AsynchronousProgramming

Table of Contents

- C++ Concurrency In Action

- 01 hello world of concurrency in c++

- 02 managing threads

- 03 sharing data between threads

- Problems with sharing data between threads

- Protecting data with mutexes

- Using mutexes in C++

- Structuring code for protecting shared data

- Spotting race conditions inherent in interfaces

- Deadlock: the problem and a solution

- Further guidelines for avoiding deadlock

- Flexible locking with std::unique_lock

- Transferring mutex ownership between scopes

- Locking at an appropriate granularity

- Alternative facilities for protecting shared data

- 04 synchronizing concurrent operations on atomic types

- Waiting for an event or other condition

- Waiting for one-off events with futures

- Waiting with a time limit

- Using synchronization of operations to simplify code

- 05 The C++ memory model and operations on atomic types

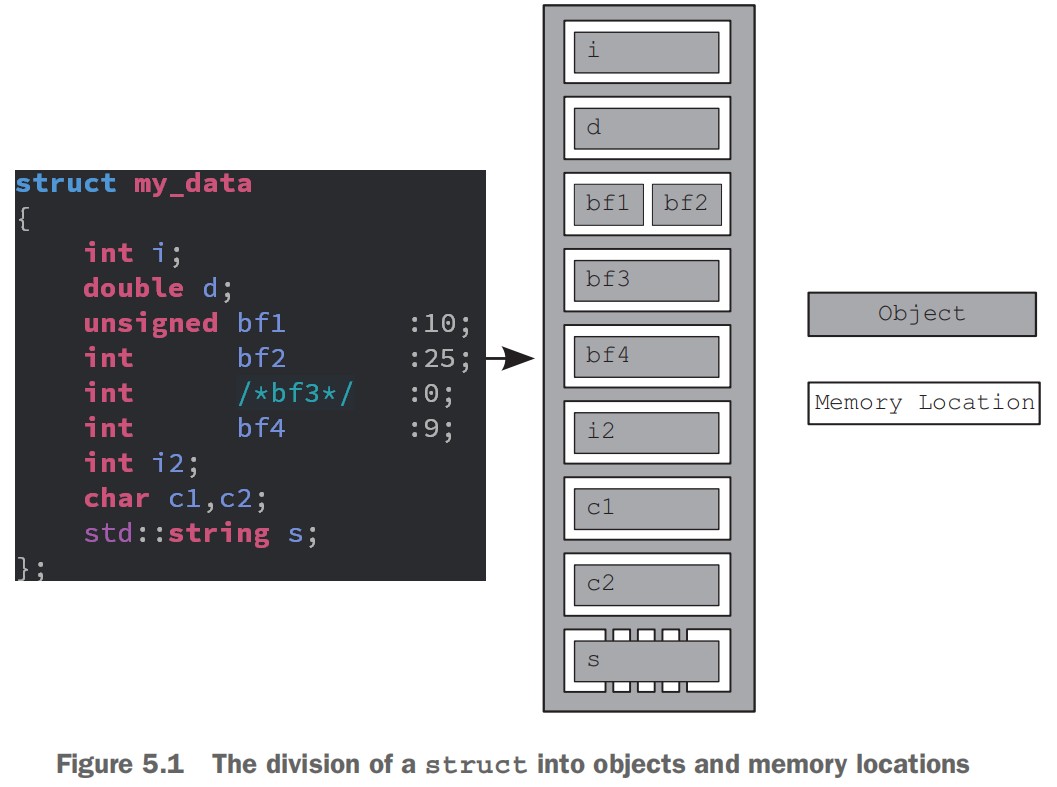

- Memory model basics

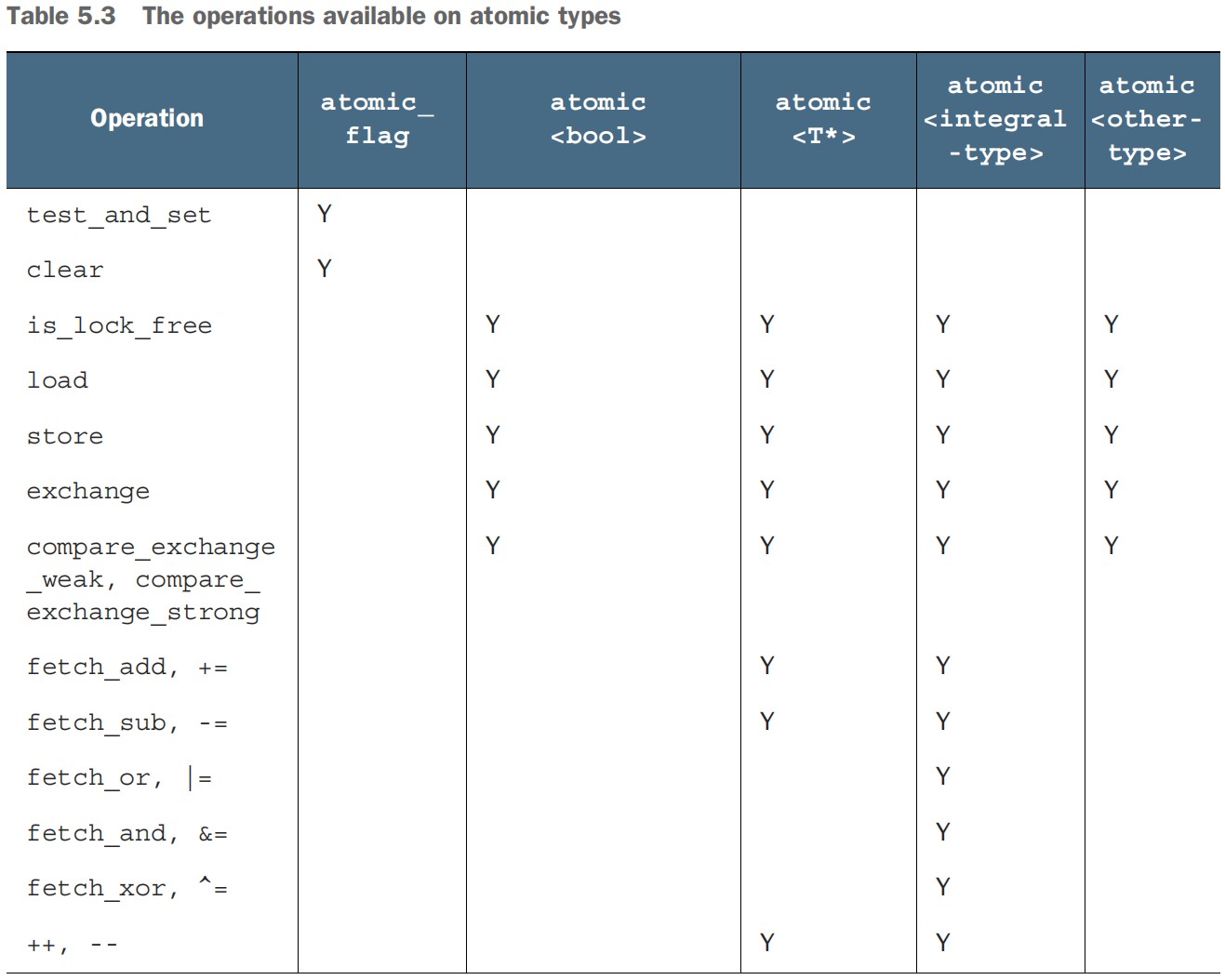

- Atomic operations and types in C++

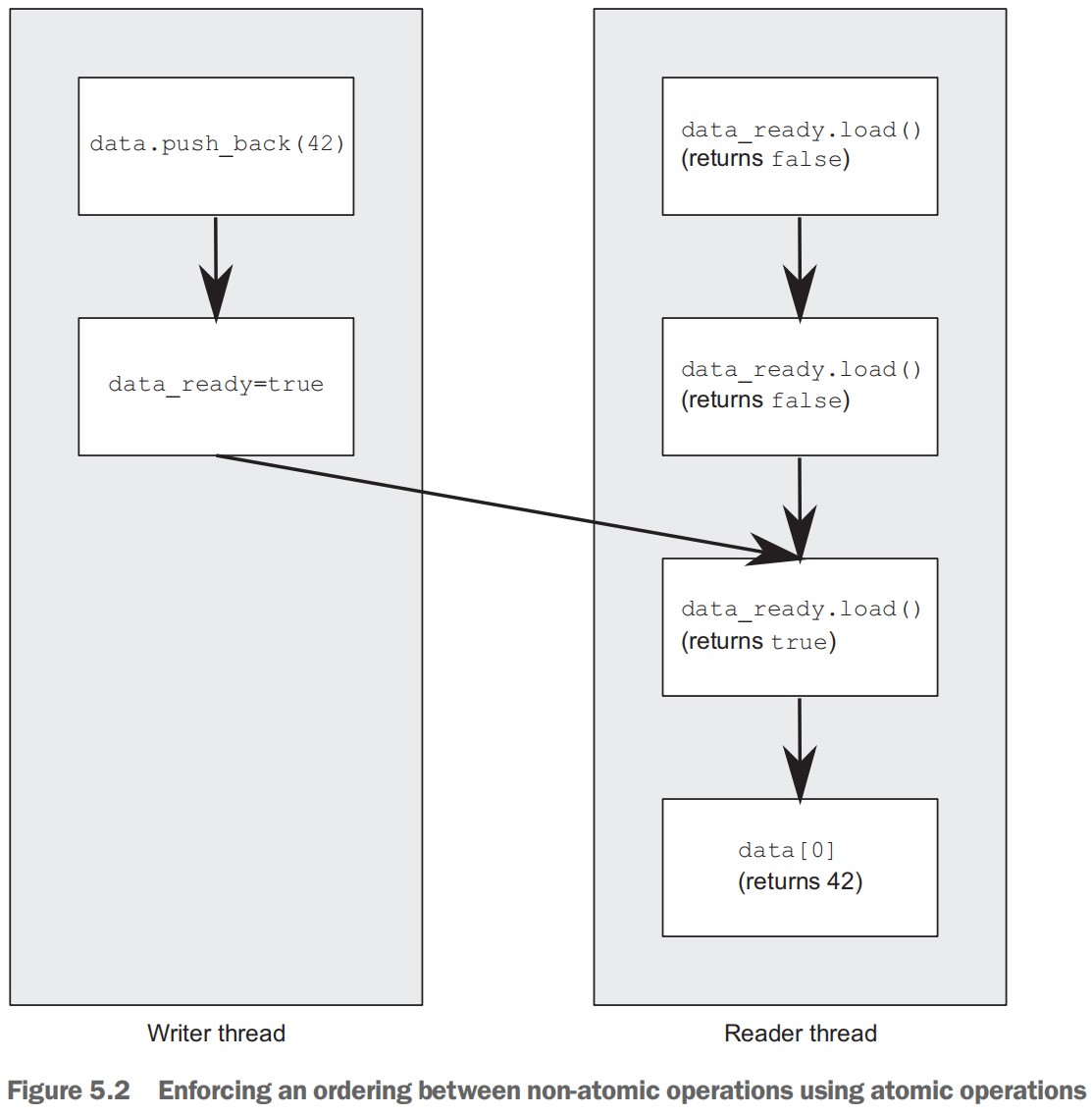

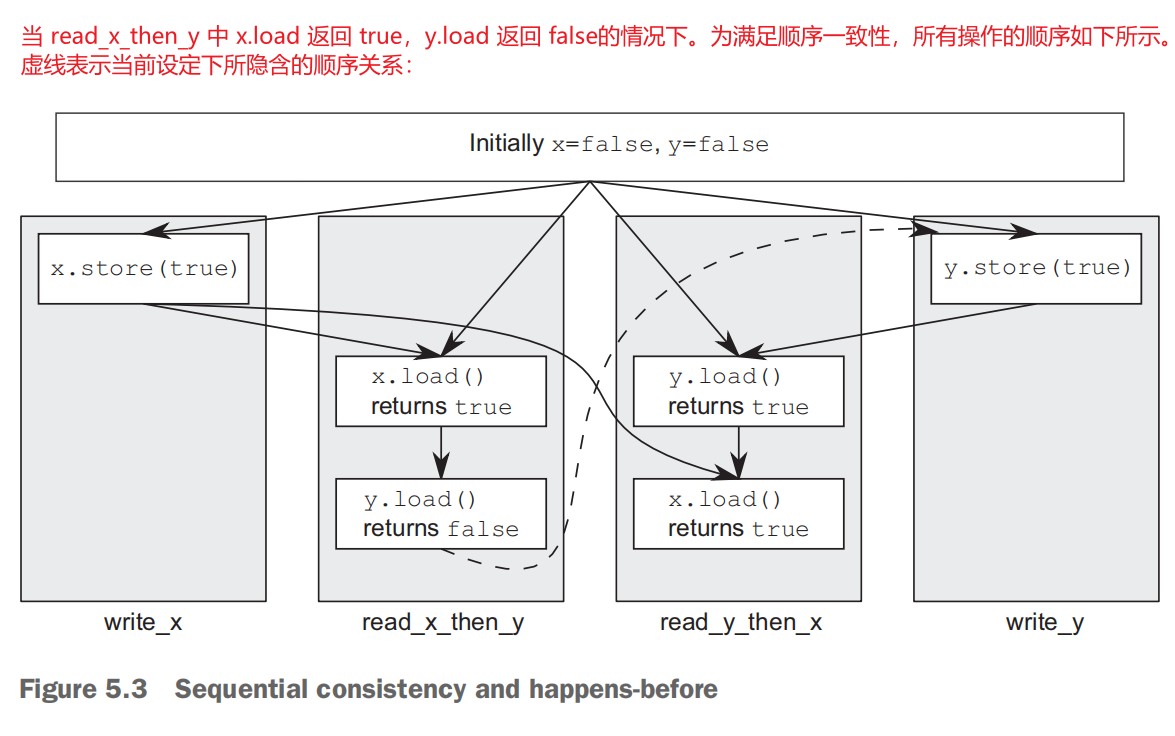

- Synchronizing operations and enforcing ordering

- 06 designing lock-based concurrent data structures

- 07 designing lock-free concurrent data structures

- 7.1 Definitions and consequences (229)

- 7.2 Examples of lock-free data structures (232)

- Writing a thread-safe stack without locks (233)

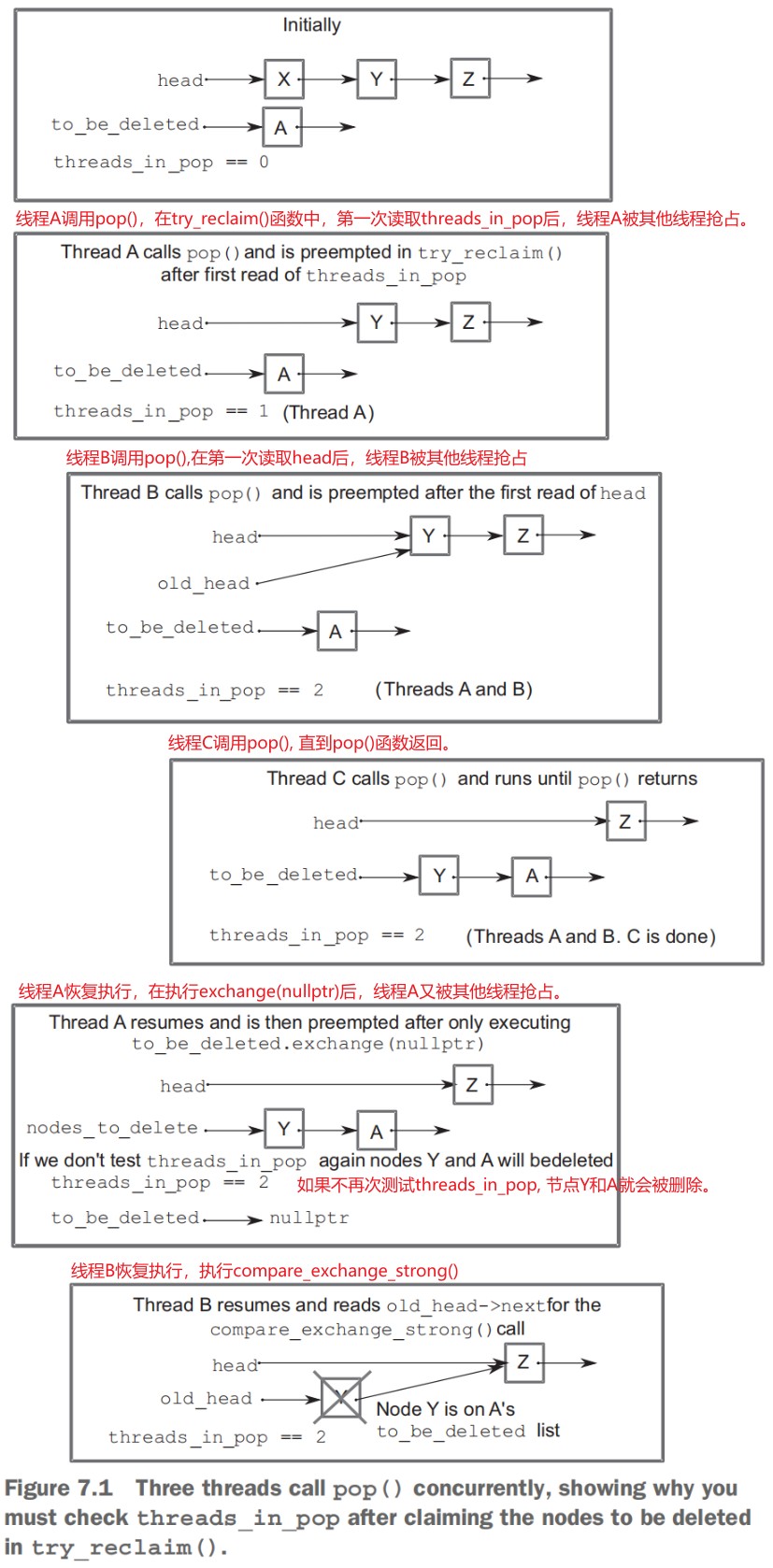

- Stopping those pesky leaks: managing memory in lock-free data structures (237)

- Detecting nodes that can’t be reclaimed using hazard pointers (241)

- Detecting nodes in use with reference counting (249)

- Applying the memory model to the lock-free stack (255)

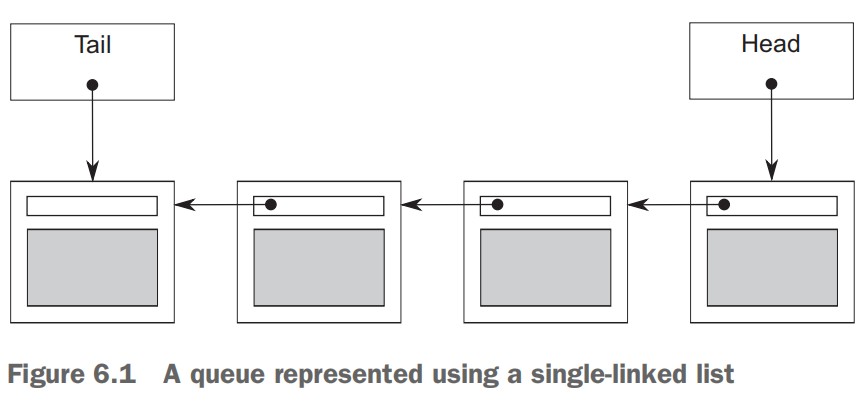

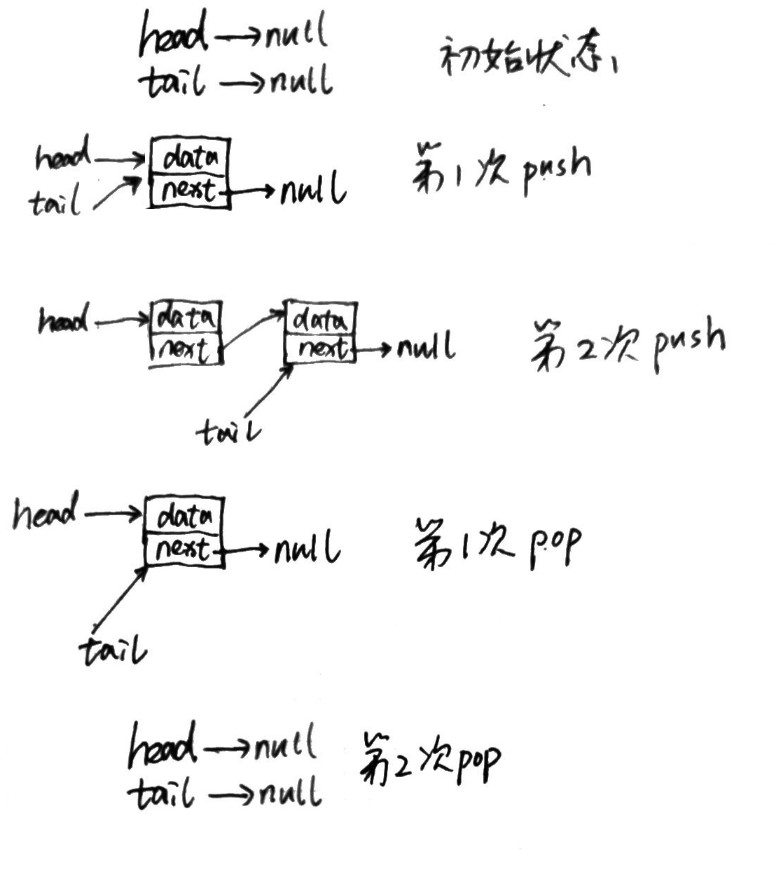

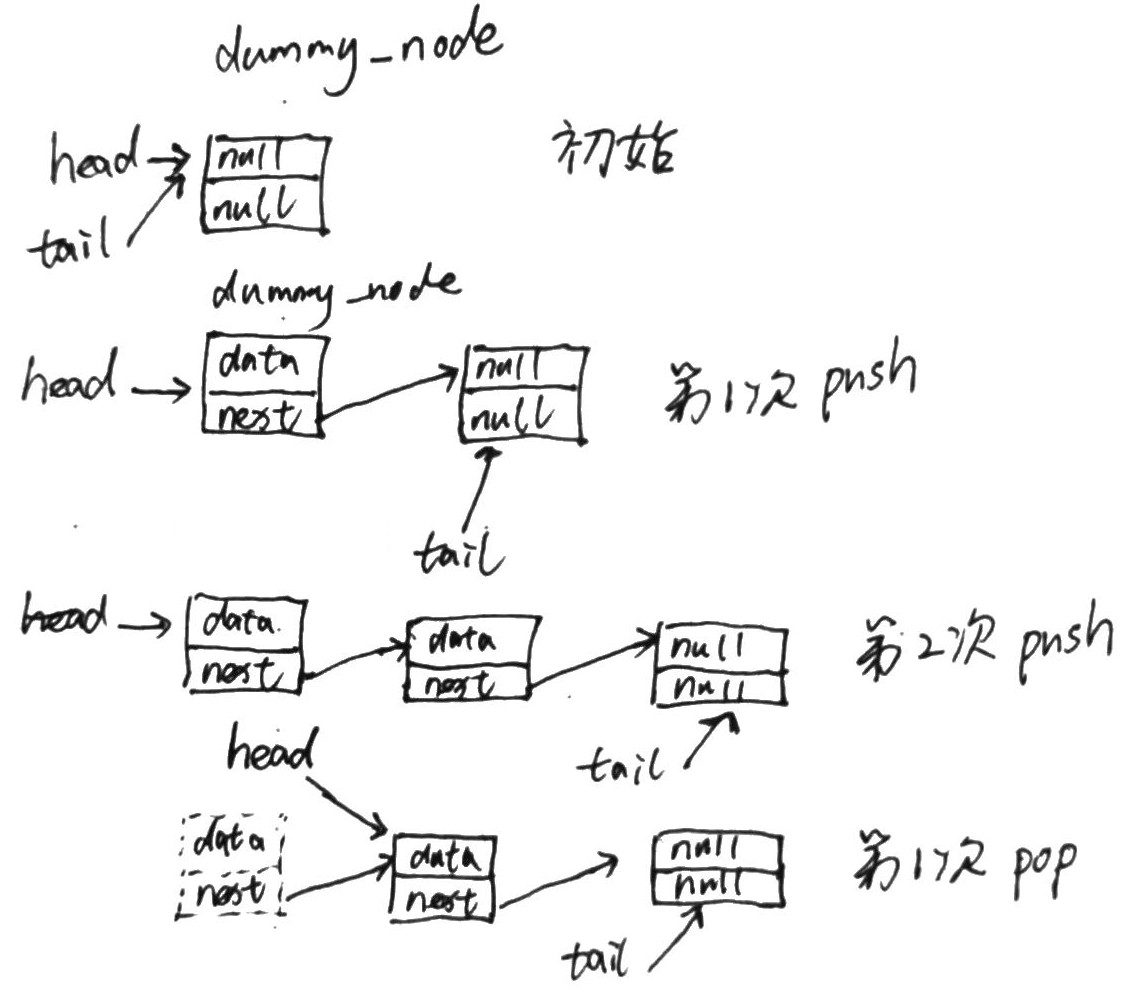

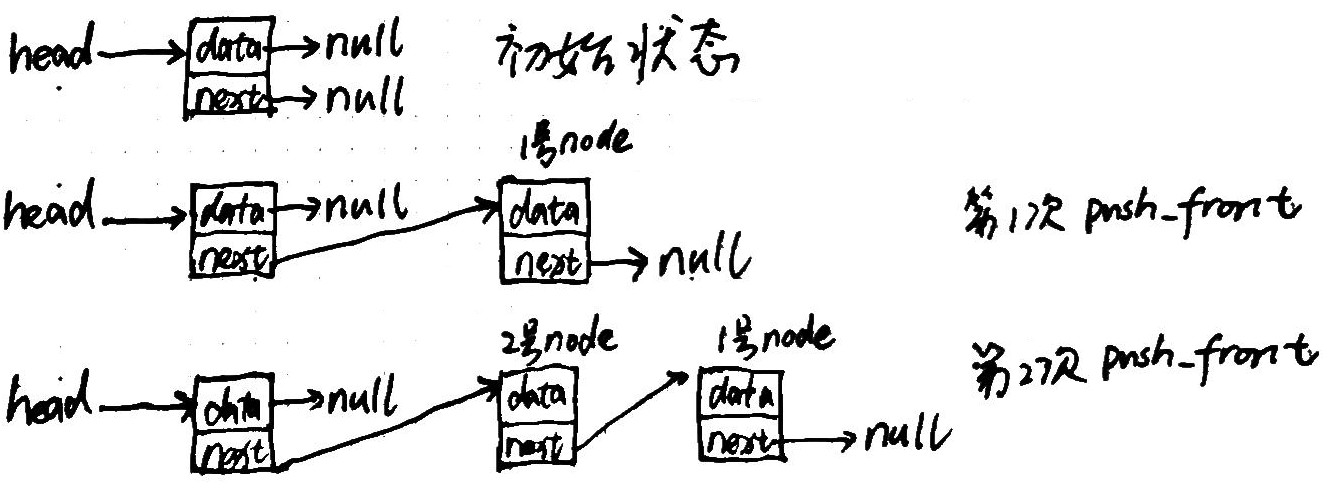

- Writing a thread-safe queue without locks (259)

- 7.3 Guidelines for writing lock-free data structures (271)

- 08 designing concurrent code

- 本章主要内容

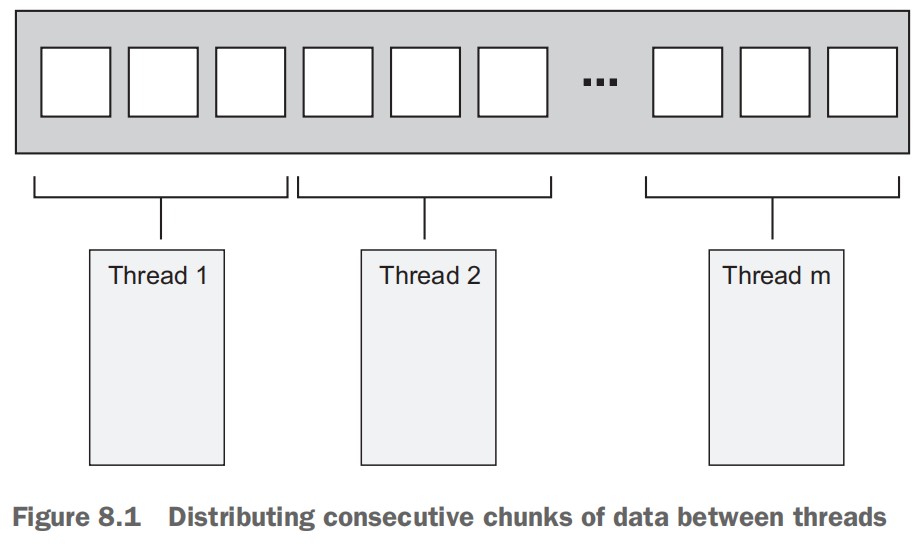

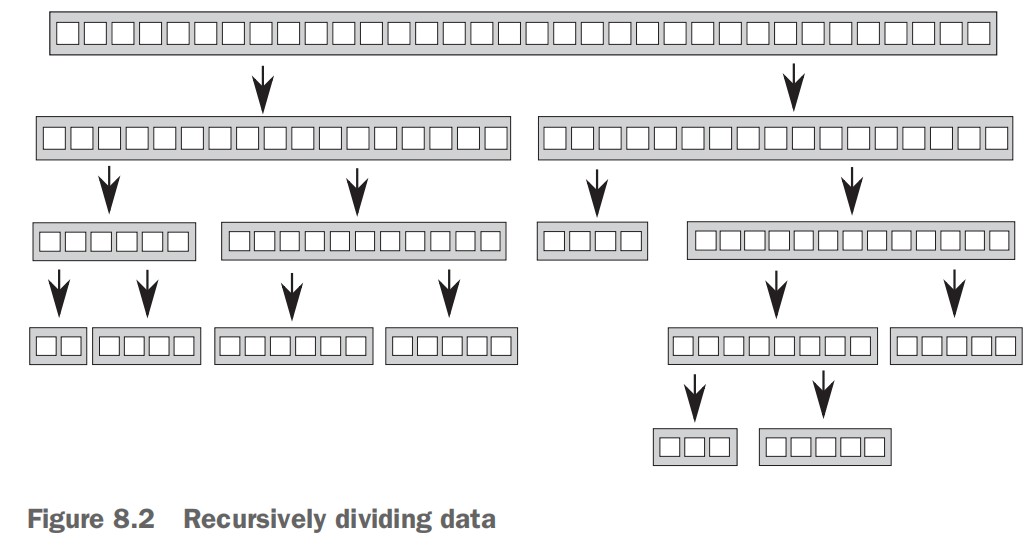

- 8.1 Techniques for dividing work between threads (275)

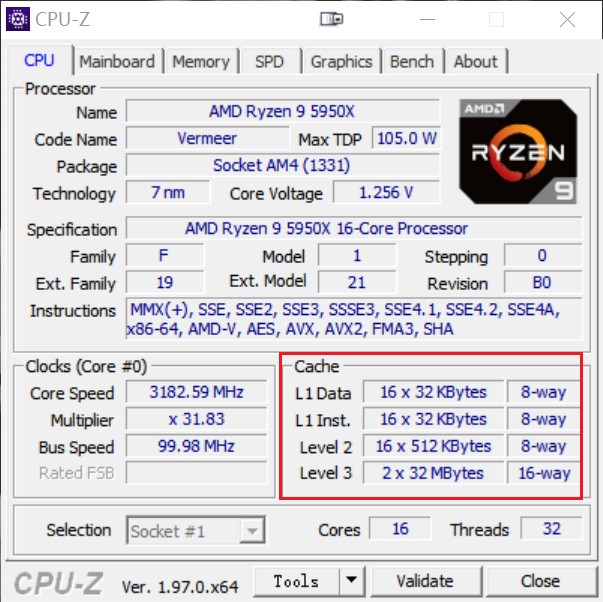

- 8.2 Factors affecting the performance of concurrent code (283)

- 8.3 Designing data structures for multithreaded performance (289)

- 8.4 Additional considerations when designing for concurrency (293)

- 8.5 Designing concurrent code in practice (305)

- 09 advanced thread management

- 本章主要内容

- 9.1 Thread pools (324)

- 9.2 Interrupting threads (338)

- Launching and interrupting another thread (339)

- Detecting that a thread has been interrupted (341)

- Interrupting a condition variable wait (341)

- Interrupting a wait on std::condition_variable_any (344)

- Interrupting other blocking calls (346)

- Handling interruptions (347)

- Interrupting background tasks on application exit (348)

- 10 parallel algorithms

- 11 testing and debugging multithreaded applications

- 本章主要内容

- 11.1 Types of concurrency-related bugs (363)

- 11.2 Techniques for locating concurrency-related bugs (365)

- c++ 多线程编程

- 参考资料

C++ Concurrency In Action

01 hello world of concurrency in c++

What is Concurrency?

将应用程序设计为多进程来实现并发

通信方式:进程之间通过常见的内部进程间通信(例如 信号、socket、files、pipes 等等)来互相交流信息

缺点:

- 进程之间的通信比较复杂或者比较慢,或者又复杂又慢,因为操作系统通常提供了很多保护为了避免一个进程意外修改另一个进程的数据。

- 运行多个进程有天然的消耗,操作系统必须拿一部分内部资源用于管理进程。

优点:

- 操作系统为进程间提供的保护和高阶通信机制,有利于编写安全的同步代码。Erlang 编程语言就是基于进程实现并行的。

- 使用分开的进程来实现并发时,可以将分开的进程在不同的机器上运行,这些机器通过网络链接在一起。

将应用程序设计为多线程来实现并发

通信方式:一个进程内的所有线程共享相同的地址空间,大多数数据可以被多线程直接访问(全局变量依然是全局的,对象或数据的指针或引用可以在线程之间进行传递)

缺点:

- 当数据被多个线程访问时,应用程序开发者需要确保每个线程在任意时刻访问该数据时看到的值是一致的。

- 多线程共享数据可能会引起很多问题,为了避免这些问题,要使用一些工具,还要遵守一些指导原则。

优点:

- 共享地址空间加上线程之间没有数据保护,使得多线程比多进程的开销要小很多,操作系统不需要过多的记录。

- C++标准没有为多进程的通信提供任何内置支持,使用多进程需要开发人员依赖平台相关的特定 API。

并发(concurrency) VS 并行(parallelism)

这两个术语都是指,利用可用的硬件同时执行多个任务。但是并行更多是面向性能的,当人们谈到并行时,他们主要关心的是利用可用硬件的优势来提升大量数据处理的性能。当人们谈到并发时,他们主要关心的是任务的分割(关注点分离 Separation of concerns)。

Why use Concurrency?

使用 concurrency 主要有两个原因:分离关注点(Separation of concerns)和性能。

使用 concurrency 来分离关注点 使用 concurrency 来提高性能

可以利用 concurrency 通过两种方式来提高性能:

第一种方式:将一个整体划分为多个部分。听上去很简单,但是划分可能很复杂,因为各个部分可能会有依赖。划分既可以是对处理流程的划分(任务并行),也可以是对数据的划分(数据并行)。

第二种方式:利用可行的并行解决更大的问题。一次处理不止一个文件,而是处理两个或 10 个或 20 个。尽管这是数据并行的一种应用,但是侧重不同。其使用相同的时间处理一大批数据。

什么时候不要使用 concurrency?

当使用 concurrency 得到的收益比不上付出的代价,就不应该使用 concurrency。

启动一个线程有天生的开销。OS 需要申请对应的内核资源,栈空间,还需要将线程加到 scheduler,这些都需要消耗时间。如果线程上的任务很快就结束了,可能任务消耗的时间还没启动线程消耗的时间多,这可能使得性能更差。

线程是有限的资源。如果你同时运行很多线程,这消耗了 OS 资源,可能使系统整体会变慢。不仅如此,使用太多线程可以耗尽一个进程的可用内存或地址空间,因为每个线程都需要一个独立的栈空间。对于 平坦架构的 32 位进程,地址空间的大小限制为 4GB,如果每个线程的栈占用 1MB,则最多可以有 4096 个线程。尽管可以使用线程池来限制线程的数量,但是并不能解决所有的问题,线程池有其自身的问题。

在 client/server 应用程序中,为每个连接启动一个线程,这对于少量连接来说是可行的,对于需要处理很多连接的高需求服务,这会很快耗尽系统的资源。这种情况下,可以使用线程池来优化性能。

线程越多,操作系统要做的上下文切换就越多。添加额外的线程将会减低应用程序整体的性能。因此,为了达到系统最佳性能,需要依据硬件的并行能力来调整线程数量。

Concurrency and multithreading in C++

History of multithreading in C++

1998 C++ 标准没有包含多线程,当时内存模型也没有正式定义,没有编译器扩展是无法编写多线程应用的。

很多编译器提供商利用当时很流行的平台相关的 C 多线程 API(POSIX C 标准和 Windows API)来支持 C++多线程。编译器的支持只是允许调用对应平台的 C API,以及保证 C++ 运行时库在多线程存在的情况下也可以正确执行。尽管很少有编译器商家提供正式的可感知多线程的内存模型,但是编译器和进程的行为已经足够好,因此编写了大量多线程 C++程序。

不满足于使用平台特定的 C API 来处理多线程,C++程序员指望他们的类库来提供面向对象的多线程设施。MFC、Boost、ACE 等等,都累积了一系列类,对底层平台相关的 API 进行了封装,为多线程提供更高级的设施,来简化多线程编程任务。尽管这些类库的具体细节差异很大,特别是启动新线程的处理,这些类的整体上也有很多共同点。他们都使用了 RAII 惯用方法来管理 mutex。

大部分情况下支持多线程的 C++编译器和平台无关的类库是足够了的。但是缺乏 C++标准的支持,意味着由于缺少多线程感知的内存模型可能会在偶然的地方导致问题,特别是利用处理器硬件知识来获得更高性能的时候,以及编写跨平台代码而编译器在不同平台上行为不同时。

Concurrency support in the C++11 standard

C++11 不止提供了多线程感知内存模型。C++标准库还包含了管理线程的类,保护共享数据的类,在线程之间同步操作的类,以及低级的原子操作。

C++14 中新加了一种 mutex 类型用于保护共享的数据。

C++17 中添加了一整套并行算法。

Efficiency in the C++ Thread Library

高性能计算领域,开发者关心的其中一个问题是 C++的效率。如果你追求极致的性能,那么你需要知道,任何高阶工具都会有一定的消耗,这是抽象的代价。

C++ Standard Library 和 Thread Library 的设计目标之一是和直接使用低阶 API 相比,消耗相同或差距不大。另一个设计目标是提供低阶的工具用于实现极限性能。

Platform-specific facilities

C++ Thread Library 为多线程和并发提供了全面的工具,而总会有平台特定的一些工具,为了便于访问平台特定的工具 C++ Thread Library 提供了 native_handler() 成员函数,其允许底层实现直接操作平台相关的 API。

Getting started

#include <iostream> #include <thread> void hello() { std::cout<<"Hello Concurrent World\n"; } int main() { std::thread t(hello); t.join(); }

每个线程都有一个初始化函数,对于应用程序的初始线程(主线程)来说,这个函数就是 main 函数。其他线程的初始函数是通过 std::thread 对象构造时来指定的。

新的线程被启动后,主线程会继续执行。如果主线程不等待新线程结束,主线程会直接执行完成(可能在新线程获得执行机会之前)。通过调用 join() 来让主线程等待关联的新线程。

02 managing threads

Basic thread management

创建进程

class background_task { public: void operator()() const { do_something(); do_something_else(); } }; // thread 接受任意可调用对象,函数、重载了调用操作符的类、lambda等 background_task f; // f会被copy到属于新线程的存储空间,并被调用 std::thread my_thread(f); // Tips: // 下面的代码会被解析为声明一个名称为my_thread的函数 // 函数参数为函数指针 // 参数函数的参数为空 // 参数函数的返回值类型为background_task std::thread my_thread(background_task()); // 正确的方式如下 std::thread my_thread((background_task())); std::thread my_thread{background_task()}; // 使用 lambda 作为 thread 的执行函数 std::thread my_thread([]{ do_something(); do_something_else(); });

等待进程结束

线程启动后,需要显示地指定是否等待其结束(调用 thread 对象的 join 函数)还是让线程自己运行(调用 thread 对象的 detach 函数)。如果在线程对象销毁前不进行指定,std::thread 的析构函数会调用 std::terminate(),这会导致进程被终止。

case1

创建线程后,执行 detach,线程执行的函数永不结束,当主线程结束后,子线程也会被迫结束。

case2

创建线程后,主线程将局部变量的引用或指针传递给线程,执行 detach,主线程离开局部变量作用域,局部变量会被释放掉,之后线程引用的数据将是错误的。

id: 100504 print ival = 10 // 子线程启动后打印引用变量的值10 id: 89912 main-thread sleep 1 second // 主线程sleep 1s id: 100504 print ival = 10 // 此时主线程还在sleep局部变量还未被释放,子线程此时打印的值依然正确 id: 100504 print ival = 143 // 主线程已经离开创建子线程的作用域,局部变量被释放,子线程打印的值为随机值,每次运行该值都不同 id: 100504 print ival = 143 id: 100504 print ival = 143 id: 100504 print ival = 143 id: 89912 main-thread sleep 5 second

case3

创建线程后,主线程将局部变量的引用或指针传递给线程,执行 join,主线程会等待子线程执行完毕后,才会继续执行,离开局部变量作用域。

id: 97172 print ival = 10 // 子线程启动后打印引用变量的值10,主线程等待子线程执行完毕后,才会继续执行 id: 97172 print ival = 10 id: 97172 print ival = 10 id: 97172 print ival = 10 id: 97172 print ival = 10 id: 93504 main-thread sleep 1 second id: 93504 main-thread sleep 5 second

join() 会清理子线程关联的存储空间,因此 std::thread 对象不再关联结束的线程,其不再关联任意线程。所以,只能对指定的线程调用一次 join,join 之后再调用 joinable 将返回 false。

case4

主线程创建子线程后 sleep 2 秒,然后再调用 join.

子线程只执行一次打印就结束.

主线程创建子线程后 sleep 2 秒,然后再调用 detach.

子线程只执行一次打印就结束.

TIPS: 子线程很快就会完成的情况下,并不会报错。只要在 std::thread 的析构之前调用 join 或 detach 就可以了。

case5

主线程创建子线程 A, 子线程 A 创建子线程 B,子线程 A 完成后,子线程 B 会依然执行,不会被迫结束。

利用 RAII 来等待线程结束

class thread_guard { std::thread& t; public: explicit thread_guard(std::thread& t_):t(t_){} ~thread_guard() { if(t.joinable()) { t.join(); } } thread_guard(thread_guard const&)=delete; thread_guard& operator=(thread_guard const&)=delete; }; struct func; void f() { int some_local_state = 0; func my_func(some_local_state); std::thread t(my_func); // RAII来等待线程结束 thread_guard(t); do_something_in_current_thread(); }

利用 detach 来使线程在后台运行

detached 的线程通常被称为后台线程(daemon threads),其概念来源于操作系统中后台进程(daemon process)。

下面是利用 detach 线程实现的文字处理器,其可以同时处理多个文件,每个线程处理一个文件。

void edit_document(std::string const& filename) { open_document_and_display_gui(filename); while(!done_editing()) { user_command cmd = get_user_input(); if(cmd.type == open_new_document) { std::string const new_name = get_filename_from_user(); std::thread t(edit_document, new_name); t.detach(); } else { process_user_input(cmd); } } }

Passing arguments to a thread function

传递指针参数给线程非常容易引起访问悬挂指针的问题,指针所指对象已经被回收了,线程还使用指针进行访问。

传递给线程参数的处理分两步:

- 将参数传递给 thread 构造函数,thread 构造函数会将参数 copy 一份记录下来。

- thread 对象再将记录下来的参数传递给线程入口函数。传递给线程入口函数的实参是在子线程的上下文中进行构造的。

- C++的 std::thread 是怎么进行参数传递的? https://www.zhihu.com/question/40428244

//////////////////////////// // case 1 下面代码将char const* 传递给thread,thread以char const*为参数构造std::string对象 // 因为"hello"为常量字符串,其存储在常量数据区(进程退出时才释放),离开局部作用域后不会被释放,所以如下代码不会存在未定义行为 void f(int i,std::string const& s); void opps(int some_param) { std::thread t(f, 3, "hello"); } //////////////////////////// // case 2.1 下面代码将char* buffer 传递给thread,thread 以 char const*为参数构造std::string对象 // 因为buffer为局部字符数组,离开局部作用域后会被释放,所以当主线程先离开oops子线程才开始运行时,如下代码会存在未定义行为! // https://www.zhihu.com/question/40428244 // https://www.jianshu.com/p/816df045f93e void oops(int some_param) { char buffer[1024]; sprintf(buffer, "%i", some_param); std::thread t(f, 3, buffer); t.detach(); } //////////////////////////// // case 2.2 下面代码将string对象的构造移到了主线程中,传递给thread构造函数的是string对象,thread构造函数会copy一份string对象保存下来,然后会将copy下来的string对象传递给线程入口函数。这样就不会存在访问对象被释放的情况了 void oops(int some_param) { char buffer[1024]; sprintf(buffer, "%i", some_param); std::thread t(f, 3, std::string(buffer)); t.detach(); } //////////////////////////// // case 3.1 下面代码希望通过子线程去修改data,子线程结束后,主线程再继续处理数据 // 但是,线程构造函数的参数是值类型,所以线程传递给入口函数的实参是data的copy。主线程的data对象并没有被修改 void update_data_for_widget(widget_id w, widget_data& data); void oops_again(widget_id w) { widget_data data; std::thread t(update_data_for_widget, w, data); display_status(); t.join(); process_widget_data(data); } //////////////////////////// // case 3.2 下面代码使用std::ref 将data的引用传递给线程构造函数,使得线程访问的data数据就是主线程的data void update_data_for_widget(widget_id w, widget_data& data); void oops_again(widget_id w) { widget_data data; std::thread t(update_data_for_widget, w, std::ref(data)); display_status(); t.join(); process_widget_data(data); }

通过传递对象指针,就可以使用成员函数作为线程入口函数

class X { public: void do_lengthy_work(); }; X my_x; std::thread t(&X::do_lengthy_work, &my_x);

传递只能 move 而不能 copy 的参数

void process_big_object(std::unique_ptr<big_object>); std::unique_ptr<big_object> p(new big_object); p->prepare_data(42); std::thread t(process_big_object, std::move(p));

std::thread 对象和 std::unique_ptr 对象一样,只能 move 而不能 copy

Transferring ownership of a thread

void some_function(); void some_other_function(); std::thread t1(some_function); std::thread t2=std::move(t1); // 将t1所有权移动给t2 t1 = std::thread(some_other_function); // 通过移动构造函数将新构造的线程所有权移动给t1 std::thread t3; // 默认构造std::thread对象t3,其不关联任何线程 t3 = std::move(t2); // 将t2所有权移动给t3 t1 = std::move(t3); // 首先将t1自身所有权释放(由于没有对t1执行join或detach,所以,这里会直接调用std::terminate 结束进程),==(进程结束,没有然后了!)==

std::thread 支持 move 意味着,可以将 std::thread 的所有权传递到函数外:

std::thread f() { void some_function(); return std::thread(some_function); } std::thread g() { void some_other_function(int); std::thread t(some_other_function, 42); return t; }

同理,也可以将所有权传递到一个函数内:

void f(std::thread t); void g() { void some_function(); f(std::thread(some_function)); std::thread t(some_function); f(std::move(t)); //f(t); // TIPS: 此处调用了thread的copy构造函数,该函数被thread标记为了delete,因此会编译错误 }

scoped_thread

std::thread 支持移动的一个好处是,可以依赖 scoped_thread 类,让其拥有 thread 的所有权。这避免了不好的事情发生,thread_scoped 对象要比其管理的 thread 的生命期长,而且一旦 thread 的所有权移动到 scoped_thread 对象中,其他对象将不能再对线程进行 join 或 detach 操作。因为,该类的目的是让 thread 在作用域内执行完成,因此将该类命名为 scoped_thread。

class scoped_thread { std::thread t; public: explicit scoped_thread(std::thread t_): t(std::move(t_)) { if(!t.joinable()) throw std::logic_error(“No thread”); } ~scoped_thread() { t.join(); } scoped_thread(scoped_thread const&)=delete; scoped_thread& operator=(scoped_thread const&)=delete; }; struct func; // 实现了调用操作符的struct void f() { int some_local_state; scoped_thread t{std::thread(func(some_local_state))}; do_something_in_current_thread(); }

上面 scoped_thread 和前面 thread_guard 类实现类似,不同之处在于,scoped_thread 可以接受直接构造的 thread 对象,而 thread_guard 则需要先创建一个 thread 对象,再将该对象通过引用传递给 thread_guard。

joining_thread

C++17 有一个提议是 joining_thread,其和 thread 类似,但是会在 joining_thread 对象释放时自动执行 join。该提议没有被同意,C++20 有一个相同的提议 jthread。我们可以很容易自己实现 joining_thread,如下:

class joining_thread { std::thread t; public: joining_thread() noexcept=default; template<typename Callable,typename ... Args> explicit joining_thread(Callable&& func,Args&& ... args): t(std::forward<Callable>(func),std::forward<Args>(args)...) {} explicit joining_thread(std::thread t_) noexcept: t(std::move(t_)) {} joining_thread(joining_thread&& other) noexcept: t(std::move(other.t)) {} joining_thread& operator=(joining_thread&& other) noexcept { if(joinable()) join(); t=std::move(other.t); return *this; } joining_thread& operator=(std::thread other) noexcept { if(joinable()) join(); t=std::move(other); return *this; } ~joining_thread() noexcept { if(joinable()) join(); } void swap(joining_thread& other) noexcept { t.swap(other.t); } std::thread::id get_id() const noexcept { return t.get_id(); } bool joinable() const noexcept { return t.joinable(); } void join() { t.join(); } void detach() { t.detach(); } std::thread& as_thread() noexcept { return t; } const std::thread& as_thread() const noexcept { return t; } };

thread and container

thread 支持移动,使得可以用识别移动的 container 来存放 thread。

void do_work(unsigned id); void f() { std::vector<std::thread> threads; for(unsigned i=0;i<20;++i) { threads.emplace_back(do_work,i); } for(auto& entry: threads) entry.join(); }

Choosing the number of threads at runtime

std::thread::hardware_concurrency() 返回真正可以并行执行的线程数量。在一个多核系统中,其返回的可能是 CPU 的核心数量。如果相关信息不可用时,其可能返回 0。

template<typename Iterator,typename T> struct accumulate_block { void operator()(Iterator first,Iterator last,T& result) { result=std::accumulate(first,last,result); } }; template<typename Iterator,typename T> T parallel_accumulate(Iterator first,Iterator last,T init) { unsigned long const length=std::distance(first,last); if(!length) return init; unsigned long const min_per_thread=25; unsigned long const max_threads= (length+min_per_thread-1)/min_per_thread; unsigned long const hardware_threads= std::thread::hardware_concurrency(); unsigned long const num_threads= std::min(hardware_threads!=0?hardware_threads:2,max_threads); unsigned long const block_size=length/num_threads; std::vector<T> results(num_threads); std::vector<std::thread> threads(num_threads-1); Iterator block_start=first; for(unsigned long i=0;i<(num_threads-1);++i) { Iterator block_end=block_start; std::advance(block_end,block_size); threads[i]=std::thread( accumulate_block<Iterator,T>(), block_start,block_end,std::ref(results[i])); block_start=block_end; } accumulate_block<Iterator,T>()( block_start,last,results[num_threads-1]); for(auto& entry: threads) entry.join(); return std::accumulate(results.begin(),results.end(),init); }

Identifying threads

thread 身份标识的类型为 std::thread::id,可以通过两种方式获得 thread 的身份标识。

- 通过 std::thread 的 get_id()成员函数获得 std::thread 关联线程的身份标识。如果 std::thread 对象不关联任何线程,则 get_id()成员函数返回一个默认的 std::thread::id 对象。

- 通过 std::this_thread::get_id() 获得当前线程的身份标识。TIPS: std::this_thread 为一个命名空间。

std::thread::id 类型的对象可以被自由地 copy 和比较。如果两个 std::thread::id 类型的对象相等,说明他们表示相同的线程,或者他们都不关联任何线程。

std::thread::id 提供了完整的比较操作集合,其可以作为关联容器的 key,也可以对其进行排序。标准库还提供了 std::hash<std::thread::id>,因此其还可以作为新的非排序关联容器的 key。

std::thread::id master_thread; void some_core_part_of_algorithm() { if(std::this_thread::get_id()==master_thread) { do_master_thread_work(); } do_common_work(); }

可以将 std::thread::id 输出。TIPS:std::thread::id 的输出是依赖于实现的,不同实现输出可能不同。输出值只用于调试,其没有任何意义。

std::cout<<std::this_thread::get_id();

03 sharing data between threads

使用线程来实现并发的一个关键好处是,线程之间可以更容易,更直接地共享数据。

共享也会带来一些问题。假如你和一个普通朋友共享一间公寓。这间公寓只有一个厨房一个卫生间。你和你的朋友无法同时使用卫生间。如果在你需要使用卫生间时,你的朋友占用卫生间很长时间,这会使你非常沮丧。类似地,假如厨房有一个组合在一起的烤炉和烤架,如果你在烤香肠的同时,你室友在烘培蛋糕。这样做你们得到的结果不会很好。(你室友会得到混有香肠味的蛋糕)

对线程来说也一样。多个线程之间共享数据时,你需要有规则规定,哪个线程可以在什么时候可以访问数据的哪些位,以及任何对该数据的改动如何同步给关心该数据的其他线程。可以很容易地在多线程之间共享数据不只是一个便利,其也是一个很大的麻烦。不正确地使用共享数据是导致并发相关 bug 的最大原因之一。

Problems with sharing data between threads

归根结底,多线程共享数据的问题都是由于修改数据导致的。如果所有共享的数据都是只读的,就不会有任何问题,因为数据被一个线程读取并不会影响其他线程对该数据的读取。但是,如果多个线程之间共享数据,其中一个或多个线程对数据进行修改,这将有很多潜在的问题。

不变性(invariants)被广泛使用,来帮助程序员思考他们的代码。在做数据更新时,这些不变性常常会被破坏,特别是数据结构比较复杂,需要修改不只一个值的时候。考虑一个双向链表,每个节点有两个指针,指针 pre 指向前一个节点,指针 next 指向后一个节点。其包含这样的不变性:假如 A.next = B,则 B.pre=A。当删除一个节点时,被删除节点的两侧的节点都需要更新,只有一个节点更新后,不变性就会被破坏,直到另一个节点也更新完毕,不变性得以再次保持。

在不变性被破坏的时候,从两个方向遍历列表获得的结果是不一致的。不变性被破坏的后果会各不相同;如果一个线程从左到右读列表,其会忽略被删除的节点。另一方面,如果另一个线程试图删除最右边的节点,则其可能永远将数据结构污染,甚至使进程 crash。这是一个 race conditions 的例子,其是在并行代码中最常见的导致 bug 的一种原因。

Race conditions

假如你在一个很大的电影院买电影票,有很多售票员,因此同时有很多人可以购票。如果另一个售票员窗口的购票者正在和你买同一场电影的电影票,那么你可选的座位依赖于你和另一个人谁先订票。如果所剩座位不多,谁先谁后的差别就会非常重要:其甚至是一场竞赛,看谁拿到最后一张票。这是一个 race condition 的例子:你获得哪个座位(或者你是否能得到座位)取决于两次购买的先后顺序。

在并行中,当结果依赖于两个或多个线程上执行的操作的相对顺序时,这种情况就是 race condition。多个线程竞争执行他们各自的操作。大多数时间,这种竞争是良性的,因为各种结果都是可接受的。例如,如果两个线程添加 item 到一个队列中,通常哪个 item 被先添加到队列并不重要,其系统的不变性一直被保持。当 race condition 导致不变性被破坏时,才会产生问题。在并行中谈到 race condition 时,通常是指有问题的 race condition;C++ 标准还定义了 data race 专业术语,用于表示一种特殊的 race condition,其专指对单个对象进行异步修改;data races 会导致可怕的未定义行为。

有问题的 race conditions 通常发生在完成一个操作需要修改两个或多个不同的的数据。例如,上面提到的双向链表中删除节点。因为操作必须访问两个分开的数据,这些修改必须在分开的指令中,因此另一个线程可能在只有其中一个修改完成时就对数据进行访问。Race conditions 通常很难被发现并且很难被复现,因为复现的窗口机会非常小。如果修改是由连续的 CPU 指令完成的,该问题显露的机会在任何一次执行中都很小,即使是该数据结构被另一个线程同步访问。随着系统负载的增加,以及该操作执行次数的增加,有问题的执行次序出现的机会也会增加。这类问题几乎必然会在大多数不顺畅的时候出现。因为 race conditions 通常是时机敏感的,而 debugger 会影响程序的执行时机,因此在调试程序时,race conditions 通常会消失。

Avoiding problematic race conditions

有很多种方式来处理 problematic race conditions,最简单的方式是使用保护机制来封装数据结构,确保只有一个线程可以修改数据结构,只有修改数据结构的线程可以看到 invariants 被破坏的中间状态。从其他访问该数据结构的线程看,对数据结构的修改要么还没开始,要么已经完成。C++标准库提供了很多这样的机制。

另一种方法是,修改你的数据结构的设计和不变性,使得对数据结构的修改是通过一系列不可分的修改来完成的,每个小的修改都保持了不变性。这种方式通常被称为无锁编程(lock-free programming),其通常很难达到正确结果。如果您在此级别工作,内存模型的细微差别以及识别哪些线程可能会看到哪组值可能会变得复杂。内存模型在第 5 章介绍,无锁编程在第 7 章介绍。

还有一种方法是,将对数据结构的修改当作事务(transaction),就像对数据库的更新是在一个事务内完成的。所需的一系列数据修改和读取存储在事务日志中,然后在一个步骤中提交。如果由于数据结构被其他线程修改提交无法被处理,事务会被重启。这种方法的专业术语名称为 software transactional memory (STM),当前是一个活跃的研究领域。本书不会介绍该方法,因为 c++中没有直接支持 STM(有一个对 c++进行 Transactional Memory 扩展的技术规范)。但是,秘密地做一些事,然后在单个步骤提交的基本理念会在后面提到。

Protecting data with mutexes

为了保护共享数据结构,如果你可以标记所有代码片段,使他们互相排斥地(mutually exclusive)访问共享数据结构,当任何一个线程在执行其中一个代码片段时,其他试图访问共享数据结构的线程必须等待直到第一个线程访问结束。这将会保证除了做修改的线程外,其他线程无法看到不变性被破坏。

使用互斥锁同步原语即可达到上面效果。mutex 是 mutual exclusion 的缩写。

mutex 是 c++中最通用的数据保护机制。但是其不是银弹;你还需要组织你的代码以保护正确的数据,在你的接口中避免固有的 race conditions。mutexs 还会带来 deadlock 的问题。

Using mutexes in C++

mutex

#include <list> #include <mutex> #include <algorithm> std::list<int> some_list; std::mutex some_mutex; void add_to_list(int new_value) { some_mutex.lock(); some_list.push_back(new_value); some_mutex.unlock(); } bool list_contains(int value_to_find) { std::lock_guard<std::mutex> guard(some_mutex); return std::find(some_list.begin(),some_list.end(),value_to_find) != some_list.end(); }

lock_guard

#include <list> #include <mutex> #include <algorithm> std::list<int> some_list; std::mutex some_mutex; void add_to_list(int new_value) { // std::lock_guard 利用RAII的理念来管理 mutex // c++17中引入了增强版本的 lock guard,其为std::scoped_lock // std::scoped_lock guard(some_mutex); std::lock_guard<std::mutex> guard(some_mutex); some_list.push_back(new_value); } bool list_contains(int value_to_find) { std::lock_guard<std::mutex> guard(some_mutex); return std::find(some_list.begin(),some_list.end(),value_to_find) != some_list.end(); }

Structuring code for protecting shared data

使用 mutex 保护数据不单单是在每个成员函数中放置 lock_guard 对象。一个逃逸的指针或引用会使得所有数据保护都是徒劳的。从某种角度看,检查逃逸指针或引用是比较容易的。只要没有成员函数返回共享数据的指针或引用给函数调用者。如果你更深入地挖掘,你会发现并不那么简单。你还要检查成员函数不会将共享数据的指针或引用传递进不受你控制的函数。

class some_data { int a; std::string b; public: void do_something(); }; class data_wrapper { private: some_data data; std::mutex m; public: template<typename Function> void process_data(Function func) { std::lock_guard<std::mutex> l(m); // 将保护数据的引用传递给不受控制的func函数,func函数将保护数据的指针保存下来,导致了共享数据指针的逃逸 func(data); } }; some_data* unprotected; void malicious_function(some_data& protected_data) { unprotected=&protected_data; } data_wrapper x; void foo() { x.process_data(malicious_function); unprotected->do_something(); }

TIPS:

不要通过函数返回共享数据的指针或引用,不要将共享数据的指针或引用存储在外部可见的地方,不要将共享数据的指针或引用当作参数传递给用户提供的函数。总之就是,不要将共享数据的指针或引用传递到锁的作用域外。

Spotting race conditions inherent in interfaces

仅仅使用互斥锁或其他机制来保护共享数据,并不意味着就不会受 race condition 影响。你依然必须确保适当的数据被保护。考虑双向链表的例子,为了使一个线程安全地删除一个节点,必须避免其他线程同步访问 3 个节点:被删除的节点,以及该节点的前后节点。如果你独立地保护访问每个节点的指针,这样做不会比不使用互斥锁的代码更好,因为 race conditions 依然存在。最简单的方式是,使用一个互斥锁保护整个链表。

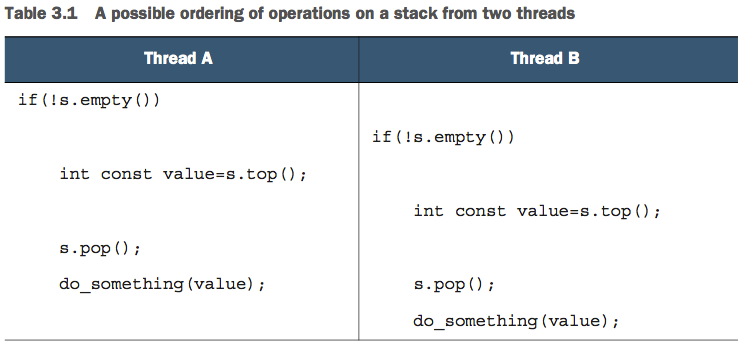

仅仅使链表上的单个操作是安全的,也并不意味着不受 race condition 影响。考虑一个栈数据结构,如果你修改 top()函数使其返回一个数据 copy 而不是引用,并且使用 mutex 保护内部数据,这个接口本质上依然受 race condition 影响。该问题并不是只存在于基于 mutex 的实现方式,对于 lock-free 的实现方式也存在该问题,该问题是接口的问题。此处的问题是,empty()和 size()不能够被信赖。尽管在调用的时候,他们是正确的,但是一旦返回,其他线程即可自由地访问 stack,他们可能 push 新的元素或者 pop 老元素出来,此时再使用 empty()和 size()返回的结果将是错误的。

template<typename T,typename Container=std::deque<T> > class stack { public: explicit stack(const Container&); explicit stack(Container&& = Container()); template <class Alloc> explicit stack(const Alloc&); template <class Alloc> stack(const Container&, const Alloc&); template <class Alloc> stack(Container&&, const Alloc&); template <class Alloc> stack(stack&&, const Alloc&); bool empty() const; size_t size() const; T& top(); T const& top() const; void push(T const&); void push(T&&); void pop(); void swap(stack&&); template <class... Args> void emplace(Args&&... args); };

stack<int> s; if(!s.empty()) // mark 1 { int const value=s.top(); // mark 2 s.pop(); // mark 3 do_something(value); }

当 stack 实例不被共享时,上面的代码是安全的。当 stack 实例被共享时,上面的代码就会有问题。该问题是由于接口设计导致的,因此需要修改接口。

问题 1: mark1 和 mark2 之间可能有其他线程调用 pop。mark2 处调用 top 时,可能 stack 中已经没有数据了。这是因为 empty 和 top 的竞争导致的。解决该问题最简单的方式是,声明当 stack 中没数据时,top 会抛出异常。这样处理虽然定位了问题,它使得编程更加繁琐,你需要在 empty 返回 false 的情况下也要捕获异常。

问题 2: 假设只有两个线程,且他们按照下面的顺序执行代码,两个线程的 value 变量是相同的值,所以两个线程中 do_something 处理的数据相同。stack 中 pop 出了两个元素,其中一个被处理两次,另一个没有被处理。这也是一种 race condition,其非常隐蔽,很难被发现。解决该问题需要对接口做更激进的修改。

可以将 top 和 pop 合并在一起使用互斥量进行保护。但是,将 top 和 pop 合并也会引入新的问题。假如 stack 的类型为 stack<vector<int>>,vector 是一个尺寸动态变化的容器,当调用 top 时,执行 vector 的 copy,如果此时内存不够,则 copy 构造 vector 会抛出 std::bad_alloc 异常。新的 pop 函数被定义为返回弹出的数据,同时将其从 stack 上删除。你所面对的问题是,返回弹出的数据给调用者在,从 stack 上删除数据之后。如果从 stack 上删除数据成功,而返回数据给调用者抛出异常,则数据会永远丢失。可以通过下面几种方式来解决该问题:

方法 1: Pass in a reference

这种方案在大多数情况下是可行的。但是,其缺点是需要调用者在调用之前构造一个 stack 元素的实例。对一些类型来说,这是不切实际的,构造一个实例是比较昂贵的。而对另外一些类型来说,这是不可行的,因为构造对象需要参数,而此处参数可能是不可行的。最后,其还需要 stack 的元素类型支持赋值。

std::vector<int> result; some_stack.pop(result);

方法 2: REQUIRE A NO-THROW COPY CONSTRUCTOR OR MOVE CONSTRUCTOR

限制 stack 元素的类型具有不抛异常的 copy 构造函数或具有不抛异常的 move 构造函数。这种方案限制了很多类型的元素无法存储在该 stack 中。

方法 3: RETURN A POINTER TO THE POPPED ITEM

返回一个指针而不是返回元素的值。可以使用 std::shared_ptr 来管理指针。这种方案对于简单类型来说,比直接返回值性能要低。

方法 4: PROVIDE BOTH OPTION 1 AND EITHER OPTION 2 OR 3

#include <exception> #include <memory> #include <mutex> #include <stack> struct empty_stack: std::exception { const char* what() const throw(); }; template<typename T> class threadsafe_stack { private: std::stack<T> data; mutable std::mutex m; // mutable 表示可以在const成员函数中修改该成员变量 public: threadsafe_stack(){} threadsafe_stack(const threadsafe_stack& other) { std::lock_guard<std::mutex> lock(other.m); data=other.data; } threadsafe_stack& operator=(const threadsafe_stack&) = delete; // 赋值运算符被删除 因为std::mutex是不能copy 不能move的对象 void push(T new_value) { std::lock_guard<std::mutex> lock(m); data.push(std::move(new_value)); } std::shared_ptr<T> pop() { std::lock_guard<std::mutex> lock(m); if(data.empty()) throw empty_stack(); std::shared_ptr<T> const res(std::make_shared<T>(data.top())); data.pop(); return res; } void pop(T& value) { std::lock_guard<std::mutex> lock(m); if(data.empty()) throw empty_stack(); value=data.top(); data.pop(); } bool empty() const { std::lock_guard<std::mutex> lock(m); return data.empty(); } };

前面讨论的 top 和 pop 接口之间的 race conditions,是因为锁的粒度太小导致的,锁没有覆盖到所有要保护的代码。将 top 和 pop 合为 pop 之后,解决了该问题。锁的粒度过大同样也会带来问题,极端情况下只用一个锁来保护所有的共享数据,这会消除所有并行带来的性能提升,因为同一时间只能执行一个线程。

粒度适当的锁机制,有时候需要你使用多个互斥量来保护一个操作中的所有共享数据。例如,某个操作使用了某个类的多个实例,多个互斥量分别保护某个类的多个实例。在这种情况下,需要在上一级进行锁定,要么把锁定操作留给用户来做,要么就需要对类的所有实例进行锁定。这两种方式都不够好。

当你需要为某个操作对两个或更多互斥量上锁时,这可能会导致死锁。

- C++ 中的 mutable 关键字 https://liam.page/2017/05/25/the-mutable-keyword-in-Cxx/

Deadlock: the problem and a solution

假如你有两个小孩,你为他们买了一个玩具,该玩具有两部分:锣和锤。只有同时获得锣和锤才能玩敲锣的游戏。这时,你的两个孩子一个拿到了锣一个拿到了锤,他们都在等对方不让出拿到的一部分,这导致他们谁也不能玩敲锣游戏。这就是典型的死锁情况。

两个线程也会发生这样的情况。死锁和 race conditions 完全相反,发生死锁后,每个线程都在等待对方完成。导致该问题的核心原因是完成某个操作需要同时对多个互斥量上锁。

解决死锁的最平常的方式是,始终按照一定的顺序对互斥量进行上锁。这样,你将永远不会死锁。但是,有时候不容易做到。例如,某个函数是交换同一个类的两个实例,该函数的两个参数是等价的,调用该函数时,实参顺序可以被调换,这就破坏了上锁的顺序。

C++标准库提供了 std::lock 函数,其可以对多个互斥量同时上锁。

class some_big_object; void swap(some_big_object& lhs,some_big_object& rhs); class X { private: some_big_object some_detail; std::mutex m; public: X(some_big_object const& sd):some_detail(sd){} friend void swap(X& lhs, X& rhs) { // 如果两个参数是同一个对象,则返回。避免对同一个互斥量上锁多次 // 对同一个互斥量上锁多次属于未定义行为 if(&lhs==&rhs) return; std::lock(lhs.m,rhs.m); std::lock_guard<std::mutex> lock_a(lhs.m,std::adopt_lock); std::lock_guard<std::mutex> lock_b(rhs.m,std::adopt_lock); swap(lhs.some_detail,rhs.some_detail); } }; // C++17 引入了 std::scoped_lock<> 可以对上面swap函数进行简化 void swap(X& lhs, X& rhs) { if(&lhs==&rhs) return; // std::scoped_lock 是一个模板类,此处利用了C++17中引入的类模板参数类型推断 std::scoped_lock guard(lhs.m,rhs.m); swap(lhs.some_detail,rhs.some_detail); }

Further guidelines for avoiding deadlock

死锁不止发生在互斥量上锁的时候。当两个线程互相调用对方 std::thread 对象的 join 函数,也会导致死锁。此时两个线程都无法向前执行,因为他们都在等待对方结束。

所有避免死锁的指导原则都可以归结为:如果有机会等着你,那么就不要等另外其他线程。

AVOID NESTED LOCKS

如果你已经对一个互斥量上了锁,不要再对其他互斥量上锁。这样就不会因为对互斥量上锁而导致死锁。如果需要对多个互斥量上锁,应该使用 std::lock。

AVOID CALLING USER-SUPPLIED CODE WHILE HOLDING A LOCK

用户的代码可能执行任何操作,其可能对互斥量上锁。如果你已经对一个互斥量上了锁,若用户的代码又对其他互斥量上锁,这破坏了第一条 guideline,有可能导致死锁。

ACQUIRE LOCKS IN A FIXED ORDER

如果你需要获得多个锁,并且无法同时对这些互斥量进行上锁,那么你需要在所有线程中保证按照相同的顺序对 mutex 进行上锁。

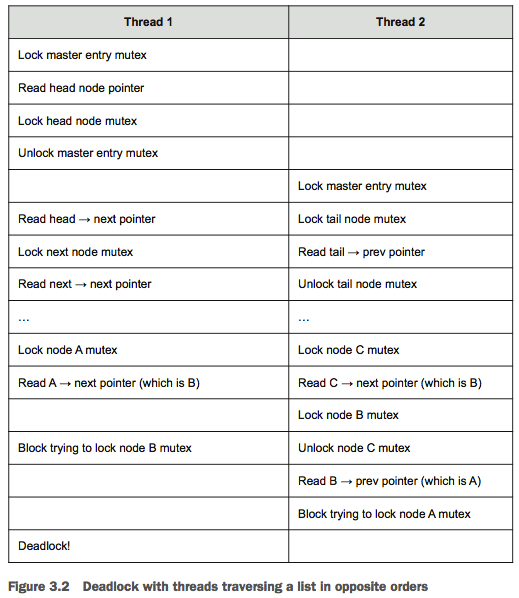

有时候无法很容易做到,考虑双向链表的例子。对于删除一个节点,我们需要获得 3 个节点的锁;遍历列表时,为了避免同时有其他线程对当前节点的 next ptr 有修改,当其获取下一个节点的锁时,其必须保持当前节点的锁。一旦获得下一个节点的锁,则可以释放当前节点的锁,下一个节点变为当前节点。这种 hand-over-hand 上锁方式,可以让多个线程同时访问列表的不同节点。但是,为了避免死锁,节点必须按照相同的顺序上锁。例如:如果一个线程从头到尾遍历列表,另一个线程从尾到头遍历列表,就会出现死锁,详细分析如下:

类似的,假设 A,B,C 是按顺序的三个节点。当删除节点 B 时,需要分别获得 A,B,C 的锁,如果先获得 B 的锁,此时其他线程有可能获得 A 的锁或 C 的锁,从而导致死锁。如果始终遵守获得锁的顺序则可避免死锁的问题。

USE A LOCK HIERARCHY

这是一种特殊的获取锁的顺序。层次锁结构提供了一种方法来检查在运行时约定规则是否被遵守。其理念是,将应用程序分层,确定给定层所有可能被锁定的互斥量。当代码试图对互斥量上锁时,如果其已经持有一个更底层的锁,则不允许其当前的操作。你可以为每个互斥量赋予一个层次编号,并记录哪些互斥量被哪些线程持有。C++标准库,没有直接提供这种机制。

hierarchical_mutex high_level_mutex(10000); hierarchical_mutex low_level_mutex(5000); hierarchical_mutex other_mutex(6000); int do_low_level_stuff(); int low_level_func() { std::lock_guard<hierarchical_mutex> lk(low_level_mutex); return do_low_level_stuff(); } void high_level_stuff(int some_param); void high_level_func() { std::lock_guard<hierarchical_mutex> lk(high_level_mutex); high_level_stuff(low_level_func()); } // thread_a 遵守了规则,其可以正确运行 // 其持有 high level锁,允许再获取low level锁 void thread_a() { high_level_func(); } void do_other_stuff(); void other_stuff() { high_level_func(); do_other_stuff(); } // thread_b 违反了规则,持有 // 其持有middle level锁,又去获取high level锁,这是不被允许的 void thread_b() { std::lock_guard<hierarchical_mutex> lk(other_mutex); other_stuff(); }

class hierarchical_mutex { std::mutex internal_mutex; unsigned long const hierarchy_value; unsigned long previous_hierarchy_value; // 被thread_local 标记的变量,每个线程都有自己的copy // 所有hierarchical_mutex 实例都可以访问该变量,但是不同线程,该变量的值不同。 static thread_local unsigned long this_thread_hierarchy_value; void check_for_hierarchy_violation() { if(this_thread_hierarchy_value <= hierarchy_value) { throw std::logic_error("mutex hierarchy violated"); } } void update_hierarchy_value() { previous_hierarchy_value=this_thread_hierarchy_value; this_thread_hierarchy_value=hierarchy_value; } public: explicit hierarchical_mutex(unsigned long value): hierarchy_value(value), previous_hierarchy_value(0) {} void lock() { // 上锁时,检查线程的锁等级是否高于互斥量锁等级 // this_thread_hierarchy_value <= hierarchy_value 获取更高等级的锁,被禁止 // this_thread_hierarchy_value > hierarchy_value 获取更低等级的锁,被允许 check_for_hierarchy_violation(); internal_mutex.lock(); // 更新当前线程的锁等级 update_hierarchy_value(); } void unlock() { // 释放锁时,检查线程的锁等级是否等于互斥量锁等级 // 乱序解锁,会导致线程的锁等级错误 // // 例如:获取锁的顺序为 high->low,释放锁的顺序也为 high-low // hierachy_value previous_hierachy_value this_thread_hierachy_value // lock high high ULONG_MAX high // lock low low high low // unlock high high ULONG_MAX ULONG_MAX // unlock low low high high // 因此应该逆序释放锁! if(this_thread_hierarchy_value!=hierarchy_value) throw std::logic_error("mutex hierarchy violated"); this_thread_hierarchy_value=previous_hierarchy_value; internal_mutex.unlock(); } bool try_lock() { check_for_hierarchy_violation(); if(!internal_mutex.try_lock()) return false; update_hierarchy_value(); return true; } }; thread_local unsigned long hierarchical_mutex::this_thread_hierarchy_value(ULONG_MAX);

EXTENDING THESE GUIDELINES BEYOND LOCKS

导致死锁的不止是对互斥量上锁,任何同步操作也会导致循环等待。因此,需要将上面的 guidelines 扩展到其他情况。例如,我们可以扩展 Avoid nested locks 这条 guideline。当线程获得一个锁时,不要去等待其他线程结束(等待的线程,可能正在获取当前线程持有的锁)。类似地,对于 Use a lock hierarchy 这条 guideliine,对于等待线程结束也适用,可以为线程指定 hierarchy,低等级的线程不能等待高等级的线程。

Flexible locking with std::unique_lock

通过放松不变性,std::unique_lock 和 lock_guard 相比,提供了更多的灵活性。std::unique_lock 内部有一个 flag 用来标记其是否拥有 mutex 的所有权,如果其没有,则在析构函数中将不会对 mutex 进行 unlock,否则才会对 mutex 进行 unlock。std::unique_lock 的成员函数 owns_lock()可以用于查询 std::unique_lock 是否对 mutex 具有所有权。

std::unique_lock 内部有 flag,因此,其所占内存大小要比 std::lock_guard 要大。由于 flag 的存在,std::unique_lock 的相关操作中需要对 flag 进行检查或更新,其性能也要比 std::lock_guard 要差一些。如果 std::lock_guard 满足你的需求,尽量使用 std::lock_guard,需要 defer lock 或需要将锁的所有权从一个作用域转移到另外作用域时,再使用 std::unique_lock .

class some_big_object; void swap(some_big_object& lhs,some_big_object& rhs); class X { private: some_big_object some_detail; std::mutex m; public: X(some_big_object const& sd):some_detail(sd){} friend void swap(X& lhs, X& rhs) { if(&lhs==&rhs) return; // std::defer_lock 表示,暂时不对mutex上锁 std::unique_lock<std::mutex> lock_a(lhs.m,std::defer_lock); std::unique_lock<std::mutex> lock_b(rhs.m,std::defer_lock); // 此处使用std::lock对 std::unique_lock 上锁,会调用std::unique_lock的lock成员函数,进而调用mutex的lock成员函数 std::lock(lock_a,lock_b); swap(lhs.some_detail,rhs.some_detail); } };

- std::unique_lock 源代码分析 https://blog.csdn.net/q943520218/article/details/95721696

Transferring mutex ownership between scopes

由于 std::unique_lock 实例可以不拥有其所关联的 mutex,因此可以通过 moving 在 std::unique_lock 实例之间传递 mutex 的所有权。std::unique_lock 类型是 movable 类型,但不是 copyable 类型,当 std::unique_lock 实例为 rvalue 时可以自动传递,当 std::unique_lock 实例为 lvalue 时需要使用 std::move 将其转化为 rvalue。

一种使用 std::unique_lock 传递 mutex 所有权的方式如下,get_lock 函数对 mutex 进行上锁,然后将所有权转移给调用者,调用者在锁的保护下可以继续做一些事情,调用者退出时,std::unique_lock 对象销毁,自动解锁 mutex。

std::unique_lock<std::mutex> get_lock() { // TODO Why extern? extern std::mutex some_mutex; std::unique_lock<std::mutex> lk(some_mutex); prepare_data(); // TODO mutex 无法copy,那么lk对象如何传递其关联的mutex? return lk; } void process_data() { std::unique_lock<std::mutex> lk(get_lock()); do_something(); }

通常当对 mutex 的上锁依赖于程序状态或传入函数的参数时,会使用这种模式。一种方式是不直接返回 std::unique_lock 对象,而是将其作为一个 gateway 类的数据成员,用于保证正确上锁访问某些保护数据。这种情况下,所有对保护数据的访问都需要通过 gateway 类:当你需要访问数据时,你需要获得一个 gateway 的实例,然后通过该实例的成员函数来访问数据。当你访问结束后,你销毁了 gateway 对象,这样其他线程就可以访问保护数据了。该 gateway 对象很可能是 movable 的,此时锁对象也需要是 movable 的。

std::unique_lock 还允许在对象销毁之前释放锁,只要调用其成员函数 unlock 就可以了。这样可以灵活控制锁的粒度,提高并行性能。

Locking at an appropriate granularity

锁的粒度是一个形象的术语用于描述被一个锁保护的数据的量。细粒度锁保护少量数据,粗粒度锁保护大量数据。 选择足够粗的锁粒度以确保所需数据受到保护很重要,只为那些需要保护的操作持有锁也很重要。

在超市购买商品,排队去结账,结账的时候发现漏买了果酱,其跑去拿果酱,使得其他所有人都等待;付款的时候,其又在包里找信用卡,此时别人也只能等待,这样减低了整体的速度。如果能提前检查购物清单,提前准备好信用卡,就可以消除其他客户不必要的等待。对于多线程也一样,当多个线程都在等待某个资源,如果任何一个线程持有该锁的时间包含了不必要保护的操作,都会导致整体的等待时间上升。尽可能只在访问共享数据时锁定互斥量,尽量在锁外对数据进行处理。特别是不要在持有锁时进行任何耗时的活动,例如文件 I/O。除非锁是用于保护对特定文件的访问。

void get_and_process_data() { std::unique_lock<std::mutex> my_lock(the_mutex); some_class data_to_process=get_next_data_chunk(); my_lock.unlock(); // 获得数据后,释放锁 result_type result=process(data_to_process); my_lock.lock(); // 写数据时,再上锁 write_result(data_to_process,result); }

适当粒度的锁不仅是保护的数据量要尽可能少,持有锁的时间也要尽可能短。当持有锁时,不要去执行耗时很长的操作,例如文件 IO 或获取另一个锁(获取另一个锁时,可能会被阻塞,这样可能会等待很长时间)。

class Y { private: int some_detail; mutable std::mutex m; int get_detail() const { std::lock_guard<std::mutex> lock_a(m); return some_detail; } public: Y(int sd):some_detail(sd){} friend bool operator==(Y const& lhs, Y const& rhs) { if(&lhs==&rhs) return true; // 此处分开对两个参数进行上锁,减低了锁的粒度,提高了性能。 // 但是,也修改了operator==的语意,其不再表示某个时间点两个对象相等,而是表示某两个时间点两个对象相等 int const lhs_value=lhs.get_detail(); int const rhs_value=rhs.get_detail(); return lhs_value==rhs_value; } };

Alternative facilities for protecting shared data

Protecting shared data during initialization

假设你有一个共享资源,构造该共享资源消耗比较大(例如:连接数据库或申请一大块内存),你希望在使用的时候才执行构造。这种设计方式被称为 Lazy Initialization。单线程情况下,其实现方法如下:

std::shared_ptr<some_resource> resource_ptr; void foo() { if(!resource_ptr) { resource_ptr.reset(new some_resource); } resource_ptr->do_something(); }

上面的方式只能工作在单线程模式下,多线程情况下可能会多次执行初始化。可以通过下面几种方法来实现多线程模式的 Lazy Initialization。

最简单的方式,但性能低下

最简单的方式是,使用互斥量来保护初始化过程,实现方式如下。但是,该方法导致初始化后的后续调用也会加锁解锁。

std::shared_ptr<some_resource> resource_ptr; std::mutex resource_mutex; void foo() { std::unique_lock<std::mutex> lk(resource_mutex); if(!resource_ptr) { resource_ptr.reset(new some_resource); } lk.unlock(); resource_ptr->do_something(); }

double-checked locking 方式,尝试优化性能,但引入了 data race

很多人使用 double-checked locking 模式来优化该问题,但是,该方法是错误的,其会导致更严重的未定义行为:

void undefined_behaviour_with_double_checked_locking() { if(!resource_ptr) // mark 1 { std::lock_guard<std::mutex> lk(resource_mutex); if(!resource_ptr) // mark 2 { // 下面代码执行了3步操作: // 1. 为 some_resource 对象分配内存 // 2. 在分配的内存上调用 some_resource的构造函数,构造一个some_resource对象 // 3. 返回该内存的指针,让resource_ptr指向该内存 // 编译器不一定按23顺序执行,可能32 resource_ptr.reset(new some_resource); // mark 3 } } resource_ptr->do_something(); // mark 4 }

这个方案也存在潜在的 race condition,第一次的检查没上锁,可能与其他线程中被保护的 reset 操作产生竞争。如果当前线程看见其他线程写入了指针,但没看到新创建的对象实例,调用 do_something 就会出错。这个例子就是 c++中定义的 data race 问题。

std::call_once std::once_flag 方案

std::once_flag 中存储了同步数据。使用 std::call_once std::once_flag 要比上面第一个最简单方案性能要好很多。

std::shared_ptr<some_resource> resource_ptr; std::once_flag resource_flag; void init_resource() { resource_ptr.reset(new some_resource); } void foo() { // std::call_once(resource_flag,init_resource); resource_ptr->do_something(); }

下面是使用 std::call_once std::once_flag 实现类成员的 lazy initialization

class X { private: connection_info connection_details; connection_handle connection; std::once_flag connection_init_flag; void open_connection() { connection=connection_manager.open(connection_details); } public: X(connection_info const& connection_details_): connection_details(connection_details_) {} void send_data(data_packet const& data) { std::call_once(connection_init_flag,&X::open_connection,this); connection.send_data(data); } data_packet receive_data() { std::call_once(connection_init_flag,&X::open_connection,this); return connection.receive_data(); } };

TIPS: std::once_flag 和 std::mutex 类似,他们的实例都不可以被 copy 和 move。因此,当你使用这些实例作为成员变量,并且你还需要 copy 构造函数或移动构造函数等时,你需要自己显示实现这些成员函数,编译器不会生成。

static 方案

当一个局部变量被声明为 static 时,第一次执行到定义该变量的时候,对该变量执行初始化。当多个线程调用该函数时,可能会对该变量初始化多次,每个线程可能都会认为自己是第一次执行到定义该变量的线程,或者一个线程开始初始化该变量但还没初始化完成,而另一个线程已经在使用该对象。c++11 之前的很多编译器都会有该问题,c++11 之后规定 static 变量的初始化只完全发生在一个线程内,直到初始化完成前其他线程都不会做处理,从而避免了 race condition。只有一个全局实例时可以不使用 std::call_once 而直接用 static。

class my_class; // 多个线程可以调用 get_my_class_instance() ,而不用担心 instance初始化时有race condition问题。 my_class& get_my_class_instance() { static my_class instance; return instance; }

Protecting rarely updated data structures

DNS 表就属于很少需要更新的数据结构。DNS 表中存储了很多条数据项,每条数据项存储一条域名和其对应的 IP 地址。尽管,当用户访问新的不同的网站时,会增加新的数据项目,通常一条数据项会保持一段时间都不变。系统会定期检查每条数据项的有效性,只有域名对应的 IP 地址变更或者域名不可用时,才需要对数据项进行更新。尽管更新很少发生,但是当多个线程访问 DNS 表时,依然需要在更新数据期间对 DNS 表进行适当保护,避免其他线程看到破坏了的数据(更新只完成一部分,没有完全完成)。

使用 std::mutex 来保护 DNS 表,有些过度悲观了,这使得多个线程对 DNS 表的读取操作也无法并行执行。此处,我们需要一种通常被称为 reader-writer mutex 的互斥量,其允许单个写者互斥访问,多个读者同步访问。

C++11 中没有提供这样的互斥量。C++14 中提供了 std::shared_timed_mutex。C++17 中提供了 std::shared_mutex。std::shared_timed_mutex 比 std::shared_mutex 提供了额外的操作,当不需要该额外操作时,某些平台上 std::shared_mutex 的效率会更高。

对于更新操作,使用 std::lock_guard <std::shared_mutex> 和 std::unique_lock<std::shared_mutex> 来进行保护,保证互斥访问。对于读取操作,使用 std::shared_lock<std::shared_mutex>来进行保护,保证共享访问。std::shared_lock<std::shared_mutex> 是 C++14 中加入的。

当任何一个线程对 reader-writer 互斥量上了共享锁,请求对该 reader-writer 互斥量上互斥锁的线程会一直被阻塞,直到所有拥有共享锁的线程释放了共享锁。当任何一个线程对 reader-writer 互斥量上了互斥锁,请求对该 reader-writer 互斥量上共享锁或互斥锁的其他线程会一直被阻塞,直到拥有互斥锁的线程释放了互斥锁。

#include <map> #include <string> #include <mutex> #include <shared_mutex> class dns_entry; class dns_cache { std::map<std::string,dns_entry> entries; // reader-writer 互斥量 mutable std::shared_mutex entry_mutex; public: dns_entry find_entry(std::string const& domain) const { // 获取共享锁,多个线程可以并行执行find_entry,但会阻塞调用update_or_add_entry的线程 std::shared_lock<std::shared_mutex> lk(entry_mutex); std::map<std::string,dns_entry>::const_iterator const it= entries.find(domain); return (it==entries.end())?dns_entry():it->second; } void update_or_add_entry(std::string const& domain, dns_entry const& dns_details) { // 获取互斥锁,只有一个线程可以执行 update_or_add_entry。会阻塞其他调用 update_or_add_entry 或 find_entry 的线程 std::lock_guard<std::shared_mutex> lk(entry_mutex); entries[domain]=dns_details; } };

Recursive locking

当已经对一个 std::mutex 上锁后,再对该互斥量上锁会导致未定义行为。C++标准库提供了 std::recursive_mutex 互斥量,可以对其多次上锁,但是 lock 次数必须和 unlock 次数相匹配。正确使用 std::lock_guard<std::recursive_mutex> 和 std::unique_lock<std::recursive_mutex> 就可以保证 lock 和 unlock 次数的匹配。

大多数情况下,当你想使用 std::recursive_mutex 时,你可能真正需要的是换一种设计。下面这种情况可以使用 std::recursive_mutex :一个类被设计为可以有多个线程并发访问,该类有一个互斥量用于保护数据成员,每个成员函数都会先对互斥量上锁,然后执行操作,之后再对互斥量解锁,当一个成员函数需要调用另一个成员函数时,那么就需要对一个互斥量多次上锁了。但是,通常不推荐这种使用方式,这种方式会导致不好的设计。当上锁后,类的不变性通常会被破坏,这意味着第二个成员函数是在不变性被破坏之后的基础上工作的。更好的方式是,从第二个成员函数分离出来一个 private 的成员函数,让上锁的这两个成员函数分别调用这个私有的成员函数。

04 synchronizing concurrent operations on atomic types

有时候不止需要保护多个线程之间共享数据,还需要同步多个线程的不同行为。一个线程等待特定事件发生或某个条件为真的情况很常见。尽管可以定期去检查事件是否发生或条件是否为真,但是这种实现性能太差了。C++标准库提供了 condition variables 和 futures , C++ Technical Specification 中提供了对 condition variables 和 futures 的扩展,还提供了 latches 和 barriers,这些都是用于处理多线程行为同步的工具。

Waiting for an event or other condition

假设你正在乘坐夜间火车进行旅行。为了保证你可以在正确站台下车,有如下几个方案:

方案 1:一晚上不睡觉,并注意每次停车是在哪个站台。一晚无法睡觉,会很累。

方案 2:查看列车到站时刻表,定一个在到站时刻之前的闹钟。如果列车延迟,则你会提早醒来。如果闹钟电池不足,则你可能会坐过站。

方案 3:最理想的方式是,列车到达你下车的站台后,有人可以通知你下车。

对于线程也一样,如果一个线程 A 在等待另一个线程 B 完成一个任务。为了保证线程 B 完成任务后,线程 A 可以马上执行,有如下几个方案:

方案 1:线程 A 不停去检查一个共享变量标记(使用 mutex 保护该共享变量),线程 B 完成任务后会写入该共享变量标记。线程 A 浪费了珍贵的执行时间去检查标记;线程 A 对共享变量上锁,导致其他线程阻塞。

方案 2:线程 A 在每次检查之间使用 sleep_for,让自己 sleep 一段时间。该方案一定程度上改善了执行时间的浪费,但是 sleep 的时间很难是恰到好处的。sleep 时间过短,会导致执行时间浪费;sleep 时间过长,会导致线程 A 无法及时处理后续工作。

方案 3:使用 c++标准库提供的 condition variable 来实现。概念上讲,一个条件变量和一个事件或其他条件相关联,一个线程或多个线程可以等待该条件被满足,此时,其可以通知一个或多个等待该条件的线程,将他们唤醒从而让他们继续执行。

Waiting for a condition with condition variables

C++标准库提供了两种条件变量:std::condition_variable 和 std::condition_variable_any。他们都需要和互斥量配合来实现适当的同步,std::condition_variable 只能和 std::mutex 一起使用;std::condition_variable_any 可以和任意满足最小条件的类 mutex 一起工作。std::condition_variable_any 在内存占用、性能以及 OS 资源消耗上都比 std::condition_variable 要多。因此,应该优先使用 std::condition_variable,除非需要 std::condition_variable_any 提供的额外灵活性。

下面实例使用 std::condition_variable 和 std::mutex 配合实现了 data_preparation_thread 和 data_processing_thread 两个线程的同步:

std::mutex mut; std::queue<data_chunk> data_queue; std::condition_variable data_cond; void data_preparation_thread() { while(more_data_to_prepare()) { data_chunk const data=prepare_data(); { // 对互斥量进行上锁 std::lock_guard<std::mutex> lk(mut); data_queue.push(data); } // 调用condition_variable的notify_one函数通知等待线程 // 等待解锁后再调用notify_one,避免等待线程立即wake后,由于互斥量未被解锁而又被阻塞。 // 解锁一个等待该条件变量的线程。如果不存在等待线程,则什么也不发生;如果存在多个等待线程,则无法确定唤醒哪个等待线程 data_cond.notify_one(); } } void data_processing_thread() { while(true) { // 对互斥量进行上锁 // Tips: 此处使用的是 std::unique_lock<std::mutex>,不能使用 std::lock_guard<std::mutex>(该函数没有提供unlock函数) std::unique_lock<std::mutex> lk(mut); // 第一个参数:std::unique_lock<std::mutex> // 第二个参数:lambda 函数用于表示等待的条件 // wait 函数的实现:先调用lambda函数检查条件是否满足,如果满足,则返回;如果不满足,则调用 lk.unlock 释放锁,并且将线程状态转换为阻塞或等待状态。当 data_preparation_thread 线程调用条件变量 data_cond 的 notify_one 函数时,data_processing_thread 从睡眠状态醒来,调用 lk.lock 上锁,然后再次调用 lambda 函数检查条件是否满足。 data_cond.wait(lk,[]{return !data_queue.empty();}); data_chunk data=data_queue.front(); data_queue.pop(); // 当前面 wait 没有阻塞过时,此处 unlock 对应与开始的 lock // 当前面 wait 阻塞过时,此处的 unlock 对于与 wait 中的 lock lk.unlock(); process(data); if(is_last_chunk(data)) break; } }

不是直接响应另一个线程的通知而执行上锁和检查(等待线程重新获取互斥量并检查条件变量)的情况,被称为 spurious wake(伪唤醒)。伪唤醒的数量和频率都是不确定的,所以不建议使用有副作用的函数做条件检查(如果条件检查很耗时,对性能影响会很大)。

本质上来说 std::condition_variable::wait 是对忙等的优化。下面代码是使用忙等实现的 wait,你的代码既应该能适用于 minimal_wait ,也应该能适用于杜绝了伪唤醒的 wait。

template<typename Predicate> void minimal_wait(std::unique_lock<std::mutex>& lk,Predicate pred) { while(!pred()) { lk.unlock(); lk.lock(); } }

Building a thread-safe queue with condition variables

#include <queue> #include <memory> // 为了使用std::shared_ptr #include <mutex> #include <condition_variable> template<typename T> class threadsafe_queue { private: mutable std::mutex mut; // bool empty() const成员函数中使用了该变量,因此需要使用mutable修饰 std::queue<T> data_queue; std::condition_variable data_cond; public: threadsafe_queue() {} threadsafe_queue(threadsafe_queue const& other) { std::lock_guard<std::mutex> lk(other.mut); data_queue=other.data_queue; } threadsafe_queue& operator=(const threadsafe_queue&) = delete; // 为了简单起见,不允许赋值操作符 void push(T new_value) { { std::lock_guard<std::mutex> lk(mut); data_queue.push(new_value); } // 通知等待线程 队列中有数据了 // notify_one 无法保证会通知哪个等待线程 data_cond.notify_one(); } void wait_and_pop(T& value) { std::unique_lock<std::mutex> lk(mut); data_cond.wait(lk,[this]{return !data_queue.empty();}); value=data_queue.front(); data_queue.pop(); } std::shared_ptr<T> wait_and_pop() { std::unique_lock<std::mutex> lk(mut); data_cond.wait(lk,[this]{return !data_queue.empty();}); std::shared_ptr<T> res(std::make_shared<T>(data_queue.front())); data_queue.pop(); return res; } bool try_pop(T& value) { std::lock_guard<std::mutex> lk(mut); if(data_queue.empty()) return false; value=data_queue.front(); data_queue.pop(); return true; } std::shared_ptr<T> try_pop() { std::lock_guard<std::mutex> lk(mut); if(data_queue.empty()) return std::shared_ptr<T>(); std::shared_ptr<T> res(std::make_shared<T>(data_queue.front())); data_queue.pop(); return res; } bool empty() const { // std::lock_guard<std::mutex> lk(mut); return data_queue.empty(); } }; threadsafe_queue<data_chunk> data_queue; void data_preparation_thread() { while(more_data_to_prepare()) { data_chunk const data=prepare_data(); data_queue.push(data); } } void data_processing_thread() { while(true) { data_chunk data; data_queue.wait_and_pop(data); process(data); if(is_last_chunk(data)) break; } }

Waiting for one-off events with futures

假设你要乘飞机去国外度假,当到达机场办理完各种登机手续后,还需要等待机场广播通知登机。这段时间内,你可能会在候机室里面找一些事情来打发时间,比如:读书,上网,或者来一杯咖啡。但本质上讲,你只是在等待一件事情:机场广播通知登机。另外,指定的航班只会出发一次,下次你再乘飞机去度假时,乘坐的可能就是其他航班了。

C++标准库使用 future 来表示这种一次性事件。当线程需要等待特定事件时,其会以某种方式获得代表该事件的 future。之后,线程可以周期性地(以很短的周期)在 future 上进行等待,来检查事件是否触发(检查信息板),检查期间也会执行其他任务(品尝机场昂贵的咖啡)。或者,线程可以先执行其他任务,直到该任务需要此事件发生时,再等待此事件对应的 future 的状态会变为就绪状态。future 可能是和数据相关(比如,登机口编号),也可能不是。一旦事件发生后(future 状态变为就绪),这个 future 将不能被重置。

C++标准库提供了两类 future:unique futures (std::future<>) 和 shared futures (std::shared_future<>)。这两个类和 std::unique_ptr<>、std::shared_ptr<>这两个类很类似。对于指定事件,只能有一个 std::future<> 实例与该事件关联;但是,可以有多个 std::shared_future<>实例关联同一个事件,当事件发生后,其对应的多个 std::shared_future<>实例会同时变为 ready 状态。

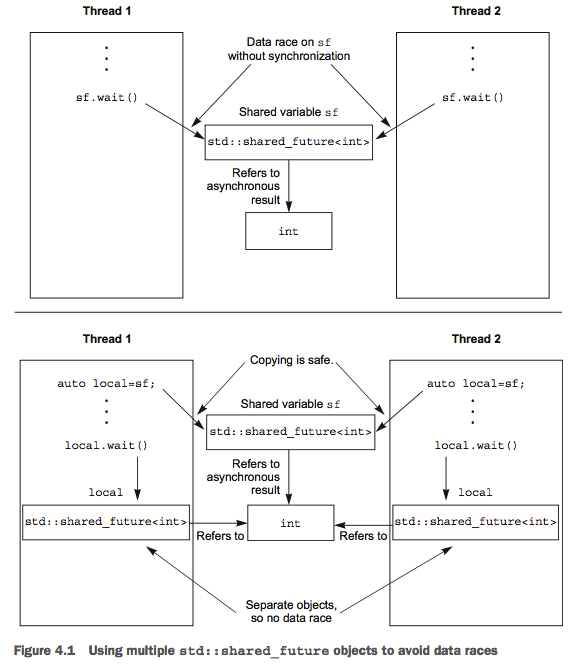

std::future<T>和 std::shared_future<T>的模版参数类型为他们所关联的数据的类型。std::future<void>和 std::shared_future<void>表示 future 不关联任何数据。尽管,future 对象可用于不同线程之间交流信息,但是,future 对象本身并没有提供同步访问保护,需要使用 mutex 或其他同步机制来保护多个线程对同一个 future 对象的访问。但是,每个线程可以拥有自己的 std::shared_future<>实例,这样就不需要同步机制保护了。

Concurrency Technical Specification 提供了 std::future<T>和 std::shared_future<T> 的扩展版本 std::experimental::future<> 和 std::experimental::shared_future<>。它们的行为与 std 命名空间中的对应项相同,但它们具有额外的成员函数以提供额外的功能。重要的是要注意 std::experimental 名称并不意味着代码质量有任何问题(我希望实现将与您的库供应商提供的其他所有东西的质量相同)。强调这些是非标准的类和函数,因为,它们可能和最终未来被 C++ 标准采用的版本,在语法和语义上有差别。包含头文件 <experimental/future> 就可以使用这两个类了。

Returning values from background tasks

假设你有一个耗时的计算,其最终会返回一个有用的结果,你当前还不需要这个结果值。你可以开启一个线程来执行计算,但是,其没有提供直接返回结果的机制。std::async 实现了该功能。你可以使用 std::async 开启一个异步任务,其会返回一个 std::future 对象,该 std::future 对象最终会持有异步任务计算的结果。当你需要计算结果的时候,可以在该 std::future 对象上执行 get() 方法,这会导致当前线程阻塞,直到 std::future 对象变为 ready 状态,然后返回结果值。

#include <future> #include <iostream> int find_the_answer_to_ltuae(); void do_other_stuff(); int main() { std::future<int> the_answer=std::async(find_the_answer_to_ltuae); do_other_stuff(); std::cout<<"The answer is "<<the_answer.get()<<std::endl; }

std::async 和 std::thread 一样,也允许传递额外的参数,如果参数为 rvalue,会使用移动构造函数。

#include <string> #include <future> struct X { void foo(int,std::string const&); std::string bar(std::string const&); }; X x; auto f1=std::async(&X::foo,&x,42,"hello"); // 调用p->foo(42, "hello"),p是指向x的指针 auto f2=std::async(&X::bar,x,"goodbye"); // 调用tmpx.bar("goodbye"), tmpx是x的拷贝副本 struct Y { double operator()(double); }; Y y; auto f3=std::async(Y(),3.141); // 调用tmpy(3.141),tmpy通过Y的移动构造函数得到 auto f4=std::async(std::ref(y),2.718); // 调用y(2.718) X baz(X&); std::async(baz,std::ref(x)); // 调用baz(x) class move_only { public: move_only(); move_only(move_only&&) move_only(move_only const&) = delete; move_only& operator=(move_only&&); move_only& operator=(move_only const&) = delete; void operator()(); }; auto f5=std::async(move_only()); // 调用tmp(),tmp是通过std::move(move_only())构造得到

默认情况下,std::async 是否会开启一个新的线程,future 所等待的任务是否是异步执行,取决于实现。你可以通过为 std::async 指定额外的参数来控制。参数的类型为 std::launch。参数 std::launch::deferred 表示延迟调用,其指定在 future 对象上执行 get 或 wait 时才调用任务。std::launch::async 表示异步调用,其指定任务必须是异步执行的。std::launch::deferred | std::launch::async 参数表示异步延迟调用,该参数是默认参数。

Tips:

- 延迟调用的函数,可能永远都不会被调用(因为,没有执行 future 的 wait 或 get 方法)。

- c++标准指出,std::launch::deferred | std::launch::async 参数表示自动策略模式。具体实现取决于系统和 libray。通常实现会考虑系统的并行能力来进行优化。

- https://www.cplusplus.com/reference/future/async/

auto f6=std::async(std::launch::async, Y(), 1.2); // 在新线程上执行 auto f7=std::async(std::launch::deferred, baz, std::ref(x)); // 在wait()或get()调用时执行 auto f8=std::async(std::launch::deferred | std::launch::async, baz, std::ref(x)); // 异步、延迟调用 auto f9=std::async(baz, std::ref(x)); f7.wait(); // 调用延迟函数

Associating a task with a future

std::packaged_task<> 可以将 std::future 和一个函数或可调用对象绑在一起。当 std::packaged_task<>被调用调用后,其会调用关联的函数或可调用对象,并将 std::future 的状态变为 ready,返回值被存储为 future 所关联的数据。这可用于实现线程池 (thread pool) 或其他的任务管理机制。如果一个大任务可以被分解为多个子任务,可以将每个子任务封装为一个 std::packaged_task<> 实例,然后将实例传递给任务调度器或线程池。这样的抽象,使得调度器只需要处理 std::packaged_task<> 实例,而不是各个独立的函数,也就不用关心任务的具体细节了。

std::packaged_task<>的目标参数是函数签名。例如:void()表示不需要参数,没有返回值的函数。int(std::string&,double*)表示需要 string 和 double*参数,返回值为 int 的函数。传递给 std::packaged_task<>的函数的参数必须和 std::packaged_task<>的模板参数匹配,函数返回值只要可以转化为对应模板参数函数签名的返回值即可。模板参数函数签名的返回值对应了 std::future 所关联的数据类型。

template<> class packaged_task<std::string(std::vector<char>*,int)> { public: template<typename Callable> explicit packaged_task(Callable&& f); std::future<std::string> get_future(); void operator()(std::vector<char>*,int); };

Passing Task between thread

很多 GUI frameworks 要求对 GUI 的更新必须在指定线程上执行,当其他线程需要更新 GUI 时,其必须发送消息给指定线程。std::packaged_task<> 提供了一种方式可以实现该需求,而不需要自定义消息。

#include <deque> #include <mutex> #include <future> #include <thread> #include <utility> std::mutex m; std::deque<std::packaged_task<void()> > tasks; bool gui_shutdown_message_received(); void get_and_process_gui_message(); void gui_thread() // 1 { while(!gui_shutdown_message_received()) // 2 { get_and_process_gui_message(); // 3 std::packaged_task<void()> task; { std::lock_guard<std::mutex> lk(m); if(tasks.empty()) // 4 continue; task=std::move(tasks.front()); // 5 tasks.pop_front(); } task(); // 6 } } std::thread gui_bg_thread(gui_thread); template<typename Func> std::future<void> post_task_for_gui_thread(Func f) { std::packaged_task<void()> task(f); // 7 std::future<void> res=task.get_future(); // 8 std::lock_guard<std::mutex> lk(m); tasks.push_back(std::move(task)); // 9 return res; // 10 }

Making (std::)promises

当应用程序需要处理很多网络连接时,为每个连接分配一个线程,这样使得网络交互更容易理解,也容易代码编写。不幸的是,随着连接数量的增长,这种方式变的不再适用。因为大量的线程会消耗大量的系统资源,还有可能造成线程上下文频繁切换(当线程数量超出硬件可接受的并发数时),这都会对性能有影响。极端情况下,操作系统可能会在其网络连接容量耗尽之前耗尽用于运行新线程的资源。因此只使用少数线程处理网络连接,每个线程同时处理多个连接,对需要处理大量网络连接的应用而言,这是一种比较普遍的做法。

std::promise<T> 提供了一种方式可以设置一个 T 类型的值,随后可以通过关联的 std::future<T>读取该值。一对 std::promise<T>和 std::future<T> 可以提供一种机制实现如下功能:等待线程可以阻塞在 future 上,提供数据的线程可以使用 promise 来设置关联的数据,使得 future 的状态变为 ready。你可以通过调用 std::promise<T>的成员函数 get_future 来获得其关联的 future。当使用 std::promise<T>的成员函数 set_value()设置 std::promise 的值后,std::future<T>的状态变为 ready,此时就可以通过 future 获得存储的值。

#include <future> void process_connections(connection_set& connections) { while(!done(connections)) // 1 { for(connection_iterator connection=connections.begin(),end=connections.end(); // 2 connection!=end; ++connection) { if(connection->has_incoming_data()) // 判断是否收到数据 { data_packet data=connection->incoming(); // 此处假设收到的数据包含一个id和一个payload数据 每个id都对应一个promise对象 std::promise<payload_type>& p = connection->get_promise(data.id); p.set_value(data.payload); // 将payload数据设置为 promise 的值 } if(connection->has_outgoing_data()) // 判断是否发送数据 { outgoing_packet data = connection->top_of_outgoing_queue(); connection->send(data.payload); // 发送数据完成后,设置 promise 的值为ture data.promise.set_value(true); } } } }

Tips: 上面的代码没有处理异常情况。

#include <vector> #include <thread> #include <future> #include <numeric> #include <iostream> #include <chrono> void accumulate(std::vector<int>::iterator first, std::vector<int>::iterator last, std::promise<int> accumulate_promise) { int sum = std::accumulate(first, last, 0); accumulate_promise.set_value(sum); // Notify future } void do_work(std::promise<void> barrier) { std::this_thread::sleep_for(std::chrono::seconds(1)); barrier.set_value(); } int main() { // Demonstrate using promise<int> to transmit a result between threads. std::vector<int> numbers = { 1, 2, 3, 4, 5, 6 }; std::promise<int> accumulate_promise; std::future<int> accumulate_future = accumulate_promise.get_future(); std::thread work_thread(accumulate, numbers.begin(), numbers.end(), std::move(accumulate_promise)); // future::get() will wait until the future has a valid result and retrieves it. // Calling wait() before get() is not needed //accumulate_future.wait(); // wait for result std::cout << "result=" << accumulate_future.get() << '\n'; work_thread.join(); // wait for thread completion // Demonstrate using promise<void> to signal state between threads. std::promise<void> barrier; std::future<void> barrier_future = barrier.get_future(); std::thread new_work_thread(do_work, std::move(barrier)); barrier_future.wait(); new_work_thread.join(); }

Saving an exception for the future

如果函数作为 std::async 的一部分被调用时,抛出了异常,异常会被保存到关联的 std::future 中,并且 future 状态会变为 ready,当调用 future 的 get()成员函数时,会再次抛出存储的异常(注意:标准没有指明,再次抛出的异常为原始异常对象还是原始异常对象的克隆体,不同编译器或库可能会有不同选择)。类似地,如果使用 std::packaged_take<>封装一个函数,调用任务时,如果抛出异常,异常也会被保存到关联的 std::future 中。std::promise 也提供了类似的机制。如果你希望保存一个异常而不是值,你可以调用 std::promise 的 set_exception() 成员函数

extern std::promise<double> some_promise; try { some_promise.set_value(calculate_value()); } catch(...) { // 此处使用了std::current_exception() 来获得当前抛出的异常 some_promise.set_exception(std::current_exception()); }

如果异常是可知的,则应该使用 std::make_exception_ptr(…),这样可以允许编译器有更多机会来优化代码。

extern std::promise<double> some_promise; bool result = process_data(); if (result) { some_promise.set_value(true); } else { some_promise.set_exception(std::make_exception_ptr(std::logic_error("process data error"))); }

另一种存储异常到 future 对象的方法是,在调用 std::promise 的 set_value 方法之前或者在调用 std::packaged_task 封装的任务之前销毁 std::promise 或 std::packaged_task 对象。此时 std::promise 或 std::packaged_task 的析构函数会将 std::future_error 异常存入 future,该异常会携带一个 std::future_errc::broken_promise 的错误码。如果编译器没有写入任何异常,等待线程会一直等待。

Waiting from multiple threads

尽管从一个线程传递数据到另一个线程时,必须使用 future,但是,future 对象本身并不是多线程安全的,多个线程访问同一个 future 实例的成员函数会导致 data race。设计上 future 对象就是不可以由多个线程访问的,future 的 get 成员函数只能调用一次,只有一个线程可以调用 future 对象的 get 成员函数来获得计算结果,第一次调用 get 成员函数后,内部的共享状态会被释放,再次调用 get 成员函数将导致未定义行为。

如果你需要多个线程等待同一事件,可以使用 std::shared_future。std::future 是只 movable 的,所有权可以在多个实例之间转移,但是,同一时间只有一个实例引用到特定的异步结果;std::shared_future 是 copyable 的,多个实例可以引用到同一个异步结果。

多个线程同时访问单个 std::shared_future 时,依然是存在 data race 的。使用锁进行保护可以避免 data race。但是,更好的方式是为每个线程传入克隆的 std::shared_future 实例,这样每个线程可以安全地访问其局部的 std::shared_future 实例,而不需要锁的保护。

使用 std::shared_future 的一个例子是 Excel。Excel 中多个 cell 最终的值可能是通过公式计算得到的,而这些 cell 可能都会引用某一个 cell 的值,我们可以使用 std::shared_future 表示每个 cell,这样每个 cell 的计算可以并行执行,当 cell A 引用另一个 cell B 时,cell A 调用 cellBFuture.get() 时会阻塞,直到 cell A 的计算完成。

引用某个异步状态的 std::shared_future 实例是从引用该状态的 std::future 实例构造的。 由于 std::future 对象不与任何其他对象共享异步状态的所有权,因此必须使用 std::move 将所有权转移到 std::shared_future 中,使 std::future 处于空状态:

std::promise<int> p; std::future<int> f(p.get_future()); assert(f.valid()); // f 是合法的 std::shared_future<int> sf(std::move(f)); assert(!f.valid()); // f 现在是不合法的 assert(sf.valid()); // sf 现在是合法的

如其他可移动对象一样,转移所有权对右值来说是隐式操作(不需要 std::move),所以可以使用 std::promise 对象的成员函数 get_future()的返回值,直接构造一个 std::shared_future 对象:

std::promise<std::string> p; std::shared_future<std::string> sf(p.get_future()); // 隐式转移所有权 使用std::future右值对象构造一个std::shared_future 对象

std::future 有一个额外的特性,其可以方便 std::shared_future 的使用。该特性可以从初始化器自动推断变量的类型。share() 成员函数就利用了该特性,其创建一个新的 std::shared_future 对象,直接将自己的所有权传递给新对象。这有效简化了代码:

std::promise< std::map< SomeIndexType, SomeDataType, SomeComparator, SomeAllocator>::iterator> p; // 推断 sf 的类型为 std::shared_future< std::map<SomeIndexType, SomeDataType, SomeComparator, SomeAllocator>::iterator > // 如果 Comparator 或Allocator改变了,只需要修改promise的类型,std::shared_future的类型会自动更新 auto sf=p.get_future().share();

Waiting with a time limit

前面介绍的阻塞调用都会将线程阻塞一段不确定长度的时间,直到等待的特定事件发生才会唤醒等待线程。大多数情况下这样做都是可行的,但是有时候你希望能指定等待的最长时长。这样你就可以发送“正在处理中…”这样的消息给交互的用户或其他进程,甚至当用户放弃等待并点击了取消按钮后,你可以直接退出等待。

你可以指定两种类型的超时:时间段超时(duration-based timeout),例如:等待 30 秒,绝对超时(absolute timeout),例如:等到 2021 年 1 月 1 日 0 时 0 分 0 秒。等待函数的变体提供了指定超时的功能。_for 处理时间段超时,_until 处理绝对超时。

Clocks

就 C++ 标准库而言,时钟是时间信息的来源。 具体来说,时钟类提供了四种不同的时间信息:

- 当前的时间信息

- 时间值的类型信息

- 时钟的嘀嗒周期

- 时钟嘀嗒的周期是否是固定不变的(如果 tick 周期固定不变,则称时钟是稳定的)

调用时钟类的 now() 静态成员函数可以获得当前时间。例如:std::chrono::system_clock::now() 返回系统时钟的当前时间。

时间值(时间点)的类型信息为时钟的 time_point 类型成员。例如:std::chrono::system_clock::now() 返回的时间点类型为 std::chrono::system_clock::time_point。

时钟的嘀嗒周期被指定为 n 秒 m 次,时钟周期的类型为时钟的 period 类型成员,其为 std::ratio<int,int>。例如:std::ratio<5,2> 表示 5 秒钟嘀嗒 2 次。如果时钟 tick 的周期到运行时才能确定,或者时钟 tick 周期会变化,则时钟周期可能被指定为平均的 tick 周期或者最小的 tick 周期或者库实现者认为合适的值。

如果 tick 周期固定不变,且不可调节,则称时钟为稳定的(steady)时钟。该时钟类对应的静态成员函数 is_steady() 返回 true。通常来说 std::chrono::system_clock 时钟不是稳定的,该时钟的 tick 是可调节的(该时钟类 tick 的调节是自动执行的)。这样的调节可能导致,依次调用两次 now() 成员函数,后一次的时间点在前一次之前。稳定的时钟对于超时计算来说非常重要。c++标准库提供的稳定时钟为 std::chrono::steady_clock。std::chrono::system_clock 表示系统的实时时钟。std::chrono::high_resolution_clock 为标准库能提供的精度最高的时钟(该时钟可能是其他类型时钟的 typedef)。

struct system_clock // wraps GetSystemTimePreciseAsFileTime/GetSystemTimeAsFileTime { using rep = long long; using period = ratio<1, 10'000'000>; // 100 nanoseconds using duration = _CHRONO duration<rep, period>; using time_point = _CHRONO time_point<system_clock>; static constexpr bool is_steady = false; _NODISCARD static time_point now() noexcept { // get current time return time_point(duration(_Xtime_get_ticks())); } _NODISCARD static __time64_t to_time_t(const time_point& _Time) noexcept { // convert to __time64_t return duration_cast<seconds>(_Time.time_since_epoch()).count(); } _NODISCARD static time_point from_time_t(__time64_t _Tm) noexcept { // convert from __time64_t return time_point{seconds{_Tm}}; } };

cout << chrono::system_clock::period::num << "/" << chrono::system_clock::period::den << endl;

// system_clock::to_time_t #include <iostream> #include <ctime> #include <ratio> #include <chrono> int main () { using namespace std::chrono; duration<int,std::ratio<60*60*24> > one_day (1); system_clock::time_point today = system_clock::now(); system_clock::time_point tomorrow = today + one_day; time_t tt; tt = system_clock::to_time_t ( today ); std::cout << "today is: " << ctime(&tt); tt = system_clock::to_time_t ( tomorrow ); std::cout << "tomorrow will be: " << ctime(&tt); return 0; } ////////// // OUTPUT: // today is: Wed May 30 12:38:06 2012 // tomorrow will be: Thu May 31 12:38:06 2012

Durations

Durations 是时间支持中最简单的部分。std:: chrono::duration<> 模板类用于表示持续的时间间隔。第一个模板参数是表示时间间隔数量的类型,第二个参数表示单位时间间隔对应多少秒,是一个 ratio 类型。例如:std::chrono::duration<short,std:: ratio<60,1>> 表示单位时间间隔为 1 分钟(60/1 秒),时间间隔数量使用 short 类型来存储。std::chrono::duration<double,std::ratio <1,1000>>表示单位时间间隔为 1 毫秒(1/1000 秒),时间间隔数量使用 double 类型来存储。

template <class _Rep, class _Period> class duration { // represents a time duration public: using rep = _Rep; using period = typename _Period::type; static_assert(!_Is_duration_v<_Rep>, "duration can't have duration as first template argument"); static_assert(_Is_ratio_v<_Period>, "period not an instance of std::ratio"); static_assert(0 < _Period::num, "period negative or zero"); // ...... private: _Rep _MyRep; // the stored rep };

标准库定义了一些常见的时间间隔:nanoseconds, microseconds, milliseconds, seconds, minutes, and hours。标准库还定义了一些 ratio:std::atto(10 的负 18 次方)、std::exa(10 的 18 次方)、std::centi(百分之一)。

在 c++14 中还引入了一些后缀操作符。可以很方便地定义 duration 常量。当使用整型字面值常量时,对应的类型为预定义的时间间隔。当使用浮点字面值常量时,会特化适当类型的 duration 模板类。如果对于 duration::rep 的精度有要求,应该自己特化 duration 模板类。

using namespace std::chrono_literals; auto one_day=24h; // 相当于 std::chrono::hours(24) auto half_an_hour=30min; // 相当于 std::chrono::minutes(30) auto max_time_between_messages=30ms; // 相当于 std::chrono::milliseconds(30) auto float_literal_dur = 2.5min; // 相当于 std::chrono::duration<float, std::ratio<60,1>>

当 duration 类型转换不会产生截断时,转化可以隐式进行,否则需要显示指定转化。例如:hours 转化为 seconds 可以隐式转化。显示转化的结果是截断后的结果,而不是执行四舍五入的结果。

std::chrono::milliseconds ms(54802); std::chrono::seconds s = std::chrono::duration_cast<std::chrono::seconds>(ms); // 使用std::chrono::duration_cast<> 进行显示转化

基于时间段的等待(duration-based wait)是通过使用 std::chrono::duration<> 实例来实现的。wait 函数会返回一个状态来指示等待结果。例如,对于 future 来说,状态类型为 std::future_status,std::future_status::timeout 表示等待超时;std::future_status::ready 表示等待的事件发生 future 状态为 ready;std::future_status::deferred 表示 future 对应的任务延时了。duration-based wait 使用的时钟是标准库中的稳定时钟(steady clock),因此 35 毫秒就是意味着经过 35 毫秒,即使系统时钟可能向前或向后进行调节,都不会受到影响。当然,系统调度的变幻莫测以及操作系统时钟精度的变化可能会导致时间间隔比 35 毫秒要长。

std::future<int> f=std::async(some_task); if(f.wait_for(std::chrono::milliseconds(35))==std::future_status::ready) { do_something_with(f.get()); }

Time points

时钟的时间点是通过 std::chrono::time_point<>模板类来表示的。第一个模板参数指定了时钟的类型,第二个模板参数指定了时钟对应的 duration,duration 表示了时间间隔数量的类型、时钟的嘀嗒周期。时间点的值(time_point)存储的是从某个特定时间点开始的时间长度,该特定的时间点被称为时钟纪元。时钟纪元是时钟的基础属性,但是时钟纪元无法被直接查询,其也不是由 c++标准指定的。典型的时间纪元包括 1970 年 1 月 1 日 0 时 0 分 0 秒 和 计算机启动的时刻。多个时钟可能共享同一个时间纪元也可能使用各自不同的时间纪元。 time_since_epoch()成员函数可以返回从时间纪元到给定时间点的时间间隔。

template<class Clock, class Duration = typename Clock::duration> class time_point; // some_time_point 保存了 std::chrono::system_clock 相关的时间点,并且以分为单位来衡量而不是 std::chrono::system_clock 指定的时钟滴答周期。 std::chrono::time_point<std::chrono::system_clock, std::chrono::minutes> some_time_point; // 创建 time_point const auto p0 = std::chrono::time_point<std::chrono::system_clock>{}; std::time_t epoch_time = std::chrono::system_clock::to_time_t(p0); std::cout << "epoch: " << std::ctime(&epoch_time); // OUTPUT--> epoch: Thu Jan 1 00:00:00 1970 // time_point to unix-timestamp auto microsecondsUTC = std::chrono::duration_cast<std::chrono::microseconds>(std::chrono::system_clock::now().time_since_epoch()).count(); // time_point + duration std::chrono::high_resolution_clock::now() + std::chrono::nanoseconds(500) // 打印代码执行时长 // time_point - time_point --> duration auto start=std::chrono::high_resolution_clock::now(); do_something(); auto stop=std::chrono::high_resolution_clock::now(); std::cout<<"do_something() took " << std::chrono::duration<double>(stop-start).count() << " seconds"<<std::endl;

当将 time_point 传递给 wait 函数时,其指定了一个绝对的超时,time_point 的 clock 参数用于衡量超时。wait 函数会跟踪 clock 的改变,直到 clock 的 now 成员函数返回的值为 time_point 之后的值,wait 函数才会返回。如果 clock 被向前调整,会导致等待时长变短,如果 clock 被向后调整,等待时长则会变长。

#include <condition_variable> #include <mutex> #include <chrono> std::condition_variable cv; bool done; std::mutex m; bool wait_loop() { auto const timeout= std::chrono::steady_clock::now()+std::chrono::milliseconds(500); std::unique_lock<std::mutex> lk(m); // 当使用条件变量时,没有传入predicate,就需要使用循环来处理伪唤醒的情况 while(!done) { // Tips: 在循环中使用 wait_for,可能在伪唤醒之前就等待超时,下次再进入等待后,又重新开始等待一段时间。这样的情况可能重复任意多次,使得总的等待时长是无界限的。而wait_util则不会出现这种情况 if(cv.wait_until(lk,timeout)==std::cv_status::timeout) break; } return done; }

Functions that accept timeouts

| 类型/命名空间 | 函数 | 返回值 |

|---|---|---|

| std::this_thread 命名空间 | sleep_for(duration) | N/A |

| sleep_until(time_point) | ||

| std::condition_variable | wait_for(duration) | std::cv_status::time_out |

| 或 std::condition_variable_any | wait_until(time_point) | 或 std::cv_status::no_timeout |

| wait_for(lock, duration, predicate) | bool —— 当唤醒时,返回谓词的结果 | |

| wait_until(lock, duration, predicate) | ||

| std::timed_mutex | try_lock_for(duration) | bool —— 获取锁时返回 true,否则返回 fasle |

| 或 std::recursive_timed_mutex | try_lock_until(time_point) | |

| std::unique_lock<TimedLockable> | ||

| unique_lock(lockable, duration) | owns_lock() | bool —— 当获取锁时返回 true,否则返回 false |

| unique_lock(lockable, time_point) | ||

| try_lock_for(duration) | ||

| try_lock_until(time_point) | ||

| std::future<ValueType> | wait_for(duration) | 当等待超时,返回 std::future_status::timeout |

| std::shared_future<ValueType> | wait_until(time_point) | 当共享状态的标记已经为 ready(即 Provider 在共享状态上设置了值或者异常),返回 std::future_status::ready |

| 当共享状态包含一个 deferred 函数,返回 std::future_status::deferred |

Using synchronization of operations to simplify code

使用前面提到的这些同步工具,你可以专注于需要同步的操作上,而不用关心同步的实现机制。这些同步工具提供了一种更加函数式地并发编程的方法,该方法可以简化你的代码。

Functional programming with futures

函数式编程是指一种编程分格,函数结果只依赖于该函数的参数,而不依赖外部的任何状态。这和数学上的函数概念相关,如果你使用相同的参数调用函数两次,则函数的结果相同。C++标准库中的很多函数具备该性质,例如:math::sin math::cos math::sqrt 等等。直接作用于基础类型的操作也具备该性质,例如:3+3 6*9 等等。我们将满足这种性质的函数称为纯函数(pure function)。

函数式编程不会修改函数外部的状态,因此,可以避免共享内存相关的很多问题。因为不会对共享数据进行修改,所以就不会有 race conditions,也就不需要使用互斥量对共享数据进行保护了。编程语言 Haskell 中,所有函数默认都为 prue function。因为大部分函数是纯函数,修改共享数据的非纯函数就会显得更加突出,因此更容易推理这些非纯函数是如何和整个程序结构配合的。

c++是一种多范式编程语言,完全可以使用 c++进行函数式编程。特别是 c++11 的到来,其引入了 lambda 函数,合并了 Boost 和 TR1 中的 std::bind,引入了变量类型的自动推断。future 又使得函数式并发在 c++中变的可行。

下面展示了函数式风格的、顺序执行的 QuickSort:

template<typename T> // 函数式编程风格的接口,函数不会修改任何外部状态,函数的执行结果通过返回值返回 std::list<T> sequential_quick_sort(std::list<T> input) { if(input.empty()) { return input; } // 因为使用了函数式风格的接口,此处需要创建新的list 存放结果 std::list<T> result; // splice(pos, from_list, from_list_pos) // 将input中开始的元素移动到result的开始位置 result.splice(result.begin(),input,input.begin()); T const& pivot=*result.begin(); auto divide_point=std::partition(input.begin(),input.end(), [&](T const& t){return t<pivot;}); // 因为使用了函数式风格的接口,此处需要创建新的list std::list<T> lower_part; lower_part.splice(lower_part.end(),input,input.begin(), divide_point); auto new_lower(sequential_quick_sort(std::move(lower_part))); auto new_higher(sequential_quick_sort(std::move(input))); result.splice(result.end(),new_higher); result.splice(result.begin(),new_lower); return result; }

下面展示了函数式风格的、并行执行的 QuickSort:

template<typename T> std::list<T> parallel_quick_sort(std::list<T> input) { if(input.empty()) { return input; } std::list<T> result; result.splice(result.begin(),input,input.begin()); T const& pivot=*result.begin(); auto divide_point=std::partition(input.begin(),input.end(), [&](T const& t){return t<pivot;}); std::list<T> lower_part; lower_part.splice(lower_part.end(),input,input.begin(), divide_point); // 使用future保存异步计算的结果 std::future<std::list<T>> new_lower(std::async(¶llel_quick_sort<T>,std::move(lower_part))); auto new_higher(parallel_quick_sort(std::move(input))); result.splice(result.end(),new_higher); result.splice(result.begin(),new_lower.get()); return result; }

函数式编程不是并发编程的唯一范式。另一种范式名为 CSP(Communicating Sequential Processes),其从概念上将线程完全分开,多个线程完全没有共享数据,他们通过通信通道来互相发送消息。Erlang 编程语言以及 MPI(Message Passing Interface)使用了这种范式。

Synchronizing operations with message passing

CSP(Communicating Sequential Processes) 的理念很简单:如果没有共享数据,每个线程就可以独立地进行推断,其行为完全依赖于它对收到消息是如何响应的。因此,每个线程相当于一个状态机:当收到一个消息后,其以某种方式更新自己的状态,还可能会给其他线程发送一个或多个消息。

CSP 完全没有共享数据,所有的交流通过消息队列来实现。但是 c++线程共享同一个地址空间,无法强制要求。因此,library 或应用程序的作者需要保证多个线程之间没有共享数据。当然,消息队列是需要被共享的,这样多个线程才能互相交互。

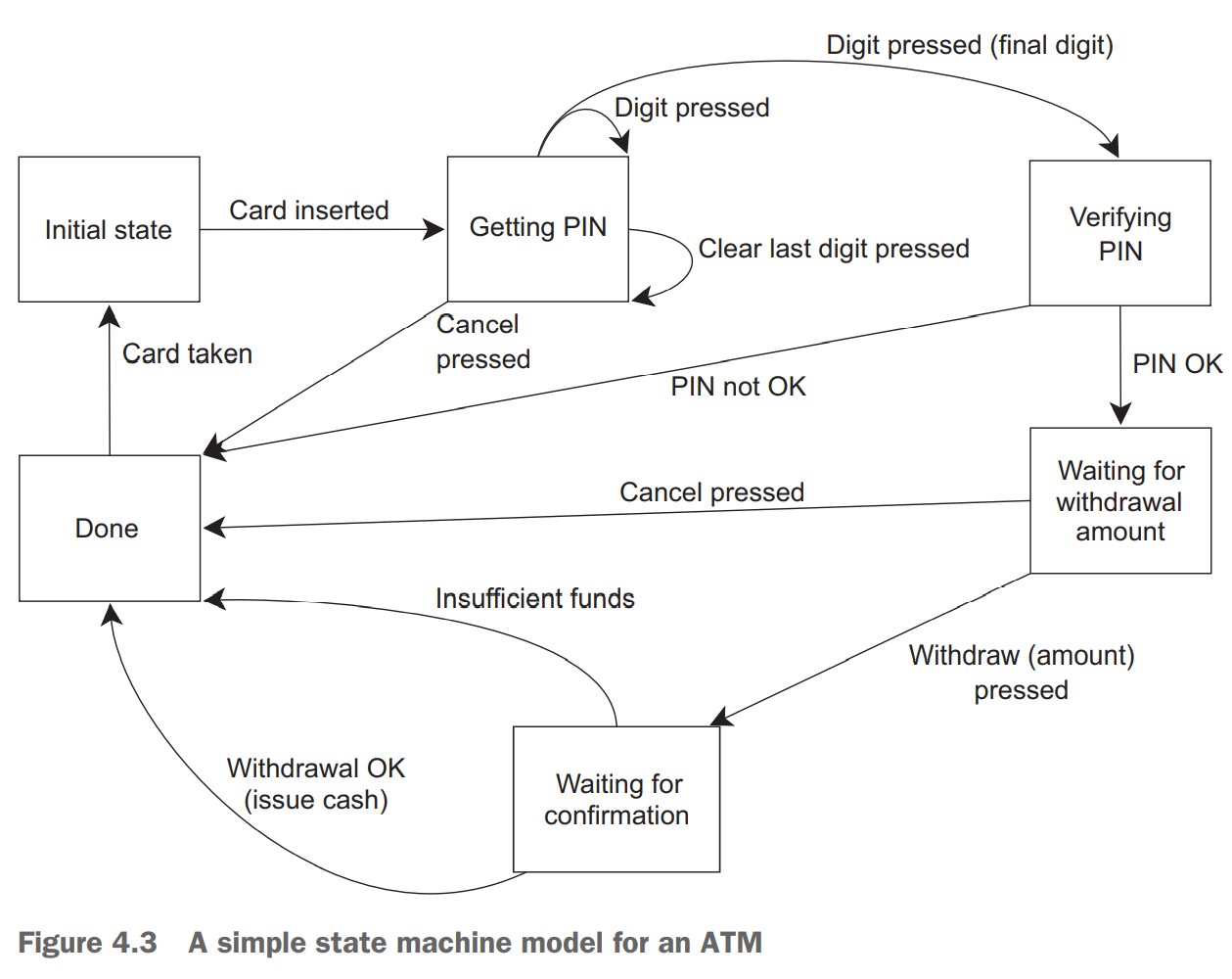

假设需要为 ATM 编写代码。代码需要处理 ATM 和取款人的交互,ATM 和银行柜台的交互,还需要控制物理机器接受取款人插入的磁卡,显示合适的信息,处理按键的点击,发放纸币,返还磁卡。可以将代码划分到 3 个独立线程中:一个处理物理机器,一个处理 ATM 逻辑,一个处理和银行的交互。

下图为将 ATM 逻辑线程建模为一个简单的状态机器:

class atm { messaging::receiver incoming; messaging::sender bank; messaging::sender interface_hardware; void (atm::*state)(); std::string account; unsigned withdrawal_amount; std::string pin; // 处理取款 void process_withdrawal() { incoming.wait() .handle<withdraw_ok>( [&](withdraw_ok const& msg) { interface_hardware.send( issue_money(withdrawal_amount)); bank.send( withdrawal_processed(account,withdrawal_amount)); state=&atm::done_processing; }) .handle<withdraw_denied>( [&](withdraw_denied const& msg) { interface_hardware.send(display_insufficient_funds()); state=&atm::done_processing; }) .handle<cancel_pressed>( [&](cancel_pressed const& msg) { bank.send( cancel_withdrawal(account,withdrawal_amount)); interface_hardware.send( display_withdrawal_cancelled()); state=&atm::done_processing; }); } // 处理余额查询 void process_balance() { incoming.wait() .handle<balance>( [&](balance const& msg) { interface_hardware.send(display_balance(msg.amount)); state=&atm::wait_for_action; }) .handle<cancel_pressed>( [&](cancel_pressed const& msg) { state=&atm::done_processing; }); } // 等待用户取款|查看余额|退出 void wait_for_action() { interface_hardware.send(display_withdrawal_options()); incoming.wait() .handle<withdraw_pressed>( [&](withdraw_pressed const& msg) { withdrawal_amount=msg.amount; bank.send(withdraw(account,msg.amount,incoming)); state=&atm::process_withdrawal; }) .handle<balance_pressed>( [&](balance_pressed const& msg) { bank.send(get_balance(account,incoming)); state=&atm::process_balance; }) .handle<cancel_pressed>( [&](cancel_pressed const& msg) { state=&atm::done_processing; }); } // 验证密码 void verifying_pin() { incoming.wait() .handle<pin_verified>( [&](pin_verified const& msg) { state=&atm::wait_for_action; }) .handle<pin_incorrect>( [&](pin_incorrect const& msg) { interface_hardware.send( display_pin_incorrect_message()); state=&atm::done_processing; }) .handle<cancel_pressed>( [&](cancel_pressed const& msg) { state=&atm::done_processing; }); } // 等待输入密码 void getting_pin() { incoming.wait() .handle<digit_pressed>( [&](digit_pressed const& msg) { unsigned const pin_length=4; pin+=msg.digit; if(pin.length()==pin_length) { bank.send(verify_pin(account,pin,incoming)); state=&atm::verifying_pin; } }) .handle<clear_last_pressed>( [&](clear_last_pressed const& msg) { if(!pin.empty()) { pin.pop_back(); } }) .handle<cancel_pressed>( [&](cancel_pressed const& msg) { state=&atm::done_processing; }); } // 等待插入磁卡 void waiting_for_card() { interface_hardware.send(display_enter_card()); incoming.wait() .handle<card_inserted>( [&](card_inserted const& msg) { account=msg.account; pin=""; interface_hardware.send(display_enter_pin()); state=&atm::getting_pin; }); } void done_processing() { interface_hardware.send(eject_card()); state=&atm::waiting_for_card; } atm(atm const&)=delete; atm& operator=(atm const&)=delete; public: atm(messaging::sender bank_, messaging::sender interface_hardware_): bank(bank_),interface_hardware(interface_hardware_) {} void done() { get_sender().send(messaging::close_queue()); } void run() { state=&atm::waiting_for_card; try { for(;;) { (this->*state)(); } } catch(messaging::close_queue const&) { } } messaging::sender get_sender() { return incoming; } };

这种编程风格可以极大简化并发系统的设计,可以独立地考虑每个线程。这也是使用多线程来分离关注点(Separate Concerns)的一个例子,你需要明确如何将多个任务划分到不同的线程中。

Continuation-style concurrency with the Concurrency TS

Concurrency TS 提供了新版本的 promise 和 packaged_task(std::experimental::promise 和 std::experimental::packaged_task.)。他们返回的实例为 std::experimental::future,其允许 Continuation-style 的并发编程。

std::experimental::future<int> find_the_answer; auto fut=find_the_answer(); // 当fut状态变为ready后,find_the_question函数会被调度,从而在某个未指明的线程上执行。 // 此处给了实现者自由来决定函数是在一个线程池上执行还是在库管理的线性上执行。这样做是有意而为之,当continuations被加到c++标准库后,实现者就可以根据他们的经验来更好地指定线程的选择并为用户提供合适的机制来控制线程的选择 auto fut2=fut.then(find_the_question); assert(!fut.valid()); assert(fut2.valid());

和直接调用 std::async 或 std::thread 不同,你不能传递参数给一个 continuation 函数,因为参数已经由 library 定义了——其接受一个 ready 状态的 future,该 future 持有触发 continuation 的函数的结果。例如:上面例子中 find_the_question 的签名为:

std::string find_the_question(std::experimental::future<int> the_answer);

Concurrency TS 没有实现一个类似于 std::async 的模板函数,实现这样的一个模板函数很简单,如下:

template<typename Func> std::experimental::future<decltype(std::declval<Func>()())> spawn_async(Func&& func){ std::experimental::promise<decltype(std::declval<Func>()())> p; auto res=p.get_future(); std::thread t( [p=std::move(p),f=std::decay_t<Func>(func)]() mutable { try { p.set_value_at_thread_exit(f()); } catch(...) { p.set_exception_at_thread_exit(std::current_exception()); } }); t.detach(); return res; } // TIPS: 使用p.set_value_at_thread_exit 和 p.set_exception_at_thread_exit 保证 future 状态变为 ready 时,线程的局部变量已经被清除。

Chaining continuations

std::experimental::future continuation

std::experimental::future 对象的 then 成员函数的返回值依然是一个 std::experimental::future 对象。这意味着,可以链接多个 continuations。

考虑如下这个例子:当用户请求登录应用程序时,你需要发送证书到后端做验证,当认证成功后,你需要向后端进一步请求用户账户相关的信息,最后,获得用户信息后,需要将相关信息展示出来。如果使用顺序方式编码,该过程对应的实现如下:

void process_login(std::string const& username, std::string const& password) { try { user_id const id = backend.authenticate_user(username, password); // 等待认证成功后,才能执行下面代码 user_data const info_to_display = backend.request_current_info(id); // 等待获取到用户信息后,才能执行下面代码 update_display(info_to_display); } catch(std::exception& e) { display_error(e); } }

但是,为了不阻塞 UI 线程,我们希望使用异步的代码。如果使用简单的 std::async,将所有逻辑都抛到后台线程。这样会阻塞后台线程,等待任务完成的过程中,依然消耗资源。如果当前有很多这样的任务,最终你将会有很多线程都在等待。下面是简单地使用 async 的方式:

std::future<void> process_login( std::string const& username, std::string const& password) { return std::async(std::launch::async,[=](){ try { user_id const id = backend.authenticate_user(username, password); user_data const info_to_display = backend.request_current_info(id); update_display(info_to_display); } catch(std::exception& e) { display_error(e); } }); }

为了避免线程的阻塞等待,需要某种机制(continuations)可以将多个 task 链接在一起,当一个任务完成后紧接着执行下一个任务,这样就可以避免阻塞等待或浪费资源在轮询上。下面代码使用了这种方式:

std::experimental::future<void> process_login(std::string const& username, std::string const& password) { return spawn_async([=](){ return backend.authenticate_user(username, password); // 从continuation 返回一个future 类型为 std::experimental::future<user_id> id }).then([](std::experimental::future<user_id> id){ // continuation 提供了future-unwrapping 特性,可以将 future<future<user_id>> 解包为 future<user_id> return backend.request_current_info(id.get()); }).then([](std::experimental::future<user_data> info_to_display){ try { update_display(info_to_display.get()); } catch(std::exception& e){ display_error(e); } }); }

如果编译器支持 c++14 引入的泛型 lambda,上面的代码可以简化为:

std::experimental::future<void> process_login(std::string const& username, std::string const& password) { return spawn_async([=](){ return backend.authenticate_user(username, password); }).then([](auto id){ // lambda 参数类型可以使用auto return backend.request_current_info(id.get()); }).then([](auto info_to_display){ // lambda 参数类型可以使用auto try { update_display(info_to_display.get()); } catch(std::exception& e){ display_error(e); } }); }

std::experimental::shared_future continuation

std::experimental::shared_future 也支持 continuations。std::experimental::shared_future 对象可以有多个 continuation,continuation 的参数类型为 std::experimental::shared_future。

// std::experimental::future的share()成员函数返回 std::experimental::shared_future 对象 auto fut = spawn_async(some_function).share(); auto fut2 = fut.then([](std::experimental::shared_future<some_data> data){ do_stuff(data); }); auto fut3 = fut.then([](std::experimental::shared_future<some_data> data){ return do_other_stuff(data); });

Waiting for more than one future

假设你有大量数据需要处理,并且可以独立处理每个数据项。

std::future<FinalResult> process_data(std::vector<MyData>& vec) { size_t const chunk_size = whatever; std::vector<std::future<ChunkResult>> results; for (auto begin=vec.begin(), end=vec.end(); beg!=end;) { size_t const remaining_size = end - begin; size_t const this_chunk_size = std::min(remaining_size, chunk_size); results.push_back(std::async(process_chunk, begin, begin+this_chunk_size)); begin += this_chunk_size; } return std::async([all_results=std::move(results)](){ std::vector<ChunkResult> v; v.reserve(all_results.size()); for (auto& f : all_results) { v.push_back(f.get()); // 此处会不断地阻塞唤醒 } return gather_results(v); }); }

上面这种实现方式独立地等待每个任务,导致合并结果的线程会被反复阻塞唤醒。这不仅使合并线程被等待占满,而且还导致额外的上下文切换。使用 std::experimental::when_all 可以避免阻塞等待和频繁的上下文切换。

std::experimental::future<FinalResult> process_data( std::vector<MyData>& vec) { size_t const chunk_size = whatever; std::vector<std::experimental::future<ChunkResult>> results; for (auto begin = vec.begin(), end = vec.end(); beg != end) { size_t const remaining_size = end - begin; size_t const this_chunk_size = std::min(remaining_size, chunk_size); results.push_back(spawn_async(process_chunk, begin, begin+this_chunk_size)); begin += this_chunk_size; } return std::experimental::when_all( results.begin(), results.end()).then( [](std::future<std::vector<std::experimental::future<ChunkResult>>> ready_results) { std::vector<std::experimental::future<ChunkResult>> all_results = ready_results.get(); std::vector<ChunkResult> v; v.reserve(all_results.size()); for (auto& f: all_results){ v.push_back(f.get()); // 此处不会阻塞 } return gather_results(v); }); }

Waiting for the first future in a set with when_any

假设你从一个巨大的数据集中搜索一个满足特定条件的值,如果有多个这样的值,则任何一个值都可以。

std::experimental::future<FinalResult> find_and_process_value(std::vector<MyData> &data) { unsigned const concurrency = std::thread::hardware_concurrency(); unsigned const num_tasks = (concurrency > 0)? concurrency : 2; std::vector<std::experimental::future<MyData *>> results; auto const chunk_size = (data.size() + num_tasks - 1) / num_tasks; auto chunk_begin = data.begin(); std::shared_ptr<std::atomic<bool>> done_flag = std::make_shared<std::atomic<bool>>(false); // 标记找到满足特定条件的值 for (unsigned i = 0; i < num_tasks; ++i) // 生成 num_tasks 个线程 { auto chunk_end = (i < (num_tasks - 1)? chunk_begin + chunk_size : data.end()); results.push_back(spawn_async([=]{ // lambda 使用copy capture,这样传入的变量就不会有 lifetime 问题了 for (auto entry = chunk_begin; !*done_flag && (entry != chunk_end); ++entry) { if (matches_find_criteria(*entry)) { *done_flag = true; return &*entry; } } return (MyData *)nullptr; })); chunk_begin = chunk_end; } std::shared_ptr<std::experimental::promise<FinalResult>> final_result = std::make_shared<std::experimental::promise<FinalResult>>(); struct DoneCheck { std::shared_ptr<std::experimental::promise<FinalResult>> final_result; DoneCheck(std::shared_ptr<std::experimental::promise<FinalResult>> final_result_) : final_result(std::move(final_result_)) {} void operator()(std::experimental::future<std::experimental::when_any_result<std::vector<std::experimental::future<MyData *>>>> results_param) { auto results = results_param.get(); MyData *const ready_result = results.futures[results.index].get(); // 从 future 中获得对应的值 if (ready_result) // 如果值不为空,则已经找到符合条件的值 { final_result->set_value(process_found_value(*ready_result)); } else { results.futures.erase(results.futures.begin() + results.index); // 移除处理过的结果 if (!results.futures.empty()) { std::experimental::when_any(results.futures.begin(), results.futures.end()).then(std::move(*this)); // 继续处理完成的任务 } else { final_result->set_exception(std::make_exception_ptr(std::runtime_error("Not found"))); } } } }; std::experimental::when_any(results.begin(), results.end()).then(DoneCheck(final_result)); // 当任何一个任务返回后,执行DoneCheck return final_result->get_future(); }

when_all 和 when_any 函数还支持不同类型的多个 future 作为参数,此时这两个函数的返回值为 future<tuple>

std::experimental::future<int> f1=spawn_async(func1); std::experimental::future<std::string> f2=spawn_async(func2); std::experimental::future<double> f3=spawn_async(func3); std::experimental::future< std::tuple< std::experimental::future<int>, std::experimental::future<std::string>, std::experimental::future<double>>> result = std::experimental::when_all(std::move(f1),std::move(f2),std::move(f3));

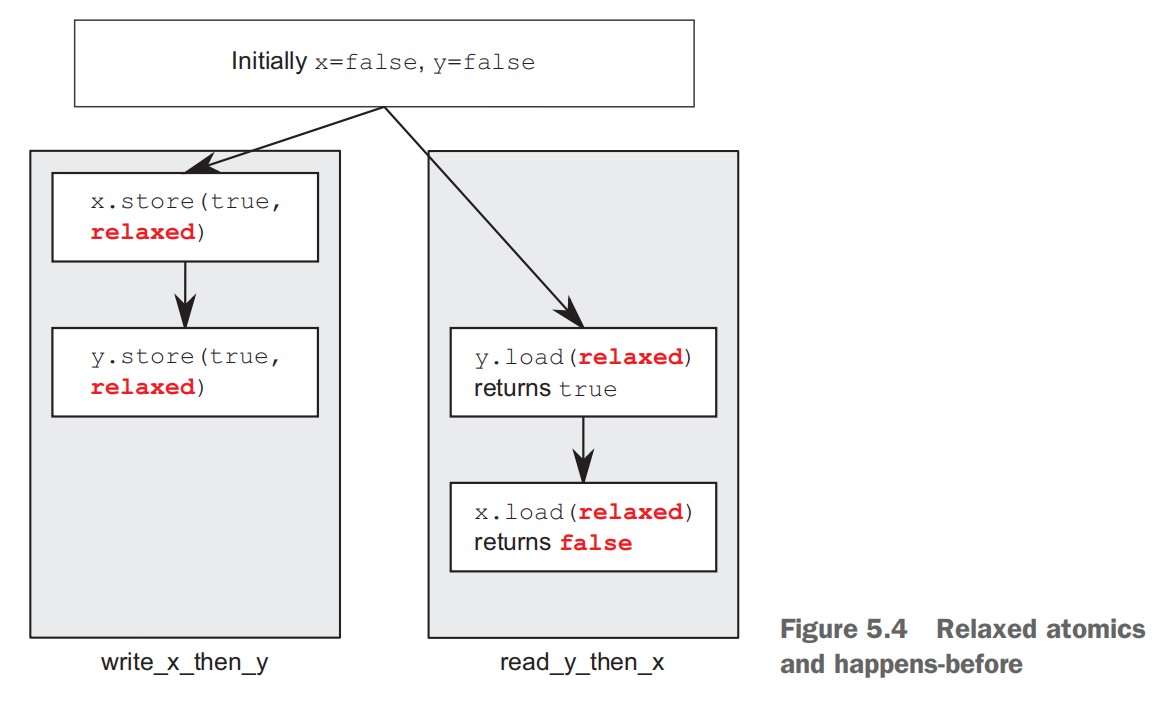

Latches and barriers in the Concurrency TS