UnityCatLikeCoding

Table of Contents

- UnityCatLikeCoding

- Basics

- Mesh Basics & Procedural Meshes

- Rendering & Advanced Rendering & CustomSRP

- Rendering

- Advanced Rendering

- CustomSRP

- MyTest

- Q&A

- 参考资料

UnityCatLikeCoding note.

<!– more –>

UnityCatLikeCoding

Basics

Building a Graph

- Heart Function https://zhidao.baidu.com/question/760898001022081444.html

Mathematical Surfaces

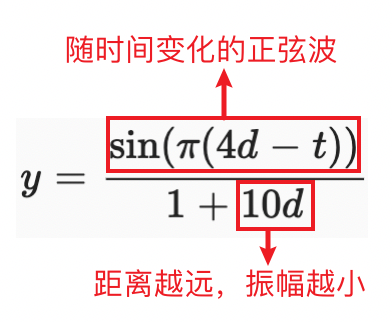

Ripple

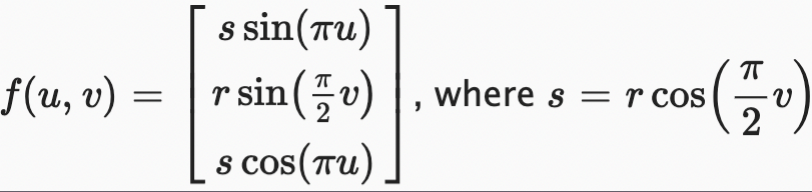

Sphere

u->[-1, 1]

v->[-1, 1]

[cos(pi*u), v, sin(pi*u)] 可以绘制出一个圆

r = cos(0.5*pi*v)

[r * sin(pi*u), v, r*cos(pi*u)] 可以绘制出一个球

将球的函数变换为如下形式,可以方便地对球的 r 进行变化:

Torus

Compute Shaders

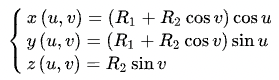

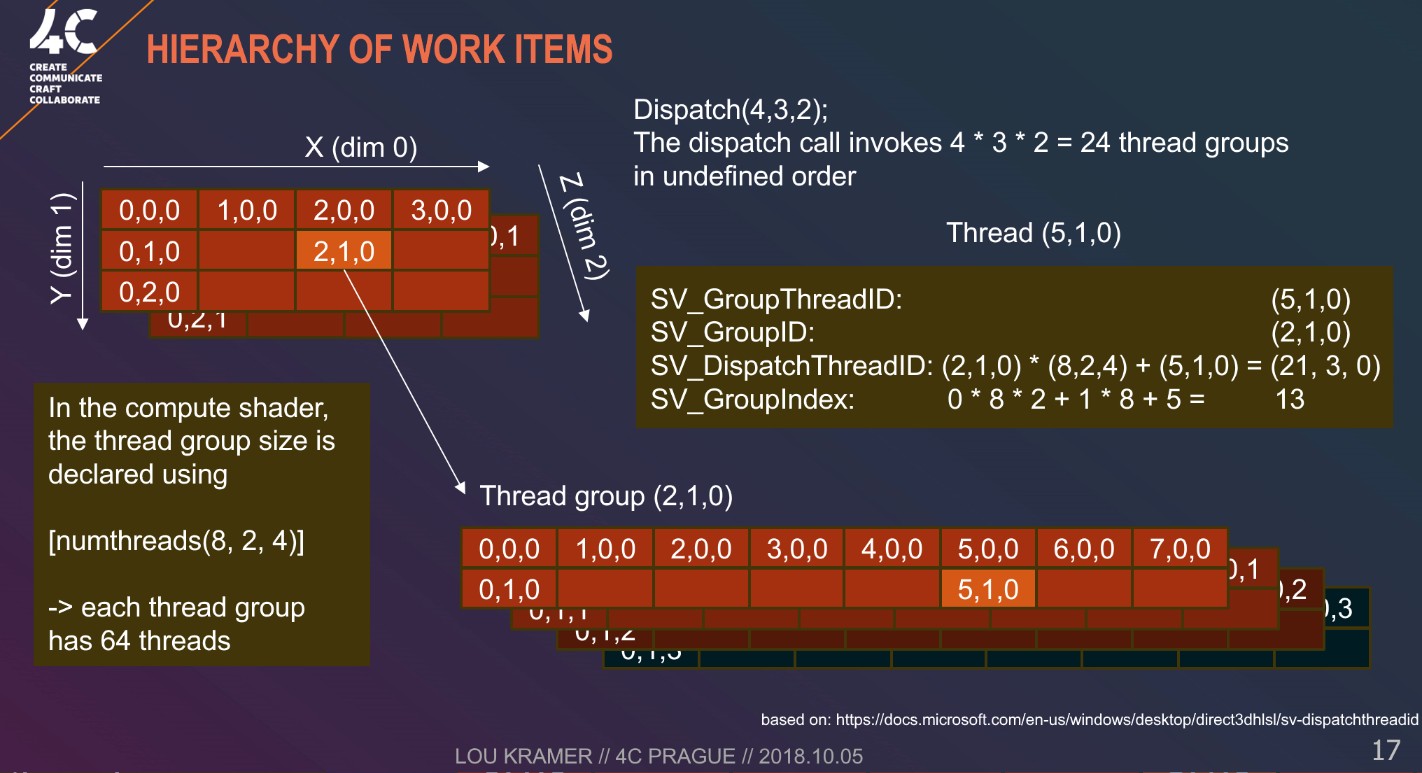

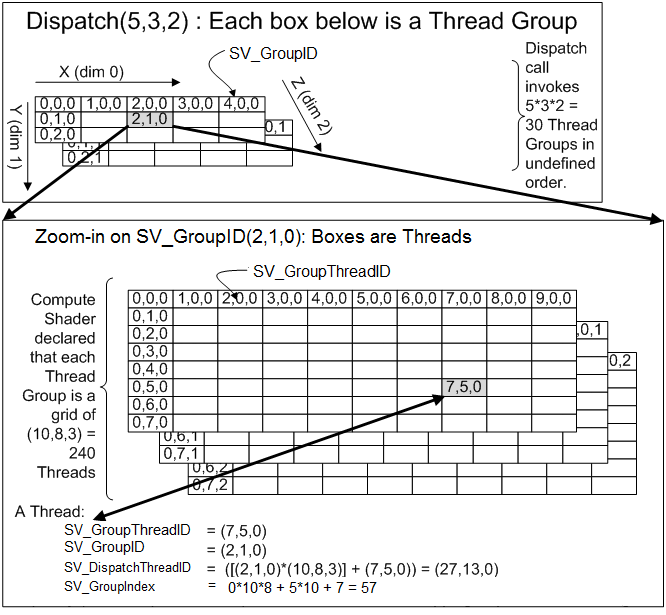

GPU 执行 compute shader 时,会将其工作划分为多个组,然后对这些组进行调度,使得这些组独立地并行运行。每个组又由多个 threads 组成,这些 threads 执行相同的计算,但是输入数据不同。我们需要在 computer shader 中使用 numthreads 属性来指定每个组包含多少个 threads,其需要 3 个整数参数。最简单的方式是将三个参数都指定为 1,表示每个组都只包含 1 个 thread。如下:

[numthreads(1,1,1)] void FunctionKernel() {}

GPU 硬件包含的计算单元始终以 lockstep 方式运行特定固定数量的 thread。这些被称为 wraps 或 wavefronts。 如果一个组的 threads 数量小于 wrap 包含的 threads 大小,一些 threads 将空闲运行,浪费时间。如果一个组的线程的数量反而超过了 wrap 包含的 threads 大小,那么 GPU 将为每组分配更多的 wraps。 一般来说,64 个线程是一个很好的默认值,因为它与 AMD GPU 的 wrap 大小相匹配,而 NVidia GPU wrap 的大小为 32 个,因此后者将会为每个组分配两个 wraps。实际上,硬件更复杂,可以用线程组做更多的事情,在本节中,我们实现的 Graph 不会用到。

numthreads 的三个参数可用于在一、二或三个维度上组织线程。 例如,(64, 1, 1) 在一个维度上给了我们 64 个线程,而 (8, 8, 1) 给了我们相同的数量,但呈现为 2D 8×8 方形网格。实现 GPUGraph 时,我们基于 2D UV 坐标定义我们的点,所以我们使用 [numthreads(8,8,1)],Z 维度为 1。如下:

[numthreads(8,8,1)] void FunctionKernel(uint3 id:SV_DispatchThreadID) // 每个thread通过一个3维整型向量唯一表示 { }

我们使用 computeShader.Dispatch 函数来发布 GPU compute shader 计算请求。

int groups = Mathf.CeilToInt(resolution / 8f); // kernelIdx // threadGroupsX // threadGroupsY // threadGroupsZ computeShader.Dispatch(0, groups, groups, 1);

Tips:

- 上图展示的不是 unity 中的 Dispatch, 而是 d3d 中的 ID3D11DeviceContext::Dispatch 函数

void Dispatch([in] UINT ThreadGroupCountX, [in] UINT ThreadGroupCountY, [in] UINT ThreadGroupCountZ);

- SV_GroupIndex

// dim.x dim.y 为 numthreads 中指定的x,y的维度 SV_GroupIndex = SV_GroupThreadID.z * dimx * dimy + SV_GroupThreadID.y * dimx + SV_GroupThreadID.x

- unity Dispatch 函数的接口如下

public void Dispatch(int kernelIndex, int threadGroupsX, int threadGroupsY, int threadGroupsZ);

Print Compute Buffer

Tips:

使用 CommandBuffer 提交渲染命令时,命令是延迟执行的,所以需要使用 CommandBuffer 获取 ComputeBuffer 中的数据,否则获取到的数据是执行命令前的数据。

void PrintComputerBuffer<T>(CommandBuffer cmd, ComputeBuffer buffer, string prefixInfo) where T : struct { void DoPrint<T>(T[] tData) { string info = ""; for (int i = 0; i < tData.Length; i++) { info += string.Format(" {0} ", tData[i]); } Debug.LogWarningFormat("{0} : {1} - {2}", prefixInfo, buffer.count, info); }; if (cmd!=null) { cmd.RequestAsyncReadback(buffer, request => { if (request.hasError) { Debug.LogWarningFormat("{0} : {1}", prefixInfo, "read buffer error"); } else { var tData = request.GetData<T>(); DoPrint(tData.ToArray()); } }); } else { T[] tData = new T[buffer.count * buffer.stride / Marshal.SizeOf(typeof(T))]; buffer.GetData(tData); DoPrint(tData); } }

Jobs

一般来说,分形(Fractal)是具有自相似性的东西,简单来说,这意味着它的较小部分看起来与较大部分相似。 例如海岸线和大量植物。 例如,一棵树的树枝可能看起来像树干,只是更小。数学和几何上也有分形。 例如:Mandelbrot 和 Julia 集、Koch 雪花、Menger 海绵和 Sierpiński 三角形。

可以通过从初始形状开始构建几何分形,然后将其较小的副本附加到自身,然后生成较小的自身版本,依此类推。这在理论上可以永远持续下去,创造出无限数量的形状,但仍占据有限的空间。 我们可以在 Unity 中创建类似的东西,但在性能下降太多之前只能达到几个层次。

Burst

// Job adding two floating point values together [BurstCompile(FloatPrecision.Standard, FloatMode.Fast, CompileSynchronously=true)] public struct MyJob : IJob { public float a; public float b; public NativeArray<float> result; public void Execute() { result[0] = a + b; } }

- BurstCompile 显式指定 unity 使用 Burst 来编译我们的 MyJob job 结构体。当 job 第一次被执行时,其会被 Burst 在后台进行编译,此时会使用常规的 C#编译版本。当 Burst 编译完成后,才会切换到 Burst 编译版本。

- CompileSynchronously=true 表示强制 editor 立即编译 job 的 Burst 版本,unity 会卡住,直到编译完成。

- FloatMode.Fast FastMode 允许 Burst 对数学操作重新排序,例如 a+b*c 变为 b*c+a, 这样可以使用一条 madd 指令执行计算。通常对操作顺序进行重拍不会导致逻辑错误,但是由于浮点数限制,重拍可能导致结果有稍微变化。如果这些小的差异无关紧要,就可以开启 FastMode。

- FloatPrecision.Standard 浮点数精度会控制 sin, cos 这些函数的精度。虽然,本节中没有直接使用这些函数。但是创建 quaternions 会间接使用。

Mesh Basics & Procedural Meshes

Mesh Basics

Procedural Meshes

Rendering & Advanced Rendering & CustomSRP

Rendering

Shader Fundamentals

基础知识

- MatrixType

可以参考 unitycatlikecoding\Rendering\Assets\MyTest\03TestShaderMatrix 工程中的展示效果。

Properties { _MainTex ("Texture", 2D) = "white" {} [Enum(NotDefineM,0,DefineM,1,DefineMWithVect,2)] DefineMatrix("DefineMatrix", Float) = 0 } v2f vert (appdata v) { v2f o; float4 translatedVertex = v.vertex + 0.5; if (DefineMatrix != 0) { float4x4 translateM = float4x4( 1, 0, 0, 0, 0, 1, 0, 0, 0, 0, 1, 0, 0, 0, 0, 1 ); if (DefineMatrix == 1) { // unity shader中向量为列向量 // 矩阵每一列表示变换后新坐标系的基坐标轴 // xAxis = (2,1,0) // yAxis = (0,1,0) // zAxis = (0,0,2) // 直接初始化矩阵 translateM = float4x4( 2, 0, 0, 0, 1, 1, 0, 0, 0, 0, 2, 0, 0, 0, 0, 1 ); } else if (DefineMatrix == 2) { // 使用向量初始化矩阵 float4 row0 = float4(2, 0, 0, 0); float4 row1 = float4(1, 1, 0, 0); float4 row2 = float4(0, 0, 2, 0); float4 row3 = float4(0, 0, 0, 1); translateM = float4x4(row0,row1,row2,row3); } translatedVertex = mul(translateM, translatedVertex); } o.wNormal = mul(v.normal, (float3x3)unity_WorldToObject); o.vertex = UnityObjectToClipPos(translatedVertex); o.uv = TRANSFORM_TEX(v.uv, _MainTex); return o; } fixed4 frag (v2f i) : SV_Target { fixed4 col = 1; float3x3 colM = float3x3( 1, 1, 0, 0, 1, 0, 0, 0, 1 ); // colM[0]取出的数据是矩阵第0行的数据 // colM[2]取出的数据是矩阵第2行的数据 col.rgb = colM[0]; float3 lightDir = _WorldSpaceLightPos0.xyz; return col*dot(lightDir, i.wNormal); //return col; }

- Array

// 在shader中使用数组常量 static const float gaussianFilter3x3[9] = { 0.02487913, 0.10797294, 0.02487913, 0.10797294, 0.46859173, 0.10797294, 0.02487913, 0.10797294, 0.02487913, }; static const float gaussianFilter5x5[25] = { 0.00120229, 0.00828598, 0.01569749, 0.00828598, 0.00120229, 0.00828598, 0.05710569, 0.10818462, 0.05710569, 0.00828598, 0.01569749, 0.10818462, 0.20495178, 0.10818462, 0.01569749, 0.00828598, 0.05710569, 0.10818462, 0.05710569, 0.00828598, 0.00120229, 0.00828598, 0.01569749, 0.00828598, 0.00120229, };

- SV 含义

SV_POSITION、SV_TARGET 中 SV 表示 System Value

SV_TARGET 表示 fragment shader 写入最终颜色值的默认目标对象,其实就是帧缓冲区对象

- ST 含义

贴图附加的 Tiling 和 Offset 属性。ST 表示 Scale 和 Translation.

- 贴图坐标系

OpenGL 坐标原点在左下角

D3D 坐标原点在左上角

- MipMap 和 FilterMode

MipMap 用于处理贴图图元密度大于像素密度的情况,一个像素对应多个贴图图元时,如果没有 mipmap,在多个贴图图元中采用一个图元而丢弃其他。有 mipmap 时,则使用更低分辨率的贴图让 像素密度和贴图密度相接近。

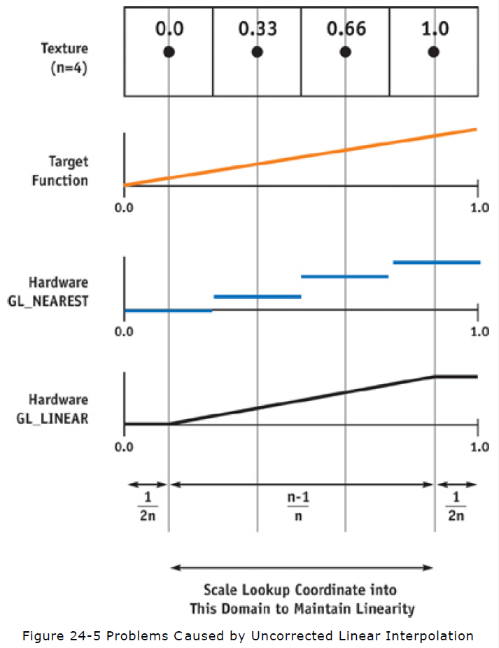

FilterMode 用于处理贴图图元密度小于像素密度的情况,采样器会对靠近采样点的图元进行采样,然后对这些图元进行插值,来得到最终颜色值。

Bilinear texture filtering 会对靠近采样点的四个图元进行加权平均。

https://docs.microsoft.com/en-us/windows/uwp/graphics-concepts/bilinear-texture-filtering

- TRANSFORM_TEX

// 该方法定义在 UnityCG.cginc #define TRANSFORM_TEX(tex,name) (tex.xy * name##_ST.xy + name##_ST.zw)

- tex2Dbias tex2Dlod

tex2Dbias(s, t) : Samples a 2D texture after biasing the mip level by t.w.

tex2Dlod(s, t) : Samples a 2D texture with mipmaps. The mipmap LOD is specified in t.w.

- tex2Dproj

在对纹理进行采样之前,tex2Dproj 将输入的 UV xy 坐标除以其 w 坐标

- SampleCmp SampleCmpLevelZero

float Object.SampleCmp( SamplerComparisonState S, float Location, // 贴图坐标 该参数类型随贴图类型变化 Texture1D=>float Texture2D=>float2 float CompareValue, // 比较的值 [int Offset] // 可选的贴图坐标偏移 该参数类型随贴图类型变化 Texture1D=>float Texture2D=>float2 ); // 返回值为[0,1]

使用 SampleCmp 对 Shadowmap 采样可以代替 shader 中执行的比较操作。详情参考下面文章:

./.UnityShaderSourceCode.html#orgf8ed859

- atan2 atan

HLSL atan2(y, x) == GLSL atan(y, x)

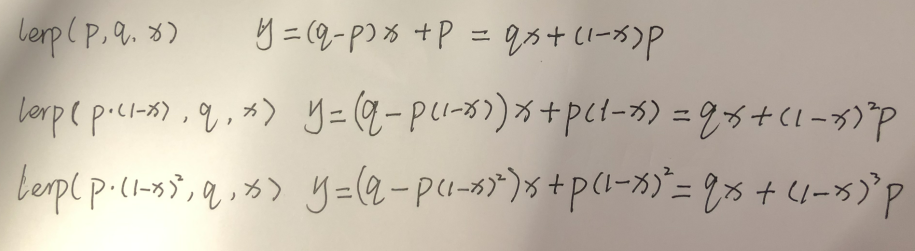

- lerp 函数意义

x = 0 时,y = p; x = 1 时,y = q;

lerp(p, q, x) lerp(p(1-x), q, x) lerp(p(1-x)^2, q, x) 三个函数,依次减弱 p 的效果。

- ddx ddy

ddx(var_i) 求出 var_i 变量在当前像素块 x 方向的变化量

ddy(var_i) 求出 var_i 变量在当前像素块 y 方向的变化量

- fwidth

fwidth(var_i) = abs(ddx(var_i)) + abs(ddy(var_i))

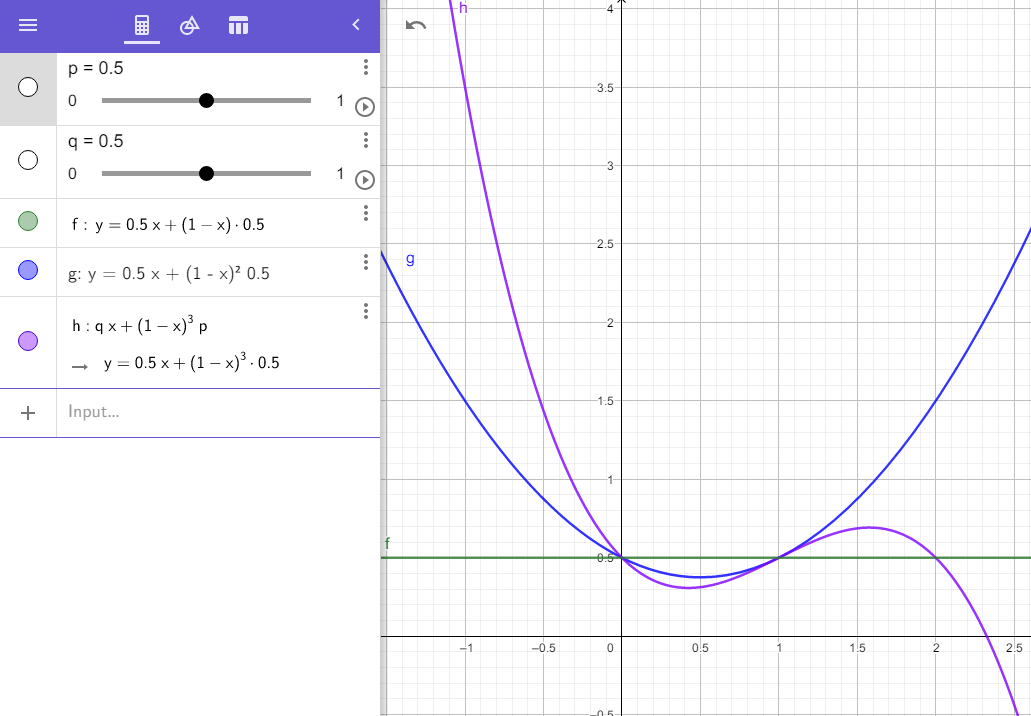

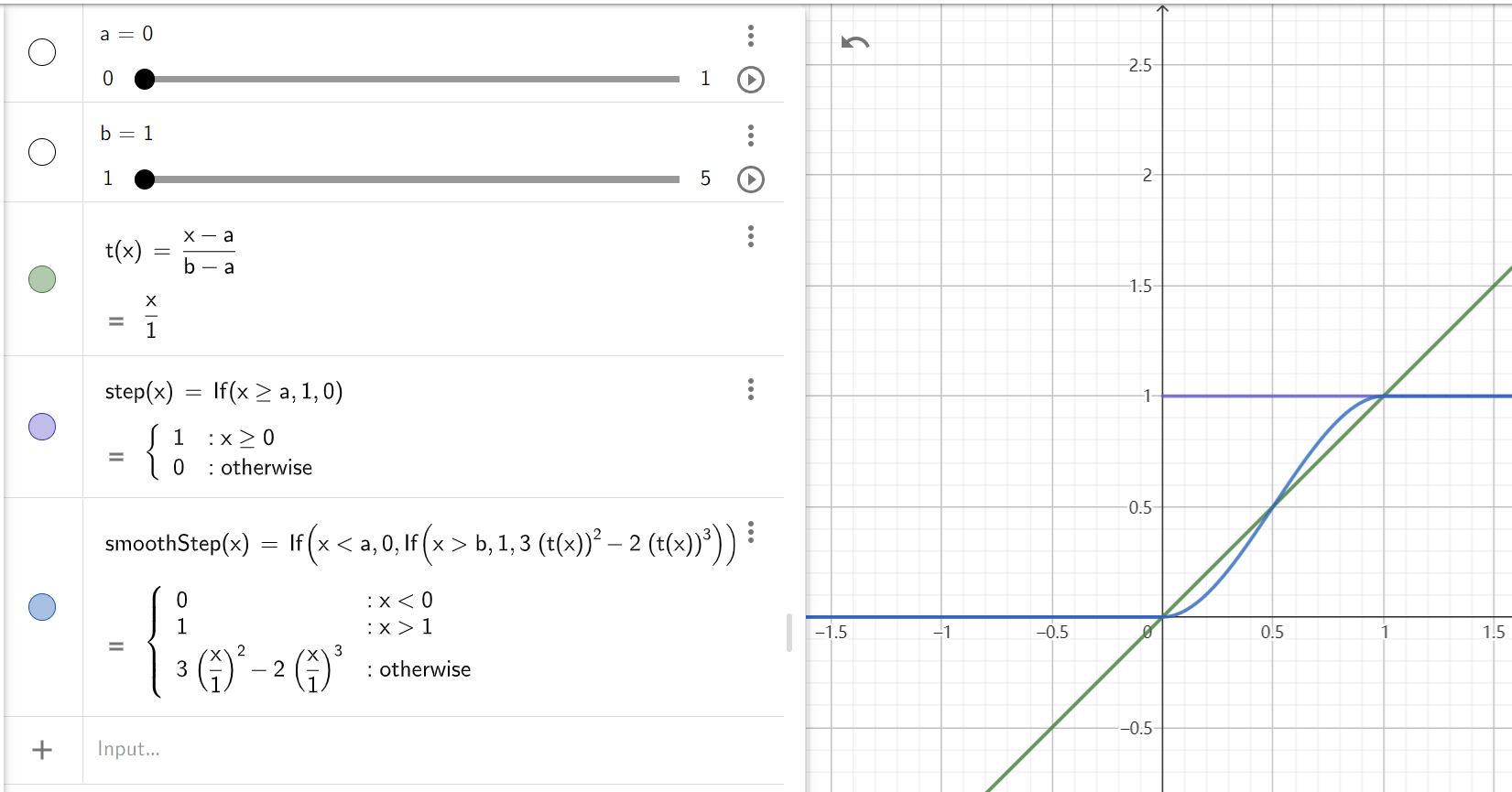

- smoothstep

smoothstep(a, b, c) 平滑的阶跃函数,c<=a 返回 0,c>=b 返回 1

t = (c-a)/(b-a)

t = saturate(t)

result = 3t^2 - 2t^3

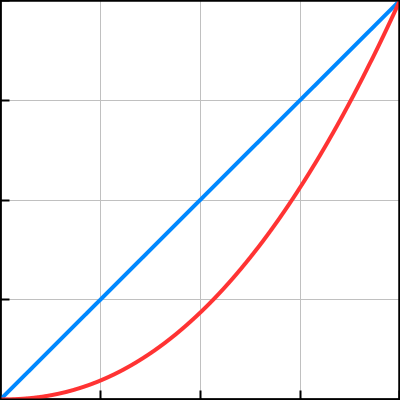

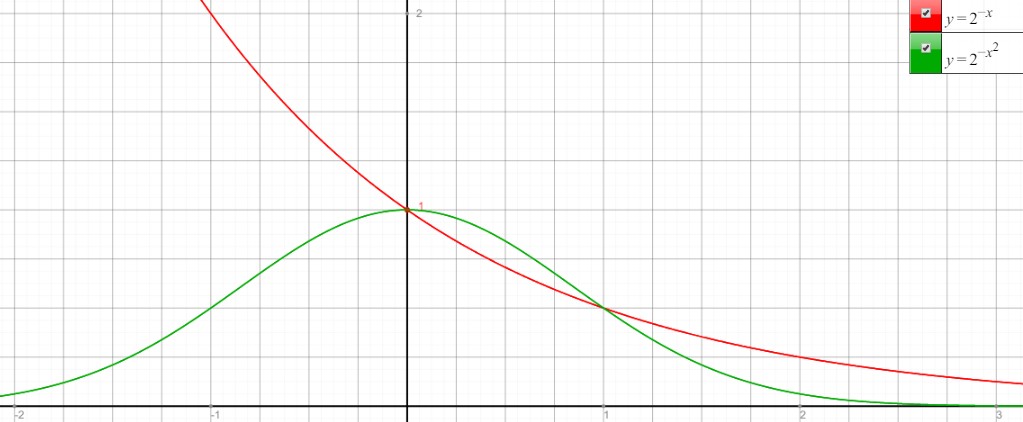

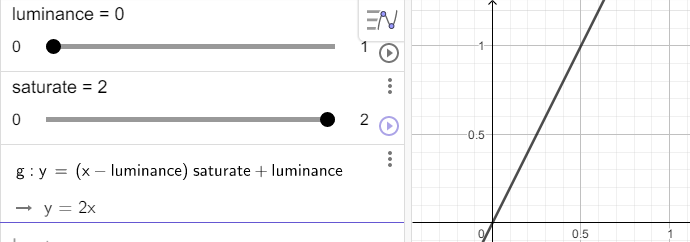

下图展示了 smoothstep 和 step 的对比:

Shader Semantics

- Screen space pixel position: VPOS

VPOS 输出的变量中保存的是屏幕像素点坐标,坐标值为整数值。

VPOS 和 SV_POSITION 不能同时出现在 vout 中,需要使用 fin 将两者分离。

Shader "Unlit/Screen Position" { Properties { _MainTex ("Texture", 2D) = "white" {} } SubShader { Pass { CGPROGRAM #pragma vertex vert #pragma fragment frag #pragma target 3.0 #include "UnityCG.cginc" struct appdata { float4 vertex : POSITION; float2 uv : TEXCOORD0; }; struct vout { float2 uv : TEXCOORD0; float4 outpos : SV_POSITION; }; struct fin { float2 uv : TEXCOORD0; UNITY_VPOS_TYPE screenPos : VPOS; }; #define vert_out vout #define frag_in fin vert_out vert(appdata i) { vert_out o; o.uv = i.uv; o.outpos = UnityObjectToClipPos(i.vertex); return o; } sampler2D _MainTex; fixed4 frag (frag_in i) : SV_Target { // screenPos.xy will contain pixel integer coordinates. // return i.screenPos.x < _ScreenParams.x/2 ? 0 : 1; // use them to implement a checkerboard pattern that skips rendering // 4x4 blocks of pixels // checker value will be negative for 4x4 blocks of pixels // in a checkerboard pattern i.screenPos.xy = floor(i.screenPos.xy * 0.25) * 0.5; float checker = -frac(i.screenPos.r + i.screenPos.g); // clip HLSL instruction stops rendering a pixel if value is negative clip(checker); // for pixels that were kept, read the texture and output it fixed4 c = tex2D (_MainTex, i.uv); return c; } ENDCG } } }

- Face orientation: VFACE

Shader "Unlit/Face Orientation" { Properties { _ColorFront ("Front Color", Color) = (1,0.7,0.7,1) _ColorBack ("Back Color", Color) = (0.7,1,0.7,1) } SubShader { Pass { Cull Off // turn off backface culling CGPROGRAM #pragma vertex vert #pragma fragment frag #pragma target 3.0 float4 vert (float4 vertex : POSITION) : SV_POSITION { return UnityObjectToClipPos(vertex); } fixed4 _ColorFront; fixed4 _ColorBack; fixed4 frag (fixed facing : VFACE) : SV_Target { // VFACE input positive for frontbaces, // negative for backfaces. Output one // of the two colors depending on that. return facing > 0 ? _ColorFront : _ColorBack; } ENDCG } } } // or struct v2f { // ....... #if defined(SHADER_STAGE_FRAGMENT) fixed vFace : VFACE; #endif } fixed4 frag(v2f i) { // ...... fixed vFace = 1; #if defined(SHADER_STAGE_FRAGMENT) vFace = i.vFace > 0 ? 1 : -1; #endif return vFace*2-1; }

- error Shader error in 'Custom/MyEffect/GNoiseBall': Non system-generated input signature parameter () cannot appear after a system generated value. at line 98 (on d3d11)

struct v2f { UNITY_VERTEX_INPUT_INSTANCE_ID float4 vertex : SV_POSITION; float3 wPos : TEXCOORD0; fixed3 wNormal : TEXCOORD1; #if defined(SHADER_STAGE_FRAGMENT) fixed vFace : VFACE; #endif }; // 将上面结构体声明改为下面方式,就可以避免该错误 struct v2f { float4 vertex : SV_POSITION; float3 wPos : TEXCOORD0; fixed3 wNormal : TEXCOORD1; UNITY_VERTEX_INPUT_INSTANCE_ID // 开启GPU Instance后,UNITY_VERTEX_INPUT_INSTANCE_ID需要放置在VFACE前面 #if defined(SHADER_STAGE_FRAGMENT) fixed vFace : VFACE; #endif };

- error Shader error in 'Custom/MyEffect/GNoiseBall': Non system-generated input signature parameter () cannot appear after a system generated value. at line 98 (on d3d11)

- 参考资料

Shader Commands

Unity 定义的变量

_WorldSpaceLightPos0 世界空间 Light 位置

_LightColor0 Light 颜色

_WorldSpaceCameraPos 世界坐标摄像机位置

_LightTexture0 Light 没有使用 Cookie 时,该变量存储衰减贴图。使用了 Cookie 时,存储 Cookie 贴图。 (Directional Light 没有衰减贴图)

_LightTextureB0 Light 使用了 Cookie 时,该变量存储衰减贴图。 (Directional Light 没有衰减贴图)

unity_WorldToShadow float4x4[4] 用于 spot lights 或 方向光的 4 级级联阴影

_LightShadowData // 参考有道笔记 UnitySourceCode.md

_ProjectionParams / x=1 or -1(-1 if projection is flipped) y=near z=far w=1/far

_ScreenParams / x=widthPixels y=heightPixels z=1.0+1.0/width w=1.0+1.0/height

_ZBufferParams / 用于线性化 ZBuffer 中的值,

/ x=1-far/near

/ y=far/near

/ z=x/far=(1-far/near)/far=(near-far)/(near*far)

/ w=y/far=(1/near)

_XXX_TexelSize / Vector4(1 / tex_width, 1 / tex_height, tex_width, tex_height)

double zc0, zc1; // OpenGL would be this: // zc0 = (1.0 - m_FarClip / m_NearClip) / 2.0; // zc1 = (1.0 + m_FarClip / m_NearClip) / 2.0; // D3D is this: zc0 = 1.0 - m_FarClip / m_NearClip; zc1 = m_FarClip / m_NearClip; // now set _ZBufferParams with (zc0, zc1, zc0/m_FarClip, zc1/m_FarClip);

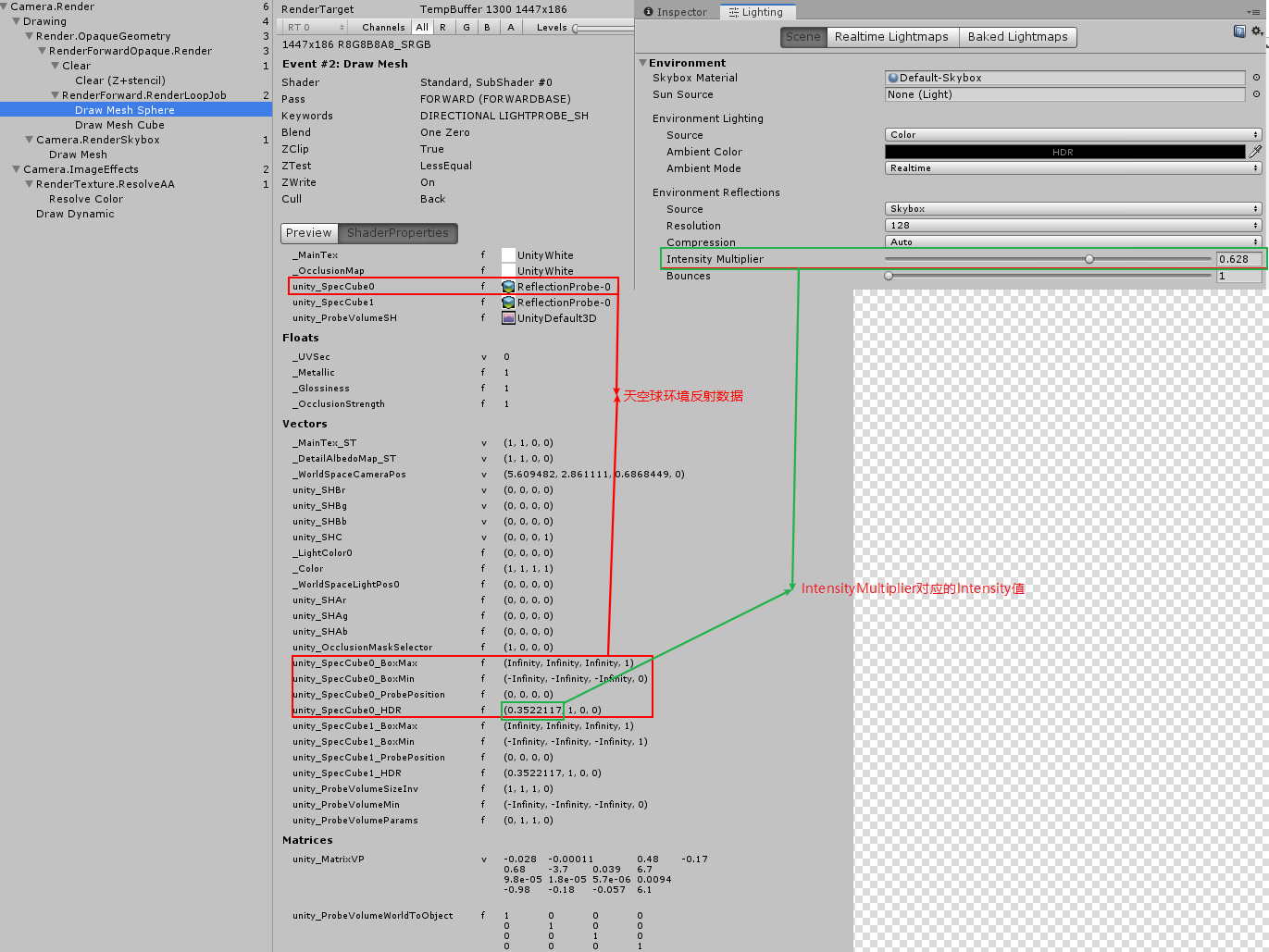

unity_SpecCube0_ProbePosition 第一个反射探针的位置,如果场景中不存在反射探针,则默认传递环境反射(Lighting / Environment Reflections / Source 下可以设置环境反射)的数据,环境反射。

unity_SpecCube0_BoxMin 第一个反射探针对应的 Box 在世界空间中坐标最小值,反射探针为环境反射时,该值为 (Infinity, Infinity, Infinity, 1)

unity_SpecCube0_BoxMax 第一个反射探针对应的 Box 在世界空间中坐标最大值,反射探针为环境反射时,该值为 (-Infinity, -Infinity, -Infinity, 1)

unity_SpecCube0_BoxMin.w 存储了第一个反射探针和第二个反射探针的插值比例,1 表示全部使用第一个反射探针,0 表示全部使用第二个反射探针.(只有将 Renderer 的 reflectionProbeUsage 属性设置为 BlendProbesAndSkybox 时,反射探针才会和 Skybox 进行混合)

unity_SpecCube0_HDR.r 存储了反射探针的强度,对应反射探针的 Runtime setting/Intensity 和 Lighting/Scene/EnvironmentReflections/IntensityMultiplier(IntensityMultiplier 只是 Intensity 的系数,所以 FrameDebug 中看到的值和该值并不同)

https://docs.unity3d.com/Manual/SL-UnityShaderVariables.html

- _ZBufferParams values? https://forum.unity.com/threads/_zbufferparams-values.39332/

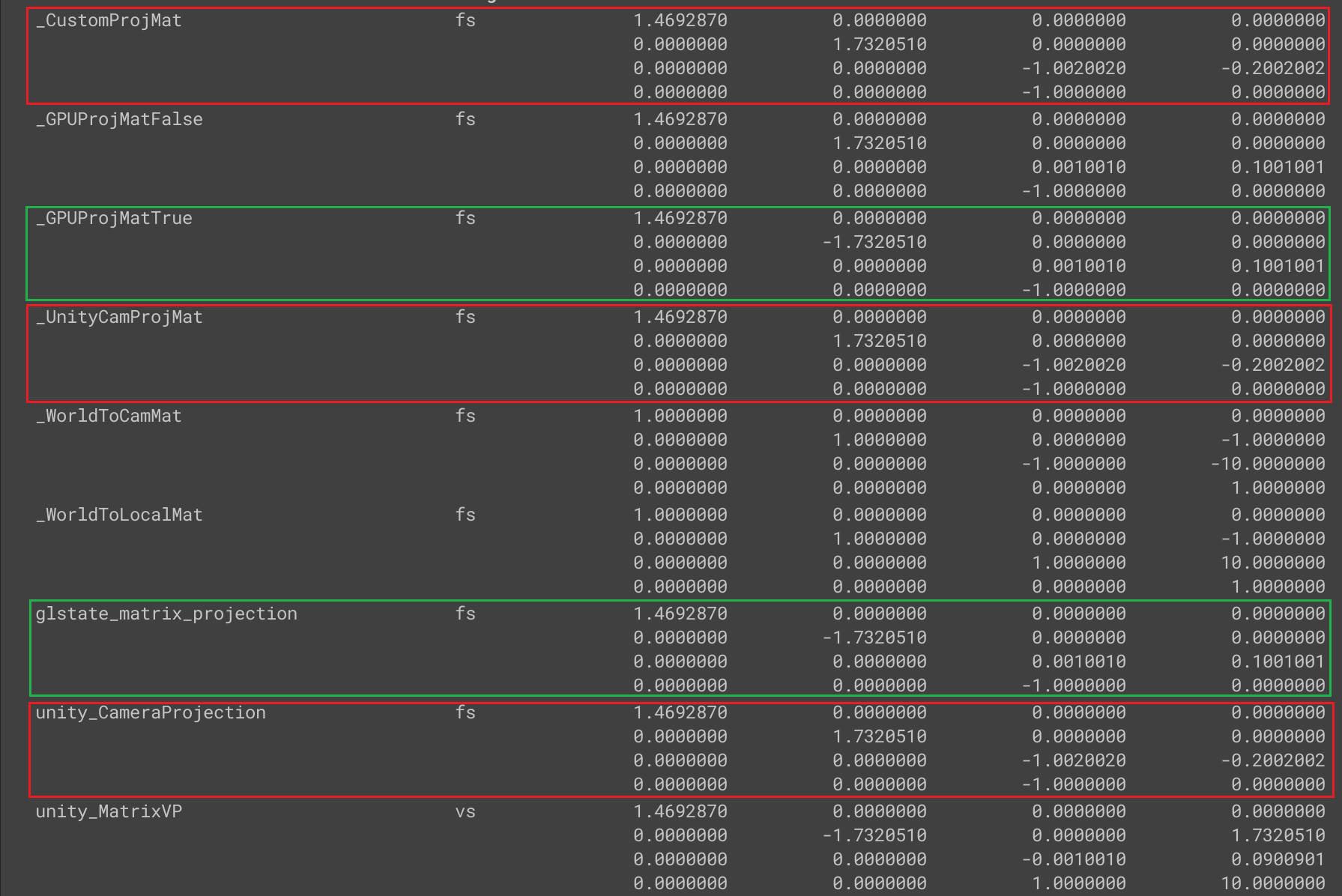

- Unity shader matrix

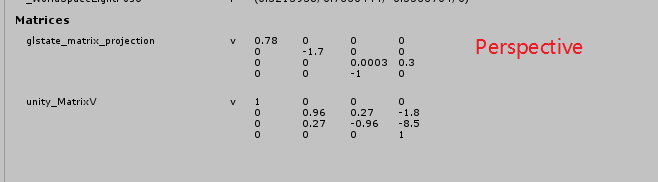

Unity camera space 和 OpenGL 习惯一致,view space 为:Z轴负方向为 forward 方向。而 Unity 物体空间和世界空间,都是以 Z 轴正方向为 forward 方向。

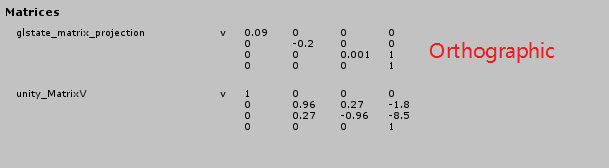

Unity 中矩阵是列主序的,但是 FrameDebug 中显示的矩阵是行主序的。

- 各种坐标系统惯例

- 透视投影矩阵

- UNITY_MATRIX_P(glstate_matrix_projection) and unity_CameraProjection

unity_CameraProjection 等价与 Camera 组件的 projectionMatrix。其采用 OpenGL 形式的投影矩阵。

UNITY_MATRIX_P 为对应于当前使用的 GraphicAPI 的渲染的投影矩阵(所谓渲染的投影矩阵,就是 shader 中使用的投影矩阵)。

使用 GL.GetGPUProjectionMatrix 函数可以将 unity_CameraProjection 转化为适用于当前 GraphicAPI 的 UNITY_MATRIX_P。GL.GetGPUProjectionMatrix 的实现请参考文档 Unity Source Code.md 的 Unity Perspective Matrix 部分。

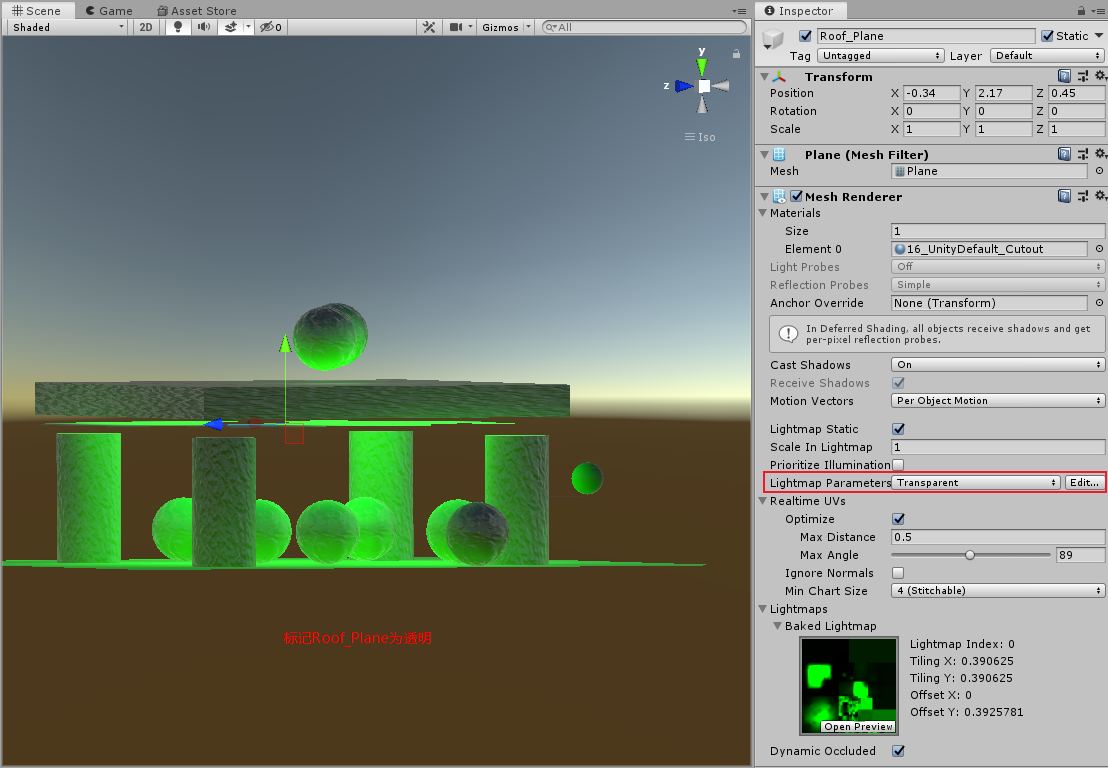

下图来自 UnityCatLikeCoding/MyTest/03TestShaderMatrix 工程中的展示效果:

private void Update() { if (mat != null) { var cam = Camera.main; if (cam != null) { mat.SetMatrix("_WorldToLocalMat", cam.transform.worldToLocalMatrix); mat.SetMatrix("_WorldToCamMat", cam.worldToCameraMatrix); var customProjMat = new Matrix4x4(); CalcGLProjMat(ref customProjMat, cam); mat.SetMatrix("_CustomProjMat", customProjMat); mat.SetMatrix("_GPUProjMatTrue", GL.GetGPUProjectionMatrix(customProjMat, true)); mat.SetMatrix("_GPUProjMatFalse", GL.GetGPUProjectionMatrix(customProjMat, false)); mat.SetMatrix("_UnityCamProjMat", cam.projectionMatrix); } } } // void CalcMyProjMat(ref Matrix4x4 mat, Camera cam) { if (cam == null) return; float n = cam.nearClipPlane; float f = cam.farClipPlane; // Fov Axis is Vertical float fovV = Mathf.Deg2Rad * cam.fieldOfView; float zoomy = 1f / Mathf.Tan(fovV / 2f); // cam.aspect = width / height float zoomx = zoomy / cam.aspect; mat.m00 = zoomx; mat.m11 = zoomy; mat.m22 = (f + n) / (f - n); mat.m23 = 1f; mat.m32 = 2 * f * n / (n - f); /* zoomx 0 0 0 0 zoomy 0 0 0 0 (f+n)/(f-n) 1 0 0 2nf/(n-f) 0 **/ } void MyProjMat2GLProjMat(ref Matrix4x4 mat) { var flipZMat = Matrix4x4.identity; flipZMat.m22 = -1; mat = flipZMat * mat; mat = mat.transpose; } void CalcGLProjMat(ref Matrix4x4 mat, Camera cam) { CalcMyProjMat(ref mat, cam); MyProjMat2GLProjMat(ref mat); }

- What's difference between UNITY_MATRIX_P and unity_CameraProjection? https://forum.unity.com/threads/whats-difference-between-unity_matrix_p-and-unity_cameraprojection.1079549/

- https://docs.unity3d.com/ScriptReference/Camera-projectionMatrix.html

- What's difference between UNITY_MATRIX_P and unity_CameraProjection? https://forum.unity.com/threads/whats-difference-between-unity_matrix_p-and-unity_cameraprojection.1079549/

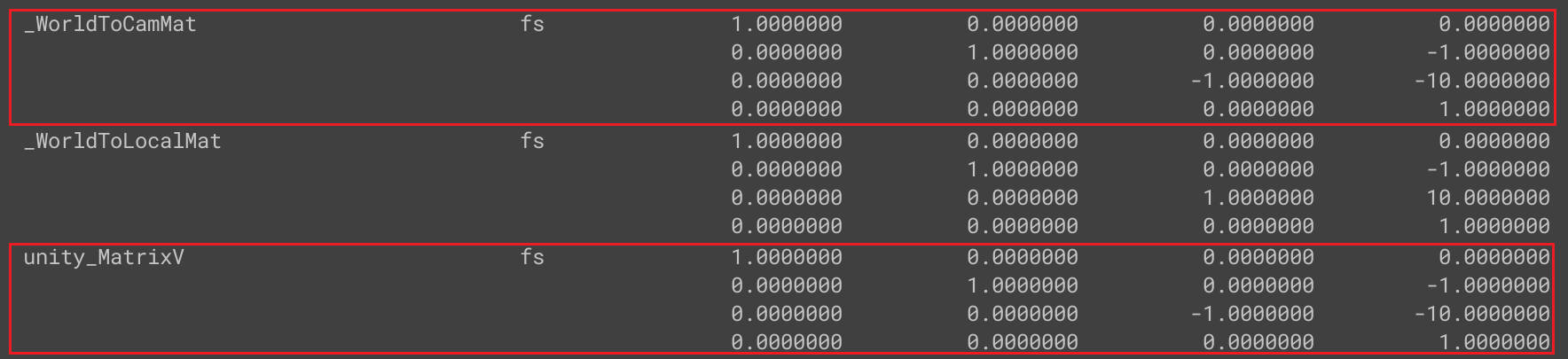

- UNITY_MATRIX_V

unity 的 view matrix 采用 OpenGL 方式,不同 GraphicAPI 不会影响 view matrix。

下图来自 UnityCatLikeCoding/MyTest/03TestShaderMatrix 工程中的展示效果:

- 参考资料

- 各种坐标系统惯例

Unity Shader 定义的宏

shader 各个阶段对应的预处理器宏

SHADER_STAGE_VERTEX

SHADER_STAGE_FRAGMENT

SHADER_STAGE_DOMAIN

SHADER_STAGE_HULL

SHADER_STAGE_GEOMETRY

SHADER_STAGE_COMPUTE

UNITY_COMPILER_HLSL 使用 HLSL 编译时,定义该宏(for D3D or GLCore/GLES3/GLES platforms)

UNITY_COMPILER_HLSL2GLSL 使用 hlsl2glsl 编译时,定义该宏

UNITY_COMPILER_CG 使用 NVIDIA 的 Cg

https://docs.unity3d.com/Manual/SL-BuiltinMacros.html

https://docs.unity3d.com/Manual/SL-ShadingLanguage.html

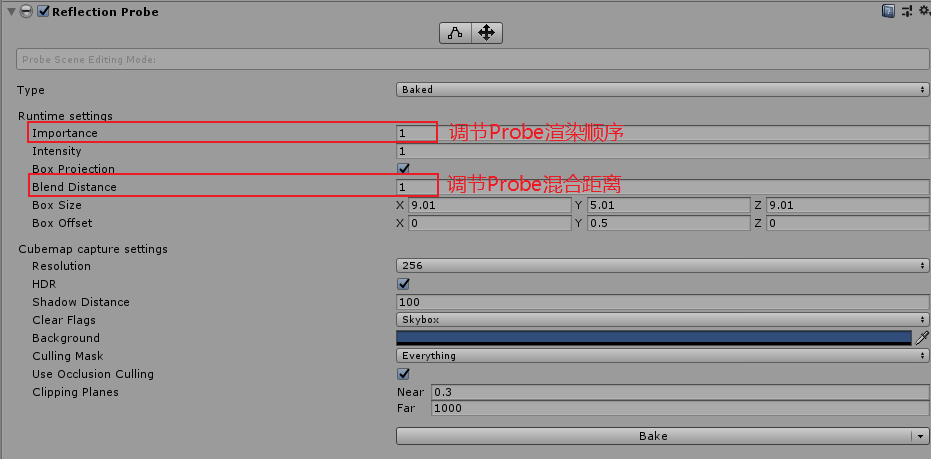

UNITY_ENABLE_REFLECTION_BUFFERS TODO-How? 延迟渲染模式下,延迟渲染反射球时会设置该变量开启。延迟渲染模式下,默认该变量是开启的,在 Graphics Settings 中将 DeferredReflections 选项选为 NoSupport 即可关闭。

https://docs.unity3d.com/ScriptReference/Rendering.BuiltinShaderDefine.html

UNITY_USE_NATIVE_HDR 查看 2019 版本的源代码发现相关代码被注释掉了,UNITY_USE_NATIVE_HDR 应该永远都不会被开启

Unity Shader Compiler

- Windows & Microsoft platforms (DX11, DX12 and Xbox One) all use Microsoft’s HLSL compiler (currently d3dcompiler_47).

- OpenGL Core , OpenGL ES 3, OpenGL ES 2.0 and Metal use Microsoft’s HLSL followed by bytecode translation into GLSL or Metal, using HLSLcc.

- OpenGL ES 2.0 can use source level translation via hlsl2glslfork and glsl optimizer. This is enabled by adding #pragma prefer_hlsl2glsl gles

- Other console platforms use their respective compilers (e.g. PSSL on PS4).

- Surface Shaders use Cg 2.2 and MojoShader for code generation analysis step.

Unity shader 预编译命令

multi_compile_local // 为本地变体,只发生在本Shader,非全局控制

Shader 汇编指令

- D3D11 汇编指令

命令 说明 示例 mul result opt1 opt2 opt1 乘 opt2 保存到 result add result opt1 opt2 opt1 加 opt2 保存到 result mad result opt1 opt2 opt3 opt1 乘 opt2 再加 opt3 保存结果到 result mov result opt1 将 opt1 数据保存到 result dcl_sampler s0, mode_default 创建贴图采样对象 s0 dcl_resource_texture2d(float,float,float,float) t0 创建 2D 贴图资源 t0 sample result.xyzw, uv.xyxx, t0.xyzw, s0 使用 s0 采样器以 uv 为贴图坐标,对贴图资源 t0 进行采样将结果保存到 result 中 - Misc

rcp 求倒数

pack and unpack data

urp 下面文件中,包含了很多 pack 和 unpack 方法。

com.unity.render-pipelines.core/ShaderLibrary/Packing.hlsl

- pack unpack int

// Packs an integer stored using at most 'numBits' into a [0..1] real. real PackInt(uint i, uint numBits) { uint maxInt = (1u << numBits) - 1u; return saturate(i * rcp(maxInt)); } // Unpacks a [0..1] real into an integer of size 'numBits'. uint UnpackInt(real f, uint numBits) { uint maxInt = (1u << numBits) - 1u; return (uint)(f * maxInt + 0.5); // Round instead of truncating }

GPU 性能

- GPU GFLOPS https://gflops.surge.sh/

Combining Textures

Linear Color Space

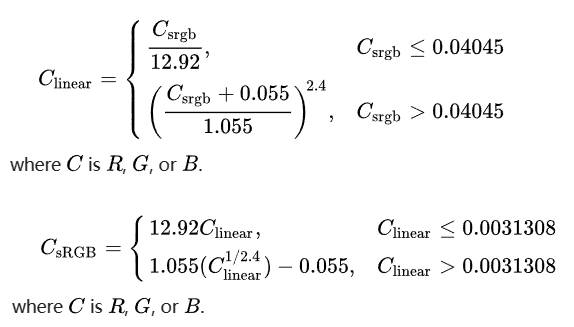

- Linear Color Space 原理

sRGB 颜色空间的 EOTF( gamma 电信号到线性光信号的转换函数)通常被近似为 e2.2

sRGB 颜色空间的 OETF(线性光信号到 gamma 电信号的转换函数)通常被近似为 l1

准确的 EOTF 和 OETF 如下:

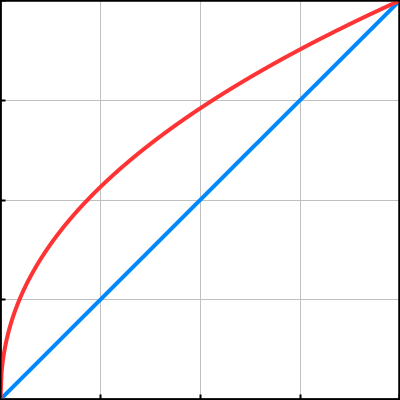

Gamma space 是指经过 gamma 矫正的颜色。gamma 矫正是对光照亮度的调整。最简单的方式是提升原始值某次幂,如 \(originalValue^{gamma}\) 。

gamma=1 表示没有改变。gamma=2 表示对原始值求平方。

这种转换原本是为了适应非线性的 CRT 显示器的。一个附加的好处是这种转换刚好和我们眼睛对不同光强度的敏感程度相一致。人眼对不同的暗的颜色要比不同的亮的颜色更加敏感。所以使用更多位数字存储暗颜色是很有意义的,求幂运算可以实现该需求,它会将比较小的值扩展到一个更大的范围,同时将较大的值压缩到一个小的范围。

运用最广泛的图片颜色格式是 sRGB.

- Encoding with gamma 1/2.2 即 \(originalValue^{\frac{1}{2.2}} = originalValue^{0.45}\)

- Decoding with gamma 2.2 即 \(originalValue^{2.2}\)

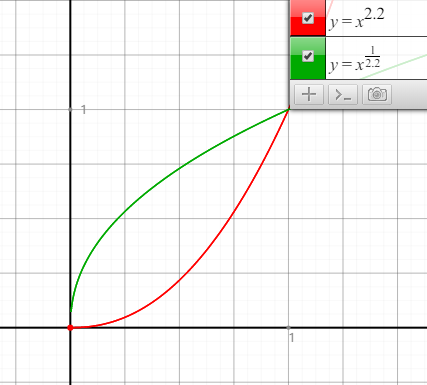

- 伽马矫正函数图示

横坐标为编码前的颜色值,纵坐标为编码后的颜色值。蓝色的线表示线性编码前后颜色值不变。红色的线表示 Gamma 编码前后颜色值变大。以 0.5 为分界线,1/2.2 Gamma 编码后,[0-0.5] 被扩展到了 [0-0.7297…] [0.5-1] 被压缩到了 [0.7297… - 1]。1/2.2 Gamma 编码的图片要比 Linear 编码的图片亮度高。

下面的 HTML 可用于 GammaToLinear 转换

<!DOCTYPE html> <html> <body> <h2>颜色转换</h2> <form action="" id="originColor"> TD 颜色 R: <input type="text" id="oR" value ="128" size="4"> G: <input type="text" id="oG" value ="128" size="4"> B: <input type="text" id="oB" value ="64" size="4"> </form> <br> <form action="" id="newColor"> Qin 颜色 R: <input type="text" id="nR" value ="" size="4" disabled> G: <input type="text" id="nG" value ="" size="4" disabled> B: <input type="text" id="nB" value ="" size="4" disabled> </form> <br> <button type="button" onclick='convertColor()'>转换</button> </body> <script type="text/javascript"> function convertColor() { var r = document.getElementById("oR").value / 255; var g = document.getElementById("oG").value / 255; var b = document.getElementById("oB").value / 255; //window.alert("test = " + r + b + g); document.getElementById("nR").value = Math.round(Math.pow(r, 1/2.2) * 255); document.getElementById("nG").value = Math.round(Math.pow(g, 1/2.2) * 255); document.getElementById("nB").value = Math.round(Math.pow(b, 1/2.2) * 255); } </script> </html>

// GammaToLinearSpace(col.rgb); 下面代码是 GammaToLinearSpace 的汇编码 void main() { u_xlat0 = texture2D(_MainTex, vs_TEXCOORD0.xy); u_xlat1.xyz = u_xlat0.xyz * vec3(0.305306017, 0.305306017, 0.305306017) + vec3(0.682171106, 0.682171106, 0.682171106); u_xlat1.xyz = u_xlat0.xyz * u_xlat1.xyz + vec3(0.0125228781, 0.0125228781, 0.0125228781); u_xlat0.xyz = u_xlat0.xyz * u_xlat1.xyz; SV_Target0 = u_xlat0; return; } // LinearToGammaSpace(col.rgb); 下面代码是 LinearToGammaSpace 的汇编代码 void main() { u_xlat0 = texture2D(_MainTex, vs_TEXCOORD0.xy); u_xlat16_1.xyz = max(u_xlat0.xyz, vec3(0.0, 0.0, 0.0)); u_xlat16_2.xyz = log2(u_xlat16_1.xyz); u_xlat16_2.xyz = u_xlat16_2.xyz * vec3(0.416666657, 0.416666657, 0.416666657); u_xlat16_2.xyz = exp2(u_xlat16_2.xyz); u_xlat16_2.xyz = u_xlat16_2.xyz * vec3(1.05499995, 1.05499995, 1.05499995) + vec3(-0.0549999997, -0.0549999997, -0.0549999997); u_xlat0.xyz = max(u_xlat16_2.xyz, vec3(0.0, 0.0, 0.0)); SV_Target0 = u_xlat0; return; }

// 下面代码是 图片Gamma和Linear转换工具 using System.Collections; using System.Collections.Generic; using UnityEngine; using UnityEditor; public class LinearGammaConvert : MonoBehaviour { static List<string> _assetPathList = new List<string>(); [MenuItem("Assets/Tools/ImageLinearToGamma")] public static void LinearToGamma() { _assetPathList.Clear(); GetSelectionPathList(_assetPathList); foreach(var path in _assetPathList) { ConvertBetweenLinearGamma(path, true); } _assetPathList.Clear(); } [MenuItem("Assets/Tools/ImageGammaToLinear")] public static void GammaToLinear() { _assetPathList.Clear(); GetSelectionPathList(_assetPathList); foreach(var path in _assetPathList) { ConvertBetweenLinearGamma(path, false); } _assetPathList.Clear(); } static void GetSelectionPathList(List<string> pathList) { if(Selection.objects!=null) { foreach(var obj in Selection.objects) { var path = AssetDatabase.GetAssetPath(obj); if(!string.IsNullOrEmpty(path)) { pathList.Add(path); } } } } static void ConvertBetweenLinearGamma(string imgPath, bool isToGamma) { if (string.IsNullOrEmpty(imgPath)) return; var textureImportor = AssetImporter.GetAtPath(imgPath) as TextureImporter; if (textureImportor == null) return; textureImportor.isReadable = true; textureImportor.sRGBTexture = !isToGamma; textureImportor.textureCompression = TextureImporterCompression.Uncompressed; textureImportor.SaveAndReimport(); var texture = AssetDatabase.LoadAssetAtPath<Texture2D>(imgPath); float gammaValue = isToGamma ? 0.4545f : 2.2f; var pixels = texture.GetPixels(); for(var i=0; i<pixels.Length; i++) { pixels[i].r = Mathf.Pow(pixels[i].r, gammaValue); pixels[i].g = Mathf.Pow(pixels[i].g, gammaValue); pixels[i].b = Mathf.Pow(pixels[i].b, gammaValue); } texture.SetPixels(pixels); texture.Apply(); System.IO.File.WriteAllBytes(imgPath, texture.EncodeToTGA()); } }

- Encoding with gamma 1/2.2 即 \(originalValue^{\frac{1}{2.2}} = originalValue^{0.45}\)

- Unity Gamma and Linear workflow

- Gamma Workflow

gamma space 下 shader 中的值全部为 gamma 编码,输出到 swapchain RT 时,不需要硬件执行 gamma 编码,所以 framebuffer RT format 为 B8G8R8A8_UNORM

贴图的 sRGB 设置不会有任何作用,贴图都是 sRGB。当 color channel 值为 0.5,从 shader 中对贴图采样得到的值也是 0.5。

- Linear Workflow

linear space 下 shader 中的值全部为 linear 值,输出到 swapchain RT 时,需要硬件执行 gamma 编码,所以 swapchain framebuffer RT format 为 B8G8R8A8_SRGB

贴图的 sRGB 设置会生效。当 color channel 值为 0.5,若贴图设置为 sRGB 时,从 shader 中对贴图采样得到的值为 0.21223。若贴图未设置为 sRGB,从 shader 中对贴图采样得到的值为 0.5。

- Gamma Workflow

- DetailTex 叠加到 MainTex 上为什么需要乘二?

MainTex 颜色范围为[0-1] DetailTex 颜色范围也为[0-1], 如果将 DetailTex 制作为灰度图并且颜色值取 0.5,那么 MainTex*DetailTex*2 可以保证图片亮度不会变化。DetailTex 颜色值小于 0.5 的地方就会减低颜色亮度,大于 0.5 的地方就会提高颜色亮度。

但是,当 Unity 引擎切换到线性空间,乘二是不正确的。DetailTex 转化为线性空间时,0.5 的 DetailTex 颜色值会变为 \(0.5^{2.2}=0.2176\) ,乘二后为 0.4352, 所以颜色亮度会减低。最好的解决方案是当 Unity 引擎切换到线性空间时,应该乘 \(frac{1}{0.5^{2.2}}=frac{1}{0.2176}=4.5956\)

Unity 中 unity_ColorSpaceDouble 用来处理不同的颜色空间乘不同的值。

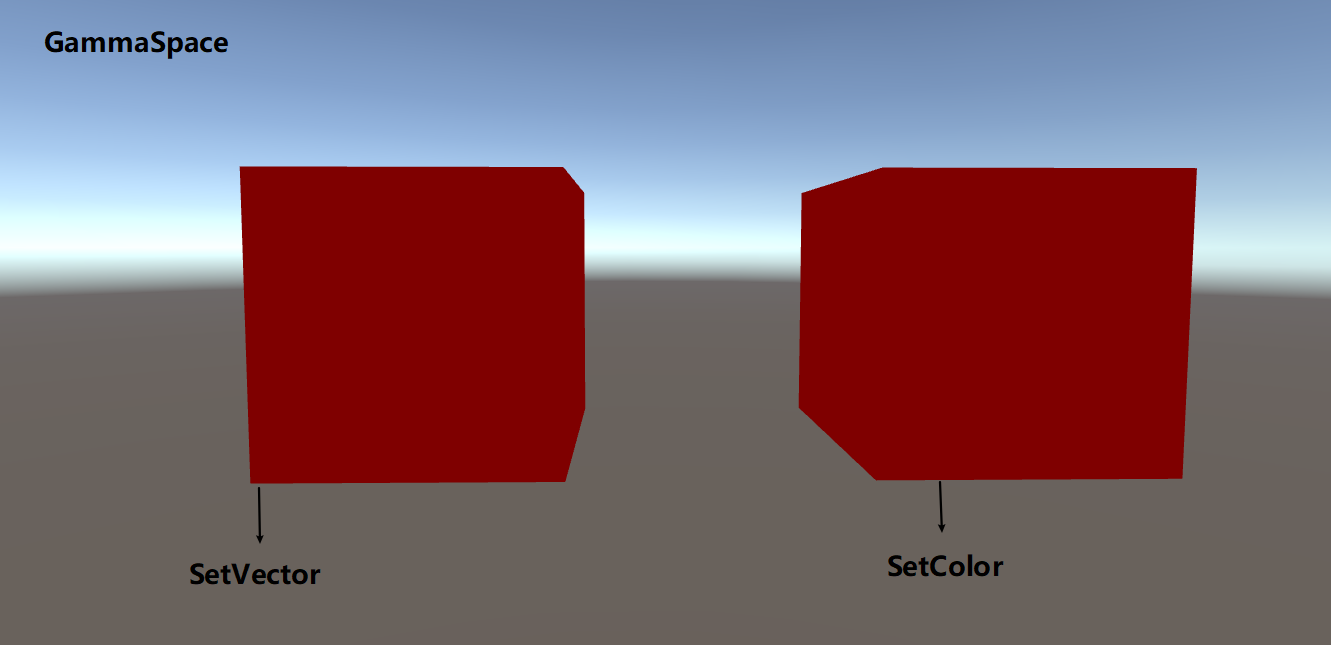

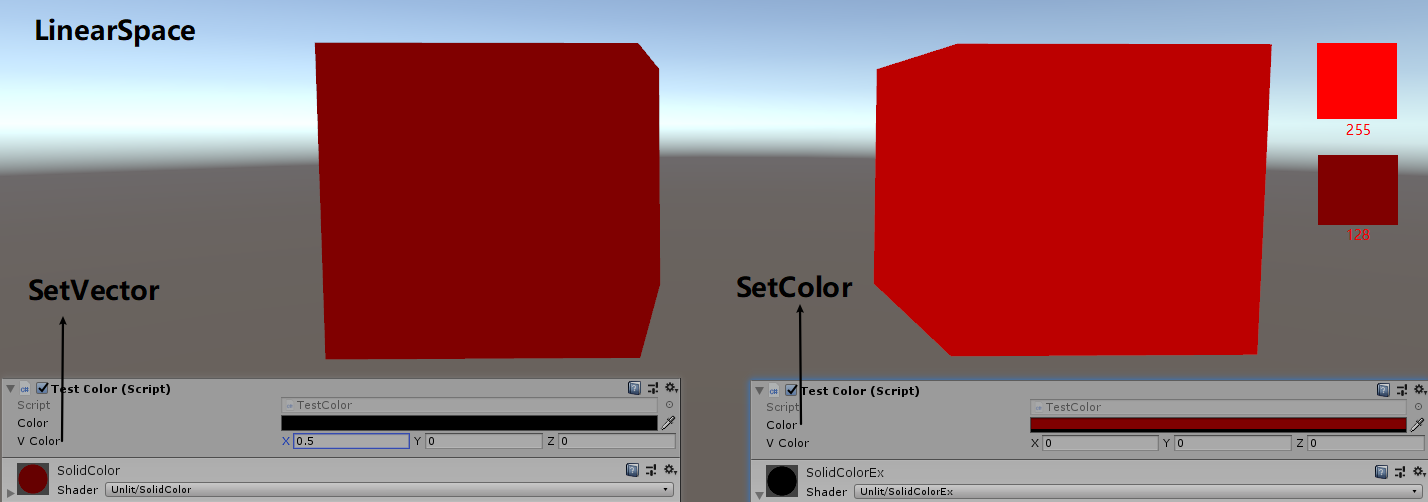

- SetVector SetColor

GammaSpace 下,SetVector SetColor 效果没有差别。下图为设置颜色值为(0.5, 0, 0)

LinearSpace 下,SetVector SetColor 效果会有明显差别。下图为设置颜色值为(0.5, 0, 0)

编辑器中设置的值和 Shader Property List 中设置的值是相同的。

线性空间下,通过 SetColor 传入的值被认为是经过 Gamma=1/2.2=0.4545 编码的值,Unity 引擎会对该值进行 Gamma=2.2 的编码(对 Gamma=1/2.2 进行解码),从而将 Gamma 空间的值转换为线性空间。所以,SetVector(0.5^2.2, 0, 0, 0) 和 SetColor(0.5, 0, 0, 0)的效果是等价的。

- 参考资料

- Linear or gamma workflow https://docs.unity3d.com/Manual/LinearRendering-LinearOrGammaWorkflow.html

- Gamma 空间是什么,为什么我们需要它 https://blog.csdn.net/qq_18229381/article/details/78053018

- Linear or gamma workflow https://docs.unity3d.com/Manual/LinearRendering-LinearOrGammaWorkflow.html

The First Light

normal 从物体空间到世界空间的变换

// obj to world i.normal = mul(transpose((float3x3)unity_WorldToObject), v.normal); inline float3 UnityObjectToWorldNormal( in float3 norm ) { #ifdef UNITY_ASSUME_UNIFORM_SCALING return UnityObjectToWorldDir(norm); #else // 改变左乘 右乘顺序 等价于 矩阵转置 // mul(IT_M, norm) => mul(norm, I_M) => {dot(norm, I_M.col0), dot(norm, I_M.col1), dot(norm, I_M.col2)} return normalize(mul(norm, (float3x3)unity_WorldToObject)); #endif }

Tags LightMode=ForwardBase

定义该 Tags 才可以在 shader 中访问场景中主方向光的信息。

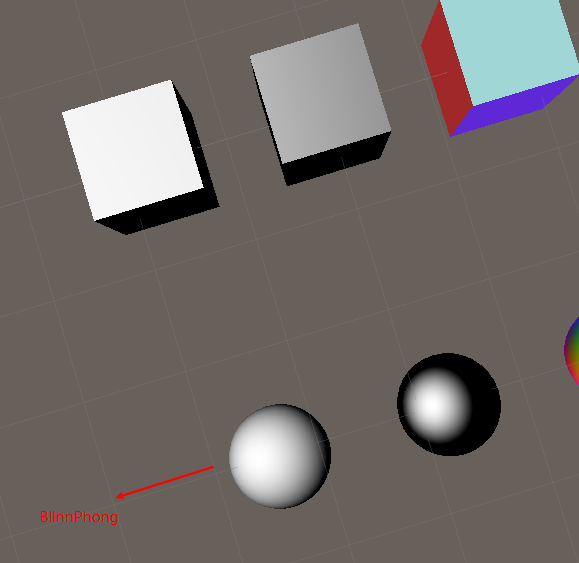

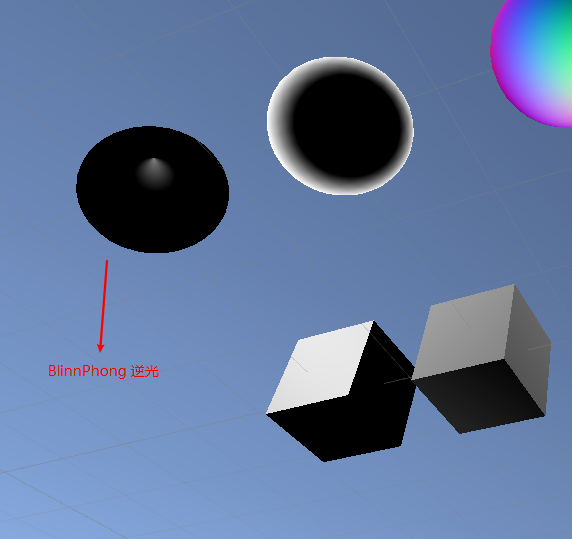

BlinnPhong

视角不逆光时的显示效果如下:

视角逆光时会有显示错误。错误如下图:

Energy Conservation

// Unity 实现的能量守恒 UnityStandardUtils.cginc half SpecularStrength(half3 specular) { #if (SHADER_TARGET < 30) // SM2.0: instruction count limitation // SM2.0: simplified SpecularStrength return specular.r; // Red channel - because most metals are either monocrhome or with redish/yellowish tint #else return max (max (specular.r, specular.g), specular.b); #endif } // Diffuse/Spec Energy conservation inline half3 EnergyConservationBetweenDiffuseAndSpecular (half3 albedo, half3 specColor, out half oneMinusReflectivity) { oneMinusReflectivity = 1 - SpecularStrength(specColor); #if !UNITY_CONSERVE_ENERGY return albedo; #elif UNITY_CONSERVE_ENERGY_MONOCHROME return albedo * oneMinusReflectivity; #else return albedo * (half3(1,1,1) - specColor); #endif }

Specular / Metallic Workflow

- Specular Workflow

Specular Workflow 中将 Specular Color 的强度提高来实现金属材质。将 Specular Color 的强度减弱来实现非金属材质。

// 默认是 Specular Workflow #ifndef UNITY_SETUP_BRDF_INPUT #define UNITY_SETUP_BRDF_INPUT SpecularSetup #endif inline FragmentCommonData SpecularSetup (float4 i_tex) { half4 specGloss = SpecularGloss(i_tex.xy); half3 specColor = specGloss.rgb; half smoothness = specGloss.a; half oneMinusReflectivity; half3 diffColor = EnergyConservationBetweenDiffuseAndSpecular (Albedo(i_tex), specColor, /*out*/ oneMinusReflectivity); FragmentCommonData o = (FragmentCommonData)0; o.diffColor = diffColor; o.specColor = specColor; o.oneMinusReflectivity = oneMinusReflectivity; o.smoothness = smoothness; return o; } // Diffuse/Spec Energy conservation inline half3 EnergyConservationBetweenDiffuseAndSpecular (half3 albedo, half3 specColor, out half oneMinusReflectivity) { oneMinusReflectivity = 1 - SpecularStrength(specColor); #if !UNITY_CONSERVE_ENERGY return albedo; #elif UNITY_CONSERVE_ENERGY_MONOCHROME return albedo * oneMinusReflectivity; #else // 该情况下,如果 specColor 不是灰度图,diffuse 颜色会显示异常 return albedo * (half3(1,1,1) - specColor); #endif } half SpecularStrength(half3 specular) { #if (SHADER_TARGET < 30) // SM2.0: instruction count limitation // SM2.0: simplified SpecularStrength return specular.r; // Red channel - because most metals are either monocrhome or with redish/yellowish tint #else return max (max (specular.r, specular.g), specular.b); #endif }

- Metallic Workflow

Metallic Workflow 中通过金属度来实现金属和非金属材质。

// 在自己的 shader 中定义 UNITY_SETUP_BRDF_INPUT = MetallicSetup 来指定使用 Metallic 流程 CGINCLUDE #define UNITY_SETUP_BRDF_INPUT MetallicSetup ENDCG inline FragmentCommonData MetallicSetup (float4 i_tex) { half2 metallicGloss = MetallicGloss(i_tex.xy); half metallic = metallicGloss.x; half smoothness = metallicGloss.y; // this is 1 minus the square root of real roughness m. half oneMinusReflectivity; half3 specColor; half3 diffColor = DiffuseAndSpecularFromMetallic (Albedo(i_tex), metallic, /*out*/ specColor, /*out*/ oneMinusReflectivity); FragmentCommonData o = (FragmentCommonData)0; o.diffColor = diffColor; o.specColor = specColor; o.oneMinusReflectivity = oneMinusReflectivity; o.smoothness = smoothness; return o; } inline half3 DiffuseAndSpecularFromMetallic (half3 albedo, half metallic, out half3 specColor, out half oneMinusReflectivity) { specColor = lerp (unity_ColorSpaceDielectricSpec.rgb, albedo, metallic); oneMinusReflectivity = OneMinusReflectivityFromMetallic(metallic); // 返回 diffuseColor // metallic=1 diffuseColor=0 oneMinusReflectivity=0 // metallic=0 diffuseColor=albedo*oneMinusDielectricSpec oneMinusReflectivity=oneMinusDielectricSpec return albedo * oneMinusReflectivity; } // 常量定义 #ifdef UNITY_COLORSPACE_GAMMA #define unity_ColorSpaceGrey fixed4(0.5, 0.5, 0.5, 0.5) #define unity_ColorSpaceDouble fixed4(2.0, 2.0, 2.0, 2.0) #define unity_ColorSpaceDielectricSpec half4(0.220916301, 0.220916301, 0.220916301, 1.0 - 0.220916301) #define unity_ColorSpaceLuminance half4(0.22, 0.707, 0.071, 0.0) // Legacy: alpha is set to 0.0 to specify gamma mode #else // Linear values #define unity_ColorSpaceGrey fixed4(0.214041144, 0.214041144, 0.214041144, 0.5) #define unity_ColorSpaceDouble fixed4(4.59479380, 4.59479380, 4.59479380, 2.0) #define unity_ColorSpaceDielectricSpec half4(0.04, 0.04, 0.04, 1.0 - 0.04) // standard dielectric reflectivity coef at incident angle (= 4%) #define unity_ColorSpaceLuminance half4(0.0396819152, 0.458021790, 0.00609653955, 1.0) // Legacy: alpha is set to 1.0 to specify linear mode #endif inline half OneMinusReflectivityFromMetallic(half metallic) { // 推导: // We'll need oneMinusReflectivity, so // 1-reflectivity = 1-lerp(dielectricSpec, 1, metallic) = lerp(1-dielectricSpec, 0, metallic) // store (1-dielectricSpec) in unity_ColorSpaceDielectricSpec.a, then // 1-reflectivity = lerp(alpha, 0, metallic) = alpha + metallic*(0 - alpha) = // = alpha - metallic * alpha half oneMinusDielectricSpec = unity_ColorSpaceDielectricSpec.a; // metallic=0 Reflectivity=DielectricSpec OneMinusReflectivity=oneMinusDielectricSpec // metallic=1 Reflectivity=1 OneMinusReflectivity=0 return oneMinusDielectricSpec - metallic * oneMinusDielectricSpec; }

Multi Lights

Light Coord

#ifdef POINT # define DECLARE_LIGHT_COORDS(idx) unityShadowCoord3 _LightCoord : TEXCOORD##idx; # define COMPUTE_LIGHT_COORDS(a) a._LightCoord = mul(unity_WorldToLight, mul(unity_ObjectToWorld, v.vertex)).xyz; # define LIGHT_ATTENUATION(a) (tex2D(_LightTexture0, dot(a._LightCoord,a._LightCoord).rr).r * SHADOW_ATTENUATION(a)) #endif #ifdef SPOT # define DECLARE_LIGHT_COORDS(idx) unityShadowCoord4 _LightCoord : TEXCOORD##idx; # define COMPUTE_LIGHT_COORDS(a) a._LightCoord = mul(unity_WorldToLight, mul(unity_ObjectToWorld, v.vertex)); # define LIGHT_ATTENUATION(a) ( (a._LightCoord.z > 0) * UnitySpotCookie(a._LightCoord) * UnitySpotAttenuate(a._LightCoord.xyz) * SHADOW_ATTENUATION(a) ) #endif #ifdef DIRECTIONAL # define DECLARE_LIGHT_COORDS(idx) # define COMPUTE_LIGHT_COORDS(a) # define LIGHT_ATTENUATION(a) SHADOW_ATTENUATION(a) #endif #ifdef POINT_COOKIE # define DECLARE_LIGHT_COORDS(idx) unityShadowCoord3 _LightCoord : TEXCOORD##idx; # define COMPUTE_LIGHT_COORDS(a) a._LightCoord = mul(unity_WorldToLight, mul(unity_ObjectToWorld, v.vertex)).xyz; # define LIGHT_ATTENUATION(a) (tex2D(_LightTextureB0, dot(a._LightCoord,a._LightCoord).rr).r * texCUBE(_LightTexture0, a._LightCoord).w * SHADOW_ATTENUATION(a)) #endif #ifdef DIRECTIONAL_COOKIE # define DECLARE_LIGHT_COORDS(idx) unityShadowCoord2 _LightCoord : TEXCOORD##idx; # define COMPUTE_LIGHT_COORDS(a) a._LightCoord = mul(unity_WorldToLight, mul(unity_ObjectToWorld, v.vertex)).xy; # define LIGHT_ATTENUATION(a) (tex2D(_LightTexture0, a._LightCoord).w * SHADOW_ATTENUATION(a)) #endif #define UNITY_LIGHTING_COORDS(idx1, idx2) DECLARE_LIGHT_COORDS(idx1) UNITY_SHADOW_COORDS(idx2) #define LIGHTING_COORDS(idx1, idx2) DECLARE_LIGHT_COORDS(idx1) SHADOW_COORDS(idx2) // vertex shader 中,计算_LightCoord #define UNITY_TRANSFER_LIGHTING(a, coord) COMPUTE_LIGHT_COORDS(a) UNITY_TRANSFER_SHADOW(a, coord) #define TRANSFER_VERTEX_TO_FRAGMENT(a) COMPUTE_LIGHT_COORDS(a) TRANSFER_SHADOW(a) #endif

Light Attenuation

#ifdef POINT sampler2D_float _LightTexture0; unityShadowCoord4x4 unity_WorldToLight; #define UNITY_LIGHT_ATTENUATION(destName, input, worldPos) \ unityShadowCoord3 lightCoord = mul(unity_WorldToLight, unityShadowCoord4(worldPos, 1)).xyz; \ fixed shadow = UNITY_SHADOW_ATTENUATION(input, worldPos); \ // 按照距离的平方衰减 fixed destName = tex2D(_LightTexture0, dot(lightCoord, lightCoord).rr).r * shadow; #endif #ifdef SPOT sampler2D_float _LightTexture0; unityShadowCoord4x4 unity_WorldToLight; sampler2D_float _LightTextureB0; inline fixed UnitySpotCookie(unityShadowCoord4 LightCoord) { // 采样时从齐次坐标系转换到欧拉坐标系 // 偏移 0.5 这样灯光坐标系原点就和图片中心点对应了 return tex2D(_LightTexture0, LightCoord.xy / LightCoord.w + 0.5).w; } inline fixed UnitySpotAttenuate(unityShadowCoord3 LightCoord) { // 使用RenderDoc 截取_LightTextureB0 对应的图片资源,发现其为1024x1的从1到0衰减的图片 return tex2D(_LightTextureB0, dot(LightCoord, LightCoord).xx).r; } #if !defined(UNITY_HALF_PRECISION_FRAGMENT_SHADER_REGISTERS) #define DECLARE_LIGHT_COORD(input, worldPos) unityShadowCoord4 lightCoord = mul(unity_WorldToLight, unityShadowCoord4(worldPos, 1)) #else #define DECLARE_LIGHT_COORD(input, worldPos) unityShadowCoord4 lightCoord = input._LightCoord #endif #define UNITY_LIGHT_ATTENUATION(destName, input, worldPos) \ DECLARE_LIGHT_COORD(input, worldPos); \ fixed shadow = UNITY_SHADOW_ATTENUATION(input, worldPos); \ fixed destName = (lightCoord.z > 0) * UnitySpotCookie(lightCoord) * UnitySpotAttenuate(lightCoord.xyz) * shadow; #endif #ifdef DIRECTIONAL #define UNITY_LIGHT_ATTENUATION(destName, input, worldPos) fixed destName = UNITY_SHADOW_ATTENUATION(input, worldPos); #endif #ifdef POINT_COOKIE samplerCUBE_float _LightTexture0; unityShadowCoord4x4 unity_WorldToLight; sampler2D_float _LightTextureB0; #if !defined(UNITY_HALF_PRECISION_FRAGMENT_SHADER_REGISTERS) #define DECLARE_LIGHT_COORD(input, worldPos) unityShadowCoord3 lightCoord = mul(unity_WorldToLight, unityShadowCoord4(worldPos, 1)).xyz #else #define DECLARE_LIGHT_COORD(input, worldPos) unityShadowCoord3 lightCoord = input._LightCoord #endif #define UNITY_LIGHT_ATTENUATION(destName, input, worldPos) \ DECLARE_LIGHT_COORD(input, worldPos); \ fixed shadow = UNITY_SHADOW_ATTENUATION(input, worldPos); \ // 使用RenderDoc 截取_LightTextureB0 对应的图片资源,发现其为1024x1的从1到0衰减的图片 fixed destName = tex2D(_LightTextureB0, dot(lightCoord, lightCoord).rr).r * texCUBE(_LightTexture0, lightCoord).w * shadow; #endif #ifdef DIRECTIONAL_COOKIE sampler2D_float _LightTexture0; unityShadowCoord4x4 unity_WorldToLight; #if !defined(UNITY_HALF_PRECISION_FRAGMENT_SHADER_REGISTERS) #define DECLARE_LIGHT_COORD(input, worldPos) unityShadowCoord2 lightCoord = mul(unity_WorldToLight, unityShadowCoord4(worldPos, 1)).xy #else #define DECLARE_LIGHT_COORD(input, worldPos) unityShadowCoord2 lightCoord = input._LightCoord #endif #define UNITY_LIGHT_ATTENUATION(destName, input, worldPos) \ DECLARE_LIGHT_COORD(input, worldPos); \ fixed shadow = UNITY_SHADOW_ATTENUATION(input, worldPos); \ fixed destName = tex2D(_LightTexture0, lightCoord).w * shadow; #endif

Mixing Lights

通过增加 shader 变体来实现对混合灯光的支持。

#pragma multi_compile DIRECTIONAL POINT

Cookies

Spot Light 默认支持 Cookie,Spot Light 的形状是通过 Cookie 来实现。SpotLight 的 Cookie 贴图的 Wrap 模式采用 Clamp。

Direcional 默认不支持 Cookie,需要通过 shader 变体开启支持。其 Cookie 贴图的 Wrap 模式采用 Repeat。

Point 默认不支持 Cookie,需要通过 shader 变体开启支持。其 Cookie 贴图是 Cube 贴图,Wrap 模式采用 Clamp。

// 下面代码等价于 #pragma multi_compile_fwdadd #pragma multi_compile DIRECTIONAL POINT DIRECTIONAL_COOKIE POINT_COOKIE

- multi_compile_fwdbase 变体 https://www.cnblogs.com/sifenkesi/p/9942272.html

Vertex Lights

灯光数量增加后,drawcall 数量会成倍增加。Unity 可以设置逐像素光照的数量。如果将超出数量限制的光照直接不进行计算,会导致明显的显示错误,可以采用更廉价的顶点光照来代替像素光照。

Unity 在 Base Pass 中实现顶点光照。引擎会寻找包含 VERTEXLIGHT_ON 关键字的 Base Pass 着色器。

顶点光照只支持 点光源,方向光和聚光灯都能在顶点着色器中计算。

在 Light 的 RenderMode 属性中,可以设置重要类型,Important 类型的光照总是逐像素光照,Not Important 类型的光照永远不会被当作逐像素光照,Auto 类型的光照其重要性由引擎来决定。

// UnityCG.cginc // 该函数返回了4个点光源对于当前顶点的综合光照颜色 // 在顶点中计算 4 个点光源光照,当光源数目不足 4 个时,计算消耗依然是 4 个光照的计算量 // Used in ForwardBase pass: Calculates diffuse lighting from 4 point lights, with data packed in a special way. float3 Shade4PointLights ( float4 lightPosX, float4 lightPosY, float4 lightPosZ, float3 lightColor0, float3 lightColor1, float3 lightColor2, float3 lightColor3, float4 lightAttenSq, float3 pos, float3 normal) { // to light vectors float4 toLightX = lightPosX - pos.x; float4 toLightY = lightPosY - pos.y; float4 toLightZ = lightPosZ - pos.z; // squared lengths float4 lengthSq = 0; lengthSq += toLightX * toLightX; lengthSq += toLightY * toLightY; lengthSq += toLightZ * toLightZ; // don't produce NaNs if some vertex position overlaps with the light lengthSq = max(lengthSq, 0.000001); // NdotL float4 ndotl = 0; ndotl += toLightX * normal.x; ndotl += toLightY * normal.y; ndotl += toLightZ * normal.z; // correct NdotL float4 corr = rsqrt(lengthSq); ndotl = max (float4(0,0,0,0), ndotl * corr); // attenuation lightAttenSq 用于改进顶点光照的效果 float4 atten = 1.0 / (1.0 + lengthSq * lightAttenSq); float4 diff = ndotl * atten; // final color float3 col = 0; col += lightColor0 * diff.x; col += lightColor1 * diff.y; col += lightColor2 * diff.z; col += lightColor3 * diff.w; return col; }

Spherical Harmonics

- 原理概述

球谐函数背后的思想是你可以只用一个连续函数来描述所有入射光在某个点的效果,这个函数定义在球的表面。

通常来说,这个函数是用球面坐标表示的。但是也可以使用 3D 坐标,这样我们就可以使用物体的 normal 向量对函数进行采样了。

为了创建这样的函数,你必须在所有方向上对光照强度进行采样,然后将结果转换为单个连续的函数。为了达到完美模拟,你必须为表面的每个点做这样的工作。这当然是无法做到的,所以我们只能做到近似效果。

首先,我们只从对象本地原点的角度定义函数。光照条件在随物体表面变化不大时效果还是可以的。小物体,或者光照比较弱或光照离物体很远时满足这种情况。幸运的是,这恰好是那些不值得逐像素计算的光照或者顶点光照。

其次,我们必须近似函数自身。你可以将任何连续的函数分解为多个不同频率的函数。这些被称为波段。对于任意一个函数,你可能需要无数个波段来模拟。

- Spherical Harmonics Bands

第一个基带:使用一个常量颜色值是最简单近似灯光的方式。光照在各个方向上都是相同的。使用单个子函数表示,这个子函数为一个常量值。

第二个基带:第二个基带引入了线性方向光,对于每一个轴向,其描述了最多的光照来自哪儿。使用三个函数表示,每个函数包含一个我们法线的坐标值,并乘上一个常量。

第三个基带:第三个基带更加复杂,它有 5 个函数组成。这些函数都是二次方的,他们包含了两个法线坐标的乘积。

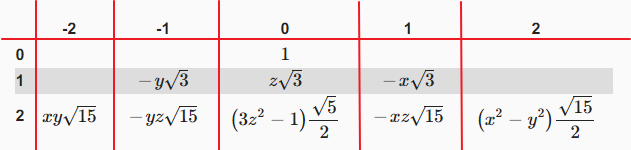

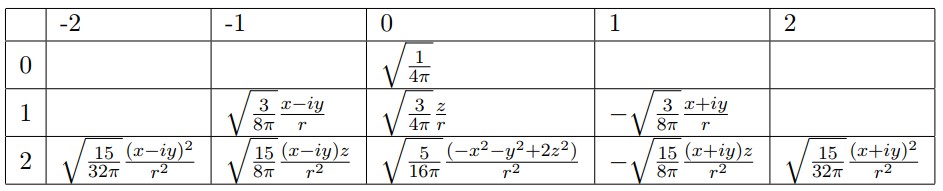

l band NO sub func count 0 1 1 3 2 5 3 7 4 9 下表为最大阶数 n 下,对应所有基带的子函数的个数

n n^2 1 1=1 2 1+3=4 3 1+3+5=9 4 1+3+5+7=16 下图列出了各个基带的子函数,每一项都需要再乘上 \(\frac{1}{2\sqrt{\pi}}\)

完整的归一化之后的(复)球谐函数如下:

因此我们可以使用 9 个因子来近似表示任何一种光照情况,考虑到颜色有 RGB 三个分量,一共需要使用 3*9=27 个因子。

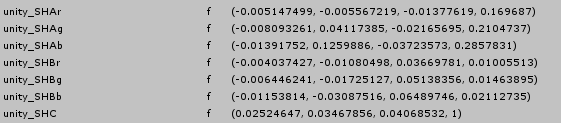

下图为 unity 中传递给 shader 的球谐数据:

- unity_SHAr.rgba 存储了光照 r 分量的第 1 个基带和第 0 个基带的参数因子,unity_SHBr.rgba + unitySHC.r 存储了光照 r 分量的第 2 个基带的参数因子

- unity_SHAg.rgba 存储了光照 g 分量的第 1 个基带和第 0 个基带的参数因子,unity_SHBg.rgba + unitySHC.g 存储了光照 g 分量的第 2 个基带的参数因子

- unity_SHAb.rgba 存储了光照 b 分量的第 1 个基带和第 0 个基带的参数因子,unity_SHBb.rgba + unitySHC.b 存储了光照 b 分量的第 2 个基带的参数因子

- unity_SHAr.rgba 存储了光照 r 分量的第 1 个基带和第 0 个基带的参数因子,unity_SHBr.rgba + unitySHC.r 存储了光照 r 分量的第 2 个基带的参数因子

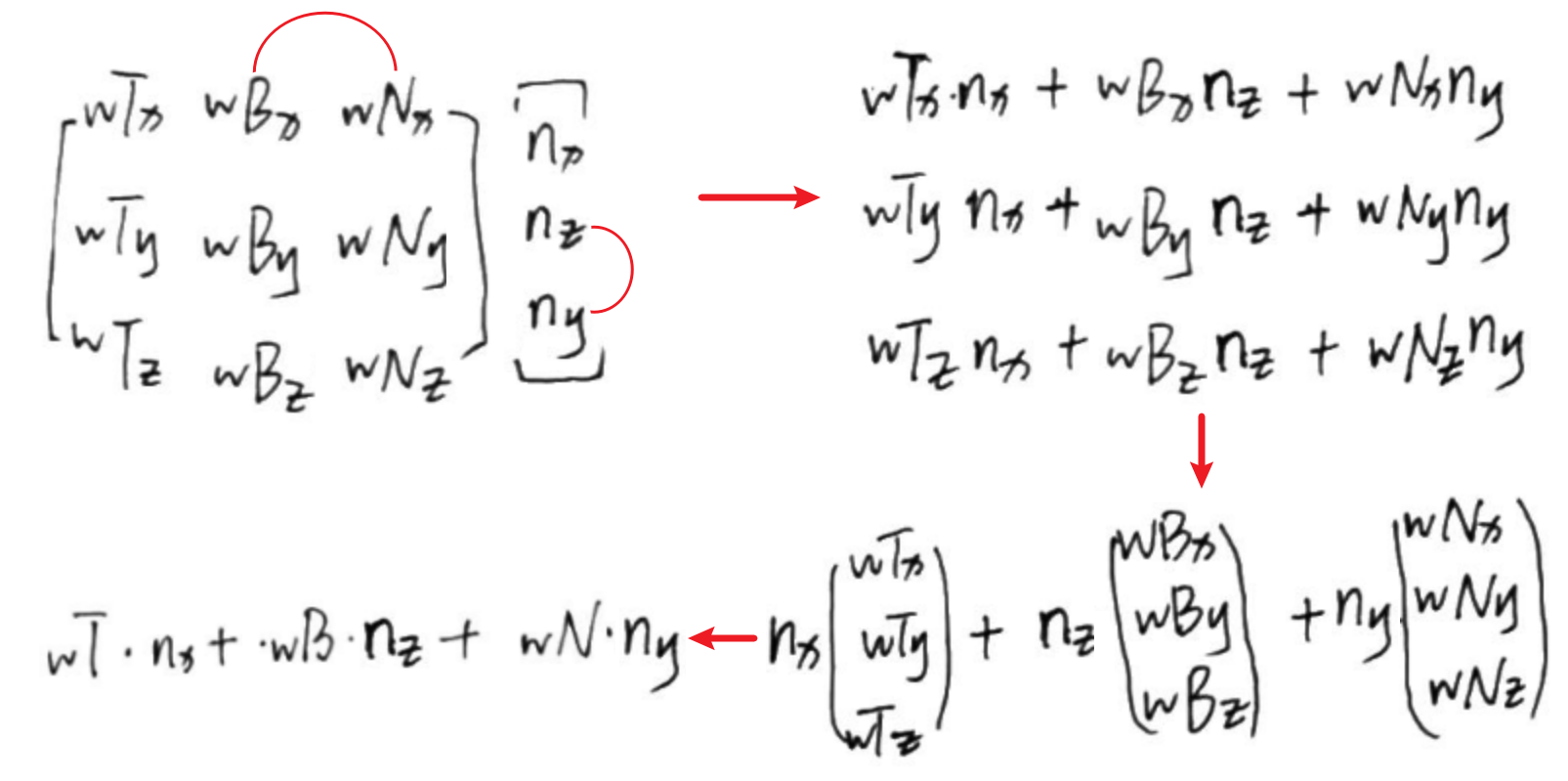

- ShadeSH9

// normal should be normalized, w=1.0 half3 SHEvalLinearL0L1 (half4 normal) { half3 x; // Linear (L1) + constant (L0) polynomial terms x.r = dot(unity_SHAr,normal); x.g = dot(unity_SHAg,normal); x.b = dot(unity_SHAb,normal); return x; } // normal should be normalized, w=1.0 half3 SHEvalLinearL2 (half4 normal) { half3 x1, x2; // 4 of the quadratic (L2) polynomials half4 vB = normal.xyzz * normal.yzzx; x1.r = dot(unity_SHBr,vB); x1.g = dot(unity_SHBg,vB); x1.b = dot(unity_SHBb,vB); // Final (5th) quadratic (L2) polynomial half vC = normal.x*normal.x - normal.y*normal.y; x2 = unity_SHC.rgb * vC; return x1 + x2; } // normal should be normalized, w=1.0 // output in active color space half3 ShadeSH9 (half4 normal) { // Linear + constant polynomial terms half3 res = SHEvalLinearL0L1 (normal); // Quadratic polynomials res += SHEvalLinearL2 (normal); # ifdef UNITY_COLORSPACE_GAMMA res = LinearToGammaSpace (res); # endif return res; }

- 环境光和 LightProbe

环境光和 LightProbe 都使用了球谐光照。在 Unity 中叠加到了间接光照的 diffuse 中。

环境光对应一组球谐系数。每个 LightProbe 也对应存储一组球谐系数。全局照明系统会烘培环境光探针,即使用球谐参数保存环境光参数,但是当几何体使用了光照探针和 Lightmaps 时,并不会应用环境光探针,因为环境光影响在光照探针和 Lightmaps 中已经存在了。只有当不存在光照探针和 Lightmap 时,才会使用环境光探针。

Tips:

RenderSettings.ambientIntensity 只会影响 ambientProbe,而不会影响 LightProbe。

unity 通过 SkyManager 来管理环境光(environment lighting). SkyManager 会自动生成一个 ambientProbe 和 default reflection probe 来 capture environtment lighting。

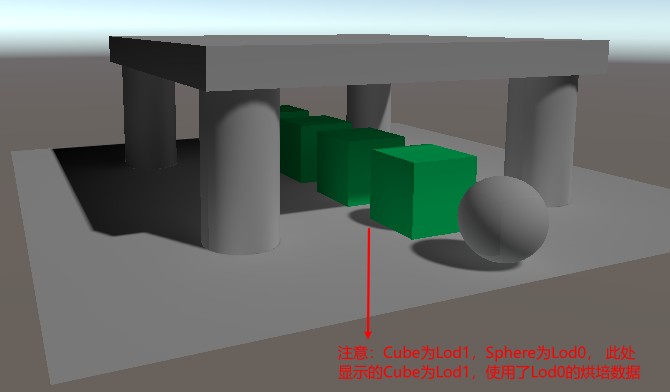

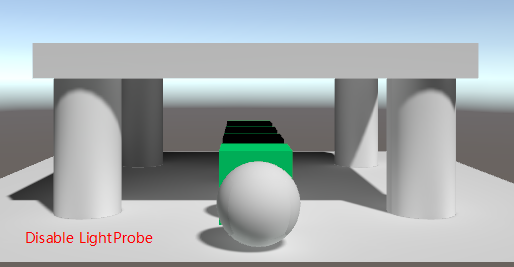

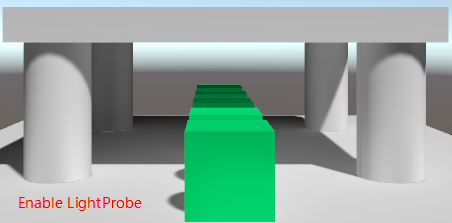

// Should SH (light probe / ambient) calculations be performed? // - 静态和动态lightmaps开启时,不执行SH计算。When both static and dynamic lightmaps are available, no SH evaluation is performed // - 静态和动态lightmaps关闭时,一定执行SH计算。 When static and dynamic lightmaps are not available, SH evaluation is always performed // - 对于低级LOD,静态lightmap和LightProbe实时全局照明可以合并在一起。 For low level LODs, static lightmap and real-time GI from light probes can be combined together // - forwardadd,shdowcaster等Pass不需要执行SH计算。Passes that don't do ambient (additive, shadowcaster etc.) should not do SH either. #define UNITY_SHOULD_SAMPLE_SH (defined(LIGHTPROBE_SH) && !defined(UNITY_PASS_FORWARDADD) && !defined(UNITY_PASS_PREPASSBASE) && !defined(UNITY_PASS_SHADOWCASTER) && !defined(UNITY_PASS_META)) half3 ShadeSHPerPixel (half3 normal, half3 ambient, float3 worldPos) { half3 ambient_contrib = 0.0; #if UNITY_SAMPLE_FULL_SH_PER_PIXEL // Completely per-pixel #if UNITY_LIGHT_PROBE_PROXY_VOLUME if (unity_ProbeVolumeParams.x == 1.0) ambient_contrib = SHEvalLinearL0L1_SampleProbeVolume(half4(normal, 1.0), worldPos); else ambient_contrib = SHEvalLinearL0L1(half4(normal, 1.0)); #else ambient_contrib = SHEvalLinearL0L1(half4(normal, 1.0)); #endif ambient_contrib += SHEvalLinearL2(half4(normal, 1.0)); ambient += max(half3(0, 0, 0), ambient_contrib); #ifdef UNITY_COLORSPACE_GAMMA ambient = LinearToGammaSpace(ambient); #endif #elif (SHADER_TARGET < 30) || UNITY_STANDARD_SIMPLE // Completely per-vertex // nothing to do here. Gamma conversion on ambient from SH takes place in the vertex shader, see ShadeSHPerVertex. #else // L2 per-vertex, L0..L1 & gamma-correction per-pixel // Ambient in this case is expected to be always Linear, see ShadeSHPerVertex() #if UNITY_LIGHT_PROBE_PROXY_VOLUME if (unity_ProbeVolumeParams.x == 1.0) ambient_contrib = SHEvalLinearL0L1_SampleProbeVolume (half4(normal, 1.0), worldPos); else ambient_contrib = SHEvalLinearL0L1 (half4(normal, 1.0)); #else ambient_contrib = SHEvalLinearL0L1 (half4(normal, 1.0)); #endif ambient = max(half3(0, 0, 0), ambient+ambient_contrib); // include L2 contribution in vertex shader before clamp. #ifdef UNITY_COLORSPACE_GAMMA ambient = LinearToGammaSpace (ambient); #endif #endif return ambient; } inline UnityGI UnityGI_Base(UnityGIInput data, half occlusion, half3 normalWorld) { UnityGI o_gi; ResetUnityGI(o_gi); // Base pass with Lightmap support is responsible for handling ShadowMask / blending here for performance reason #if defined(HANDLE_SHADOWS_BLENDING_IN_GI) half bakedAtten = UnitySampleBakedOcclusion(data.lightmapUV.xy, data.worldPos); float zDist = dot(_WorldSpaceCameraPos - data.worldPos, UNITY_MATRIX_V[2].xyz); float fadeDist = UnityComputeShadowFadeDistance(data.worldPos, zDist); data.atten = UnityMixRealtimeAndBakedShadows(data.atten, bakedAtten, UnityComputeShadowFade(fadeDist)); #endif o_gi.light = data.light; o_gi.light.color *= data.atten; // 此处调用 ShadeSHPerPixel 方法计算环境光 /LightProbe的球谐光照,将结果存储到indirectLight.diffuse中 #if UNITY_SHOULD_SAMPLE_SH o_gi.indirect.diffuse = ShadeSHPerPixel(normalWorld, data.ambient, data.worldPos); #endif #if defined(LIGHTMAP_ON) // Baked lightmaps half4 bakedColorTex = UNITY_SAMPLE_TEX2D(unity_Lightmap, data.lightmapUV.xy); half3 bakedColor = DecodeLightmap(bakedColorTex); #ifdef DIRLIGHTMAP_COMBINED fixed4 bakedDirTex = UNITY_SAMPLE_TEX2D_SAMPLER (unity_LightmapInd, unity_Lightmap, data.lightmapUV.xy); o_gi.indirect.diffuse += DecodeDirectionalLightmap (bakedColor, bakedDirTex, normalWorld); #if defined(LIGHTMAP_SHADOW_MIXING) && !defined(SHADOWS_SHADOWMASK) && defined(SHADOWS_SCREEN) ResetUnityLight(o_gi.light); o_gi.indirect.diffuse = SubtractMainLightWithRealtimeAttenuationFromLightmap (o_gi.indirect.diffuse, data.atten, bakedColorTex, normalWorld); #endif #else // not directional lightmap o_gi.indirect.diffuse += bakedColor; #if defined(LIGHTMAP_SHADOW_MIXING) && !defined(SHADOWS_SHADOWMASK) && defined(SHADOWS_SCREEN) ResetUnityLight(o_gi.light); o_gi.indirect.diffuse = SubtractMainLightWithRealtimeAttenuationFromLightmap(o_gi.indirect.diffuse, data.atten, bakedColorTex, normalWorld); #endif #endif #endif #ifdef DYNAMICLIGHTMAP_ON // Dynamic lightmaps fixed4 realtimeColorTex = UNITY_SAMPLE_TEX2D(unity_DynamicLightmap, data.lightmapUV.zw); half3 realtimeColor = DecodeRealtimeLightmap (realtimeColorTex); #ifdef DIRLIGHTMAP_COMBINED half4 realtimeDirTex = UNITY_SAMPLE_TEX2D_SAMPLER(unity_DynamicDirectionality, unity_DynamicLightmap, data.lightmapUV.zw); o_gi.indirect.diffuse += DecodeDirectionalLightmap (realtimeColor, realtimeDirTex, normalWorld); #else o_gi.indirect.diffuse += realtimeColor; #endif #endif o_gi.indirect.diffuse *= occlusion; return o_gi; }

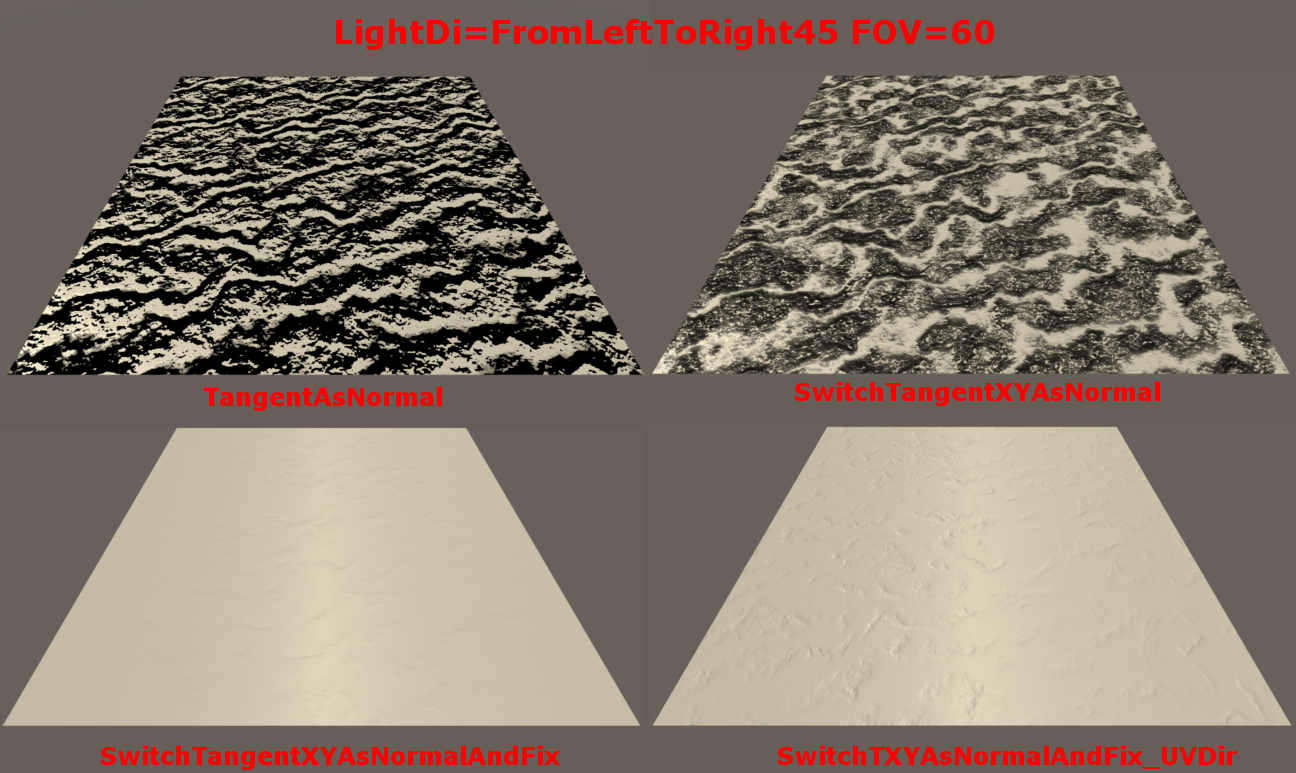

Bumpiness

高度图转 normal map 的方法

- 方案 1

- 通过高度求出每一点的斜率。该斜率就是该点的 tangent。求出 u 或 v 方向的 tangent。

- 将 tangent 绕 z 轴旋转 90 度,就是 normal。

// 利用 u 方向高度变化来求 normal float2 delta = float2(_HeightMap_TexelSize.x, 0); float h1 = tex2D(_HeightMap, i.uv); float h2 = tex2D(_HeightMap, i.uv + delta); // scale normal with 1/delta.x 第一种形式消除了除法,而且改善了精度 // i.normal = float3(delta.x, h2 - h1, 0); <==> i.normal = float3(1, (h2 - h1)/delta.x, 0); i.normal = float3(delta.x, h2 - h1, 0); // 调换 x 和 y 将 tangent 转化为 normal i.normal = float3(h2 - h1, delta.x, 0); // 放大y减弱normal效果 i.normal = float3(h2 - h1, 1, 0); // 也可以利用 v 方向高度来变化求 normal.实现方法相同

下图为使用该方式计算 normal 的效果图

- 通过高度求出每一点的斜率。该斜率就是该点的 tangent。求出 u 或 v 方向的 tangent。

- 方案 2

- 通过高度求出每一点的斜率。该斜率就是该点的 tangent。分别求出 u/v 方向的 tangent。

- 将 u/v 方向的 tangent 进行叉乘生成 normal。

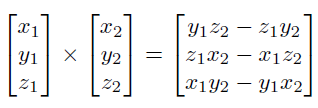

下面是向量叉乘公式:

此处 tangent 向量叉乘计算结果为:

\begin{equation} \begin{bmatrix} 0\\ {f_v}'\\ 1 \end{bmatrix} \times \begin{bmatrix} 1\\ {f_u}'\\ 0 \end{bmatrix} = \begin{bmatrix} {f_v}'*0-1*{f_u}'\\ 1*1-0*0 \\ 0*{f_u}'-{f_v}'*1 \end{bmatrix} = \begin{bmatrix} -{f_u}'\\ 1 \\ -{f_v}' \end{bmatrix} \end{equation}

float2 du = float2(_HeightMap_TexelSize.x * 0.5, 0); float u1 = tex2D(_HeightMap, i.uv - du); float u2 = tex2D(_HeightMap, i.uv + du); float3 tu = float3(1, u2 - u1, 0); float2 dv = float2(0, _HeightMap_TexelSize.y * 0.5); float v1 = tex2D(_HeightMap, i.uv - dv); float v2 = tex2D(_HeightMap, i.uv + dv); float3 tv = float3(0, v2 - v1, 1); i.normal = cross(tv, tu); i.normal = normalize(i.normal);

- 通过高度求出每一点的斜率。该斜率就是该点的 tangent。分别求出 u/v 方向的 tangent。

Normal 向量的插值

Normal 贴图的 Filter,以及顶点的 Normal 向量在传递到片段着色器过程中的插值 都会导致 normal 向量不再是单位向量,所以需要重新单位化。

Normal 贴图存储惯例

Normal 贴图通用的惯例是将向上的方向存储到 z 分量.所以,在 shader 中采样出来 normal 向量后需要调换 y 分量和 z 分量。

DXT5nm 存储 normal 贴图

其只存储了 normal 的 x,y 分量,丢弃掉了 z 分量。z 分量通过计算得到 \(z=\sqrt{1-x^2-y^2}\) .

x 分量存储在 A 通道,y 分量存储在 G 通道。R 通道和 B 通道没有使用。

DXT5 按照 4x4 个像素为一个块进行压缩。R 占用 5 位,B 占用 5 位,G 占用 6 位,A 占用 8 位。RGB 公用一个查找表,A 单独使用一个查找表。所以将 x 分量存储到 A 通道可以保持 x 分量和 y 分量的独立性。

手机平台不支持 DXT5nm 格式,在手机平台 unity 仍然使用通用的 rgb 进行编码。

缩放 Normal

只需要在单位化 normal 前,对 normal 的 x 分量和 z 分量进行缩放,就可以强化和弱化 y 分量。

Blending Normals

回顾使用高度图生成 normal 贴图的方法,可以知道,如果希望 normal 效果叠加,其实就是将高度叠加,也就是斜率叠加(斜率为 h/x, 贴图各个地方 x 都相同,因此高度相当于斜率)。

normal 贴图中存储的值为:(s 表示单位化过程中,对各个分量的缩放)

所以叠加 MainNormalTex 和 DetailNormalTex 的高度后得到的 normal 为

Whiteout Blending : 对上面得到的 normal 乘 \(M_zD_z\) ,然后丢弃掉对 x 和 y 分量的缩放、这样可以强化 X 和 Y 分量

下面这段文字翻译自 Blending in Detial 文章:

在开发 Reoriented Normal Mapping 方法时,我们希望新的方法满足下面的属性,从而能让艺术家从直观上理解其行为:

属性 1:符合逻辑,方法有清晰的数学理论基础。(如:有清晰的几何解释)

属性 2:处理恒等情况,如果其中一个 normal map 是平的,则输出和另外一个 normal map 一样。

属性 3:不会变平,两个 normal map 的强度都会被保持。

尽管 Whiteout 方法看似可行,但是其并不完全具备上面的第一和第三条属性。为了满足这些属性,我们的策略是对 detail normal 进行旋转使其跟随 base normal 对应的表面,就像切空间的 normal 会被变换以跟随几何表面的法线。

Unity 中 base normal 和 detail normal 的混合使用了类似的思路,但是,其构造的 detail normal 旋转矩阵使用的三个向量并不是正交的。

float3 n1 = tex2D(texBase, uv).xyz*2 - 1; float3 n2 = tex2D(texDetail, uv).xyz*2 - 1; float3x3 nBasis = float3x3( float3(n1.z, n1.y, -n1.x), // +90 degree rotation around y axis float3(n1.x, n1.z, -n1.y), // -90 degree rotation around x axis float3(n1.x, n1.y, n1.z)); float3 r = normalize(n2.x*nBasis[0] + n2.y*nBasis[1] + n2.z*nBasis[2]); return r*0.5 + 0.5;

- Blending in Detail https://blog.selfshadow.com/publications/blending-in-detail/index.html

- Normal Blend 方法总结 https://zhuanlan.zhihu.com/p/364821684

Tangent Space And Tangent Space To World Space

TangentSpace 基向量如下:(假设左手坐标系,Tangent 对应 x 轴,Normal 对应 y 轴,Binormal 对应 z 轴)

- Tangent 向量对应 U axis

- Normal 向量对应表面法线

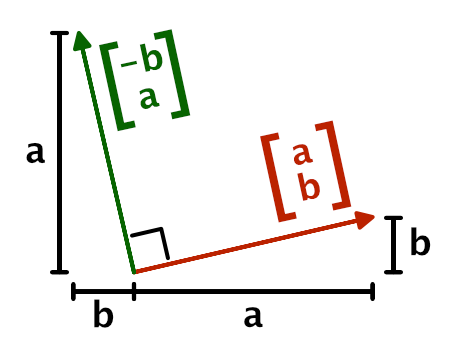

- Binormal(或 Bitangent)向量对应 V axis。Binormal = Tangent x Normal = -(Normal x Tangent)。

- 为什么要在 tangent vector 的 w 分量中存储-1 或 1?

创建左右对称的 3D 模型(例如:人类,动物)时,通常会对 mesh 进行作于镜像。这样就只需要编辑半部分模型,而且也只需要一半的贴图数据。在进行模型镜像的时候,顶点的 normal,tangent,向量也需要进行镜像,但是 binormal 向量则不需要。可以通过在 tangent 的 w 分量中存储-1 来表示 binormal 为非镜像的,tangent 的 w 分量中存储 1 来表示 binormal 为镜像的。

- 为什么不需要对 worldTangent 和 worldBinormal 进行 normalize?

worldTangent worldBinormal 只用于得到 TangentToWorld 变换矩阵,从而将 tangentNormal 转换为 worldNormal。不会直接使用 worldTangent worldBinormal 用于光照计算,所以不需要 normalize。

- 为什么 Unity 中没有对法线 y、z 分量进行调换?

// Unity 实现 half3x3 CreateTangentToWorldPerVertex(half3 normal, half3 tangent, half tangentSign) { // For odd-negative scale transforms we need to flip the sign half sign = tangentSign * unity_WorldTransformParams.w; half3 binormal = cross(normal, tangent) * sign; // TIPS: normal 放到了最后一列从而和法线的真实的y相对应,从而实现了法线y,z分量的调换 return half3x3(tangent, binormal, normal); } // vertex shader float4 tangentWorld = float4(UnityObjectToWorldDir(v.tangent.xyz), v.tangent.w); float3x3 tangentToWorld = CreateTangentToWorldPerVertex(normalWorld, tangentWorld.xyz, tangentWorld.w); // fragment shader half3 tangent = tangentToWorld[0].xyz; half3 binormal = tangentToWorld[1].xyz; half3 normal = tangentToWorld[2].xyz; // TIPS: float3 normalWorld = tangent * normalTangent.x + binormal * normalTangent.y + normal * normalTangent.z;

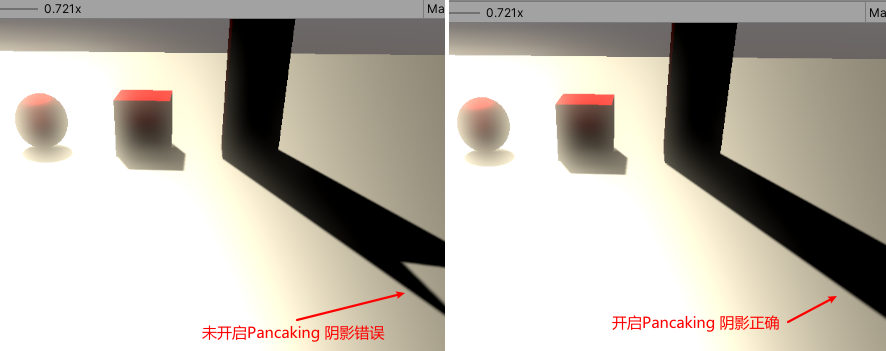

Shadows

方向光阴影

- ShadowBias

- 开启屏幕空间阴影

- 开启关闭的方法

- 关闭 在 ProjectSetting/Graphic 中,将 Screen Space Shadows 设置为 No Support,Tier 中取消勾选 Cascaded Shadows 。

- 开启 在 ProjectSetting/Graphic 中,将 Screen Space Shadows 设置为 Built-in shader,Tier 中勾选 Cascaded Shadows 。

- 关闭 在 ProjectSetting/Graphic 中,将 Screen Space Shadows 设置为 No Support,Tier 中取消勾选 Cascaded Shadows 。

- Rendering to Depth Texture

Unity 绘制场景中物体将其深度写入到 DepthTexture

- Rendering To Shadow Maps

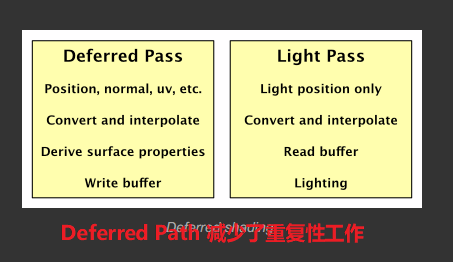

Unity 在光源位置对场景进行绘制,将物体深度写入到 Shadowmap

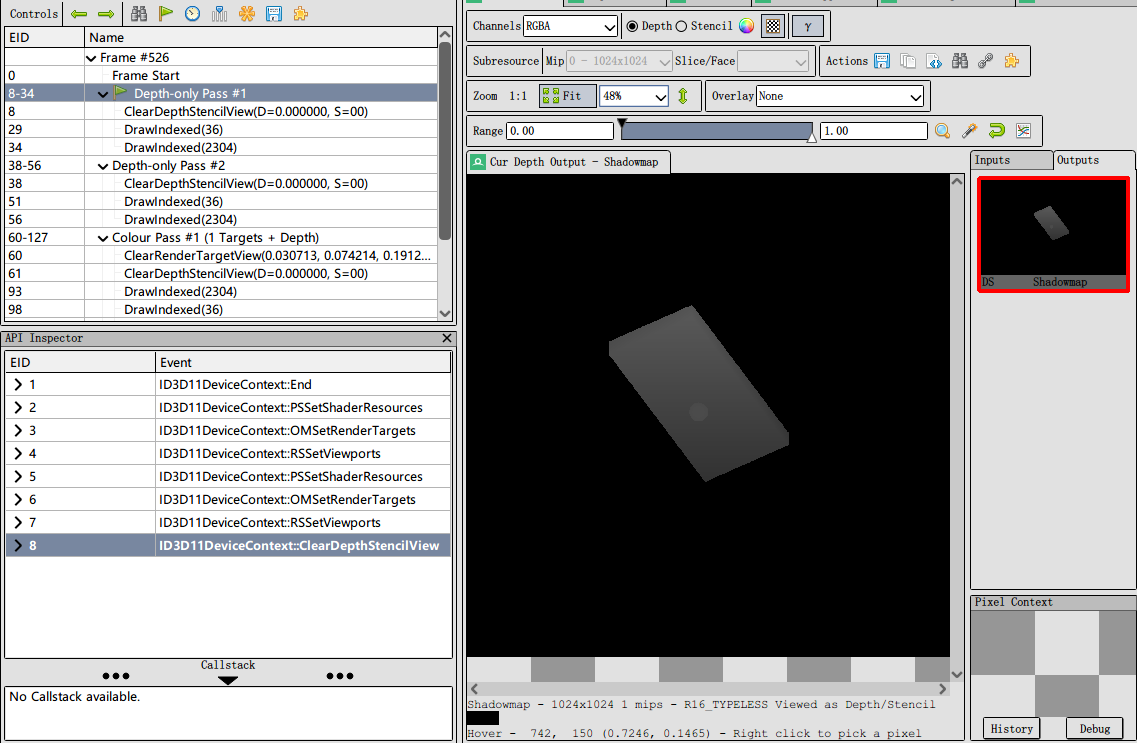

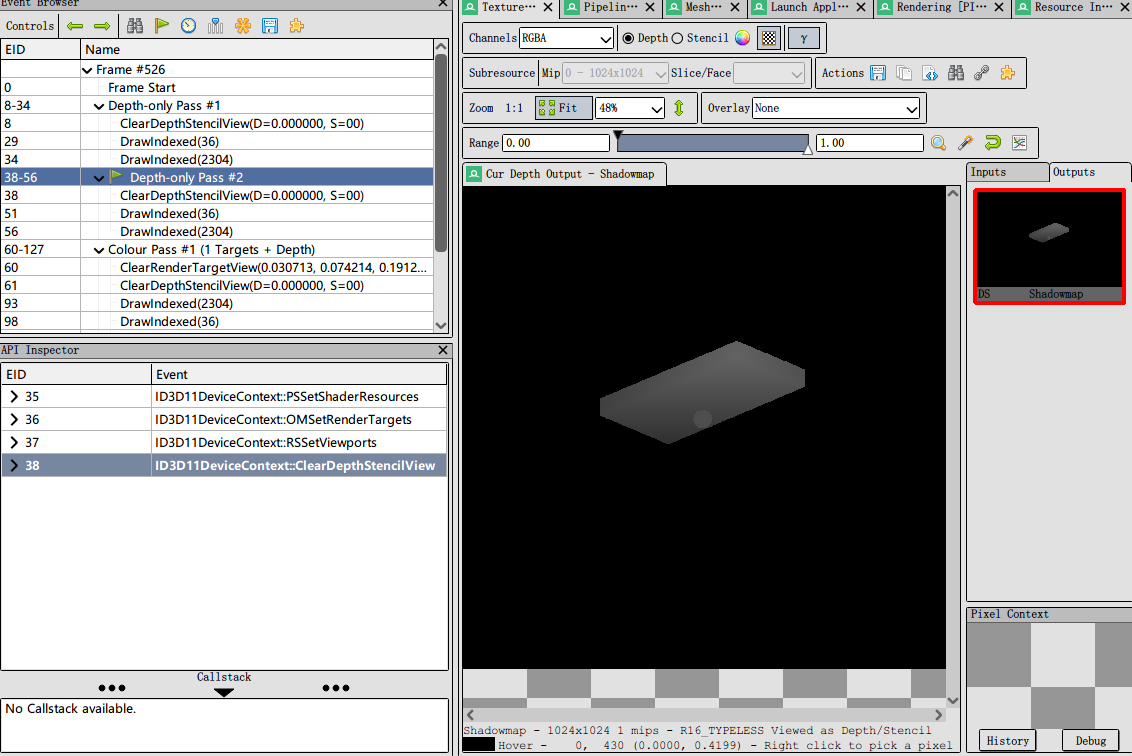

开启 shadow cascades 后,会多次绘制阴影。开启 2 级会绘制两次,开启 4 级会绘制 4 次。

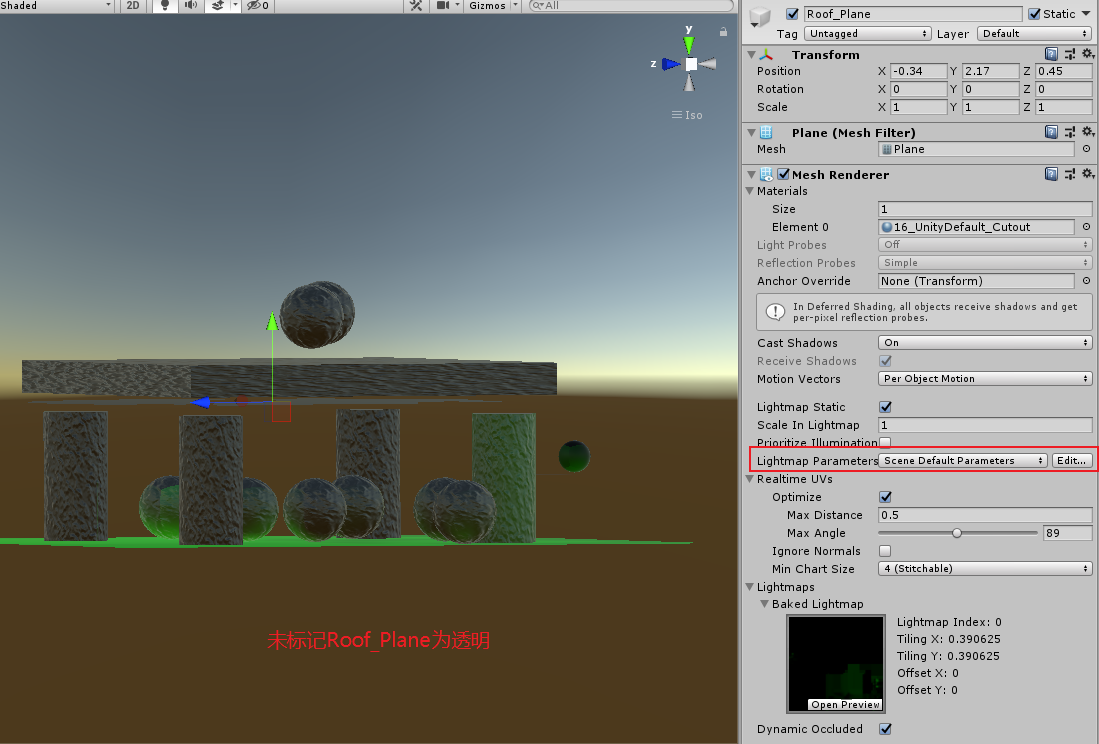

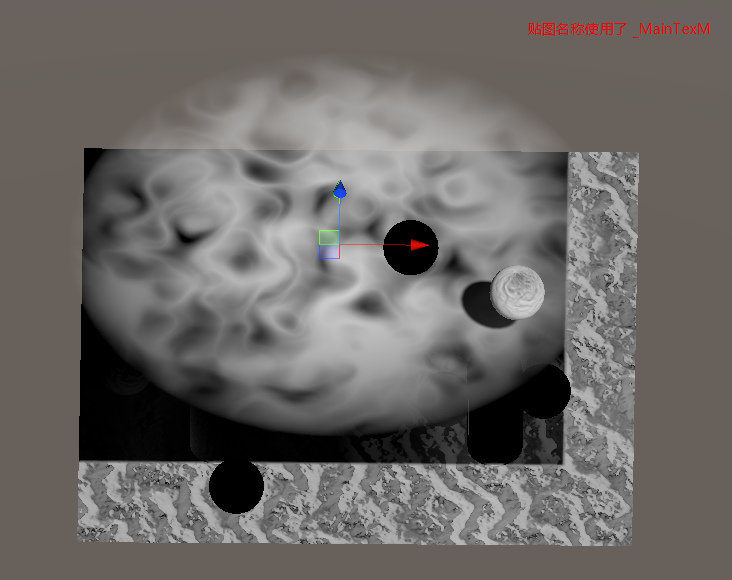

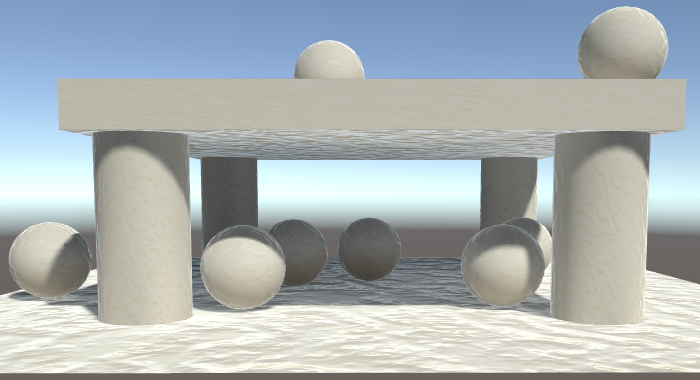

下图为第一个方向光视角下开启 4 级 cascades 阴影渲染的阴影贴图:

下图为第二个方向光视角下开启 4 级 cascades 阴影渲染的阴影贴图:

- Collecting Shadows

Unity 使用 Hidden/Internal-ScreenSpaceShadows shader 绘制一个全屏的矩形,以前面得到的 DepthTexture 和 Shadowmap 为输入,对于每一个片段通过比较对应的场景摄像机的深度和光照摄像机的深度得出屏幕空间的阴影贴图。

在这个过程中,Unity 通过 Filtering 来实现软阴影。

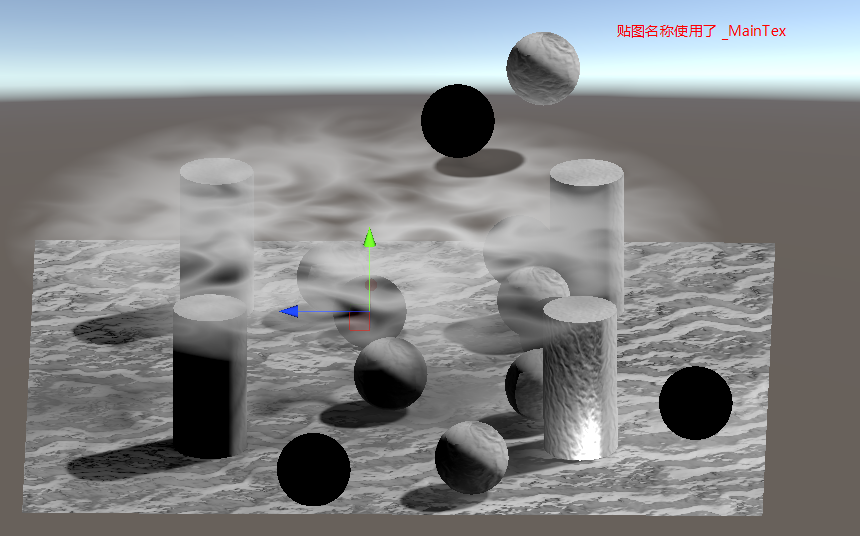

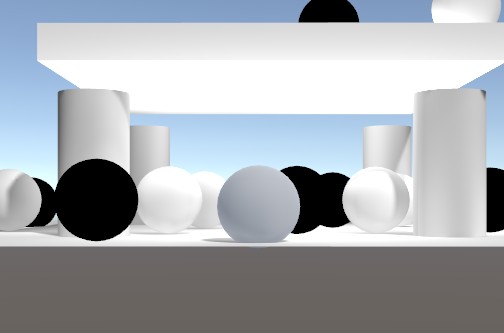

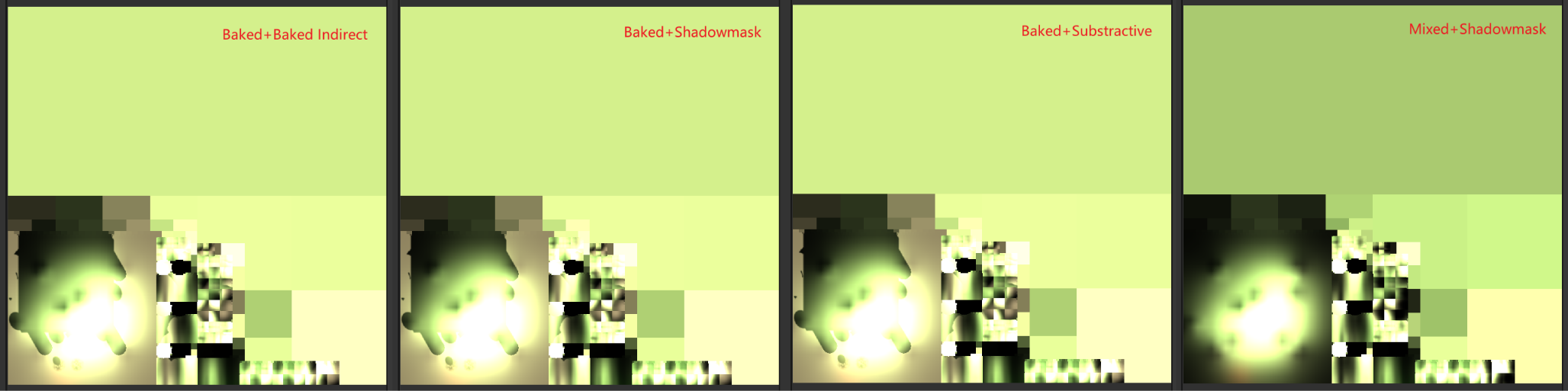

下图为第一个方向光对应的屏幕空间阴影贴图:

下图为第二个方向光对应的屏幕空间阴影贴图:

- 最终结果

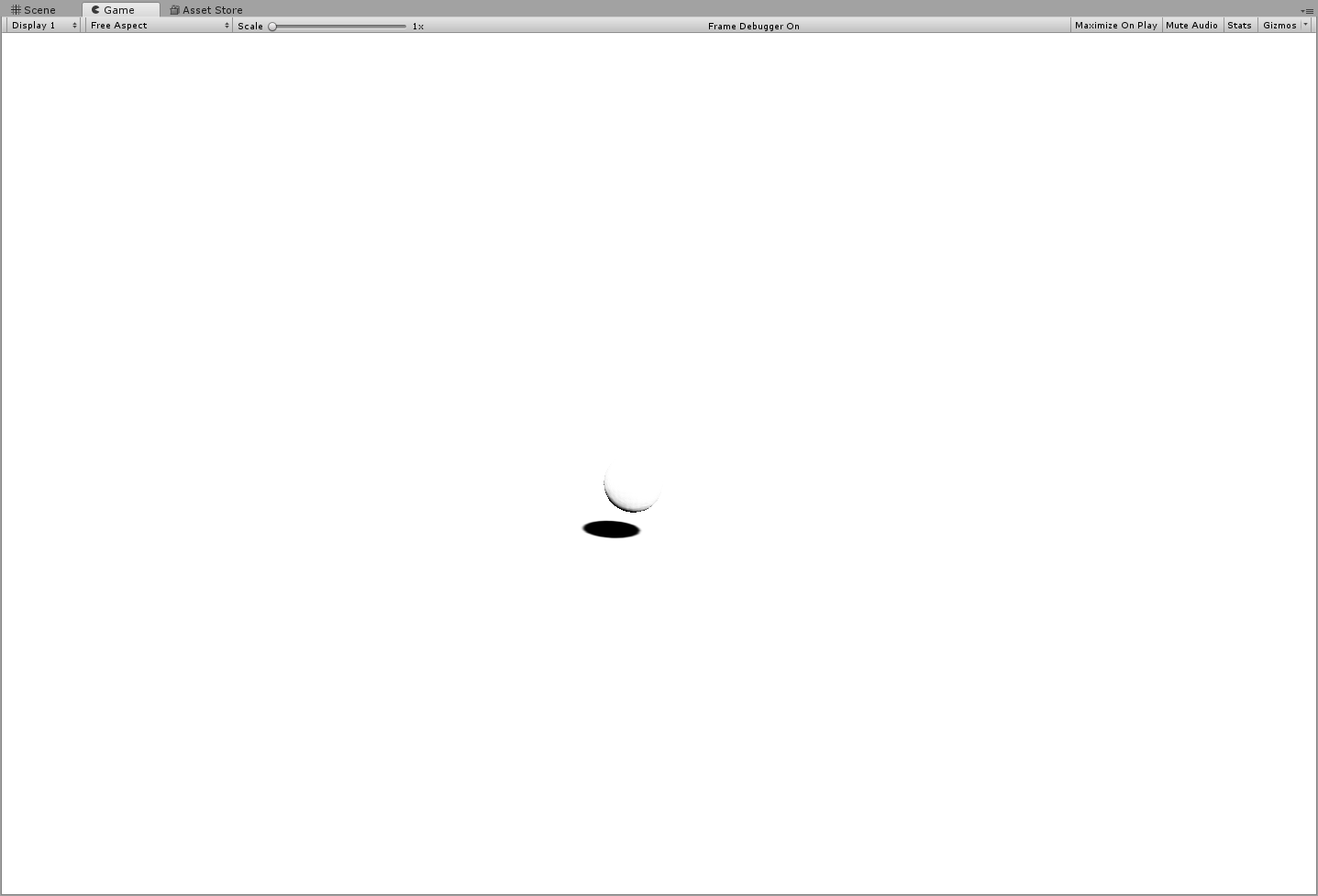

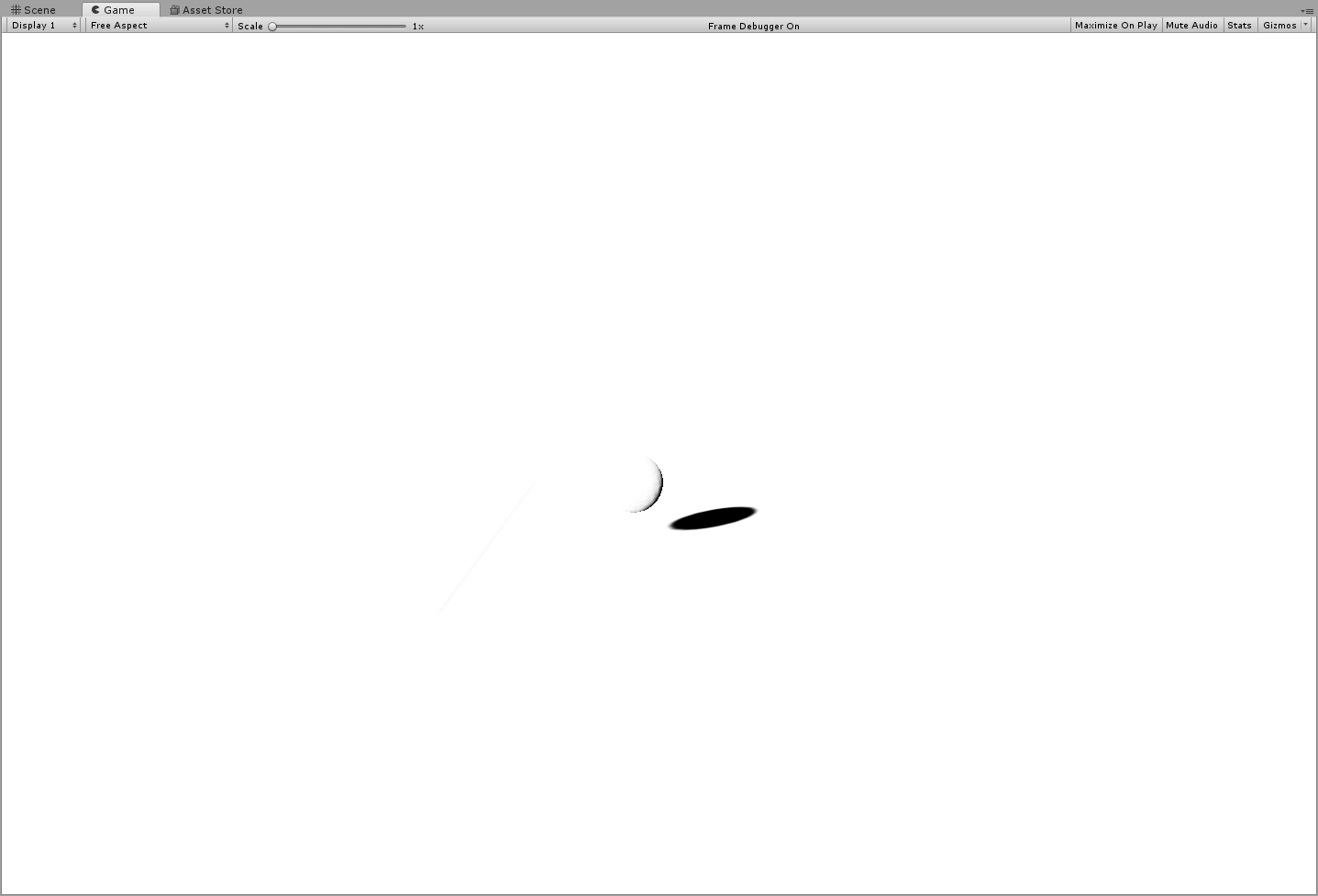

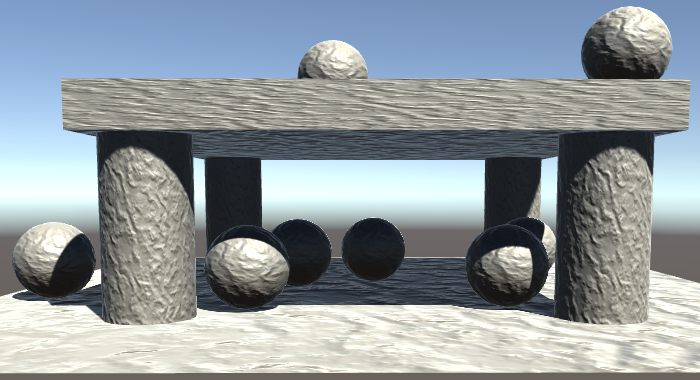

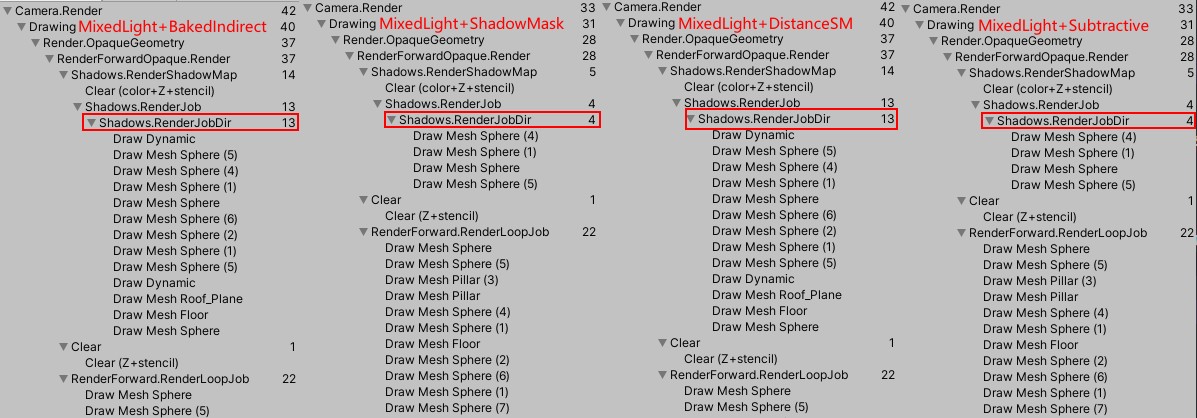

下图为两个方向光绘制场景时对应的 drawcall:

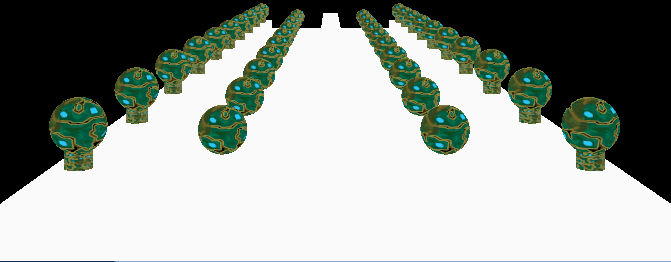

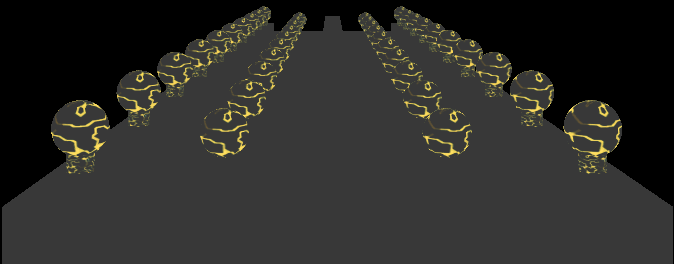

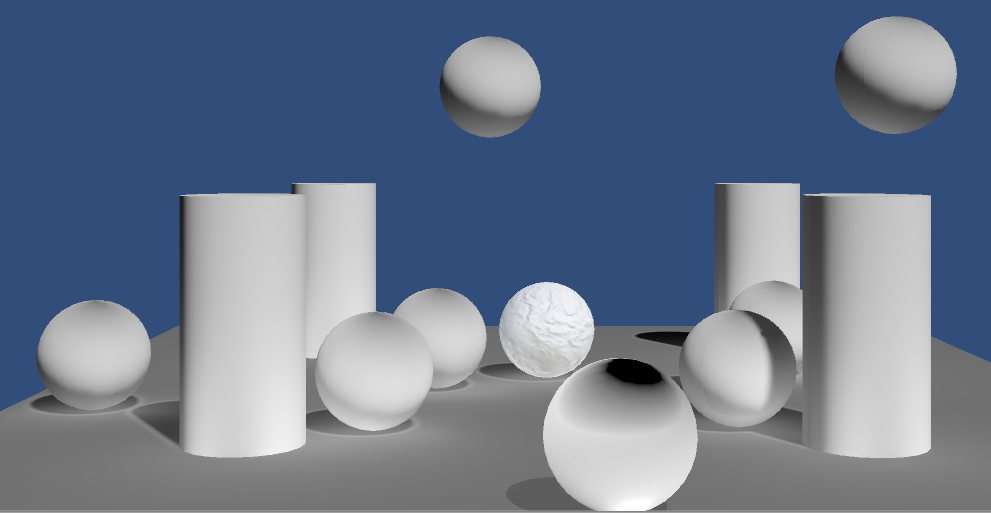

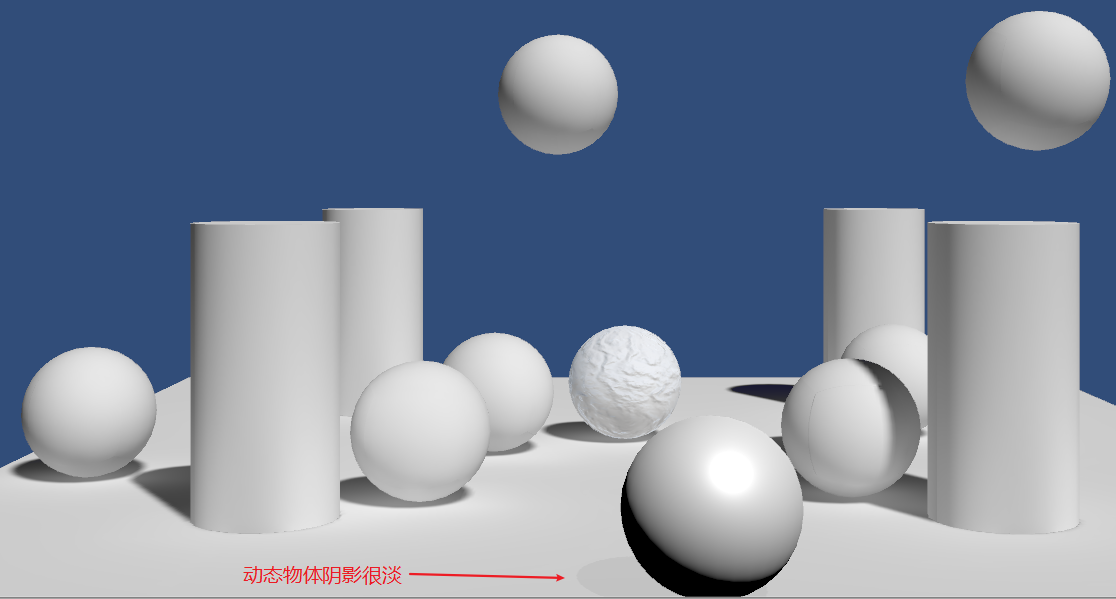

下图为绘制结果:

- 开启关闭的方法

- 关闭屏幕空间阴影

- ShadowQuality

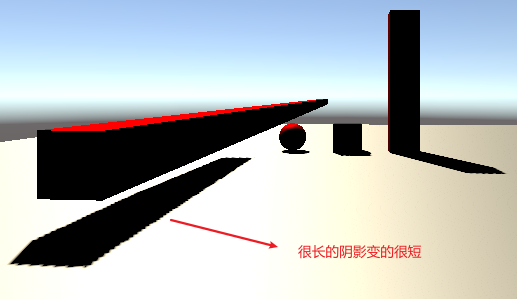

减低 ShadowDistance 可以提高阴影精度,但是会缩小阴影范围。

设置投影类型 QualitySettings.shadowProjection = ShadowProjection.CloseFit; 可以提高阴影精度。

开启 Cascade。

- ForwardAddPass 阴影支持

// 方案1 fwd pass 中添加如下命令 #pragma multi_compile_fwdadd_fullshadows // 方案2 // 2.1 fwd pass 中修改Tag // 2.2添加 DIRECTIONAL SHADOWS_SCREEN变体 Tags { "LightMode" = "ForwardAdd" "SHADOWSUPPORT"="true" } // ... #pragma multi_compile _ DIRECTIONAL #pragma multi_compile _ SHADOWS_SCREEN

- 参考资料

Spot Light Shadow

相关宏定义

| 宏定义 | DrawCall | 说明 |

|---|---|---|

| UNITY_NO_SCREENSPACE_SHADOWS | 开启屏幕空间阴影 | |

| SHADOWS_DEPTH | Shadows.RenderJob ShadowCaster | Directional 和 Spot 生成阴影贴图写入深度的宏定义 |

| SHADOWS_CUBE | Shadows.RenderJob ShadowCaster | PointLight 生成阴影贴图写入深度的宏定义 |

| SHADOWS_SCREEN | RenderForward ForwardBasePass | 主 Directional 开启阴影对应的宏定义 |

| SHADOWS_SCREEN DIRECTIONAL | RenderForward ForwardAddPass | 第二个 Directional 开启阴影对应的宏定义 |

| SHADOWS_DEPTH SPOT | RenderForward ForwardAddPass | Spot 开启阴影对应的宏定义 |

| SHADOWS_CUBE POINT | RenderForward ForwardAddPass | Point 开启阴影对应的宏定义 |

- DIRECTIONAL SPOT POINT 3 个对应 Light 组件上的 LightType 的设置

- SHADOWS_SCREEN SHADOWS_DEPTH SHADOWS_CUBE 对应物体 Renderer 组件上的 ReceiveShadow 设置

参考资料

- Signed Distance Field Shadow in Unity https://zhuanlan.zhihu.com/p/37918356

- Unity 平面阴影(王者荣耀阴影实现) https://zhuanlan.zhihu.com/p/42781261

Reflection

Environment Mapping

- 缺少 Indirect Specular Lighting

在 shader 中组合了 diffuse specular ambient 后,感觉应该可以创建出看上去真实的画面了,然而物体表面依然暗淡,闪耀的表面效果看起来不正确。闪耀的表面应该像镜子,特别是表面为金属时。(完美的镜面反射会反射所有光照,所以其不存在 diffuse.光滑度越高、金属度越高,材质越接近完美镜面。)

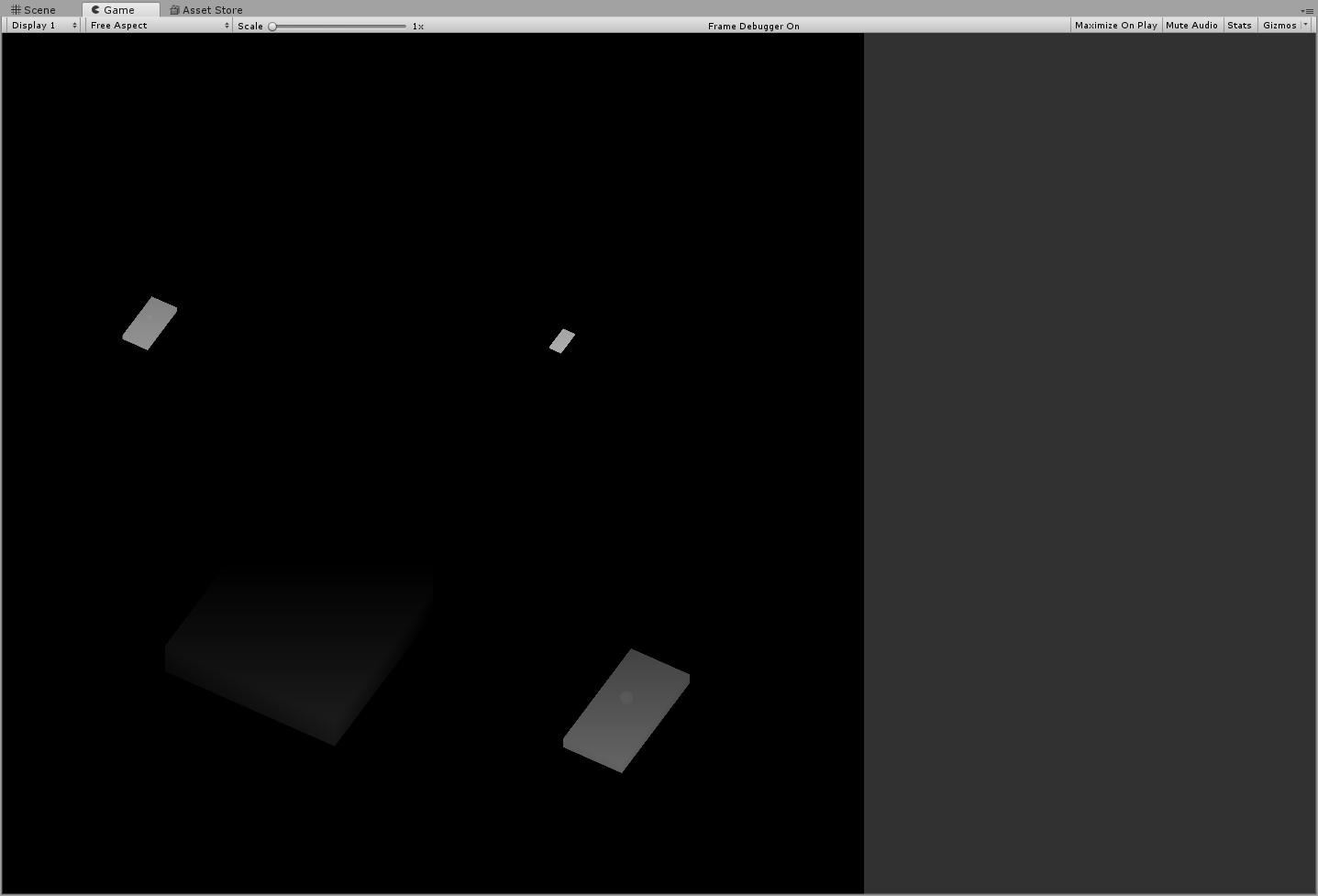

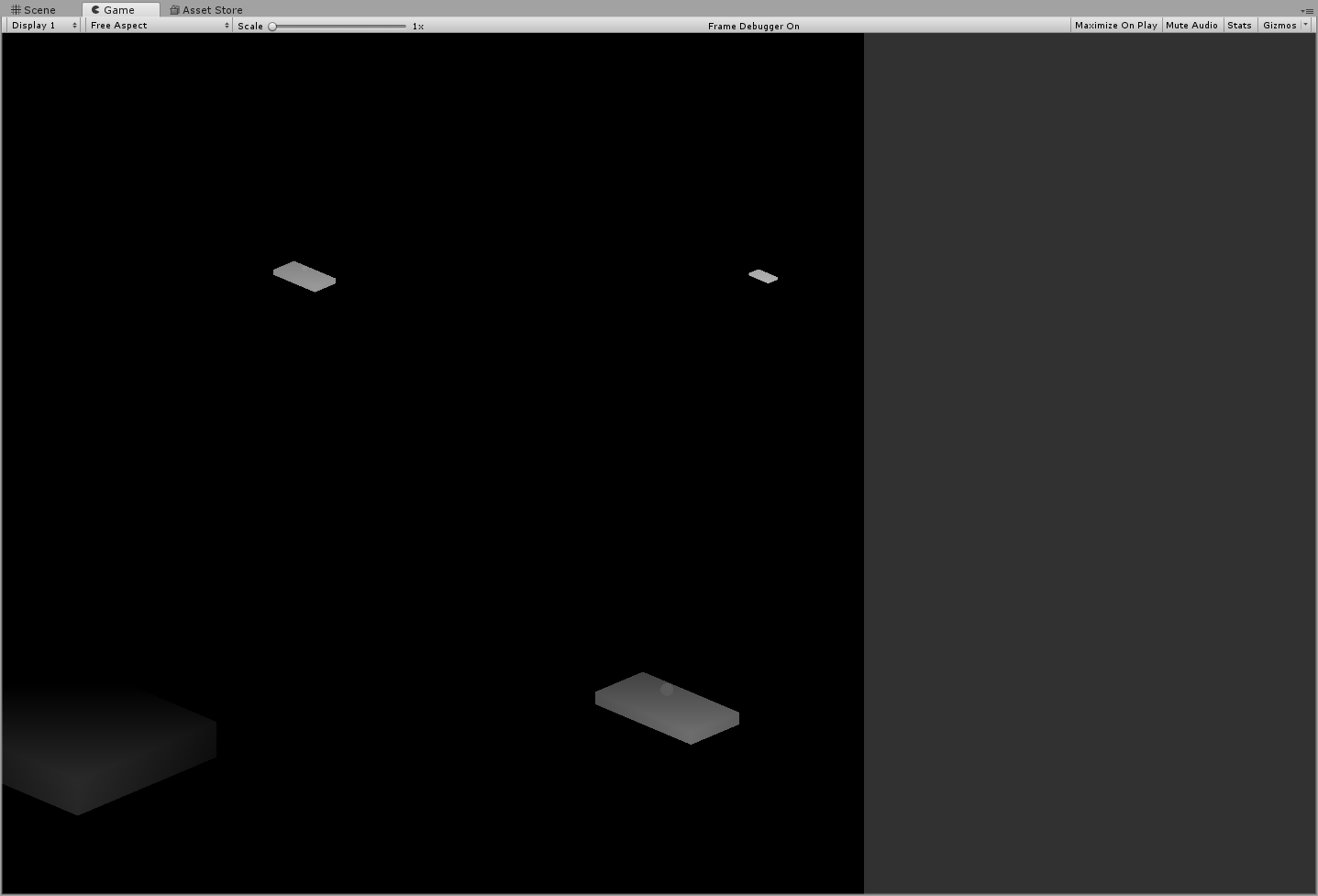

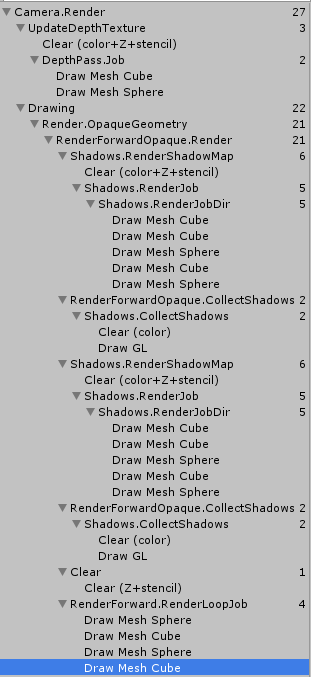

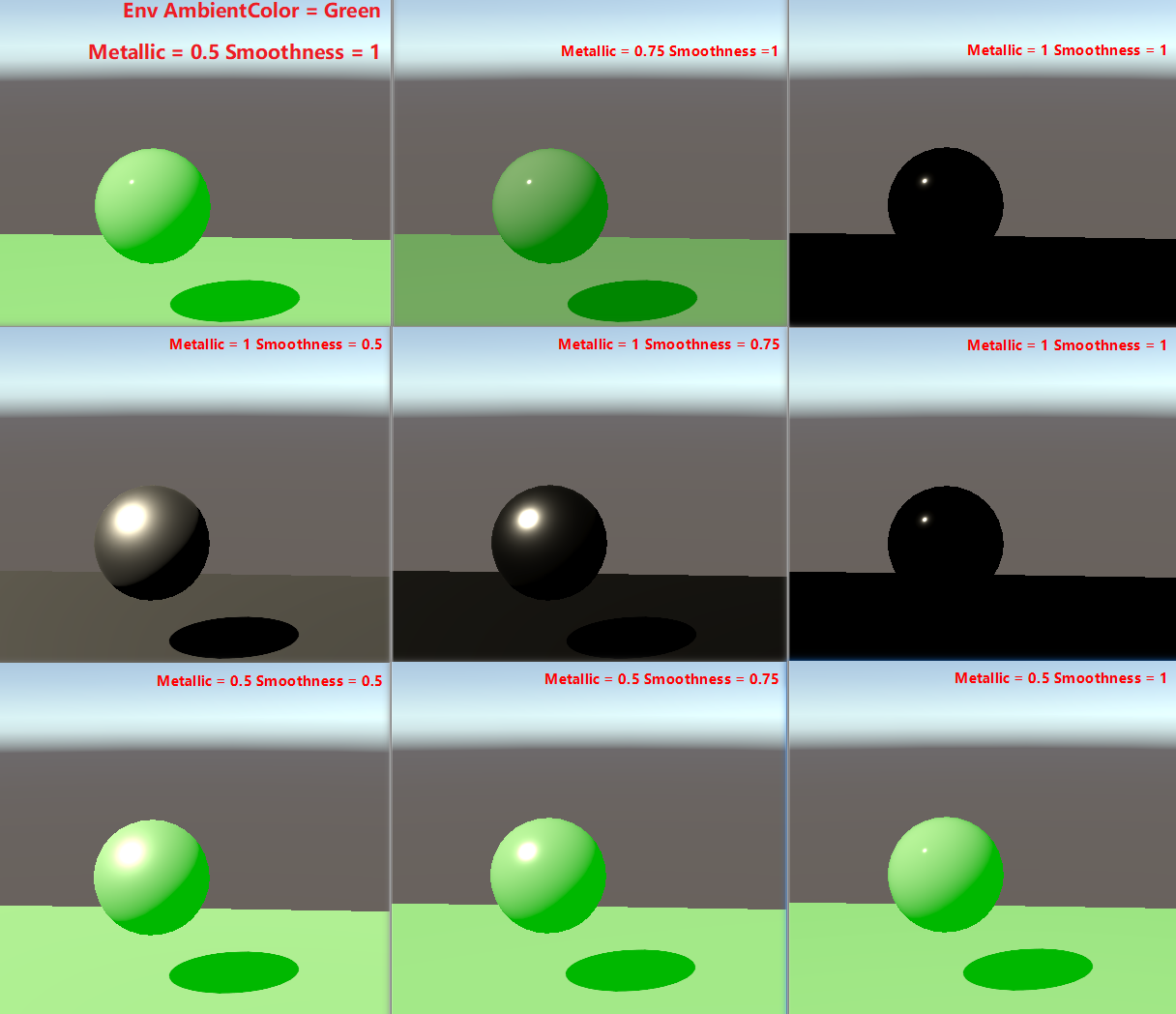

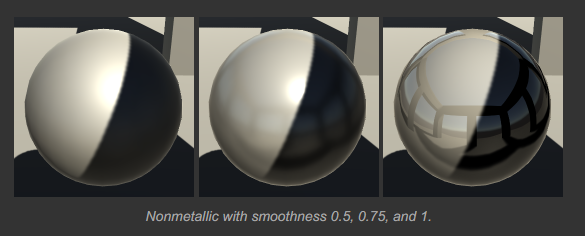

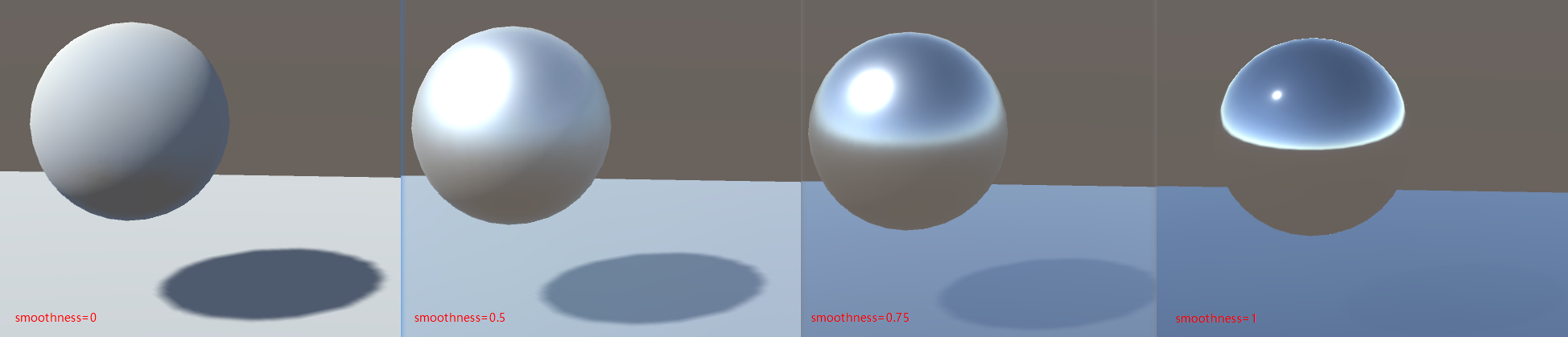

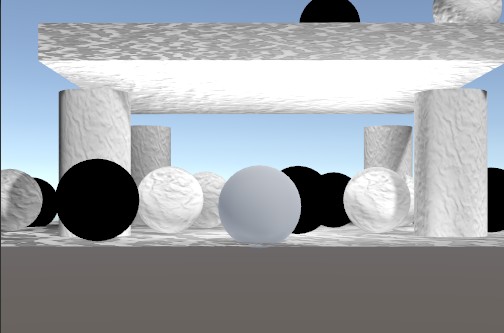

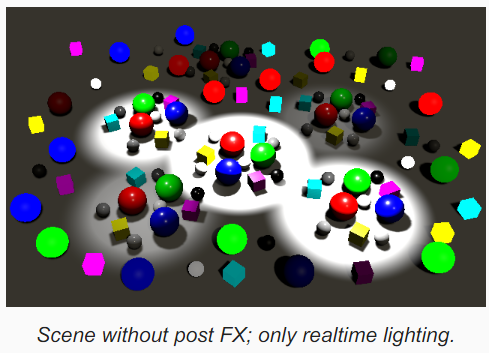

下图为 Metallic Smoothness 取不同值时的渲染效果:

上图 metallic=1 时,env ambient 几乎对渲染没有任何影响,这是因为金属度越高反射率越大,反射率越大其漫反射部分就越少(参考 PhysicalTheory.org 中 金属和非金属放射光的差异 的描述),所以 ambient 对于 metallic=1 的材质几乎没有任何影响。

上图 metallic=1 Smoothness=1 时,几乎是一个黑色的球,只能看到一个很小的高光,这个很小的高光是表面将直接光源反射到了朝向我们的方向(朝向摄像机的方向)。之所以渲染结果是黑球,是因为 shader 中只包含了直接光照和间接光照的 diffuse(也就是 ambient),为了反射环境,需要添加间接光照的高光反射,即 indirectLight.specular。

- Indirect Specular Lighting 特点

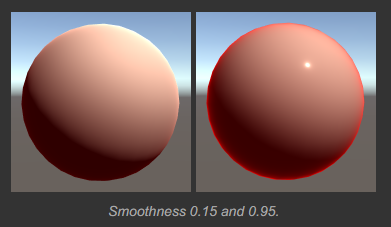

视线和法线夹角越大,Fresnel 反射越强。表面越光滑 Fresnel 反射越强。

因为 Fresnel 间接反射来源于间接光照(上图中直接光照颜色为白色,间接光照的高光直接设置为了红色),所以它产生的效果独立于直接光照,因此上图中即使处于阴影部分的边缘处 Fresnel 反射依然很强,其独立于直接光源的阴影。

UnityIndirect CreateIndirectLight (Interpolators i) { UnityIndirect indirectLight; indirectLight.diffuse = 0; indirectLight.specular = 0; #if defined(VERTEXLIGHT_ON) indirectLight.diffuse = i.vertexLightColor; #endif #if defined(FORWARD_BASE_PASS) indirectLight.diffuse += max(0, ShadeSH9(float4(i.normal, 1))); // 间接高光颜色设置为了红色 indirectLight.specular = float3(1, 0, 0); #endif return indirectLight; }

Imperfect Reflections

模糊的反射是通过环境贴图的 mipmap 来实现的。

- Metals VS Nonmetals

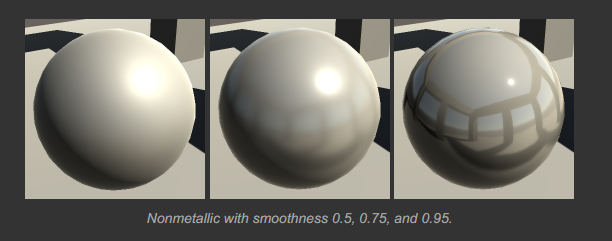

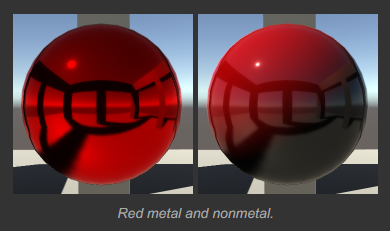

金属和非金属表面都可以产生清晰的反射,但是他们看起来是不同的。镜面反射在闪耀的电介质材质(非金属)上效果会很强,但是镜面反射并不会主导电介质材质(非金属)的外观,他们仍然表现出大量的可见的 diffuse 反射。

金属会改变镜面反射的颜色,但是非金属则不会。这对于镜面高光和环境镜面反射都适用。下图中金属的镜面高光颜色为红色,非金属是白色。

- Mirrors and Shadows

间接反射是独立于表面的直接照明的。这在其阴影区域会更加明显。对于非金属,这会让表面更亮一些,你依然可以看到直接光照导致的阴影。

同样的规则适用于金属。但是,金属的间接反射起主导作用。因此,直接光照和阴影会随着光泽度增加而消失。完美镜面上不存在阴影。

现实世界中很少有完美的镜面。现实世界中的材质都是由金属和非金属混合而成的,可以通过调节金属度来模拟不完美的镜面材质。

Box Projection

ReflectionProbe 的 Box 区域是和世界坐标轴对齐的,它不受旋转和缩放影响。

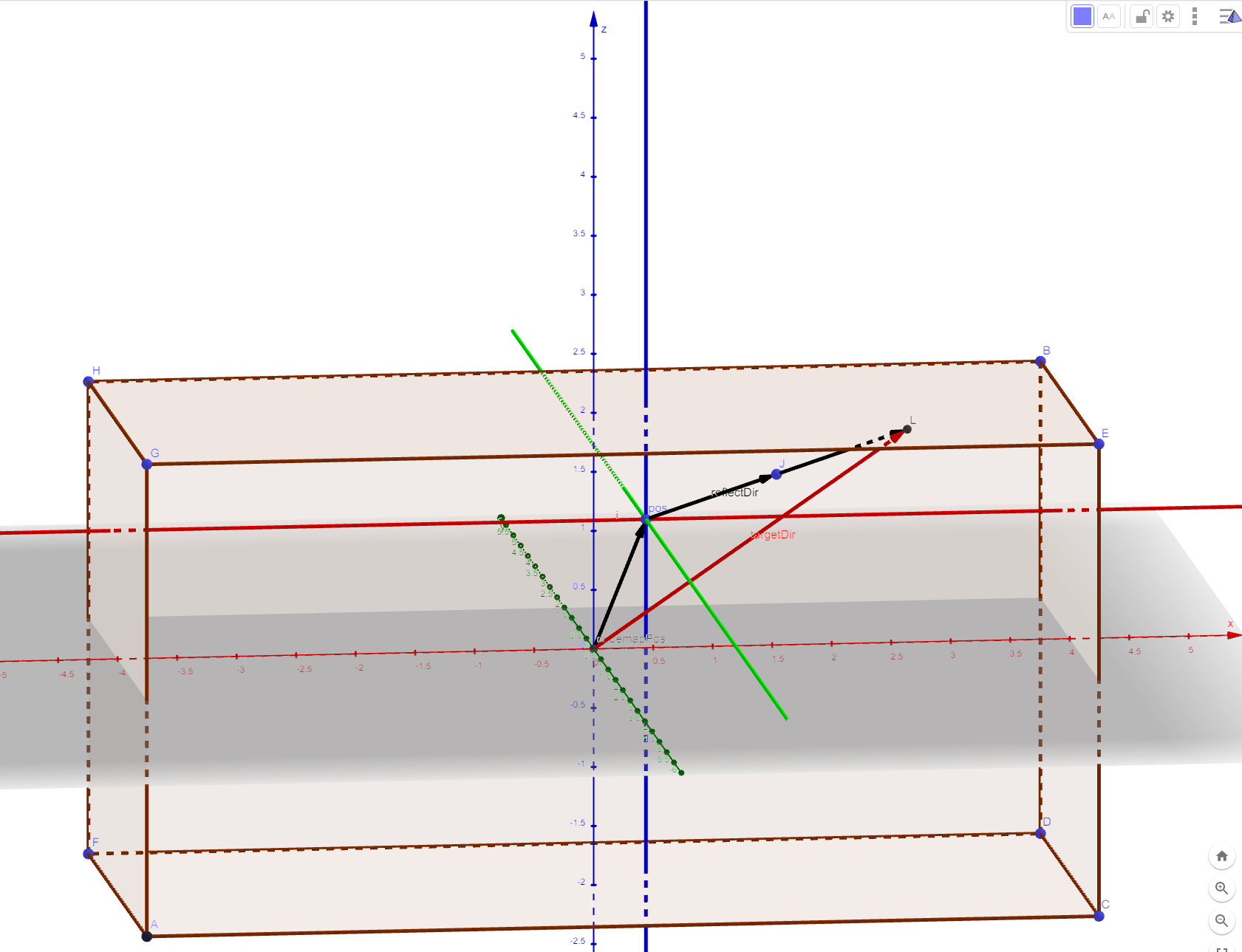

BoxProjection 原理如下图所示:

./UnityCatLikeCoding/01_08re_box_projection.ggb

BoxProjection 对应代码实现如下:

half3 BoxProjection(half3 dir, half3 pos, half4 cubemapPos, half3 boxMin, half3 boxMax) { // cubemapPos.w 控制 BoxProjection 是否生效 // UNITY_BRANCH 用于开启真正的分支 UNITY_BRANCH if (cubemapPos.w > 0) { half3 factors = ((dir > 0 ? boxMax : boxMin) - pos) / dir; half realFactor = min(min(factors.x, factors.y), factors.z); return dir * realFactor + (pos - cubemapPos); } return dir; }

- 关于 UNITY_BRANCH https://forum.unity.com/threads/correct-use-of-unity_branch.476804/

- HLSL branch flatten https://docs.microsoft.com/zh-cn/windows/win32/direct3dhlsl/dx-graphics-hlsl-if

Blending Reflection Probes

只有将 Renderer 的 reflectionProbeUsage 属性设置为 BlendProbesAndSkybox 时,反射探针才会和 Skybox 进行混合

public enum ReflectionProbeUsage { Off = 0, // 关闭反射探针 BlendProbes = 1, // 反射探针只和反射探针进行混合 BlendProbesAndSkybox = 2, // 反射探针可以和 skybox 进行混合 Simple = 3 // 只使用其中一个反射探针或 skybox,不进行混合 }

// 混合反射探针的逻辑 UnityIndirect CreateIndirect(v2f i, half3 viewDir) { UnityIndirect indirect; indirect.diffuse = 0; indirect.specular = 0; #if defined(FORWARD_BASE_PASS) indirect.diffuse += max(0, ShadeSH9(half4(i.worldNormal, 1))); half roughness = 1 - _Smoothness; roughness *= 1.7 - 0.7 * roughness; half3 reflectDir = reflect(-viewDir, i.worldNormal); half3 reflectDir1 = BoxProjection(reflectDir, i.worldPos, unity_SpecCube0_ProbePosition, unity_SpecCube0_BoxMin, unity_SpecCube0_BoxMax); half4 envColor = UNITY_SAMPLE_TEXCUBE_LOD(unity_SpecCube0, reflectDir1, roughness*UNITY_SPECCUBE_LOD_STEPS); envColor.rgb = DecodeHDR(envColor, unity_SpecCube0_HDR); UNITY_BRANCH if (unity_SpecCube0_BoxMin.a < 0.9999) { half3 reflectDir2 = BoxProjection(reflectDir, i.worldPos, unity_SpecCube1_ProbePosition, unity_SpecCube1_BoxMin, unity_SpecCube1_BoxMax); half4 envColor2 = UNITY_SAMPLE_TEXCUBE_SAMPLER_LOD(unity_SpecCube1, unity_SpecCube0, reflectDir2, roughness*UNITY_SPECCUBE_LOD_STEPS); // DecodeHDR 中代码处理了 intensity 逻辑 envColor2.rgb = DecodeHDR(envColor2, unity_SpecCube1_HDR); envColor = lerp(envColor2, envColor, unity_SpecCube0_BoxMin.a); } //indirect.specular = half3(1, 0, 0); indirect.specular = envColor.rgb; #endif return indirect; }

下面着重列出 Reflection CubeMap 的采样

// Step 1 // MetallicSetup half smoothness = metallicGloss.y; // this is 1 minus the square root of real roughness m. // SpecularSetup half smoothness = specGloss.a; // Step 2 perceptualRoughness = 1 - smoothness // Step 3 indirectSpecular = Unity_GlossyEnvironment (UNITY_PASS_TEXCUBE(unity_SpecCube0), data.probeHDR[0], glossIn); // Unity_GlossyEnvironment builtin_shaders/CGIncludes/UnityImageBasedLighting.cginc half3 Unity_GlossyEnvironment (UNITY_ARGS_TEXCUBE(tex), half4 hdr, Unity_GlossyEnvironmentData glossIn) { half perceptualRoughness = glossIn.roughness /* perceptualRoughness */ ; // TODO: CAUTION: remap from Morten may work only with offline convolution, see impact with runtime convolution! // For now disabled #if 0 float m = PerceptualRoughnessToRoughness(perceptualRoughness); // m is the real roughness parameter // smallest such that 1.0+FLT_EPSILON != 1.0 (+1e-4h is NOT good here. is visibly very wrong) const float fEps = 1.192092896e-07F; // remap to spec power. See eq. 21 in --> http://jbit.net/~sparky/academic/mm_brdf.pdf // <<Microfacet Based Bidirectional Reflectance Distribution Function>> // 阿里云备份 float n = (2.0/max(fEps, m*m))-2.0; // remap from n_dot_h formulatino to n_dot_r. See section "Pre-convolved Cube Maps vs Path Tracers" // --> https://s3.amazonaws.com/docs.knaldtech.com/knald/1.0.0/lys_power_drops.html // 有道云备份 <<Power Drops Within Lys>> n /= 4; // remap back to square root of real roughness (0.25 include both the sqrt root of the conversion and sqrt for going from roughness to perceptualRoughness) perceptualRoughness = pow( 2/(n+2), 0.25); #else // MM: came up with a surprisingly close approximation to what the #if 0'ed out code above does. perceptualRoughness = perceptualRoughness*(1.7 - 0.7*perceptualRoughness); #endif half mip = perceptualRoughnessToMipmapLevel(perceptualRoughness); half3 R = glossIn.reflUVW; half4 rgbm = UNITY_SAMPLE_TEXCUBE_LOD(tex, R, mip); return DecodeHDR(rgbm, hdr, isGammaSpace ? 1 : 0); } define UNITY_SPECCUBE_LOD_STEPS (6) half perceptualRoughnessToMipmapLevel(half perceptualRoughness) { return perceptualRoughness * UNITY_SPECCUBE_LOD_STEPS; } // Decodes HDR textures // handles dLDR, RGBM formats inline half3 DecodeHDR(half4 data, half4 decodeInstructions, int colorspaceIsGamma) { // Take into account texture alpha if decodeInstructions.w is true(the alpha value affects the RGB channels) half alpha = decodeInstructions.w * (data.a - 1.0) + 1.0; // If Linear mode is not supported we can skip exponent part if(colorspaceIsGamma) return (decodeInstructions.x * alpha) * data.rgb; return (decodeInstructions.x * pow(alpha, decodeInstructions.y)) * data.rgb; }

Bouncing Reflections

Lighting/Scene 下的数据记录在当前打开的场景文件中,每个场景的数据可以不同。

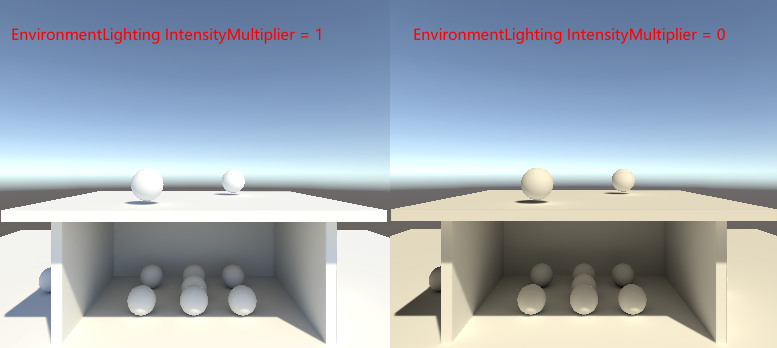

EnvironmentLighting/Source 指定天空球作为环境光来源,还是自定义环境光来源。

EnvironmentLighting/IntensityMultiplier 当 EnvironmentLighting/Source 为 Skybox 时,该调节项控制天空球光照亮度.

EnvironmentReflections/Source 指定使用天空球作为环境反射源,还是自定义环境反射源。

EnvironmentReflections/IntensityMultiplier 控制反射源在场景中提供反射的因子,值为 1 时符合物理规律。

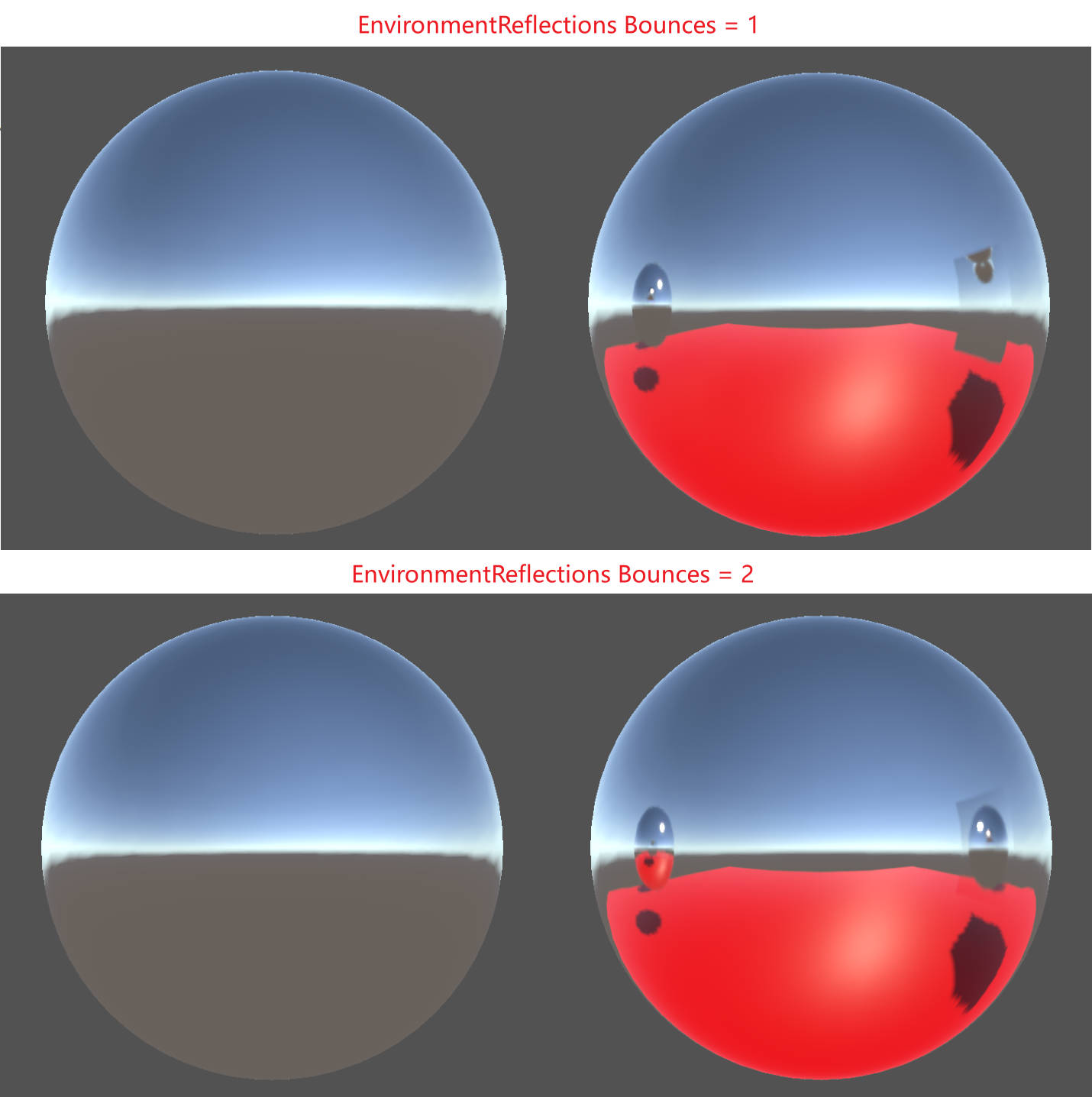

EnvironmentReflections/Bounces 指定烘培反射 Probe 时,光线弹射次数

Tips:

EnvironmentReflections/Bounces 对 EnvCubeMap 的烘培没有影响,但对 Refelction Probe 的烘培有影响。如下图所示,bounces 为 2 时,ReflectionCubeMap 中的球体反射了地面的红色。

ComplexMaterials & More Complexity

Emission

Unity HDR Color 的计算逻辑如下:

[Serializefield] private Color _emissionColorValue; [Serializefield] private float _intensity; mat.SetVector("_EmissionColor", _emissionColorValue * Mathf.Pow(2, _intensity));

Shader 中实现 Emission 的方法:

[NoScaleOffset] _EmissionMap ("Emission", 2D) = "black" {} [HDR]_Emission ("Emission", Color) = (0, 0, 0) #pragma shader_feature _EMISSION_MAP sampler2D _EmissionMap; float3 _Emission; float3 GetEmission (Interpolators i) { #if defined(FORWARD_BASE_PASS) #if defined(_EMISSION_MAP) return tex2D(_EmissionMap, i.uv.xy) * _Emission; #else return _Emission; #endif #else return 0; #endif } float4 MyFragmentProgram (Interpolators i) : SV_TARGET { //… float4 color = UNITY_BRDF_PBS( albedo, specularTint, oneMinusReflectivity, GetSmoothness(i), i.normal, viewDir, CreateLight(i), CreateIndirectLight(i, viewDir) ); color.rgb += GetEmission(i); return color; }

Smoothness & Metallic Map

将 MetallicMap 和 SmoothnessMap 存储到一张 DXT5 格式的贴图中 ,Metallic Map 放到贴图 r 通道, Smoothness Map 放到贴图 a 通道。等价于使用两张 DXT1 格式贴图分别存储。因为 DXT5 分开对 RGB 和 A 通道进行压缩。

Occlusion

[NoScaleOffset] _OcclusionMap ("Occlusion", 2D) = "white" {} _OcclusionStrength("Occlusion Strength", Range(0, 1)) = 1 #pragma shader_feature _OCCLUSION_MAP sampler2D _OcclusionMap; float _OcclusionStrength; float GetOcclusion (Interpolators i) { #if defined(_OCCLUSION_MAP) return lerp(1, tex2D(_OcclusionMap, i.uv.xy).g, _OcclusionStrength); #else return 1; #endif } // Occlusion 同时影响直接光照阴影和间接光照阴影时,Occlusion效果会过强 // 因为Occlusion是基于物体形状的而不是特定光照的,其只影响间接光照会更合理一些。凹痕越深的地方,各个方向的间接光照减弱越多,而直接光照照进凹痕时,还是可以加将其照亮。 UnityLight CreateLight (Interpolators i) { //… UNITY_LIGHT_ATTENUATION(attenuation, i, i.worldPos); // 通过将Occlusion和atten相乘来影响直接光照阴影 attenuation *= GetOcclusion(i); light.color = _LightColor0.rgb * attenuation; light.ndotl = DotClamped(i.normal, light.dir); return light; } UnityIndirect CreateIndirectLight (Interpolators i, float3 viewDir) { //… #if defined(FORWARD_BASE_PASS) //… float occlusion = GetOcclusion(i); // 通过将Occlusion和间接光照的diffuse、specular相乘来影响间接光照阴影 indirectLight.diffuse *= occlusion; indirectLight.specular *= occlusion; #endif return indirectLight; }

Transparency

Cutout

- clip 操作对于移动平台的 TBDR 来说消耗比较大,通过添加 _RENDERING_CUTOUT ShaderFeature,对于不需要 clip 的材质可以提升渲染性能。

- 修改 cutout 材质的渲染队列,让其在不透明(Opaque)物体之后绘制,这样如果 cutout 材质对应的物体被不透明物体遮挡了,就可以避免对 cutout 物体的绘制,从而提高性能。

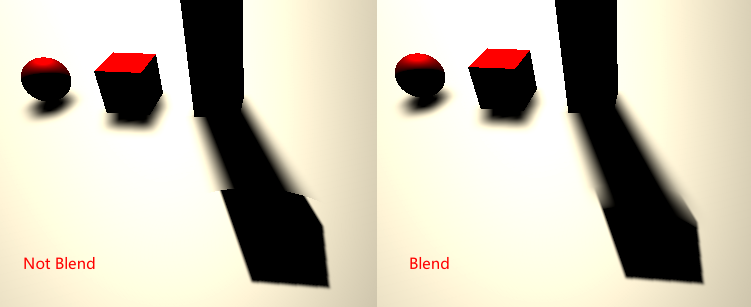

Semitransparent

- 半透明物体需要采用 Blend SrcAlpha OneMinusSrcAlpha 的混合方式,这样才能将半透明物体后面的物体透出来。

- 半透明物体不能写深度缓冲区,否则半透明物体叠加在一起时,深度测试会剔除掉物体的一部分,导致渲染结果不正确。

RenderType tag

下面是 Unity 内置 shader 的 Shader replacement tags, 在使用替换的 shader 进行渲染时,需要使用为 shader 设置的"RenderType" tag。

- Opaque: most of the shaders (Normal , Self Illuminated, Reflective, terrain shaders).

- Transparent: most semitransparent shaders (Transparent, Particle, Font, terrain additive pass shaders).

- TransparentCutout: masked transparency shaders (Transparent Cutout, two pass vegetation shaders).

- Background: Skybox shaders.

- Overlay: GUITexture, Halo, Flare shaders.

- TreeOpaque: terrain engine tree bark.

- TreeTransparentCutout: terrain engine tree leaves.

- TreeBillboard: terrain engine billboarded trees.

- Grass: terrain engine grass.

- GrassBillboard: terrain engine billboarded grass.

Fading vs Transparency

- Fade Mode

Fade Mode 中,使用的混合模式为 Blend SrcAlpha OneMinusSrcAlpha,几何体的颜色会依据 alpha 值降隐,漫反射和高光反射都会降隐。这种效果对于玻璃是不合适的,玻璃是全透明的,但是依然有清晰的高光和反射。 Transparent Mode

Transparent Mode 中,使用的混合模式为 Blend One OneMinusSrcAlpha, albedo 会乘 alpha 值,因此漫反射会根据 alpha 值降隐,高光反射会影响到透明度。这种模式适用于玻璃。

光线被反射后,透过半透明物体的光线会对应减少,如果所有光线都被反射,则不透明度为 1,如果没有光线被反射,则不透明度为原始值。y=kx+b 两个方程两个未知数,即可求出最终的 alpha 值。

k * Reflectivity + b = newAlpha

光线都被反射: Reflectivity=1 newAlpha=1 k*1 + b = 1 k=1-b

光线没被反射: Reflectivity=0 newAlpha=oldAlpha k*0 + b = oldAplha b=oldAlpha

newAlpha = (1-oldAlpha) * Reflectivity + oldAlpha

= Reflectivity - oldAlpha*Reflectivity + oldAlpha

= Reflectivity + oldAlpha*(1 - Reflectivity)

= oneMinusReflectivity + oldAlpha*oneMinusReflectivity

#if defined(_RENDERING_TRANSPARENT) albedo *= alpha; alpha = 1 - oneMinusReflectivity + alpha * oneMinusReflectivity; #endif

Semitransparent Shadows

Cutout Shadow

透贴的阴影只需要在 ShadowCaster Pass 的片段着色器中使用 clip(alpha - _Cutoff)指令将对应的片段剔除就可以了。

Transparenct Shadow

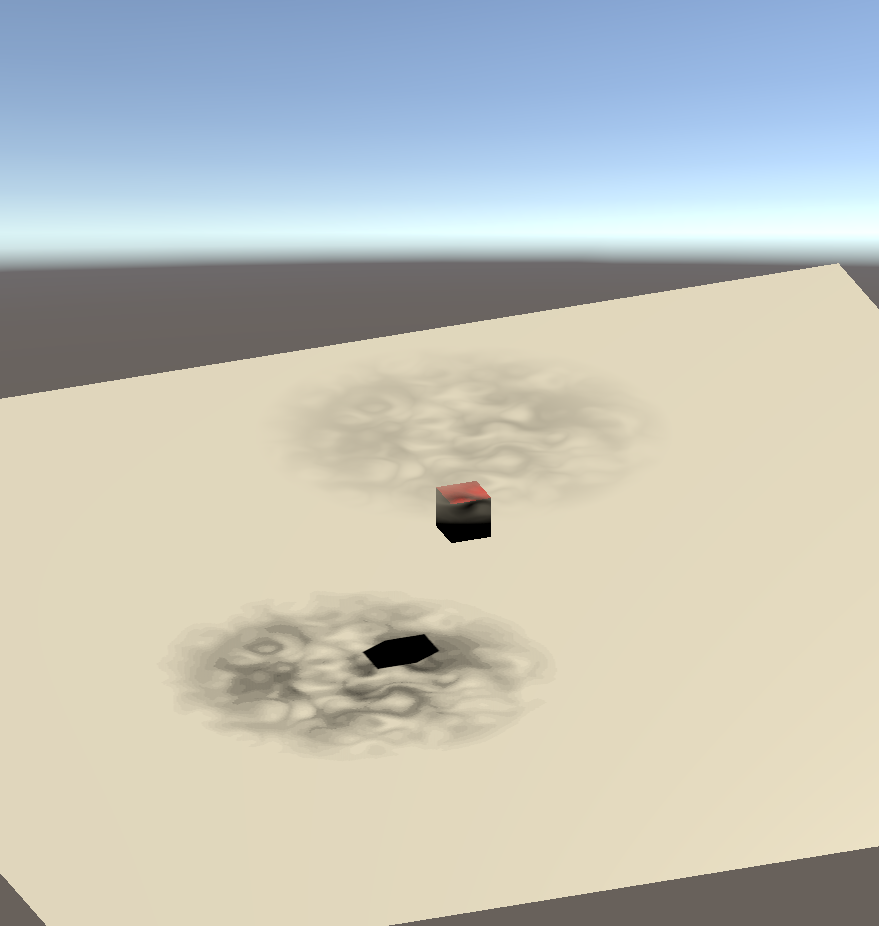

使用 Dithering 技术来实现半透明阴影。依据 alpha 值 clip 投影表面,从而模拟出半透明阴影。下图为使用这种技术实现的阴影效果:

_DitherMaskLOD Unity 使用的 Dither 贴图的模式如下,其一共包含 16 种模式,每个模式中的小像素块是 4x4 的像素块。开始是一个全空的模式(下图最右边),依次向左每个模式填充一个像素块,直到模式中有 7 个像素块被填充。然后图案翻转,直到所有像素被填充。

// 采样 _DitherMaskLOD 用到的uv.z的范围为[0, 1] 因为一共有16种模式,所以uv.z = 0 对应第一种模式uv.z = 1.0/16.0 = 0.0625 对应第二种模式 uv.z = 0.9375 对应第15中模式 // alpha*0.9375 当alpha越小选取的模式越靠右边,取样得到的dither值为0的概率越大,当alpha越大选取的模式越靠左边,取样得到的dither值为1的概率越大,从而模拟了半透明的阴影 float3 uv = float3(i.vpos.xy, alpha*0.9375); float dither = tex3D(_DitherMaskLOD, uv); clip(dither - 0.01);

Deferred Shading

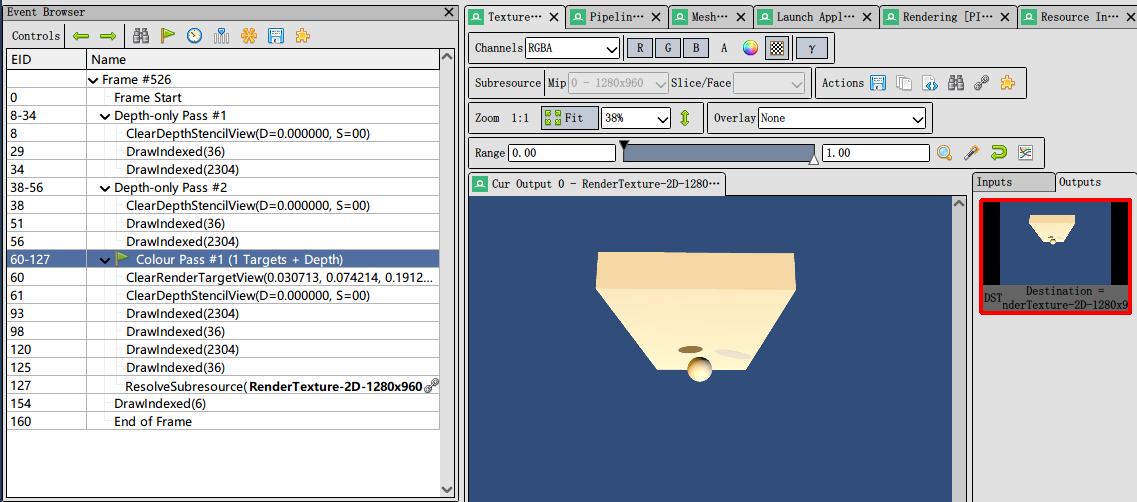

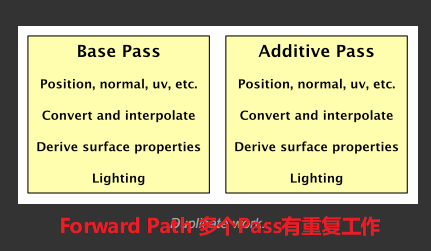

Forward Path vs Deferred Path

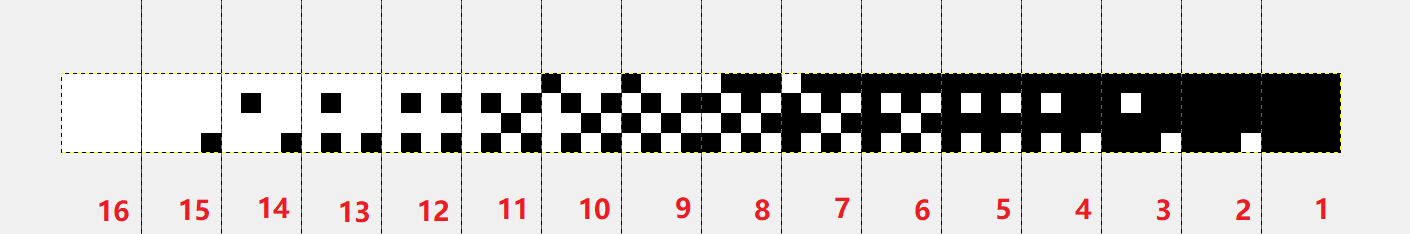

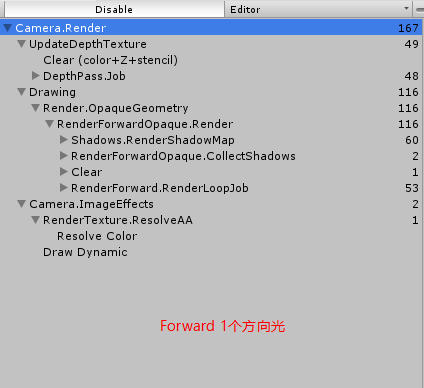

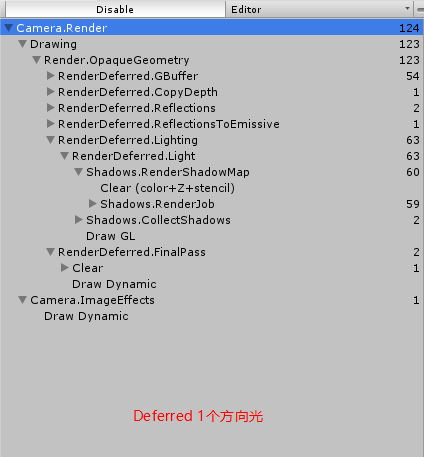

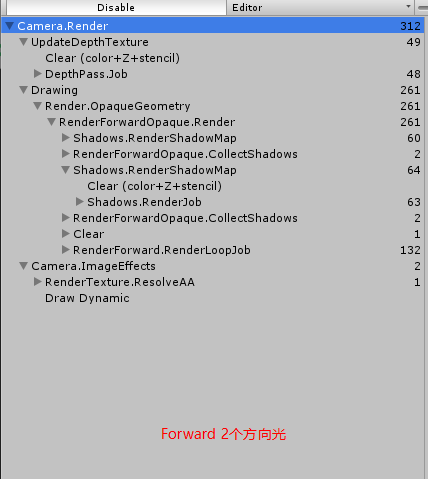

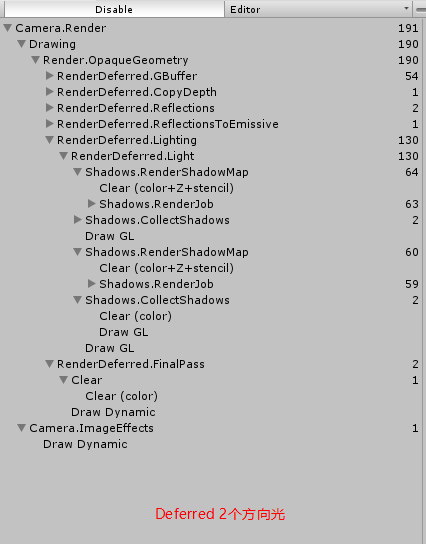

- DrawCall 对比

当场景中只有一个方向光时,Forward Path 和 Deferred Path 的 DrawCall 数目相差不多,Forward Path 因为需要单独生成 DepthTexture,在开始的 DepthPass 中多出了 48 个 DrawCall

场景中有两个方向光时,Forward Path 比 Deferred Path 多出了很多 DrawCall。

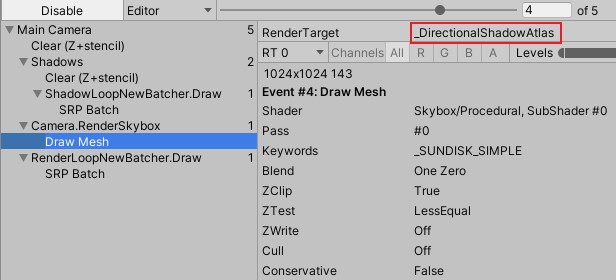

- GBuffer 内容

- Rendering Lights

- Directional Lights

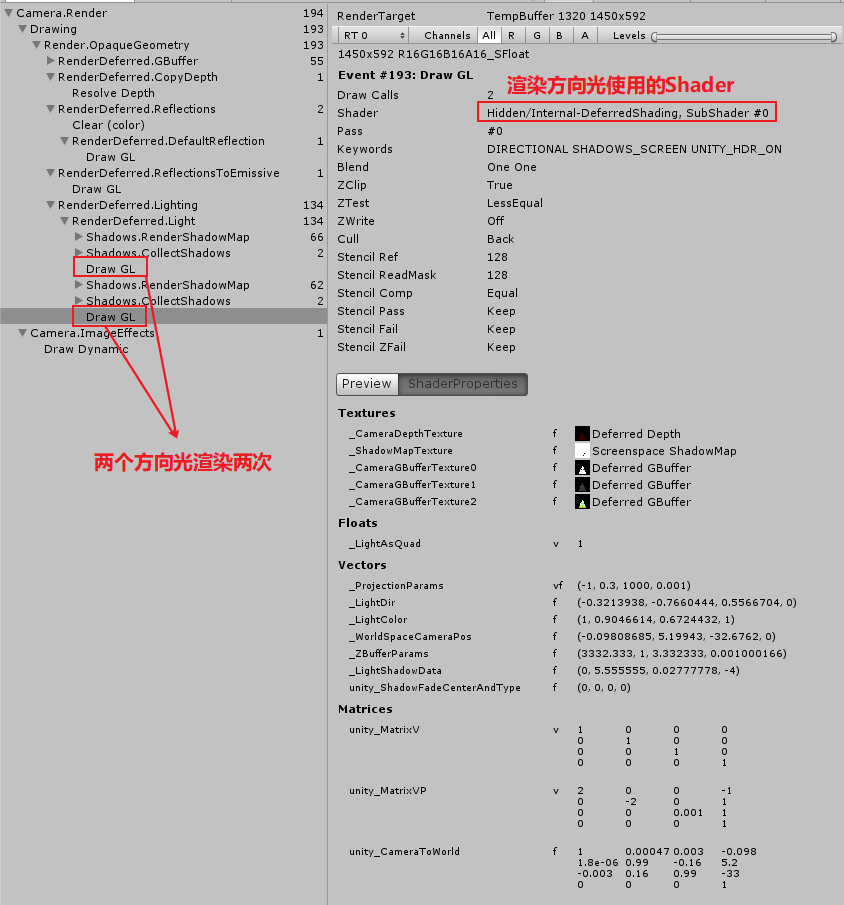

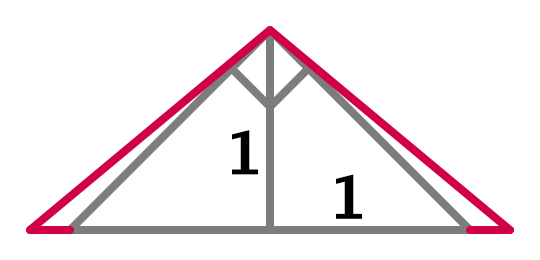

因为方向光影响所有物体,通过渲染一个覆盖整个视图的四边形来计算方向光的渲染。Unity 默认使用 Internal-DeferredShading.shader 来渲染这个四边形。(每个方向光使用一个四边形计算一次,多个方向光计算多次)

下图中使用了两个方向光,其中渲染了两次:

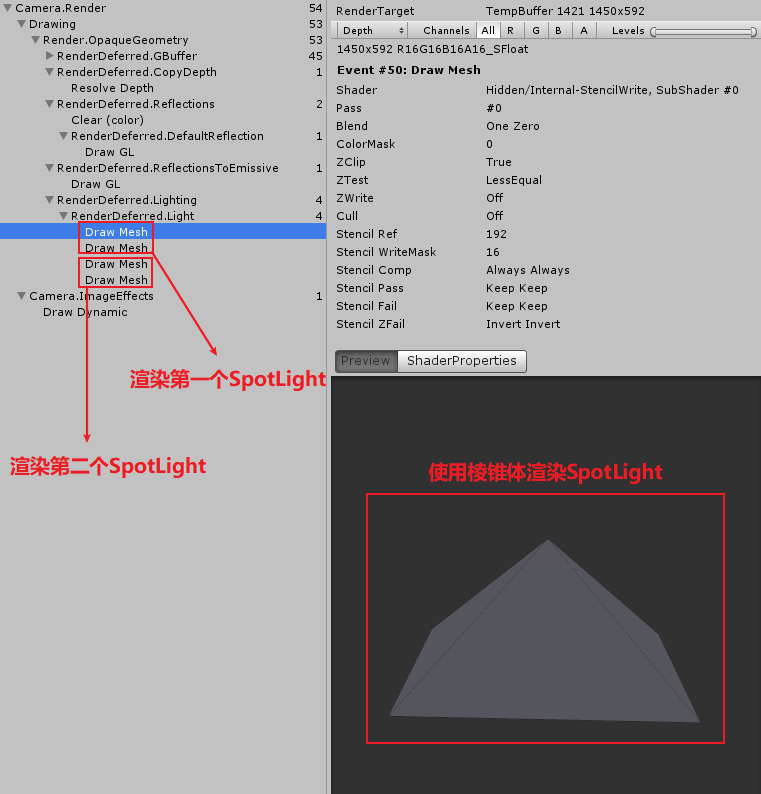

- Spot Lights

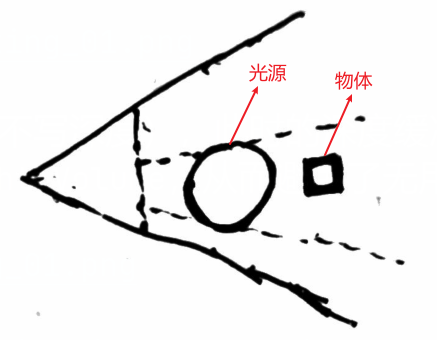

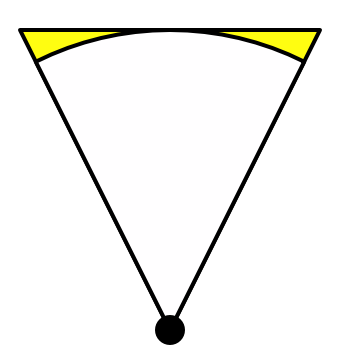

spot light 不会影响所有物体,使用一个棱锥体可以表示 Spot light 照亮的体积,所以通过渲染一个棱锥体来执行 Spot Light 的渲染,这样只有棱锥体可见区域会被渲染。如果棱锥体完全被其他物体遮挡,则不需要渲染该 spot light。如果棱锥体的任何一个片段被渲染,将会执行该 spot light 的光照计算。

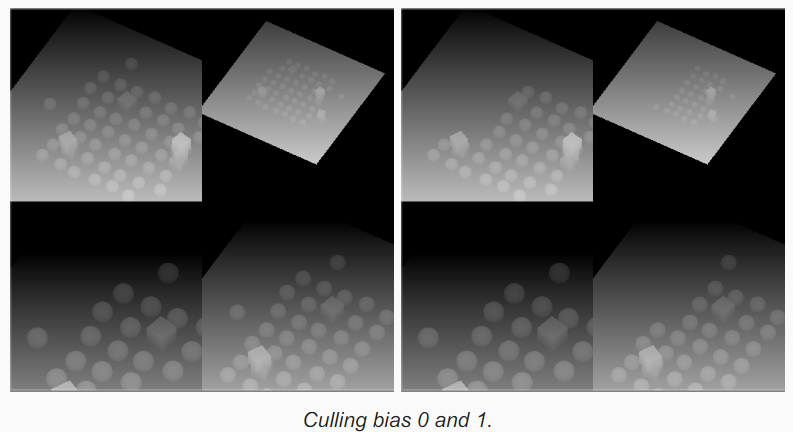

只有真的有物体在 spot light 照亮的体积中时,光照计算才是有意义的。在棱锥体后面的几何体是不需要渲染的,因为 spot light 照不到该几何体。

为了避免渲染不必要的片段,首先使用 Internal-StencilWrite.shader 渲染棱锥体,该 Pass 会写入模板缓冲区,用来标识哪些片段需要渲染。不过当棱锥体和摄像机近平面交叉时不能使用该技术,因为此时近平面外的正面被摄像机剔除,只有反面写入了模板值。

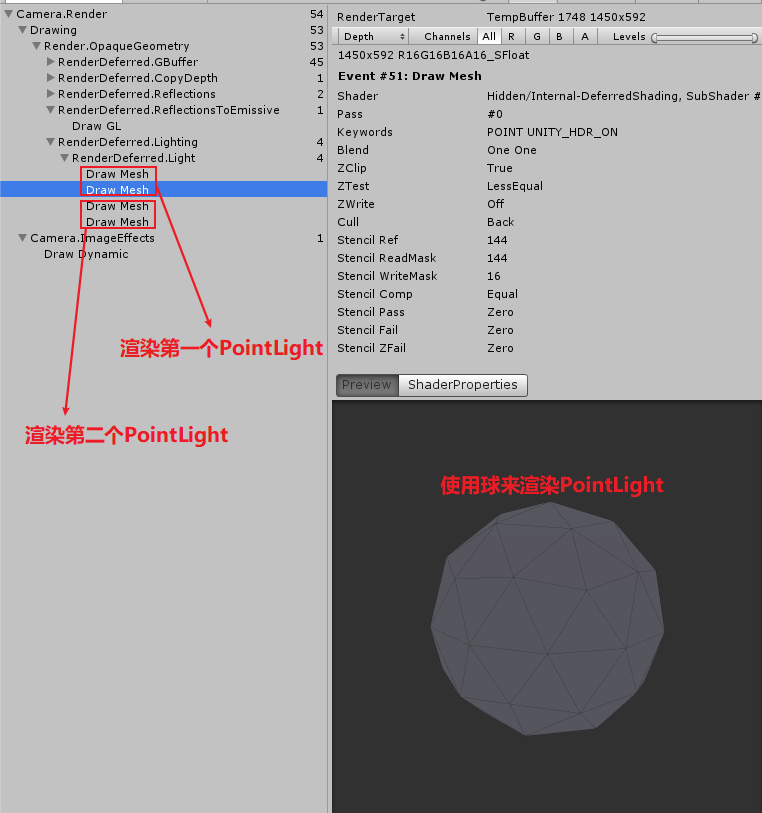

- Point lights

point light 和 spot light 类似,只是使用球体来表示 point light 照亮的体积。

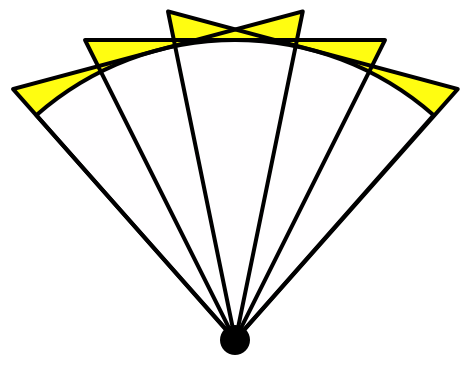

- Light Volume

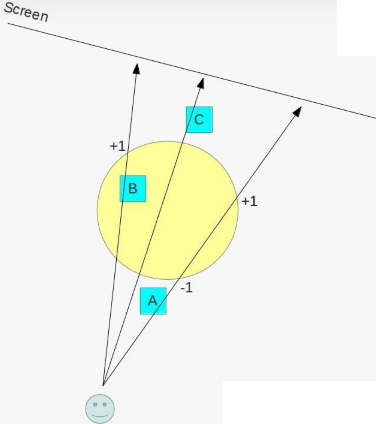

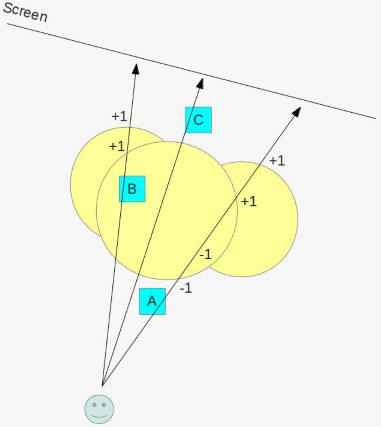

直接渲染 Light Volume 而不做特殊处理会有以下问题:

- 当灯光和近平面相交时,可见的 Light Volume 是背面,不关闭背面剔除 。灯光就不可见了。

由于我们是将 Light Volume 投影到屏幕上来得到光源影响范围。这会导致 Light Volume 远离屏幕一侧的物体也会参与光照计算。如下图:

可以利用模板缓冲区来解决上面问题,具体做法如下:

a. 渲染 Light Volume,开启深度测试,Cull Back(渲染正面),关闭深度写入,模板测试全通过。

b. 深度测试失败, 模板值减 1,深度测试成功,模板值不变

c. 再次渲染 LightVolume, 开启深度测试,Cull Front(渲染背面),关闭深度写入,模板测试全通过。

d. 深度测试失败,模板值加 1,深度测试成功,模板值不变

e. 再次渲染 LightVolume, 开启模板测试, 进行光照计算。

Tips: 该方法还适用于多光源

详细解释可以参考:

- 当灯光和近平面相交时,可见的 Light Volume 是背面,不关闭背面剔除 。灯光就不可见了。

- Directional Lights

- Light Range

延迟渲染中,Unity 默认使用 LDR(Low Dynamic Range)渲染场景,此时颜色值被写入到 ARGB32 格式的贴图中,Unity 使用对数运算来编码颜色从而扩大存储的颜色范围。Final Deferred Pass 会将这些颜色值转化为正常范围的颜色值。可以在 Camera 中可以设置是否开启 HDR。

col.xyz += GetEmissive(i); #if defined(DEFERRED_PASS) output.gBuffer0.rgb = albedo; output.gBuffer0.a = GetOcclusion(i); output.gBuffer1.rgb = specColor; output.gBuffer1.a = smoothness; output.gBuffer2 = float4(normal * 0.5 + 0.5, 1); #if !defined(UNITY_HDR_ON) // 使用指数-对数运算来编码解码颜色 // exp2(-col.rgb) = 2^{-col.rgb} col.rgb = exp2(-col.rgb); #endif output.gBuffer3 = col; #else //return indirect.specular.rgbr; output.color = col; #endif // DEFFERRED_PASS return output;

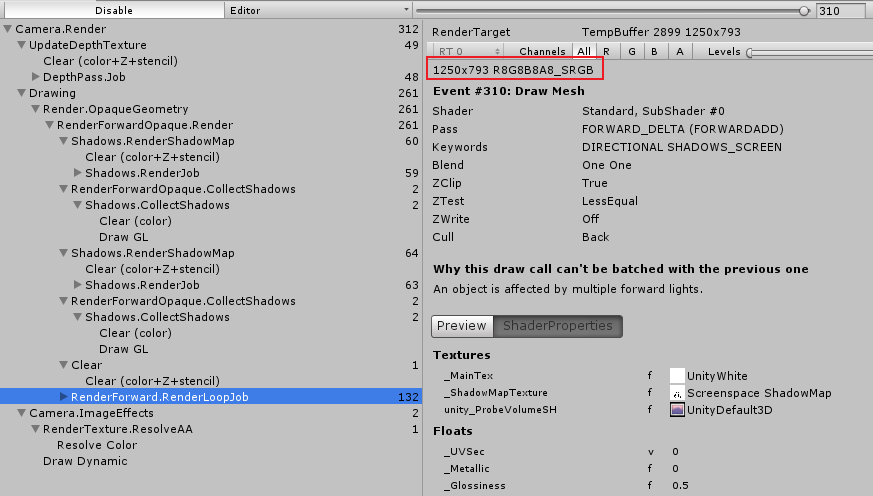

下图为不开启和开启 HDR 对于的 RenderTarget 贴图格式:

- Mixing Rendering Modes

场景中一部分物体使用的 shader 不支持延迟渲染模式时,引擎会先执行延迟渲染,将支持延迟渲染的物体绘制出来,然后再执行前向渲染,将其他不支持延迟渲染的物体绘制出来。

Unity 的延迟渲染不支持半透明物体,半透明物体需要 Forward rendering 阶段来渲染(因为半透明物体意味着需要将半透明物体叠在其后面的物体上,每多一个半透物体重叠就额外需要一整套 GBuffer 来存储对应半透明物体的渲染数据)。

Support Deferred Path

- 创建 deferred pass

延迟渲染需要 GPU 支持 MRT(multiple render targets).

Pass { Tags { // 表示该Pass用于延迟渲染 "LightMode" = "Deferred" } CGPROGRAM #pragma target 3.0 // 如果GPU不支持MRT则排除当前Pass #pragma exclude_renderers nomrt // 延迟渲染不支持 _RENDERING_FADE和 _RENDERING_TRANSPARENT #pragma shader_feature _ _RENDERING_CUTOUT #pragma shader_feature _METALLIC_MAP #pragma shader_feature _ _SMOOTHNESS_ALBEDO _SMOOTHNESS_METALLIC #pragma shader_feature _NORMAL_MAP #pragma shader_feature _OCCLUSION_MAP #pragma shader_feature _EMISSION_MAP #pragma shader_feature _DETAIL_MASK #pragma shader_feature _DETAIL_ALBEDO_MAP #pragma shader_feature _DETAIL_NORMAL_MAP #pragma vertex MyVertexProgram #pragma fragment MyFragmentProgram #define DEFERRED_PASS #include "MyDeferred.cginc" ENDCG }

- deferred pass frag output

struct FragmentOutput { // 延迟渲染需要将数据保存到多个RenderTarget #if defined(DEFERRED_PASS) float4 gBuffer0 : SV_Target0; float4 gBuffer1 : SV_Target1; float4 gBuffer2 : SV_Target2; float4 gBuffer3 : SV_Target3; #else float4 color : SV_Target; #endif };

- gbufer0123

FragmentOutput output; #if defined(DEFERRED_PASS) #if !defined(UNITY_HDR_ON) color.rgb = exp2(-color.rgb); #endif // GBuffer0.rgb 记录albedo output.gBuffer0.rgb = albedo; // GBuffer0.a记录Occlusion output.gBuffer0.a = GetOcclusion(i); // GBuffer1.rgb 记录了 specularColor output.gBuffer1.rgb = specularTint; // GBuffer1.a 记录了Smoothness output.gBuffer1.a = GetSmoothness(i); // GBuffer2中记录了normal output.gBuffer2 = float4(i.normal * 0.5 + 0.5, 1); // GBuffer3中记录了Emissive 和 environment ambient,后续光照计算得到的颜色都会叠加到GBuffer3中 output.gBuffer3 = color; #else output.color = ApplyFog(color, i); #endif return output;

- 为什么自己写的 DeferredPass GBuffer0 中输出了高光颜色,GBuffer1 中颜色比较暗?

FrameDebug 发现 MetallicMap 的贴图使用了 Unity 的默认贴图,进一步检查发现 shader 属性列表中定义的属性名称和 shader 中使用的名称不一致。

- 为什么自己写的 DeferredPass GBuffer0 中输出了高光颜色,GBuffer1 中颜色比较暗?

- support LDR

#if defined(DEFERRED_PASS) output.gBuffer0.rgb = albedo; output.gBuffer0.a = GetOcclusion(i); output.gBuffer1.rgb = specColor; output.gBuffer1.a = smoothness; output.gBuffer2 = float4(normal * 0.5 + 0.5, 1); #if !defined(UNITY_HDR_ON) col.rgb = exp2(-col.rgb); #endif output.gBuffer3 = col; #else //return indirect.specular.rgbr; output.color = col; #endif // DEFFERRED_PASS return output;

- Tone mapping 进化论 https://zhuanlan.zhihu.com/p/21983679

- Tone Mapping 与 Gamma Correction https://zhuanlan.zhihu.com/p/79203830

- Tone mapping 进化论 https://zhuanlan.zhihu.com/p/21983679

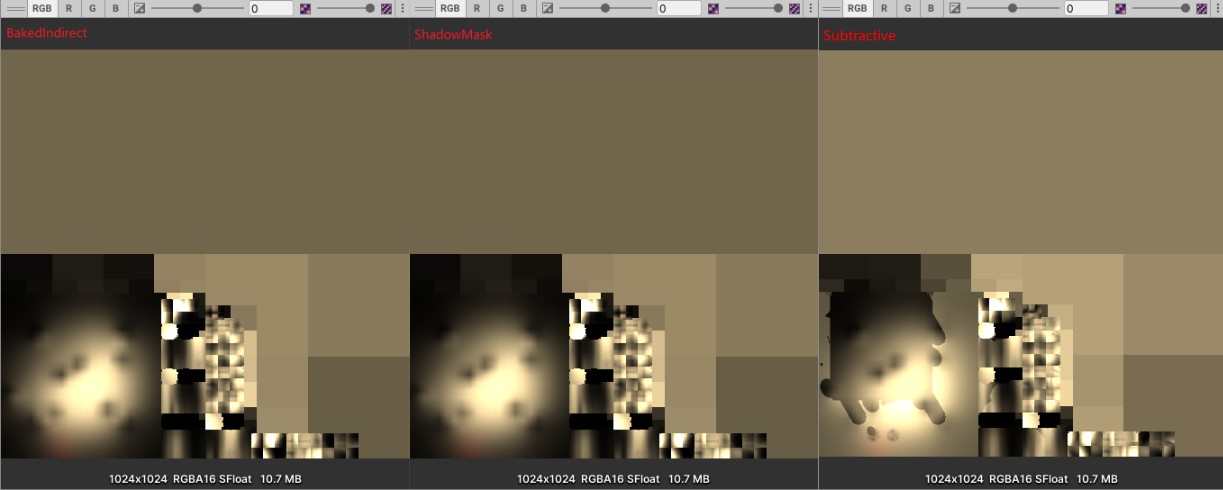

Deferred Reflections

- Unity 内置的屏幕空间反射

延迟渲染时,反射球会被渲染,反射球被投影到和反射球体积有交叉的几何体上。因此,反射球的反射不会扩展到反射球体积之外。反射球的渲染类似于灯光的渲染,只是反射球是使用正方体渲染的。

多个反射球按照顺序渲染,首先 skybox 被渲染,会覆盖整个视图。然后,各个反射球被渲染,每个反射球只会覆盖其体积内的表面。多个反射球体积有重叠时,重叠区域内,先绘制的反射球会被后绘制的反射球覆盖。

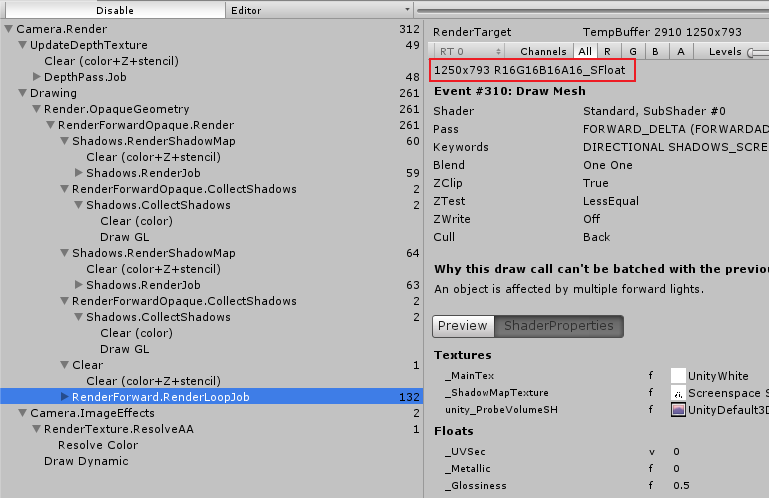

默认情况下,体积大的反射球会先绘制,这样体积小的反射球就可以覆盖体积大的反射球。你可以通过修改反射球的 Importance 属性值来调整它的绘制顺序。

- 延迟渲染使用非屏幕空间反射

关闭延迟渲染的屏幕空间反射后,Unity 会采用前向渲染的方式计算反射,将反射效果写入 GBuffer3 中。

Fog

Forward Fog

在 LightSetting 可以设置雾相关的属性。

- ForwardPath 中为什么天空盒子不受雾效果的影响?

雾效果是在 Standard Shader 中的片段着色器中,对片段颜色进行修改来实现的。Unity 的天空盒并没有使用 Standard Shader 进行渲染,所以其不受雾影响。

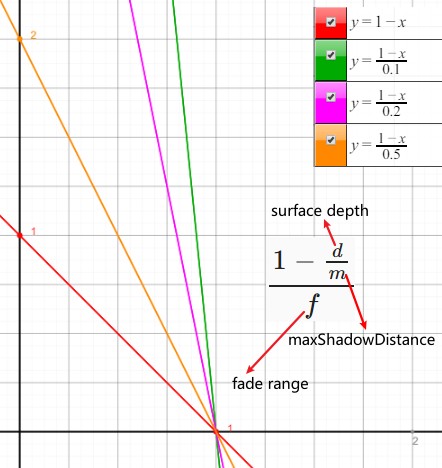

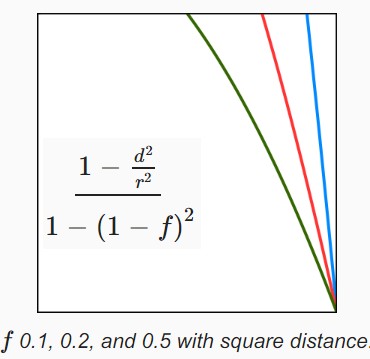

- Linear Fog

线性模式的雾可以设置雾生效的最小距离和最大距离。离摄像机距离小于最小距离时没有雾的效果,在最小距离到最大距离雾的效果逐渐增加到最大,大于最大距离时显示最大雾的效果(即物体完全呈现雾的颜色)

LinearFog 计算公式 \(f = \frac{fogEnd - fogCoor}{fogEnd-fogStart}\)

- Exponential Fog

一次指数模式的雾。

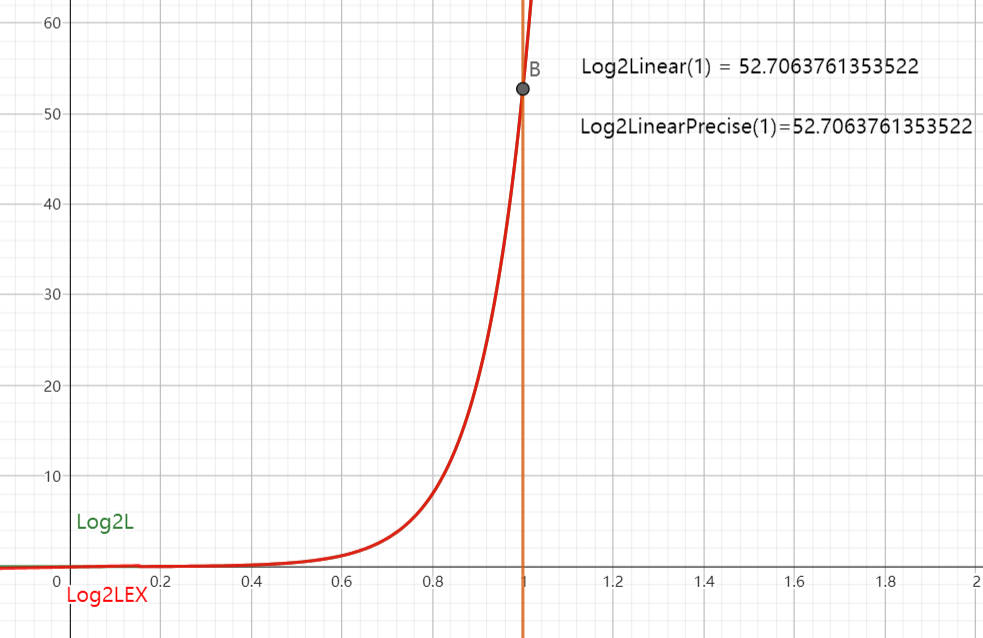

ExponentialFog 计算公式 \(f = 2^{-fogCoor*fogDensity}\)

- Exponential Squared Fog

二次指数模式的雾。

ExponentialSquaredFog 计算公式 \(f = 2^{-(fogCoor*fogDensity)^{2}}\)

- Depth-Based Fog

Unity Shader 使用裁剪空间坐标的 w 分量作为 Fog Coordinate,裁剪空间坐标的 w 分量为投影变换前摄像机坐标系下坐标的 z 分量。这种计算雾的方式也称为基于深度的雾计算。

基于深度的雾计算比基于距离的雾计算效率更高。基于距离的雾比基于深度的雾效果要好,基于深度的雾在摄像机旋转视角时,雾效会变化。下图说明了其中的原理:

- 代码实现

- ApplyFog

v2f vert (appdata v) { v2f o; UNITY_INITIALIZE_OUTPUT(v2f, o); o.pos = UnityObjectToClipPos(v.vertex); o.uv.xy = TRANSFORM_TEX(v.uv, _MainTex); o.uv.zw = TRANSFORM_TEX(v.uv, _DetailTex); o.worldNormal = mul(v.normal, (float3x3)unity_WorldToObject); o.worldPos = mul(unity_ObjectToWorld, v.vertex); // 基于深度的雾 #if FOG_DEPTH // OpenGL clip space z range = [-near, far] o.worldPos.w = o.pos.z; #endif float3 tangentWorld = UnityObjectToWorldDir(v.tangent.xyz); float3x3 tangentToWorld = MCreateTangentToWorldPerVertex(o.worldNormal, tangentWorld, v.tangent.w); o.tangentToWorld[0] = tangentToWorld[0]; o.tangentToWorld[1] = tangentToWorld[1]; o.tangentToWorld[2] = tangentToWorld[2]; ComputeVertexLightColor(o); #if defined(UNITY_NO_SCREENSPACE_SHADOWS) TRANSFER_SHADOW(o); #else UNITY_TRANSFER_SHADOW(o, 0); #endif COMPUTE_LIGHT_COORDS(o); return o; } float4 ApplyFog(float color, v2f i) { float viewDistance = length(_WorldSpaceCameraPos - i.worldPos); #if FOG_DEPTH viewDistance = UNITY_Z_0_FAR_FROM_CLIPSPACE(i.worldPos.w); #endif UNITY_CALC_FOG_FACTOR_RAW(viewDistance); // 多光源支持 只需要对第一个光源叠加雾的颜色就可以了,其他光源只根据雾的强度进行减弱。 float3 fogColor = 0; #if defined(FORWARD_BASE_PASS) fogColor = unity_FogColor.rgb; #endif return lerp(fogColor, color, unityFogFactor); }

- UNITY_Z_0_FAR_FROM_CLIPSPACE(coord) 将 zclip space z value map to [0, far]

#if defined(UNITY_REVERSED_Z) #if UNITY_REVERSED_Z == 1 //D3d with reversed Z => z clip range is [near, 0] -> remapping to [0, far] //max is required to protect ourselves from near plane not being correct/meaningfull in case of oblique matrices. #define UNITY_Z_0_FAR_FROM_CLIPSPACE(coord) max(((1.0-(coord)/_ProjectionParams.y)*_ProjectionParams.z),0) #else //GL with reversed z => z clip range is [near, -far] -> should remap in theory but dont do it in practice to save some perf (range is close enough) #define UNITY_Z_0_FAR_FROM_CLIPSPACE(coord) max(-(coord), 0) #endif #elif UNITY_UV_STARTS_AT_TOP //D3d without reversed z => z clip range is [0, far] -> nothing to do #define UNITY_Z_0_FAR_FROM_CLIPSPACE(coord) (coord) #else //Opengl => z clip range is [-near, far] -> should remap in theory but dont do it in practice to save some perf (range is close enough) #define UNITY_Z_0_FAR_FROM_CLIPSPACE(coord) (coord) #endif

- 为什么此处不需要将 Z 值线性化?而从深度缓存区取出的深度值需要线性化?

ClipSpace 的 Z 值(OpenGL Clip Space Z Range=[-near,far])没有经过透视除法,所以其 Z 值本身就是线性的;

深度缓冲区中的 Z 值(Depth Buffer Z Range=[0, 1])经过了透视除法,其值不是线性的(10%近处的场景占用了 0-0.9 范围的深度)。

- Depth Testing https://learnopengl.com/Advanced-OpenGL/Depth-testing

- linear Depth Buffer(线性深度缓冲区) https://www.cnblogs.com/pulas/archive/2012/02/07/2341462.html

- Depth Testing https://learnopengl.com/Advanced-OpenGL/Depth-testing

- 为什么此处不需要将 Z 值线性化?而从深度缓存区取出的深度值需要线性化?

- UNITY_CALC_FOG_FACTOR_RAW 实现了前面的计算公式

#if defined(FOG_LINEAR) // factor = (end-z)/(end-start) = z * (-1/(end-start))+(end/(end-start)) #define UNITY_CALC_FOG_FACTOR_RAW(coord) float unityFogFactor = \ (coord) * unity_FogParams.z + unity_FogParams.w #elif defined(FOG_EXP) // factor = exp(-density*z) #define UNITY_CALC_FOG_FACTOR_RAW(coord) float unityFogFactor = \ unity_FogParams.y * (coord); \ unityFogFactor = exp2(-unityFogFactor) #elif defined(FOG_EXP2) // factor = exp(-(density*z)^2) #define UNITY_CALC_FOG_FACTOR_RAW(coord) float unityFogFactor = \ unity_FogParams.x * (coord); \ unityFogFactor = exp2(-unityFogFactor*unityFogFactor) #else #define UNITY_CALC_FOG_FACTOR_RAW(coord) float unityFogFactor = 0.0 #endif // x = density / sqrt(ln(2)), useful for Exp2 mode // y = density / ln(2), useful for Exp mode // z = -1/(end-start), useful for Linear mode // w = end/(end-start), useful for Linear mode float4 unity_FogParams;

- ApplyFog

Deferred Fog

- Shader Source Code

Shader "Custom/DeferredFog" { CGINCLUDE #include "UnityCG.cginc" sampler2D _MainTex; sampler2D _CameraDepthTexture; float3 _FrustumCorners[4]; struct VertexData { float4 vertex : POSITION; }; struct Interpolators { float4 pos : SV_POSITION; float2 uv : TEXCOORD0; #if defined(FOG_DISTANCE) float3 ray; #endif }; Interpolators VertexProgram (VertexData v) { Interpolators i; i.pos = float4(v.vertex.xy, 0.0, 1.0); // 直接通过三角形顶点坐标求的uv坐标 i.uv = (v.vertex + 1) * 0.5; #if UNITY_UV_STARTS_AT_TOP i.uv= i.uv * float2(1.0, -1.0) + float2(0.0, 1.0); #endif #if defined(FOG_DISTANCE) // 将 i.uv 映射为数组的索引值 i.ray = _FrustumCorners[i.uv.x+2*i.uv.y] #endif return i; } float4 FragmentProgram (Interpolators i) : SV_Target { float depth = SAMPLE_DEPTH_TEXTURE(_CameraDepthTexture, i.uv); depth = Linear01Depth(depth); // 为了和Forward Path中深度雾计算一直需要减掉near , 参考 UNITY_Z_0_FAR_FROM_CLIPSPACE 函数中的处理 // _ProjectionParams // x=1 or -1 y=near z=far w=1/far #if defined(FOG_DISTANCE) float viewDistance = length(depth * i.ray); #else float viewDistance = depth * _ProjectionParams.z - _ProjectionParams.y; #endif UNITY_CALC_FOG_FACTOR_RAW(viewDistance); unityFogFactor = saturate(unityFogFactor); // 天空盒深度值为1,通过下面判断,让雾不影响天空盒 if (depth > 0.9999) { unityFogFactor = 1; } float3 color = tex2D(_MainTex, i.uv).rgb; float3 foggedColor = lerp(unity_FogColor.rgb, color, unityFogFactor); return float4(foggedColor, 1); } ENDCG SubShader { Cull Off ZWrite Off ZTest Always Pass { CGPROGRAM #pragma vertex VertexProgram #pragma fragment FragmentProgram #pragma multi_compile_fog ENDCG } Pass { CGPROGRAM #define FOG_DISTANCE #pragma vertex VertexProgram #pragma fragment FragmentProgram #pragma multi_compile_fog ENDCG } } }

- Depth-Based Fog

- Distance Based Fog

从摄像机原点向远平面发射一条射线,如果从原点到远平面之间有物体,这射线最先接触的物体的交点到摄像机原点的距离就是我们要求的距离。

从摄像机原点 O 到远平面交点 F 的射线(向量 OF)和从原点 O 到最先接触物体的交点 I 的射线(向量 OI)之间的关系为 \(OF=depth*OI\) ,其中 depth 为交点 I 对应的深度值。

在 vertex shader 中设置每个顶点对应的 \(ray=\overrightarrow{OF}\) ,在 fragment shader 中就会得到各个像素对应的 OF 向量。

Deferred Lights

Light Shader

- 两个 Pass

DeferredShading 需要两个 Pass。第一个 Pass 执行光照计算,第二个 Pass 处理 LDR 模式下的颜色解码。

当 HDR 没开启时,光照数据是按照指数-对数运算编码解码的,前面的 DeferredShading 使用指数运算进行了编码,此时需要使用对数运算进行解码。

- Avoiding the Sky

当 HDR 没有开启时,SceneView 中天空盒会显示不正确(Unity 2020.1.4f1 版本),在第二个 Pass 中使用 StencilBuffer 作为 Mask,从而避免对数运算解码对天空盒对应的像素进行操作。

Pass { Cull Off ZTest Always ZWrite Off Stencil { Ref [_StencilNonBackground] ReadMask [_StencilNonBackground] CompBack Equal CompFront Equal } // ....... }

Directional Lights

使用正交投影矩阵渲染一个矩形。具体实现参考有道云笔记 Unity Source Code.md

- 读取 G-Buffer 数据使用的 UV

struct Interpolators { float4 pos : SV_POSITION; float4 uv : TEXCOORD0; }; Interpolators VertexProgram (VertexData v) { Interpolators i; i.pos = UnityObjectToClipPos(v.vertex); // 读取G-Buffer数据使用的UV i.uv = ComputeScreenPos(i.pos); return i; }

- 像素对应的世界坐标位置

从原始透视摄像机到近平面四个角的射线存储在绘制四边形的 normal 中。

struct VertexData { float4 vertex : POSITION; float3 normal : NORMAL; }; struct Interpolators { float4 pos : SV_POSITION; float4 uv : TEXCOORD0; float3 ray : TEXCOORD1; }; Interpolators VertexProgram (VertexData v) { Interpolators i; i.pos = UnityObjectToClipPos(v.vertex); i.uv = ComputeScreenPos(i.pos); i.ray = v.normal; return i; } fixed4 frag (v2f i) : SV_Target { float2 uv = i.uv.xy / i.uv.w; float depth = SAMPLE_DEPTH_TEXTURE(_CameraDepthTexture, uv); depth = Linear01Depth(depth); float3 rayToFarPlane = i.ray * _ProjectionParams.z / i.ray.z; float3 viewPos = rayToFarPlane * depth; // 求像素对应的世界坐标位置,unity_CameraToWorld矩阵为原始透视摄像机到世界空间的转换矩阵 float3 worldPos = mul(unity_CameraToWorld, float4(viewPos, 1)).xyz; // ...... }

- Supporting LDR