Physically Based Rendering

Table of Contents

- Physically Based Rendering

- Prepare

- 1 Introduction

- Part 1 Main Geometric Functionality

- Part 2 Image Formation Process

- Part 3 Light And Scatter

- 8 Reflection models

- 9 Materials

- 10 Texture

- 11 Volume Scattering

- 12 Light Source

- Part 4 Implement Light Transport algorithms

- 13 Monte Carlo Integration

- 14 Light Transport I:Surface Reflection

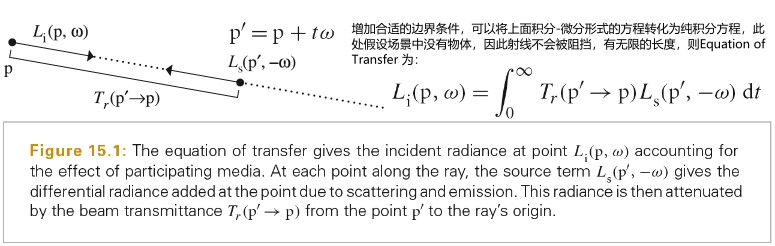

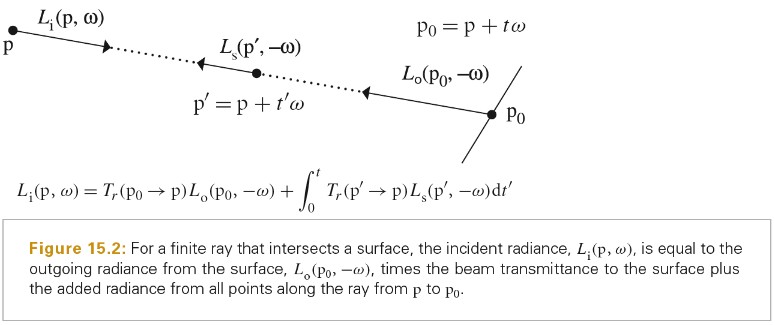

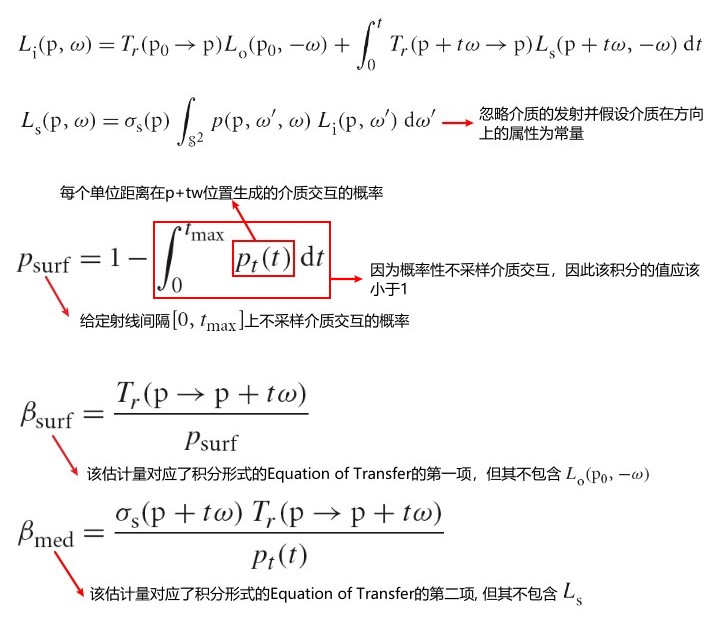

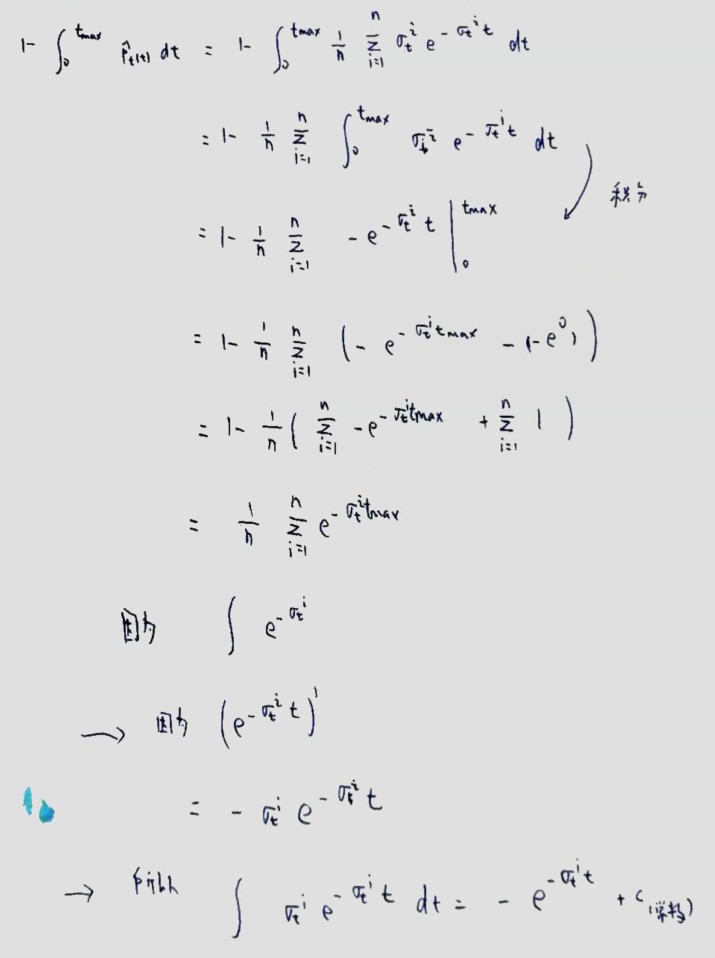

- 15 Light Transport II:Volume Rendering

- 16 Light Transport III:Bidirectional Methods

- 17 Retrospective and the future

- 参考资料

- Lighting Model

Physically Based Rendering 第 3 版 翻译.

<!– more –>

Physically Based Rendering

Prepare

git clone -b book git@github.com:mmp/pbrt-v3.git git submodule update --init --recursive ## 配置 CMake SourceCode 路径 D:/Documents/MyProject/Public/pbrt3_book/pbrt-v3 ## 配置 CMake Build Binaries 路径 D:/Documents/MyProject/Public/pbrt3_book/build_app ## Windows CMake Configure ## Windows CMake Generate ## D:/Documents/MyProject/Public/pbrt3_book/build_app目录下打开VS工程 ## run test ## Command Arguments: $(ProjectDir)..\pbrt-v3\scenes\killeroo-simple.pbrt pbrt.exe --nthreads 1 D:\Documents\MyProject\Public\pbrt3\scenes\killeroo-simple.pbrt pbrt.exe -- 1 D:\Documents\MyProject\Public\pbrt3\scenes\killeroo-simple.pbrt ## 执行结果 # pbrt3_book/build_app/killeroo-simple.exr ## 下载更多场景 git clone git://git.pbrt.org/pbrt-v3-scenes ./pbrt3_scenes ## 将pbrtv3 格式的场景转化为 pbrtv4版本 v4-version-path/pbrt.exe --upgrade v3-version-path/scenes/killeroo-simple.pbrt > killeroo-smiple-v4.pbrt v4-version-path/pbrt.exe --upgrade v3-version-path/scenes/geometry/killeroo.pbrt > killeroo-v4.pbrt

1 Introduction

Literate Programming

Literate Programming 是 Tex 的作者发明的一种编程方法,它基于很简单却非常有革命性的观念,这个观念就是应该以人的思维,而不应该以电脑的思维来写程序。

Photorealistic rendering and the ray-tracing algorithm

尽管有很多种方式实现光线追踪,但是所有的这些实现中都需要模拟下面物体和现象:

Cameras

- 对于场景图片的每个点,摄像机记录的颜色值应该为多少呢?

从简易的针孔照相机来看,只有通过针孔和胶片像素点连线的光线才会被记录到胶片上。所以,可以依据像素点和摄像机位置生成射线。

Ray-object intersections

每次摄像机生成一条射线时,渲染器的第一项任务就是确定射线第一次和哪个物体相交,并且交点在哪儿。交点就是沿着射线可见的点。然后,我们将模拟光线和交点的交互。

射线的参数表示形式, \(o\) 表示射线的原点, \(t\) 为参数,其合法范围为 \((0, \infty )\)

只是一个单独的交点对于射线追踪器是不够的,它还需要知道表面上该点的一些特定的属性。首先,该点的材质必须是确定的,并且会被传递给射线追踪算法的后续阶段。其次,交点的额外的几何信息也是需要的。例如交点的法线。

Light sources

射线和物体的交互阶段确定了需要被渲染的点,以及该点的一些局部几何信息。回顾我们最终的目标是要找出在摄像机方向上离开该点的光的总量。为此我们需要知道有多少光照可以到达该交点。

假设光源为点光源,单位表面接收到的辐照度如下, \(\Phi\) 表示光源的辐射通量,\(\theta\) 表示光线和表面的夹角

Visibility

构造一个新的射线,其起点为前面阶段得到的交点,其方向指向光源。这些特殊的射线被称为阴影射线。如果我们追踪这些射线,就可以判断是否有阻挡物在交点和光源之间,没有阻挡物时,光线的贡献才会被计算。

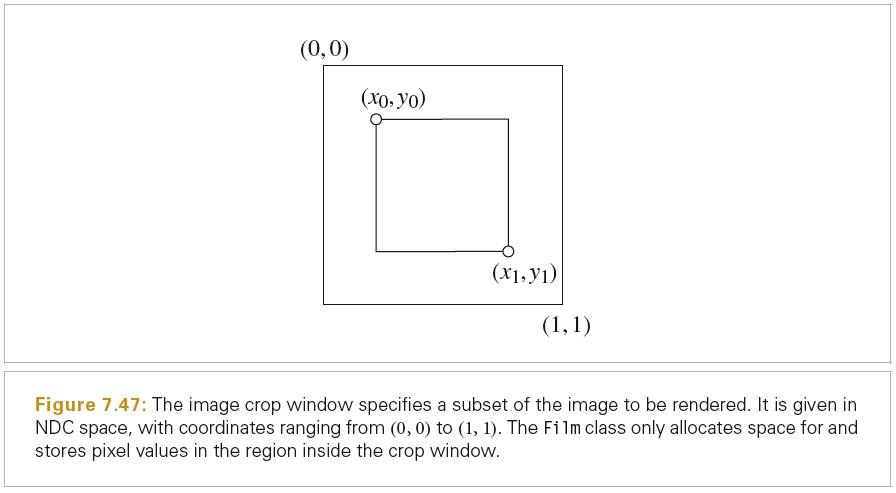

Surface scattering

场景中的每个物体都提供了一个材质,这是物体表面上每个点的显示属性的描述。这个描述是通过双向反射分布函数给出的。这个函数可以告诉我们从入射方向 \(w_i\) 到 出射方向 \(w_o\) 有多少能量被反射。我们将在 p 点的 BRDF 记作 \(f_r(p, w_o, w_i)\)

foreach(var light in lights) { if (!IsLightBlocked(light)) { incident_light = light.L(point); amount_reflected = surface.BRDF(hit_point, camera_vector, light_vector); L += amount_reflected * incident_light; } } // 此处的 L 表示辐射率

BTDF 双向透射分布函数

BSDF 双向散射分布函数

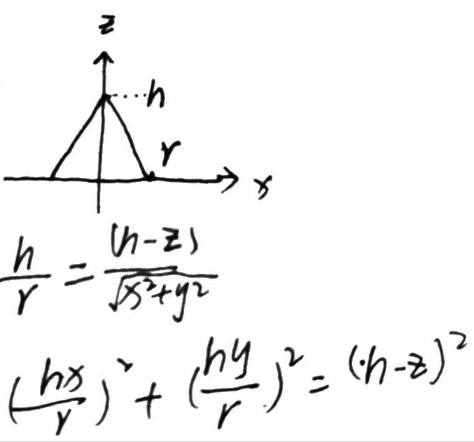

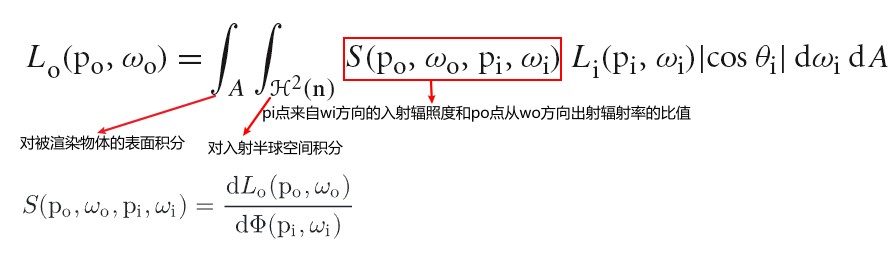

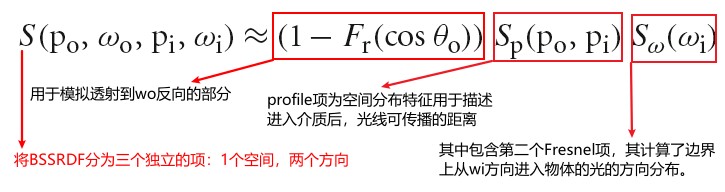

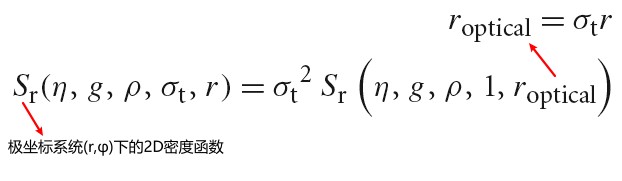

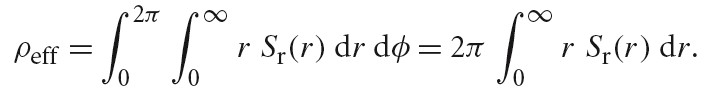

BSSRDF 双向次表面散射反射分布函数

Indirect light transport

如果从摄像机发出的射线碰到了有光泽的物体例如一面镜子,我们可以依据交点处表面的法线反射射线,并递归地调用射线追踪程序来找到到达交点的光照,然后将其贡献加到原始的摄像机射线中。同样的技术可以用于追踪和透明物体相交时,生成的透射射线。

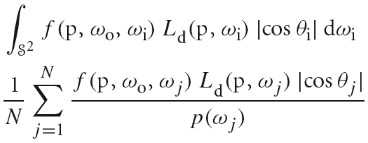

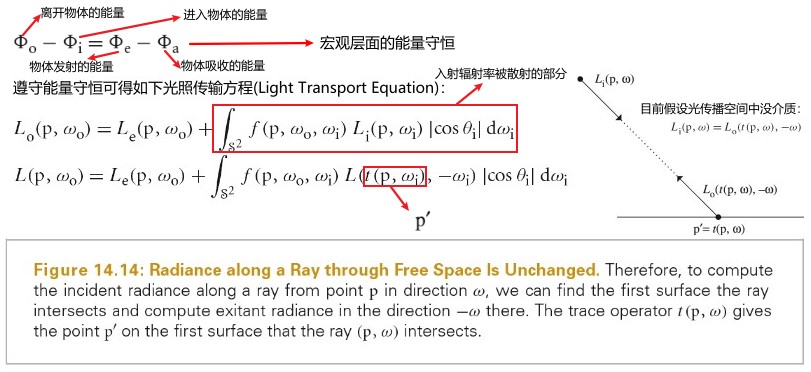

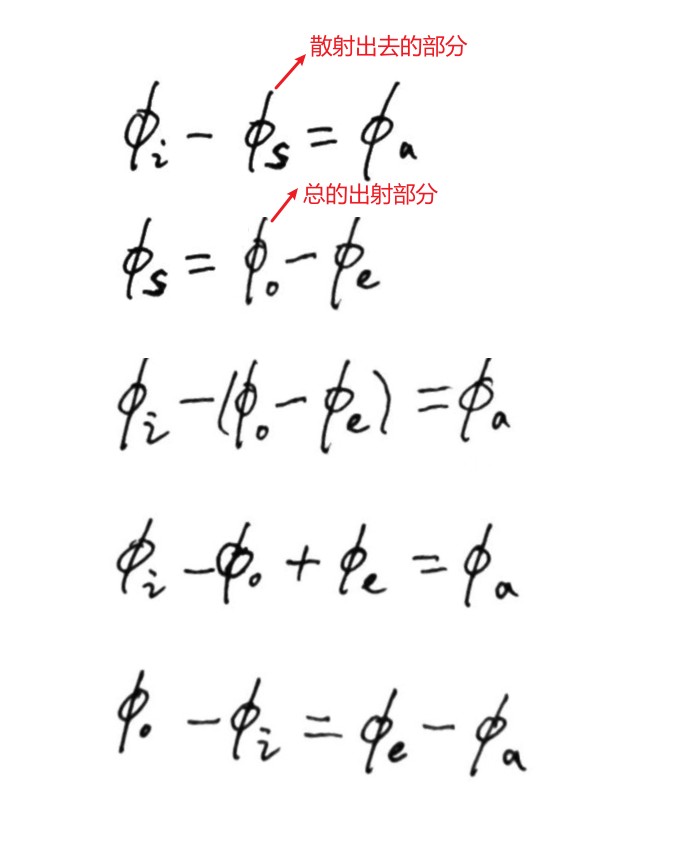

通常来讲,从某个点到达摄像机的光由两部分组成,一部分是该点发出的光的总量,另一部分是该点反射的光的总量。这种观念的正式表述就是光照传播方程(也叫渲染方程):

Whitted 简化了上述渲染方程中,积分的求解,他只计算朝向光源的 L_i(p,w_i)。但是,他的方法可以进一步扩展,例如,我们可以计算多个靠近 Whitted 选取方向的射线进行计算,然后按照权重计算他们的贡献,这样就可以获得更好的效果。

当射线碰到物体时,我们可以一直生成新的射线,然后,递归计算该射线。这样就可以捕捉到物体之间所有的反射,从而创造出非常真实的图片。

Ray propagation

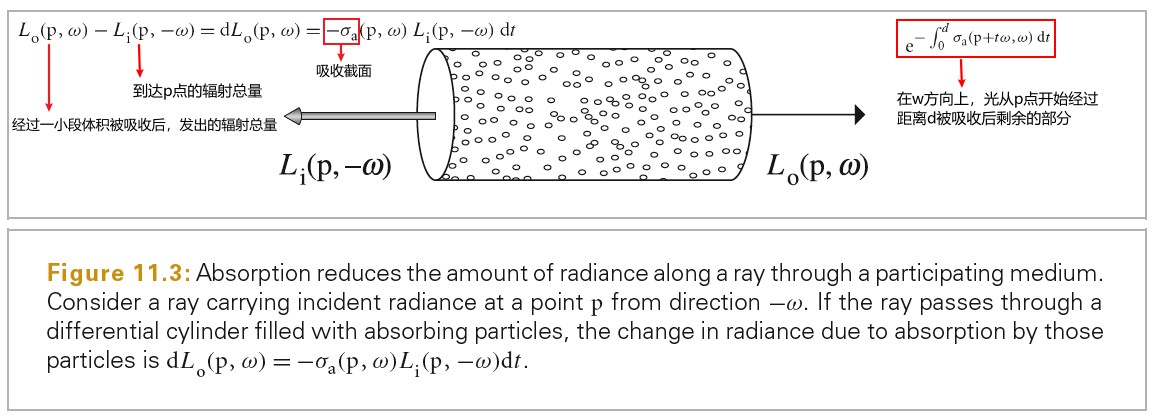

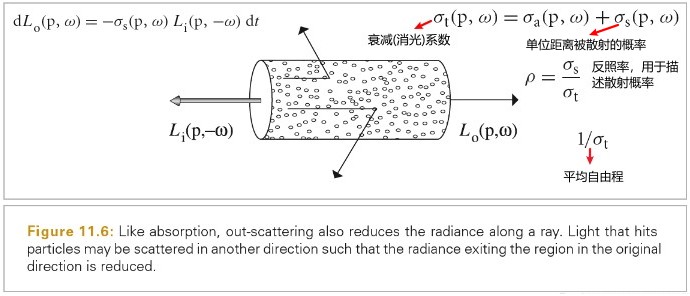

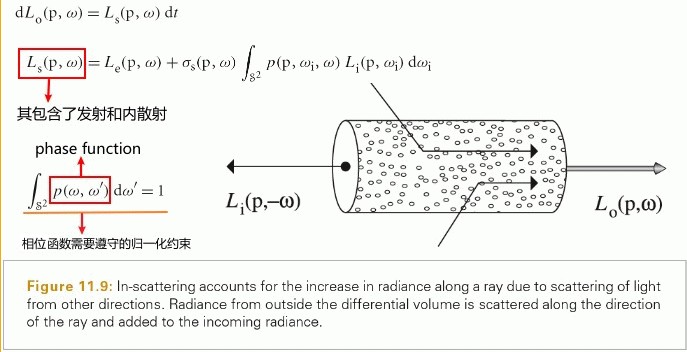

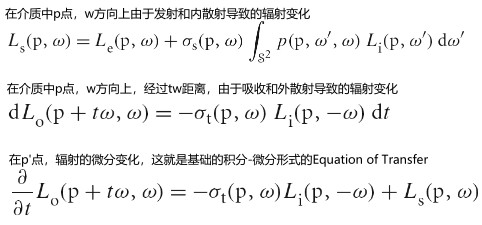

介质对光传播的影响有两种方式。

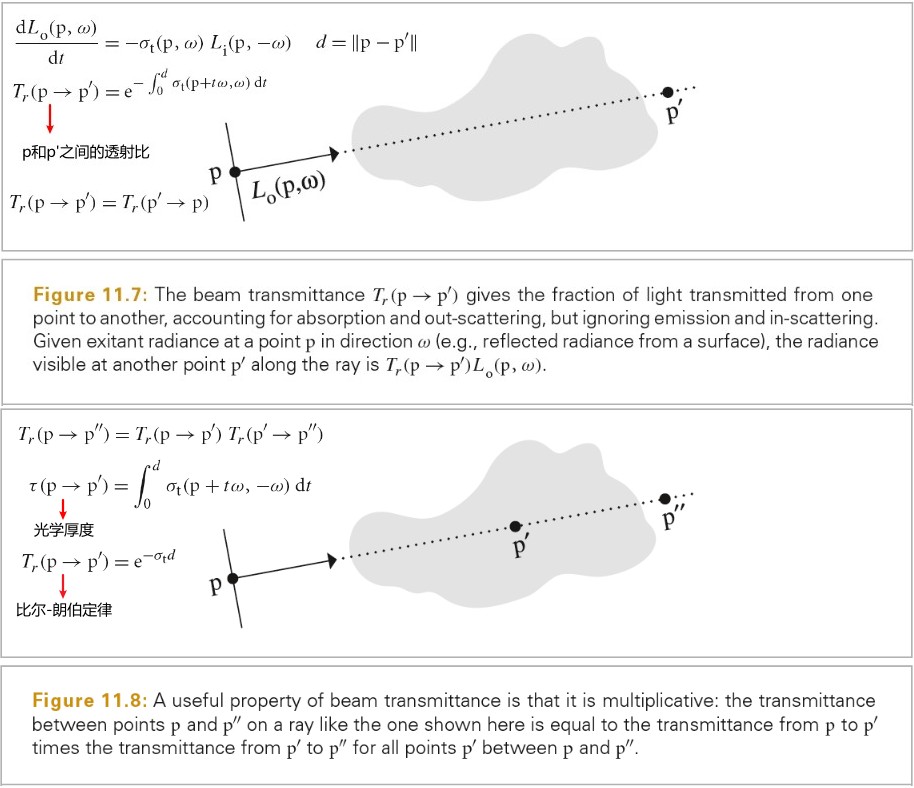

第一种,介质可以减弱光线,无论是吸收或者是将光散射到其他方向。我们可以通过计算射线原点和当前交点之间的透射率来计算这种影响效果。

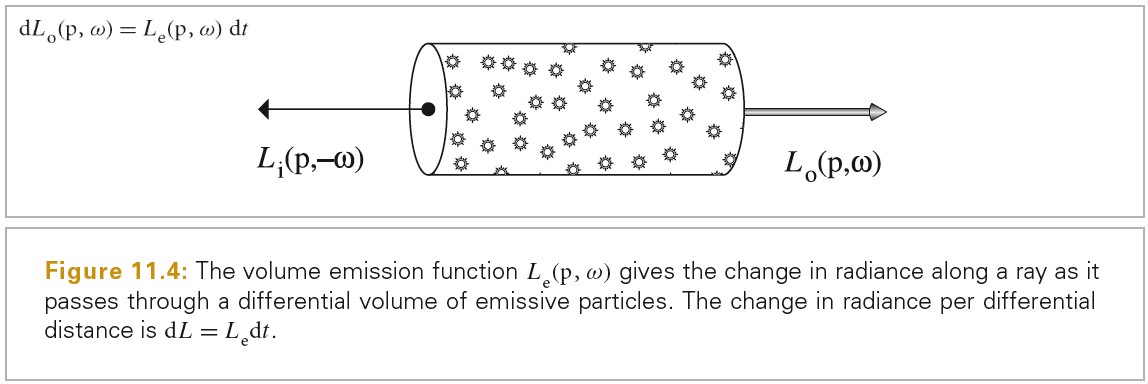

第二种,介质也可以对射线携带的光有增强作用。当介质本身发光时,或者是介质从其他方向反射光照到当前射线方向。从数值上计算体积光传播方程可以找到很多这样的例子。

pbrt: System Overview

| Base Class | Directory |

|---|---|

| Shape | shapes/ |

| Aggregate | accelerators/ |

| Camera | cameras/ |

| Sampler | samplers |

| Filter | filters/ |

| Material | materials/ |

| Texture | textures/ |

| Medium | media/ |

| Light | lights/ |

| Integrator | integrators/ |

phases of execution

- 解析完命令行参数后,会调用 api.cpp - pbrtWorldEnd() 函数 - pbrtWorldEnd 中会先创建 Integrator, 调用 api.cpp - RenderOptions::MakeIntegrator() - 创建 Integrator 时会先创建 Sampler, 调用 api.cpp - MakeSampler() - 创建 Integrator - 创建完 Integator 后会创建 Scene,调用 api.cpp - RenderOptions::MakeScene() - 创建 Scene时会先创建场景管理数据结构 Accelerator, 调用 api.cpp - MakeAccelerator() - 创建 Scene - 创建完Scene之后会执行 integrator->Render(*scene) 开启渲染主循环

scene representation

采用了自定义的文本格式。如下面所示

LookAt 400 20 30 0 63 -110 0 0 1

Rotate -5 0 0 1

Camera "perspective" "float fov" [39]

Film "image"

"integer xresolution" [700] "integer yresolution" [700]

"string filename" "killeroo-simple.exr"

# zoom in by feet

# "integer xresolution" [1500] "integer yresolution" [1500]

# "float cropwindow" [ .34 .49 .67 .8 ]

Sampler "halton" "integer pixelsamples" [8]

Integrator "path"

WorldBegin

AttributeBegin

Material "matte" "color Kd" [0 0 0]

Translate 150 0 20

Translate 0 120 0

AreaLightSource "area" "color L" [2000 2000 2000] "integer nsamples" [8]

Shape "sphere" "float radius" [3]

AttributeEnd

AttributeBegin

Material "matte" "color Kd" [.5 .5 .8]

Translate 0 0 -140

Shape "trianglemesh" "point P" [ -1000 -1000 0 1000 -1000 0 1000 1000 0 -1000 1000 0 ]

"float uv" [ 0 0 5 0 5 5 0 5 ]

"integer indices" [ 0 1 2 2 3 0]

Shape "trianglemesh" "point P" [ -400 -1000 -1000 -400 1000 -1000 -400 1000 1000 -400 -1000 1000 ]

"float uv" [ 0 0 5 0 5 5 0 5 ]

"integer indices" [ 0 1 2 2 3 0]

AttributeEnd

AttributeBegin

Scale .5 .5 .5

Rotate -60 0 0 1

Material "plastic" "color Kd" [.4 .2 .2] "color Ks" [.5 .5 .5]

"float roughness" [.025]

Translate 100 200 -140

Include "geometry/killeroo.pbrt"

Material "plastic" "color Ks" [.3 .3 .3] "color Kd" [.4 .5 .4]

"float roughness" [.15]

Translate -200 0 0

Include "geometry/killeroo.pbrt"

AttributeEnd

WorldEnd

integrator interface and SamplerIntegrator

Intergrator 是一个抽象基类,所有 integrators 必须实现其定义的 Render() 方法。Render() 方法会接受一个 Scene 类型的引用参数,该参数表示被渲染的场景。

class Integrator { public: // Integrator Interface virtual ~Integrator(); virtual void Render(const Scene &scene) = 0; };

SamplerIntegrator 是 Integrator 的子类。WhittedIntegrator 是 SamplerIntegrator 的子类。SamplerIntegrator 的名称来源于它的渲染过程是由一个 Sampler 类实例中的 samples 驱动的。 每个 sample 对应图像上的一个点,在该点处,itegrator 会计算到达该点的光,从而得到最终的图像。

// SamplerIntegrator Declarations class SamplerIntegrator : public Integrator { public: // SamplerIntegrator Public Methods SamplerIntegrator(std::shared_ptr<const Camera> camera, std::shared_ptr<Sampler> sampler, const Bounds2i &pixelBounds) : camera(camera), sampler(sampler), pixelBounds(pixelBounds) {} virtual void Preprocess(const Scene &scene, Sampler &sampler) {} void Render(const Scene &scene); virtual Spectrum Li(const RayDifferential &ray, const Scene &scene, Sampler &sampler, MemoryArena &arena, int depth = 0) const = 0; Spectrum SpecularReflect(const RayDifferential &ray, const SurfaceInteraction &isect, const Scene &scene, Sampler &sampler, MemoryArena &arena, int depth) const; Spectrum SpecularTransmit(const RayDifferential &ray, const SurfaceInteraction &isect, const Scene &scene, Sampler &sampler, MemoryArena &arena, int depth) const; protected: // SamplerIntegrator Protected Data std::shared_ptr<const Camera> camera; private: // SamplerIntegrator Private Data std::shared_ptr<Sampler> sampler; const Bounds2i pixelBounds; }; } // namespace pbrt

SamplerIntegrator 存储了一个指向 Sampler 的指针。 采样器的实现会极大地影响系统生成的图像的质量。 首先,采样器负责在胶片上选择点,从而确定追踪哪条射线。 其次,它负责为积分器提供样本位置,用于估计光传输积分值。例如,一些积分器需要在光源上随机选择点来计算区域光的照明。生成良好分布的样本是渲染过程的重要组成部分,它可以显着影响整体效率; 这个主题是第 7 章的重点。

Camera 对象控制视角和镜头参数,例如位置、方向、焦点和视野。 Camera 类中的 Film 成员变量处理图像存储。 Camera 类在第 6 章中描述,Film 在第 7.9 节中描述。 Film 负责将最终图像写入文件,并可能在计算时将其显示在屏幕上。

实现 SamplerIntegrator 接口的类可以选择性地实现 Preprocess() 方法。 该方法在场景完全初始化后调用,让积分器有机会进行与场景相关的计算,例如分配依赖于场景中灯光数量的额外数据结构,或预先计算场景中 radiance 的粗略分布。

the main rendering loop

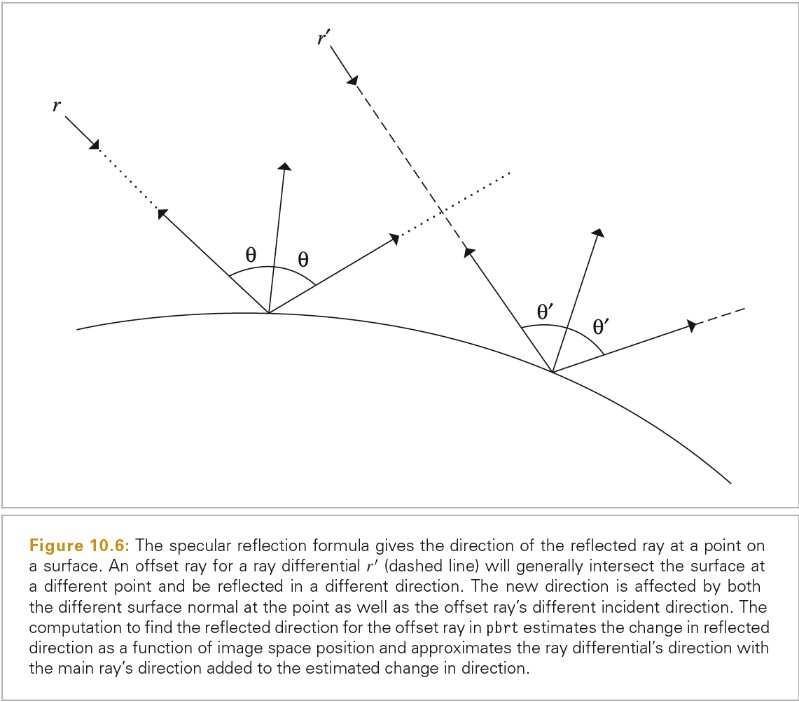

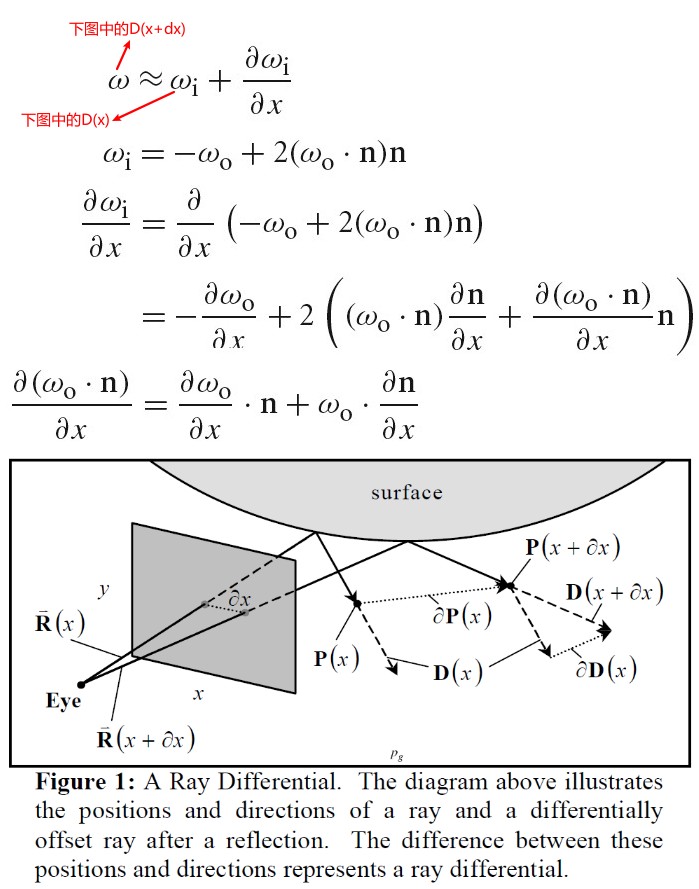

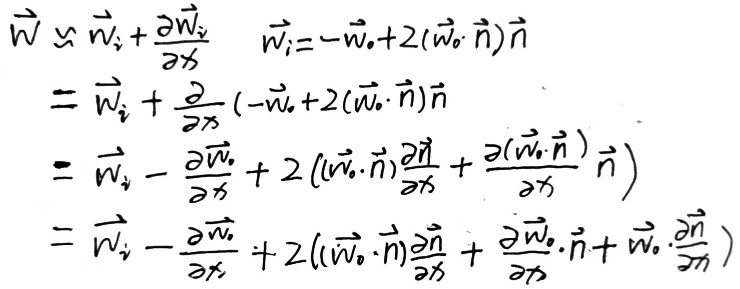

Ray differentials

Ray differentials 包含了射线的相关的信息,其实就是在当前像素点上分别在 x 和 y 方向上偏移一像素生成的射线.

Li 函数

Li 函数用于计算给定射线的入射辐射率

- ray 指定被计算的射线

- scene 指定被渲染的场景

- sampler 样本生成器,使用 MonteCarlo 积分来计算光照传输方程

- arena MemoryArena 对象,用于积分器高效地分配临时内存空间

- depth 射线从摄像机发出,直到当前调用 Li(),弹射的次数

渲染主循环流程

- 依据胶片大小划分tile, 每个tile并行进行渲染

- 为tile分配内存

- 为 tile 克隆sampler实例

- 计算tile的采样边界

- 依据tile的采样边界获取对应的FileTile

- 遍历tile内的每个像素,对每个像素进行渲染

- 对每个像素的每个样本进行处理

- 根据像素坐标获取对应的CameraSample

- 为当前的CameraSample 生成摄像机射线

- 计算沿着摄像机射线的辐射率 L

- 记录当前样本贡献的辐射率,以及对应的权重

an integrator for whited ray tracing

Whitted 积分器的工作方式是,沿着射线的反射和折射方向递归地计算辐射率。当达到预先决定的最大深度后停止递归。如果不设置最大深度的话,可能递归永远都不会结束。

parallelization of pbrt

EXERCISE

pbrt.exe --nthreads 1 D:\Documents\MyProject\Public\pbrt3\scenes\killeroo-simple.pbrt

Part 1 Main Geometric Functionality

2 Geometry and Transformations

本书坐标系

PhysicalBasedRendering 坐标系为左手坐标系,向量为列向量.

世界坐标系 y is up.

Reflection 坐标系 z is up.

从一个向量创建一个坐标系

// 利用 互相垂直的向量夹角为90度,则cos(\theta)=0 // 取 v1 x、y分量中比较大的向量和z分量交换,并将z(原来z分量值所处的新分量)取反,再将分量比较小的项(没有参与交换的分量)置0,新的向量就可以满足上面的条件 template <typename T> inline void CoordinateSystem(const Vector3<T> &v1, Vector3<T> *v2, Vector3<T> *v3) { if (std::abs(v1.x) > std::abs(v1.y)) { *v2 = Vector3<T>(-v1.z, 0, v1.x) / std::sqrt(v1.x * v1.x + v1.z * v1.z); } else { *v2 = Vector3<T>(0, v1.z, -v1.y) / std::sqrt(v1.y * v1.y + v1.z * v1.z); } *v3 = Cross(v1, *v2); }

AABB Bounding Box

template <typename T> Bounds3<T> Union(const Bounds3<T> &b1, const Bounds3<T> &b2) { return Bounds3<T>(Point3<T>(std::min(b1.pMin.x, b2.pMin.x), std::min(b1.pMin.y, b2.pMin.y), std::min(b1.pMin.z, b2.pMin.z)), Point3<T>(std::max(b1.pMax.x, b2.pMax.x), std::max(b1.pMax.y, b2.pMax.y), std::max(b1.pMax.z, b2.pMax.z))); } template <typename T> Bounds3<T> Intersect(const Bounds3<T> &b1, const Bounds3<T> &b2) { return Bounds3<T>(Point3<T>(std::max(b1.pMin.x, b2.pMin.x), std::max(b1.pMin.y, b2.pMin.y), std::max(b1.pMin.z, b2.pMin.z)), Point3<T>(std::min(b1.pMax.x, b2.pMax.x), std::min(b1.pMax.y, b2.pMax.y), std::min(b1.pMax.z, b2.pMax.z))); } template <typename T> bool Overlaps(const Bounds3<T> &b1, const Bounds3<T> &b2) { bool x = (b1.pMax.x >= b2.pMin.x) && (b1.pMin.x <= b2.pMax.x); bool y = (b1.pMax.y >= b2.pMin.y) && (b1.pMin.y <= b2.pMax.y); bool z = (b1.pMax.z >= b2.pMin.z) && (b1.pMin.z <= b2.pMax.z); return (x && y && z); }

Point 和 Vector 的不同

点可以被表示为 [s1,s2,s3,1][v1,v2,v3,p0]^T 或 [v1,v2,v3,p0][s1,s2,s3,1]^T

向量可以被表示为 [s1,s2,s3,0][v1,v2,v3,p0]^T 或 [v1,v2,v3,p0][s1,s2,s3,0]^T

向量和矩阵运算即向量在空间中变换时,平移变换不会改变向量。将向量的第四个分量赋值为 0,可以保证向量和矩阵的运算中向量不受坐标系原点变化的影响(平移变换)。

Normal 和 Vector 的不同

Normal 是垂直与表面的向量,对一个表面做矩阵变换后,为了保证 Normal 与表面依然垂直,需要对 Normal 使用不同的变换矩阵。

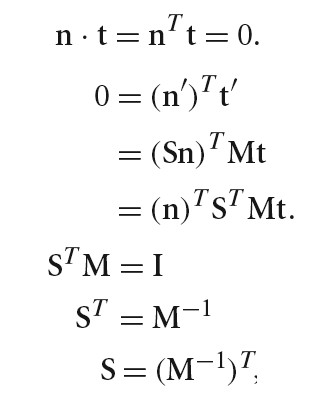

n 为原始平面 A 点处的法线,t为原始平面 A 点处法线 n 对应的切线,n'为变换后平面 A 点处的法线,t'为变换后平面 A 点处法线 n'对应的切线。

变换前满足条件 dot(n,t) = n^Tt = 0

变换后满足条件 dot(n',t') = n'^Tt' = 0

假设 S 为变换 Normal 的矩阵则有:

(Sn)^Tt'=0

(Sn)^TMt=0

n^TS^TMt=0 ==> S^TM = I ==> S^T=M^(-1) ==> S=(M^(-1))^T

Matrix

本书中使用了列向量,Matrix 和向量相乘时,向量在右边矩阵在左边。Matrix 每一列表示新坐标系的坐标轴的基向量。

代码中 Matrix 按照行主序(row-major)存储,和向量相乘时,Matrix 每行分别和向量相乘:

/* m[0][0] m[0][1] m[0][2] m[0][3] m[1][0] m[1][1] m[1][2] m[1][3] m[2][0] m[2][1] m[2][2] m[2][3] m[3][0] m[3][1] m[3][2] m[3][3] */ template <typename T> inline Point3<T> Transform::operator()(const Point3<T> &p) const { T x = p.x, y = p.y, z = p.z; T xp = m.m[0][0] * x + m.m[0][1] * y + m.m[0][2] * z + m.m[0][3]; T yp = m.m[1][0] * x + m.m[1][1] * y + m.m[1][2] * z + m.m[1][3]; T zp = m.m[2][0] * x + m.m[2][1] * y + m.m[2][2] * z + m.m[2][3]; T wp = m.m[3][0] * x + m.m[3][1] * y + m.m[3][2] * z + m.m[3][3]; CHECK_NE(wp, 0); if (wp == 1) return Point3<T>(xp, yp, zp); else return Point3<T>(xp, yp, zp) / wp; }

矩阵和行列式

- 数学家最初发明行列式和矩阵是为了解决什么问题? https://www.zhihu.com/question/19919917/answer/270694029

- 行列式与矩阵之间的深刻联系是什么? https://www.zhihu.com/question/31698184

- 行列式的本质是什么? https://www.zhihu.com/question/36966326/answer/70687817

- 行列式的计算方法 https://www.jianshu.com/p/99b9ac1c6162

- n 阶行列式 https://baike.baidu.com/item/n%E9%98%B6%E8%A1%8C%E5%88%97%E5%BC%8F

- 特征值和特征向量的意义? https://www.zhihu.com/question/29589753

逆矩阵求解

- 伴随矩阵 https://baike.baidu.com/item/%E4%BC%B4%E9%9A%8F%E7%9F%A9%E9%98%B5

- 逆矩阵 https://baike.baidu.com/item/%E9%80%86%E7%9F%A9%E9%98%B5

// 平移矩阵的逆矩阵 Transform Translate(const Vector3f &delta) { Matrix4x4 m(1, 0, 0, delta.x, 0, 1, 0, delta.y, 0, 0, 1, delta.z, 0, 0, 0, 1); Matrix4x4 minv(1, 0, 0, -delta.x, 0, 1, 0, -delta.y, 0, 0, 1, -delta.z, 0, 0, 0, 1); return Transform(m, minv); } // 缩放矩阵的逆矩阵 Transform Scale(Float x, Float y, Float z) { Matrix4x4 m(x, 0, 0, 0, 0, y, 0, 0, 0, 0, z, 0, 0, 0, 0, 1); Matrix4x4 minv(1/x, 0, 0, 0, 0, 1/y, 0, 0, 0, 0, 1/z, 0, 0, 0, 0, 1); return Transform(m, minv); } // 旋转矩阵的逆矩阵为旋转矩阵的转置矩阵

LookAt

Transform LookAt(const Point3f &pos, const Point3f &look, const Vector3f &up) { Matrix4x4 cameraToWorld; // Initialize fourth column of viewing matrix cameraToWorld.m[0][3] = pos.x; cameraToWorld.m[1][3] = pos.y; cameraToWorld.m[2][3] = pos.z; cameraToWorld.m[3][3] = 1; // Initialize first three columns of viewing matrix Vector3f dir = Normalize(look - pos); if (Cross(Normalize(up), dir).Length() == 0) { Error( "\"up\" vector (%f, %f, %f) and viewing direction (%f, %f, %f) " "passed to LookAt are pointing in the same direction. Using " "the identity transformation.", up.x, up.y, up.z, dir.x, dir.y, dir.z); return Transform(); } Vector3f right = Normalize(Cross(Normalize(up), dir)); Vector3f newUp = Cross(dir, right); cameraToWorld.m[0][0] = right.x; cameraToWorld.m[1][0] = right.y; cameraToWorld.m[2][0] = right.z; cameraToWorld.m[3][0] = 0.; cameraToWorld.m[0][1] = newUp.x; cameraToWorld.m[1][1] = newUp.y; cameraToWorld.m[2][1] = newUp.z; cameraToWorld.m[3][1] = 0.; cameraToWorld.m[0][2] = dir.x; cameraToWorld.m[1][2] = dir.y; cameraToWorld.m[2][2] = dir.z; cameraToWorld.m[3][2] = 0.; return Transform(Inverse(cameraToWorld), cameraToWorld); }

判断矩阵是否为透视矩阵

判断矩阵是否包含缩放

bool HasScale() const { Float la2 = (*this)(Vector3f(1, 0, 0)).LengthSquared(); Float lb2 = (*this)(Vector3f(0, 1, 0)).LengthSquared(); Float lc2 = (*this)(Vector3f(0, 0, 1)).LengthSquared(); #define NOT_ONE(x) ((x) < .999f || (x) > 1.001f) return (NOT_ONE(la2) || NOT_ONE(lb2) || NOT_ONE(lc2)); #undef NOT_ONE }

判断矩阵是否会将左手坐标系变为右手坐标系

bool Transform::SwapsHandedness() const { Float det = m.m[0][0] * (m.m[1][1] * m.m[2][2] - m.m[1][2] * m.m[2][1]) - m.m[0][1] * (m.m[1][0] * m.m[2][2] - m.m[1][2] * m.m[2][0]) + m.m[0][2] * (m.m[1][0] * m.m[2][1] - m.m[1][1] * m.m[2][0]); return det < 0; }

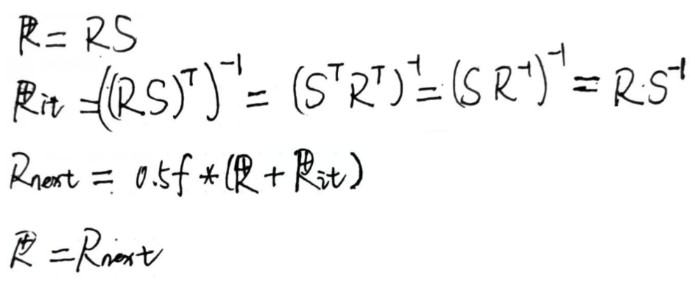

从矩阵中分离 TRS

void AnimatedTransform::Decompose(const Matrix4x4 &m, Vector3f *T, Quaternion *Rquat, Matrix4x4 *S) { // Extract translation _T_ from transformation matrix T->x = m.m[0][3]; T->y = m.m[1][3]; T->z = m.m[2][3]; // Compute new transformation matrix _M_ without translation Matrix4x4 M = m; for (int i = 0; i < 3; ++i) M.m[i][3] = M.m[3][i] = 0.f; M.m[3][3] = 1.f; // Extract rotation _R_ from transformation matrix Float norm; int count = 0; Matrix4x4 R = M; do { // Compute next matrix _Rnext_ in series Matrix4x4 Rnext; Matrix4x4 Rit = Inverse(Transpose(R)); for (int i = 0; i < 4; ++i) for (int j = 0; j < 4; ++j) Rnext.m[i][j] = 0.5f * (R.m[i][j] + Rit.m[i][j]); // Compute norm of difference between _R_ and _Rnext_ norm = 0; for (int i = 0; i < 3; ++i) { Float n = std::abs(R.m[i][0] - Rnext.m[i][0]) + std::abs(R.m[i][1] - Rnext.m[i][1]) + std::abs(R.m[i][2] - Rnext.m[i][2]); norm = std::max(norm, n); } R = Rnext; } while (++count < 100 && norm > .0001); // XXX TODO FIXME deal with flip... *Rquat = Quaternion(R); // Compute scale _S_ using rotation and original matrix *S = Matrix4x4::Mul(Inverse(R), M); }

3 Shapes

AABB`

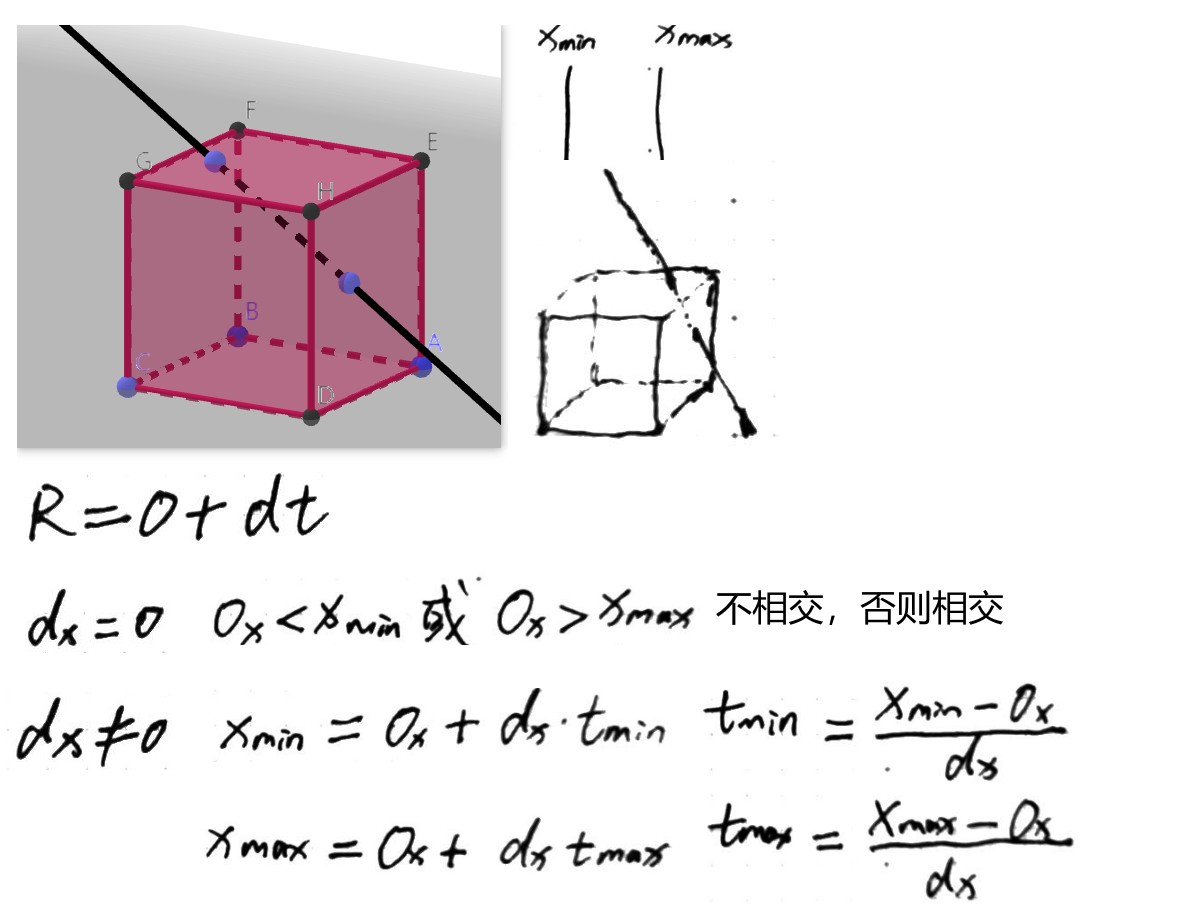

AABB 和射线求交点

参考项目 unitycatlikecoding\RenderingAndAdvancedR\Assets\MyTest\08BoundingBoxAlgorithm 中计算。

template <typename T> inline bool Bounds3<T>::IntersectP(const Ray &ray, Float *hitt0, Float *hitt1) const { Float t0 = 0, t1 = ray.tMax; for (int i = 0; i < 3; ++i) { // Update interval for _i_th bounding box slab Float invRayDir = 1 / ray.d[i]; Float tNear = (pMin[i] - ray.o[i]) * invRayDir; Float tFar = (pMax[i] - ray.o[i]) * invRayDir; // Update parametric interval from slab intersection $t$ values if (tNear > tFar) std::swap(tNear, tFar); // Update _tFar_ to ensure robust ray--bounds intersection tFar *= 1 + 2 * gamma(3); t0 = tNear > t0 ? tNear : t0; // tFar为无穷大时,t1=t1=ray.tMax t1 = tFar < t1 ? tFar : t1; if (t0 > t1) return false; } if (hitt0) *hitt0 = t0; if (hitt1) *hitt1 = t1; return true; } template <typename T> inline bool Bounds3<T>::IntersectP(const Ray &ray, const Vector3f &invDir, const int dirIsNeg[3]) const { const Bounds3f &bounds = *this; // Check for ray intersection against $x$ and $y$ slabs // 求xAxis yAxis方向ray和BoundBox的相交区域 Float tMin = (bounds[dirIsNeg[0]].x - ray.o.x) * invDir.x; Float tMax = (bounds[1 - dirIsNeg[0]].x - ray.o.x) * invDir.x; Float tyMin = (bounds[dirIsNeg[1]].y - ray.o.y) * invDir.y; Float tyMax = (bounds[1 - dirIsNeg[1]].y - ray.o.y) * invDir.y; // Update _tMax_ and _tyMax_ to ensure robust bounds intersection tMax *= 1 + 2 * gamma(3); tyMax *= 1 + 2 * gamma(3); // xAxis方向上的相交区域向yAxis方向延伸 yAxis方向上的相交区域向xAxis方向延伸 如果两个延伸后的区域不相交 说明ray和BoundingBox不相交 if (tMin > tyMax || tyMin > tMax) return false; if (tyMin > tMin) tMin = tyMin; if (tyMax < tMax) tMax = tyMax; // Check for ray intersection against $z$ slab Float tzMin = (bounds[dirIsNeg[2]].z - ray.o.z) * invDir.z; Float tzMax = (bounds[1 - dirIsNeg[2]].z - ray.o.z) * invDir.z; // Update _tzMax_ to ensure robust bounds intersection tzMax *= 1 + 2 * gamma(3); if (tMin > tzMax || tzMin > tMax) return false; if (tzMin > tMin) tMin = tzMin; if (tzMax < tMax) tMax = tzMax; return (tMin < ray.tMax) && (tMax > 0); }

下面文章对算法解释的很清楚:

- 射线与包围盒的相交测试 https://zhuanlan.zhihu.com/p/138259656

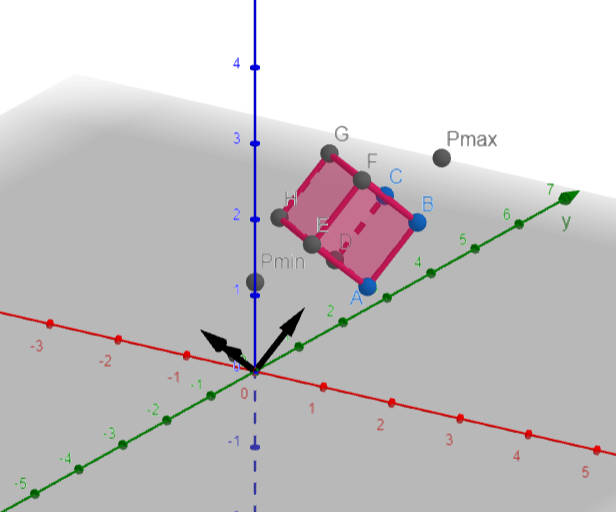

transform AABB

- 方法 1

- 方法 2

Vector3f xa = m_col0 * b.pMin.x; Vector3f xb = m_col0 * b.pMax.x; Vector3f ya = m_col1 * b.pMin.y; Vector3f yb = m_col1 * b.pMax.y; Vector3f za = m_col2 * b.pMin.z; Vector3f zb = m_col2 * b.pMax.z; float w = m[3][3]; Vector3f pmin_ = Min(xa,xb) + Min(ya,yb) + Min(za,zb) + m_col3; Vector3f pmax_ = Max(xa,xb) + Max(ya,yb) + Max(za,zb) + m_col3; box.pMin = {pmin_.x/w,pmin_.y/w,pmin_.z/w}; box.pMax = {pmax_.x/w,pmax_.y/w,pmax_.z/w}; return box;

./PhysicallyBasedRendering/trans-bbox.ggb

- 快速变换 AABB https://zhuanlan.zhihu.com/p/116051685

- 快速变换 AABB https://zhuanlan.zhihu.com/p/116051685

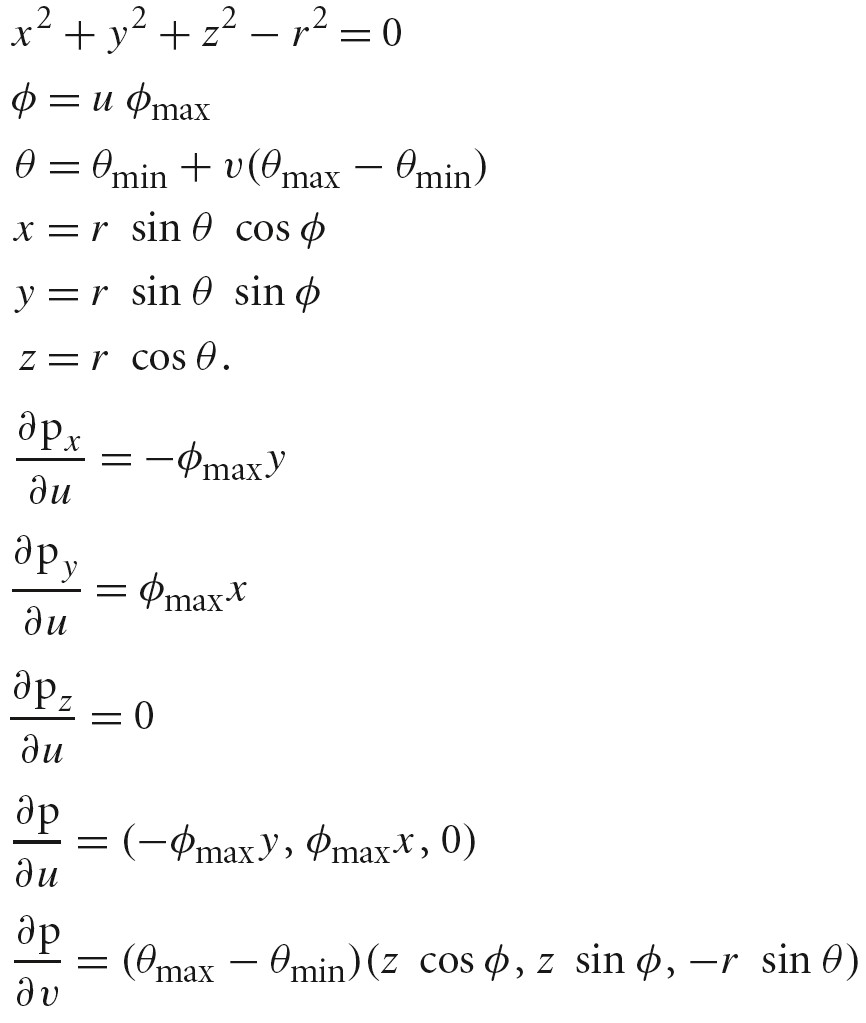

Sphere Shape

x^2+y^2+z^2 = 1 单位球

x^2+y^2+z^2 = r^2 半径为 r 的球

f(Θ,Φ) 形式

x = rsin(Θ)cos(Φ)

y = rsin(Θ)sin(Θ)

z = rcos(Θ)

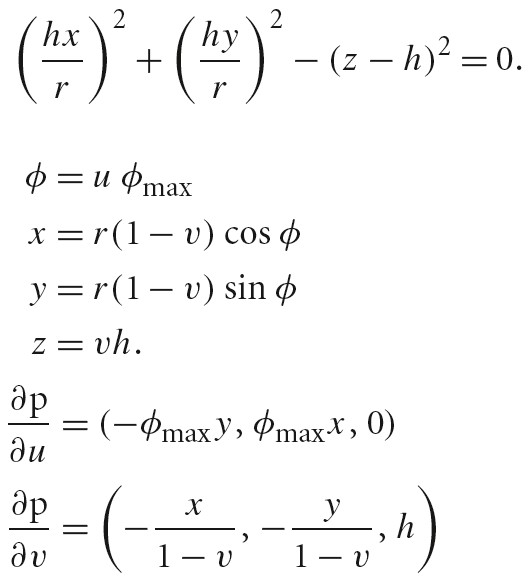

f(u, v)形式

Φ = uΦmax

Θ = Θmin + v(Θmax-Θmin)

下面链接可以求解偏导数:

曲面面积求解

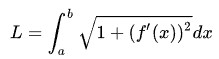

曲线长度求解

任意光滑曲线绕 x 轴旋转一周得到的旋转曲面的面积

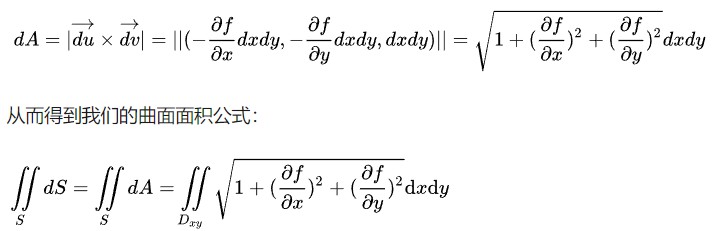

一般曲面面积求解,下图为曲面面积公式

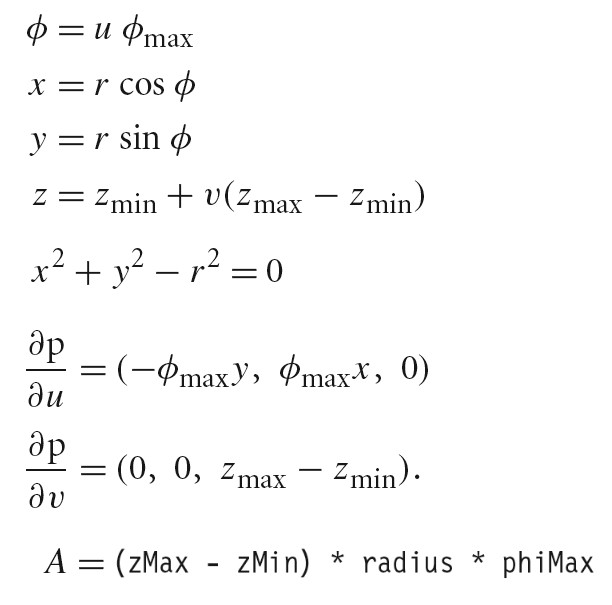

Cylinder Shape

x^2+y^2-r^2 = 0

Φ = uΦmax

x = rcos(Φ)

y = rsin(Φ)

z = zmin + v(zmax-zmin)

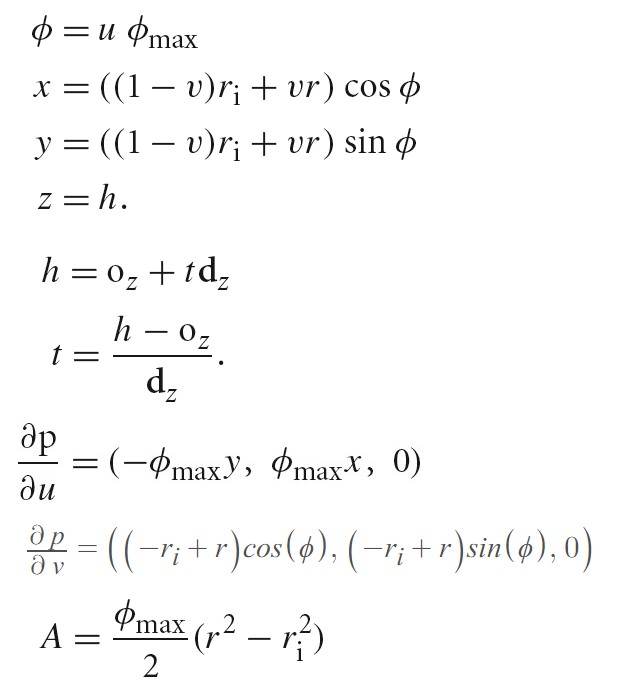

Disk

Φ = uΦmax

x = ((1-v)ri + vr)cos(Φ)

y = ((1-v)ri + vr)sin(Φ)

z = h

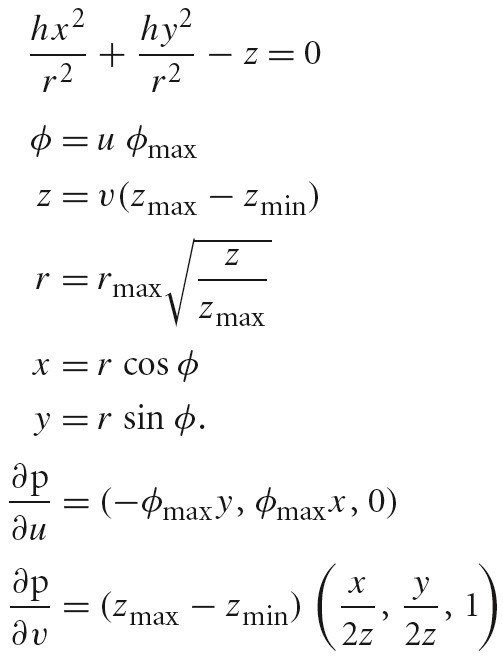

Paraboloid

- 旋转抛物面方程怎么写? https://www.zhihu.com/question/387696812

- 椭圆抛物面和双曲抛物面的方程怎么推导出来的? https://www.zhihu.com/question/312954498/answer/1091698001

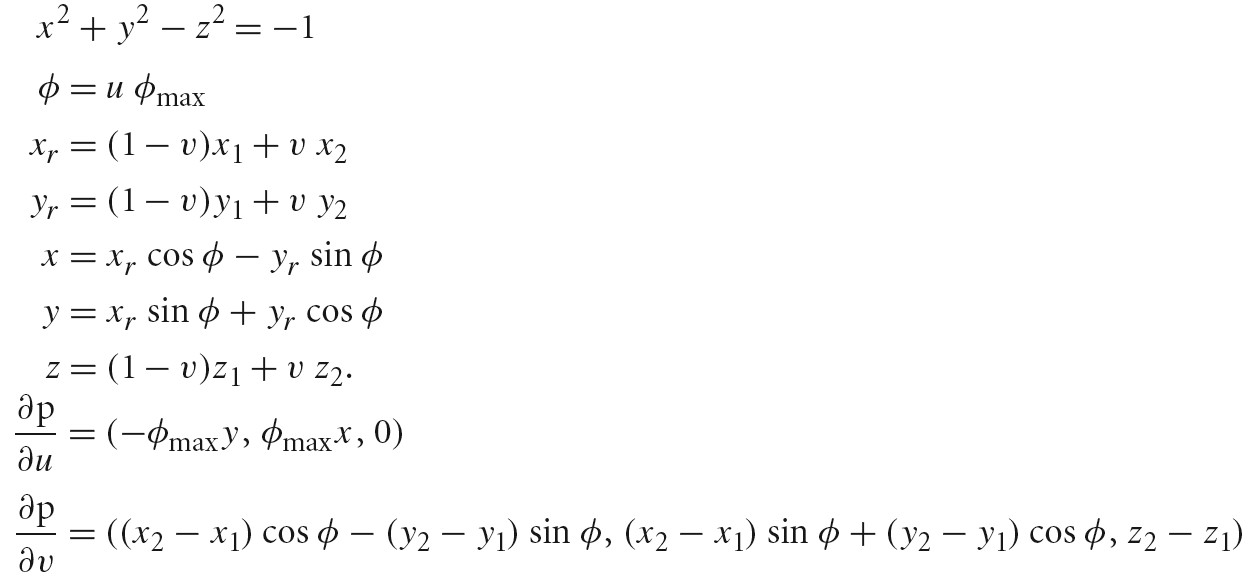

Hyperboloid

Triangle Meshes

对于简单多面体 V-E+F=2

对于任意多面体 f(p)=V-E+F

V=vertex, E=edge, F=face

由三角形构成的物体 E=F*3/2 (由三角形构成的物体,其每个边都属于两个面,而其一共有 F 个面,所以这样的边一共有 3F 个,又每个边属于两个面,所以每个面多计算一次,所以最终的边数量为 F*3/2)

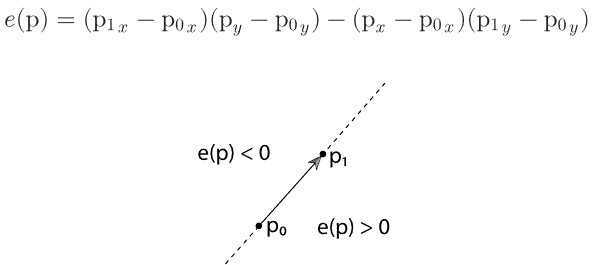

Triangle

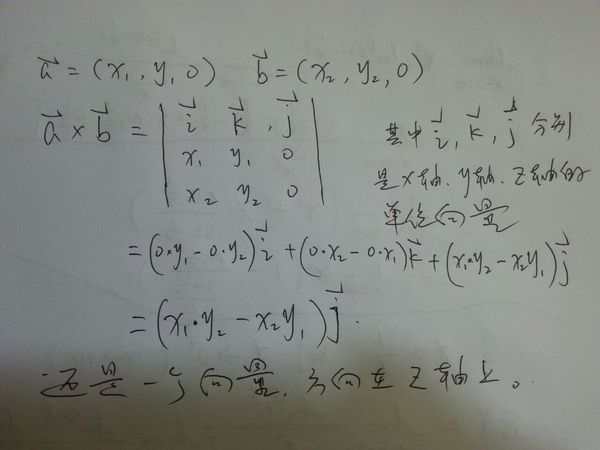

e(p) 边函数给出了 p0,p1 和给定点 p 围成的三角形的面积,其利用了向量的叉乘。上面图中边函数 e(p)为 2 维向量的叉乘的结果。

下面文件展示了 e(p)和 面积的关系:

./PhysicallyBasedRendering/20_05_19_edge_equ.ggb

- 点积和叉乘的出现背景是什么? https://www.zhihu.com/question/349692615

- 二维向量叉乘公式 https://zhidao.baidu.com/question/679880157161377532.html

- 矩阵求逆 https://www.mathsisfun.com/algebra/matrix-inverse.html

- 判断点是否在三角形内 https://www.cnblogs.com/graphics/archive/2010/08/05/1793393.html

- 重心坐标系 https://www.scratchapixel.com/lessons/3d-basic-rendering/ray-tracing-rendering-a-triangle/barycentric-coordinates

Float Triangle::Area() const { //Get triangle vertices in p0, p1, and p2 return 0.5 * Cross(p1 - p0, p2 - p0).Length(); }

pbrt 中,TriangleMesh 在构造函数中会将所有顶点位置、法线、切线都转换到世界空间。所以,Triangle 的 WorldBound 不需要执行变换,而 ObjectBound 则需要变换回物体空间。

Bounds3f Triangle::ObjectBound() const { // Get triangle vertices in _p0_, _p1_, and _p2_ const Point3f &p0 = mesh->p[v[0]]; const Point3f &p1 = mesh->p[v[1]]; const Point3f &p2 = mesh->p[v[2]]; return Union(Bounds3f((*WorldToObject)(p0), (*WorldToObject)(p1)), (*WorldToObject)(p2)); } Bounds3f Triangle::WorldBound() const { // Get triangle vertices in _p0_, _p1_, and _p2_ const Point3f &p0 = mesh->p[v[0]]; const Point3f &p1 = mesh->p[v[1]]; const Point3f &p2 = mesh->p[v[2]]; return Union(Bounds3f(p0, p1), p2); }

Curve

Curve 的表示

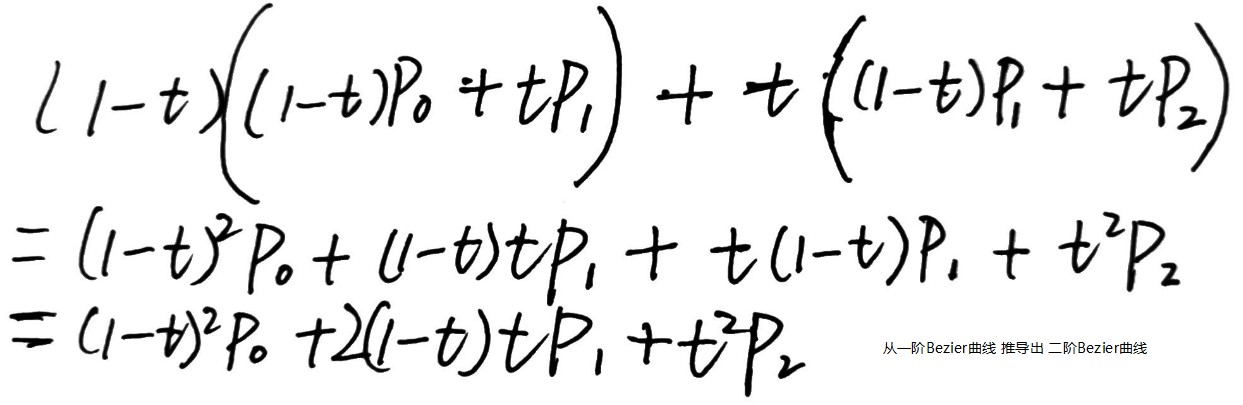

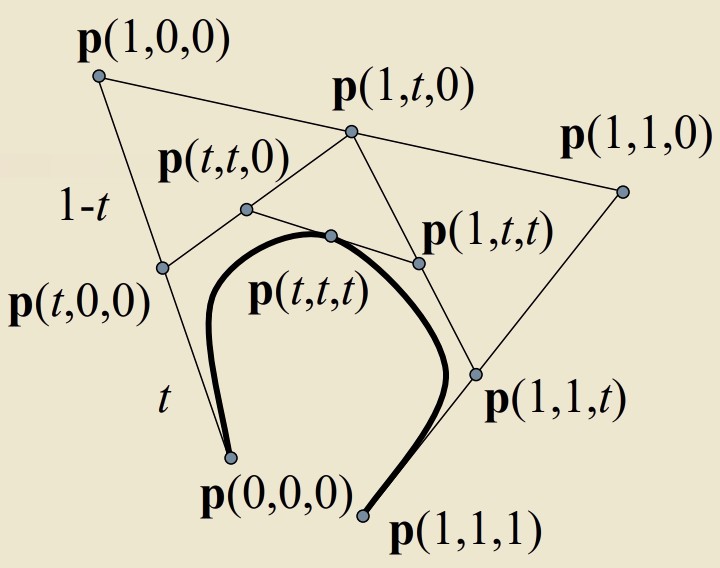

n 阶的贝塞尔曲线,是两个 n-1 阶贝塞尔曲线之间的插值

下图演示了从一阶 Bezier 曲线导出二阶 Bezier 曲线:

./PhysicallyBasedRendering/00_03_bezier_curve.ggb

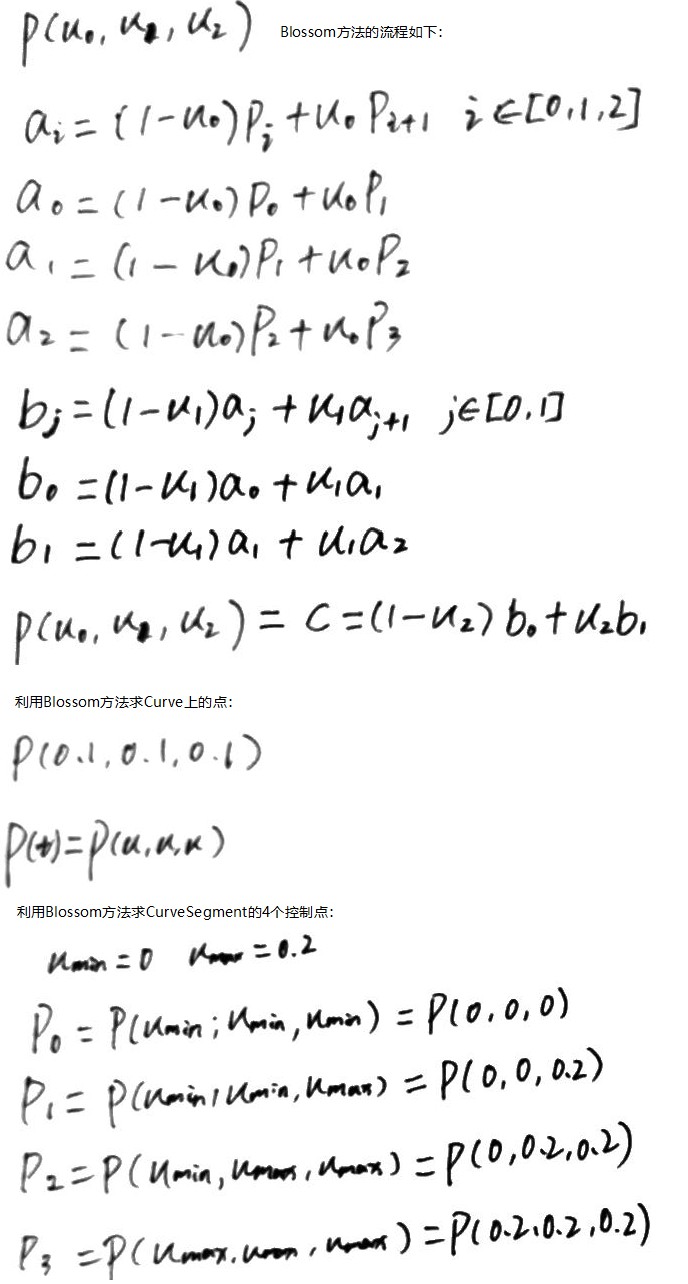

将一条 BezierCurve 分为多段,可以通过 Blossoming 来确定每一段 BezierCurve 的控制点

// p[4] 为BezierCurve的4个控制点 static Point3f BlossomBezier(const Point3f p[4], Float u0, Float u1, Float u2) { Point3f a[3] = {Lerp(u0, p[0], p[1]), Lerp(u0, p[1], p[2]), Lerp(u0, p[2], p[3])}; Point3f b[2] = {Lerp(u1, a[0], a[1]), Lerp(u1, a[1], a[2])}; return Lerp(u2, b[0], b[1]); } // 下面代码求出了当前子段Curve对应的控制点 TODO Why? Point3f cpObj[4]; cpObj[0] = BlossomBezier(common->cpObj, uMin, uMin, uMin); cpObj[1] = BlossomBezier(common->cpObj, uMin, uMin, uMax); cpObj[2] = BlossomBezier(common->cpObj, uMin, uMax, uMax); cpObj[3] = BlossomBezier(common->cpObj, uMax, uMax, uMax);

- 贝塞尔曲线 https://zh.wikipedia.org/wiki/%E8%B2%9D%E8%8C%B2%E6%9B%B2%E7%B7%9A

- Bezier Blossoms https://courses.engr.illinois.edu/cs418/fa2018/slides/10-5%20Bezier%20Blossoms.pdf

- Blossom https://en.wikipedia.org/wiki/Blossom_(functional)

- A Primer on Bézier Curves https://pomax.github.io/bezierinfo/

Curve Intersect

// 创建 Curve 时会直接将 Curve 分成多段,各段 Curve 公共的信息会存储在 CurveCommon 类中,每个分段的信息存储在 Curve 类中。 // // 下面开始描述 每个分段 Curve 的 Intersect // 通过 BlossomBezier 方法可以求出当前 Curve 类对应的控制点数据 // 将控制点数据转换到求交坐标系下 (Ray.dir 为坐标系 zAxis,控制点 p3-p0 为坐标系 yAxis,Ray 和 Curve 的交点坐标为(0,0)) // 计算后续递归求交点的深度 // 创建 Ray 和当前 Curve 段的 BoundingBox,如果 BoundingBox 不重叠,则说明 Ray 和当前 Curve 段没交点 // 将当前 Curve 段继续从中间分为两段子 Curve,分别对子 Curve 段求与 Ray 的交点 // // 下面开始描述 子 Curve 段的 Intersect // 对子 Curve 段进行求导可以得出子 Curve 段的导数函数,利用导数函数求出 p0 和 p3 点的切线,再利用切线求出 p0 和 p3 点垂直与切线的向量,则得到子 Curve 段两端点处的垂直向量 // 以垂直向量为边,判断交点(0,0)是否在垂直向量正确的一侧,如果不在,说明没有交点。 // 将交点(0,0)投影到 p0p3 直线上,近似求出交点在子 Curve 段上的 u 值,代码中记作 w // 通过 w 可以计算出交点(0,0)在整段 Curve 上的 u 值,代码中记作 u,使用 u 可以计算出交点处 Curve 的宽度 // 如果 CurveType 为 Ribbon,需要将 Curve 的宽度进行 Slerp,最终将交点处 Curve 的宽度记作 hitWidth // // 测试交点和 Curve 的宽度 // 计算出子 Curve 段上 w 处的坐标值,该点近似为交点在子 Curve 段上的投影点,代码中记作 pc,同时求得 pc 点处的切线,代码中记作 dpcdw // 计算投影点到交点(0,0)的距离,如果距离大于 hitWidth/2,说明交点不在子 Curve 段的曲面上,如果投影点 pc.z<0 || pc.z>zMax 也说明交点不在子 Curve 段的曲面上 // // 计算交点的 v 值 // 以 pc 和 dpcdw 为边,判断交点(0,0)在边的哪一侧,从而求出对应的 v 值 // // 计算 t 以及交点处的导数

Subdivision Surfaces

Subdivision 的优点

- Subdivision Surface 比多边形 Mesh 要平滑

- 大多数现存的基础设施建模系统可以被重定向为 Subdivision,经典的多边形建模工具可用于构建 Subdivision 控制模型

- Subdivision 方法通常是基于样条的表面表示的一般化。

- 通过在局部增加控制表面就可以很容易地为局部区域增加细节,这对于样条表现形式则比较困难

Mesh 的表示

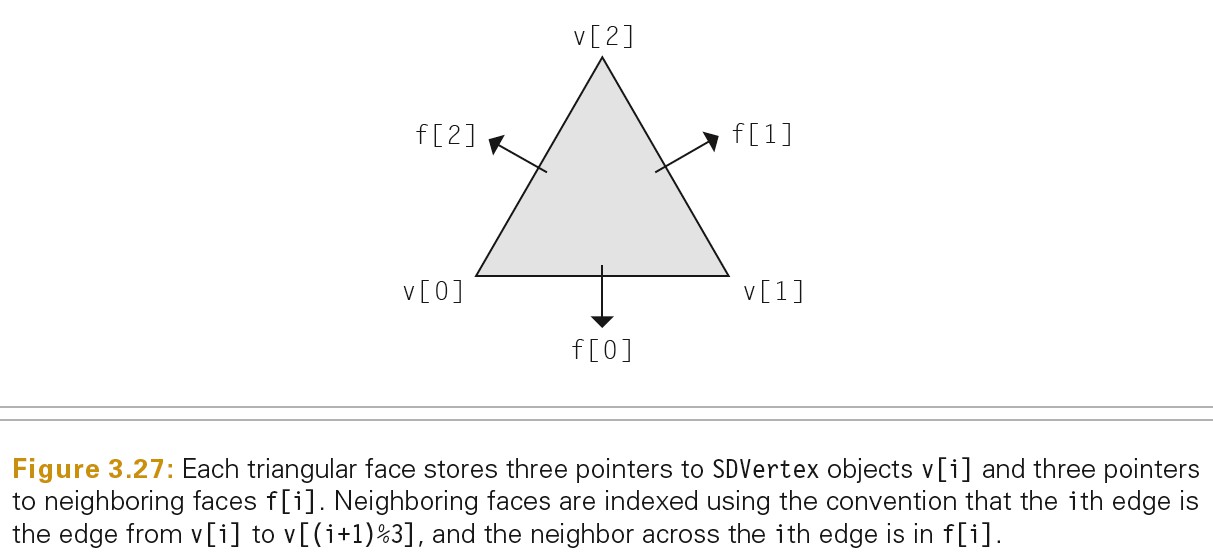

SDFace 表示 subdivision mesh 的三角面

SDVertex 表示 subdivision mesh 的顶点

subdivision mesh 可以是封闭的 mesh 也可以是开放的 mesh

- 封闭的 mesh 没有边界,所有的面在每个边上都有邻接面,即每个面都有 3 个邻接面

- 开放的 mesh 有边界

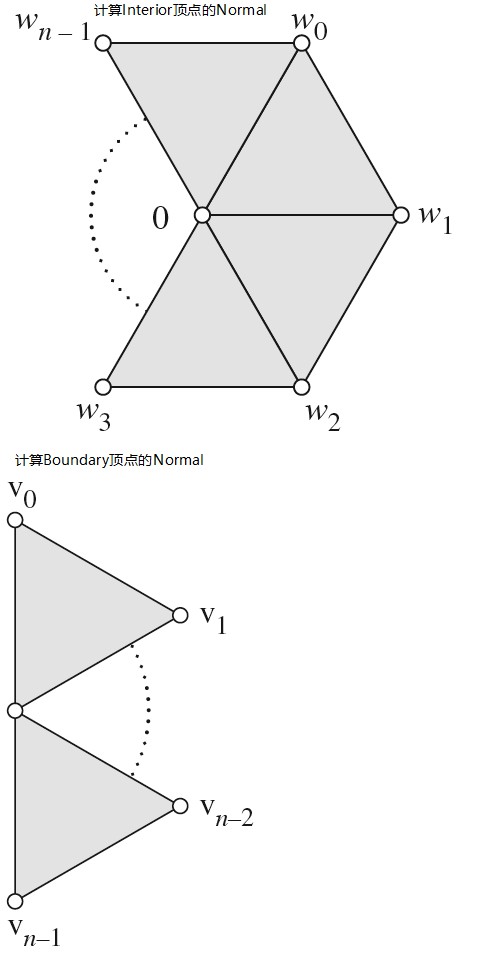

在 mesh 内部的,大部分顶点有 6 个邻接面,有 6 个邻接顶点

在开放 mesh 的边界上,大多数顶点有 3 个邻接面,有 4 个邻接顶点

顶点的邻接顶点数量被称为该顶点的 valence

valence 值大于 6 的内部顶点,和 valence 值大于 4 的边界顶点被称为 Extraordinary Vertices;否则为 Regular Vertices.

Loop Subdivision 表面在所有地方都是平滑的,除了在 Extraordinary Vertices 处。

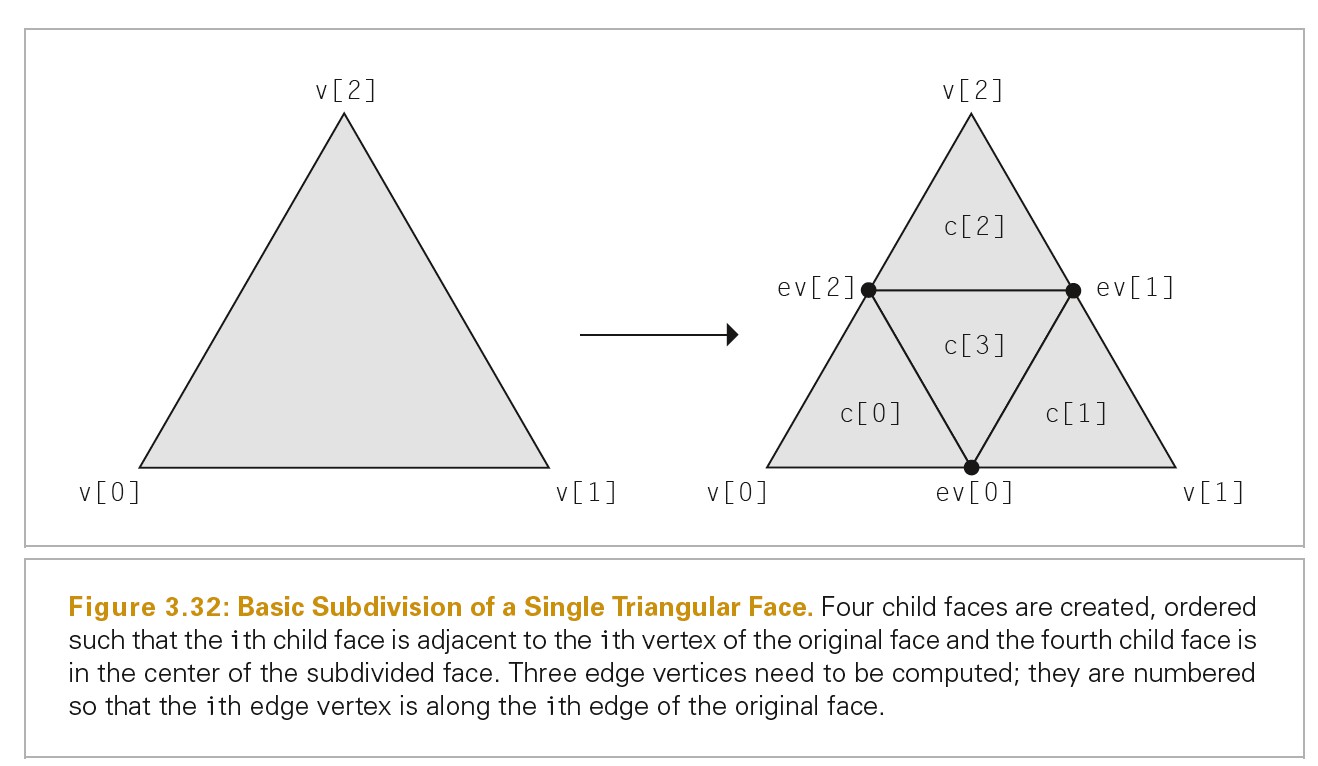

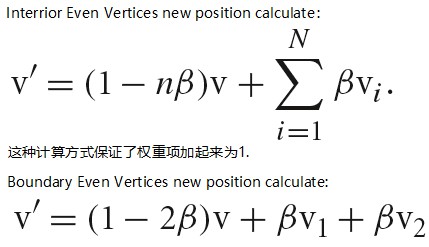

原来在 Mesh 中已经存在的点被称为 Even Vertices(SDVertex.child 指向的 vertex),分割边的新的顶点被称为 Odd Vertices(SDFace.children[].v[]数组中的某个 vertex);

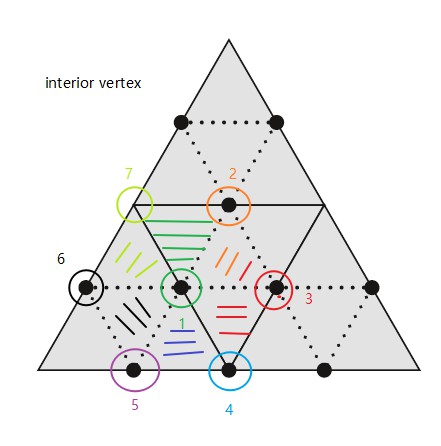

下图表示了 SDFace 中顶点和邻接面数据的拓扑结构

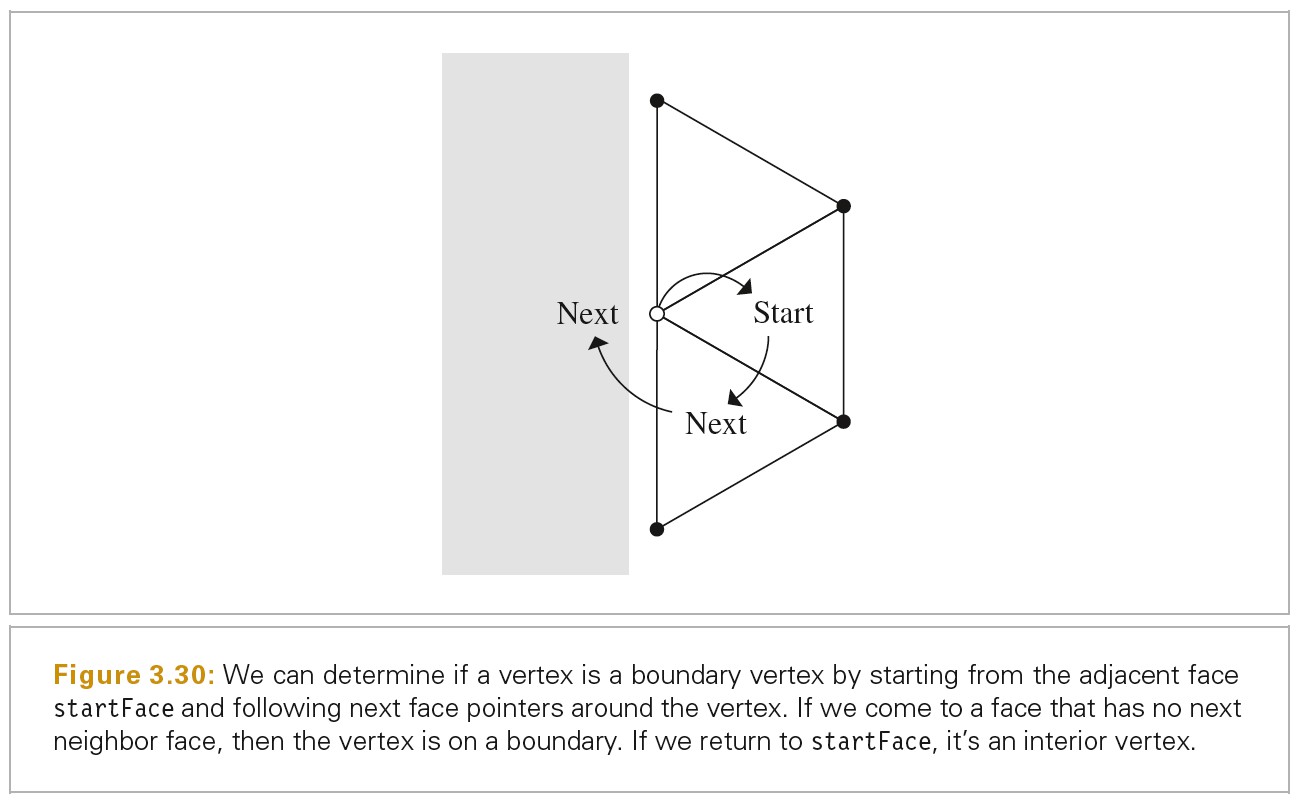

下图表示了判断顶点是否在边界上

对控制 Mesh 进行 Subdivision 后,每个 SDVertex 有一个 children SDVertex,每个 SDFace 有 4 个 children SDFace

计算顶点的 valence 值

// 计算顶点的valence值 inline int SDVertex::valence() { SDFace *f = startFace; if (!boundary) { // Compute valence of interior vertex int nf = 1; while ((f = f->nextFace(this)) != startFace) ++nf; return nf; } else { // Compute valence of boundary vertex int nf = 1; while ((f = f->nextFace(this)) != nullptr) ++nf; f = startFace; while ((f = f->prevFace(this)) != nullptr) ++nf; return nf + 1; } }

计算顶点周围一圈的顶点

void SDVertex::oneRing(Point3f *p) { if (!boundary) { // Get one-ring vertices for interior vertex SDFace *face = startFace; do { *p++ = face->nextVert(this)->p; face = face->nextFace(this); } while (face != startFace); } else { // Get one-ring vertices for boundary vertex SDFace *face = startFace, *f2; while ((f2 = face->nextFace(this)) != nullptr) face = f2; *p++ = face->nextVert(this)->p; do { *p++ = face->prevVert(this)->p; face = face->prevFace(this); } while (face != nullptr); } }

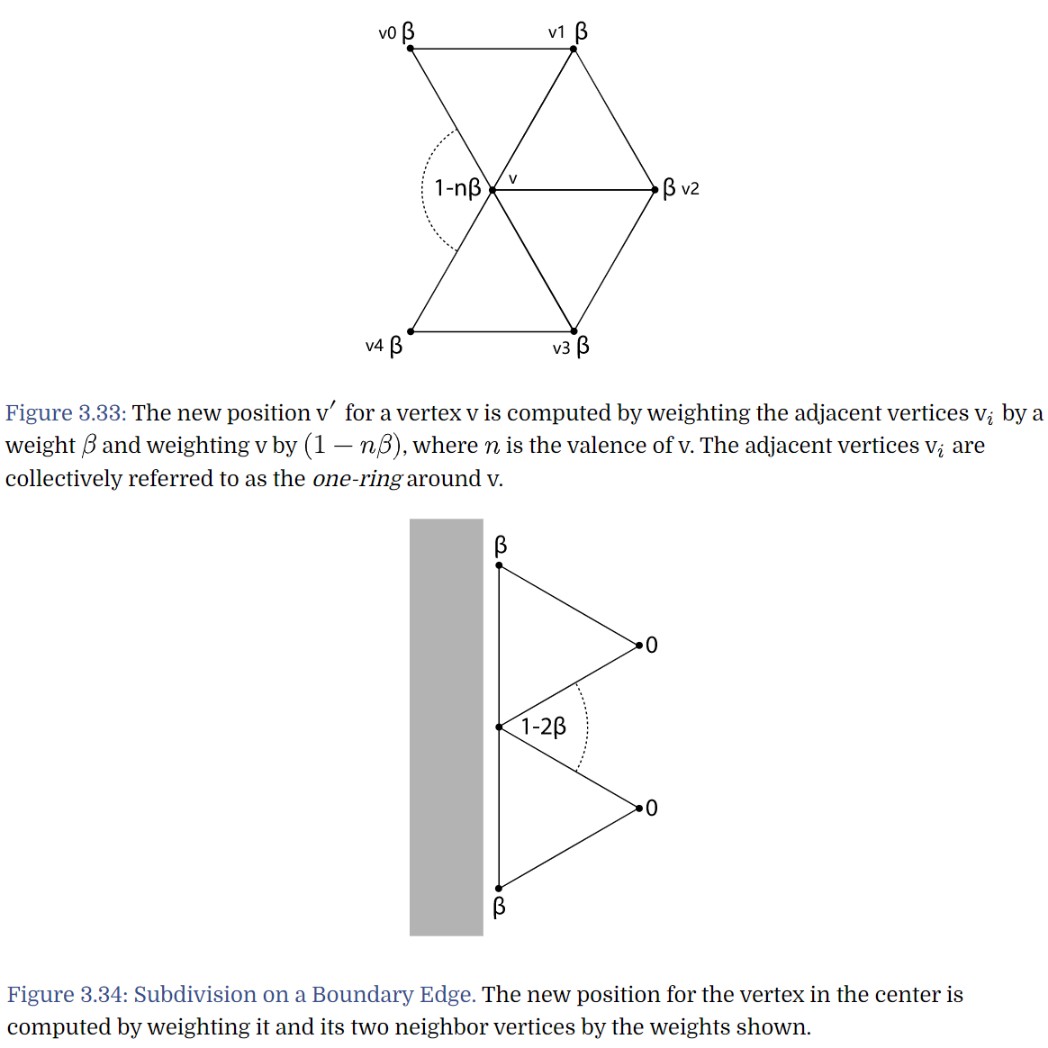

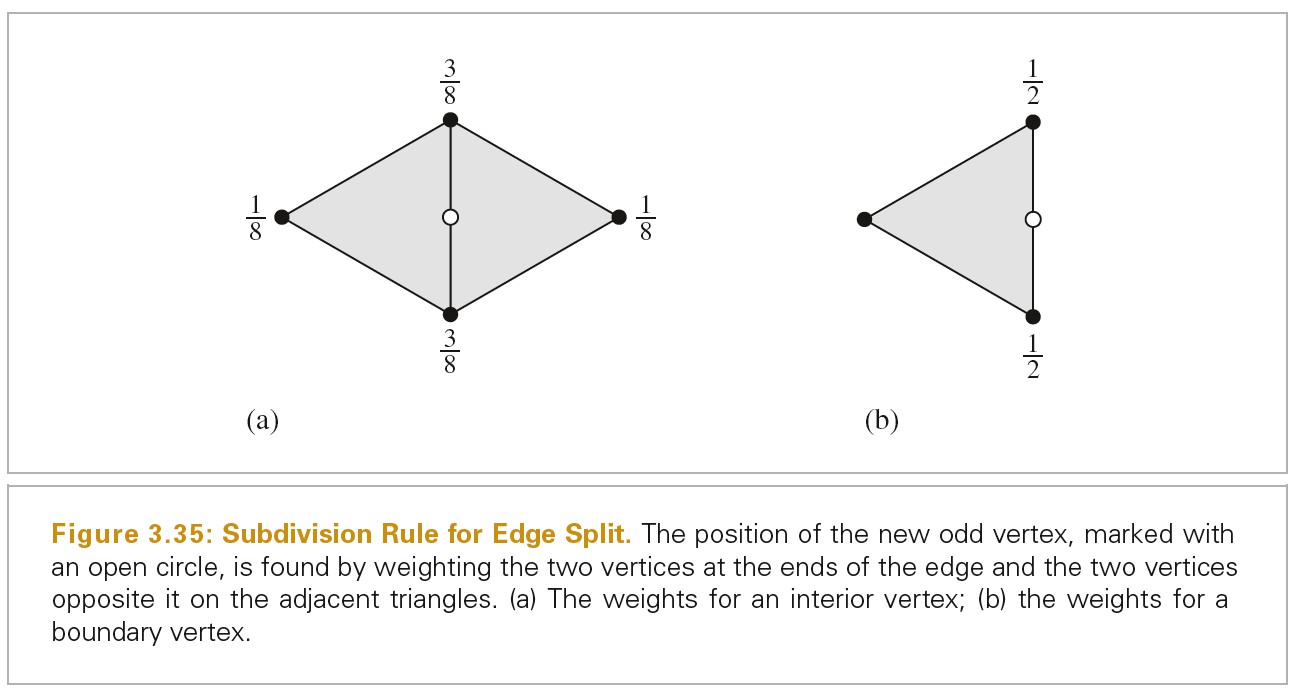

下图展示了计算非边界顶点周围一圈顶点的过程:

计算顶点新的坐标

计算顶点的 Normal

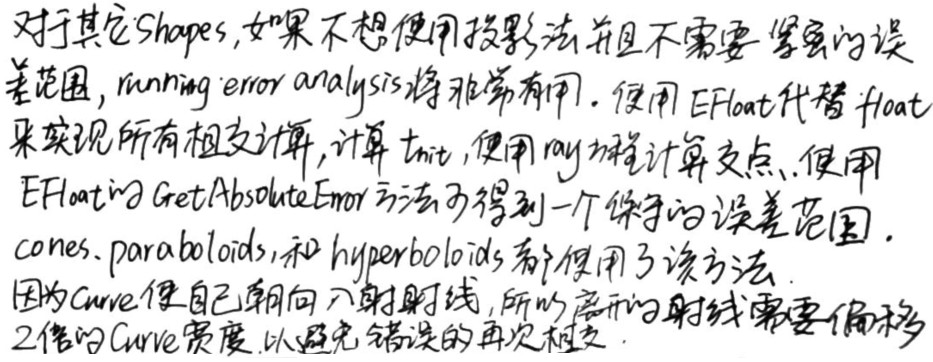

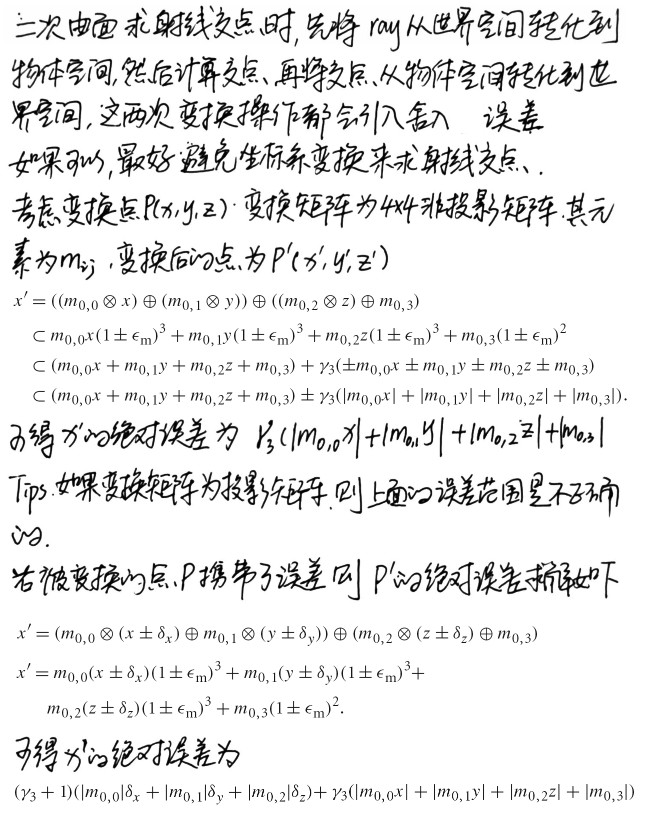

Managing Rounding Error

浮点数的算术

无法在有限的内存中表示无限的实数。

- 定点数

一种有限表示实数的方法是使用定点数。以 16 位整型表示实数 [0, 65535/256] = [0, 255+255/256],这种表示的精度为 1/256

定点数可以使用整数算术运算高效实现,但是,其可以表示的最大数是有限的,而且不能精确地表示接近零的很小的数

- 浮点数

浮点数表示法,使用一个符号(sign),一个尾数(significand),以及一个指数(exponent)。这种表示法和科学计数相似,但是有效位数和指数是固定的数字。

IEEE 标准规定,32 位浮点数通过一位符号位,8位指数,23 位尾数

- 将 Float 转化为 UInt32

// 方法1 现代版本的c++已经禁止了这种方式,为了让编译器可以更积极地对代码进行优化 float f = ...; uint32_t bits = *((uint32_t *)&f); // 方法2 现代版本的c++规定,从union读取的元素和上一次赋值的元素不同为未定义行为 union FloatBits { float f; uint32_t ui; } FloatBits fb; fb.f = ...; uint32_t bits = fb.ui; // 方法3 inline uint32_t FloatToBits(float f) { uint32_t ui; memcpy(&ui, &f, sizeof(float)); return ui; } inline float BitsToFloat(uint32_t ui) { float f; memcpy(&f, &ui, sizeof(uint32_t)); return f; }

- Bump Float Value

// 浮点数二进制表示的连续性支持了下面的这些方法 // 求下一个比当前float值大的值 inline float NextFloatUp(float v) { // Handle infinity and negative zero for _NextFloatUp()_ if (std::isinf(v) && v > 0.) return v; if (v == -0.f) v = 0.f; // Advance _v_ to next higher float uint32_t ui = FloatToBits(v); if (v >= 0) ++ui; else --ui; return BitsToFloat(ui); } // 求下一个比当前float小的值 inline float NextFloatDown(float v) { // Handle infinity and positive zero for _NextFloatDown()_ if (std::isinf(v) && v < 0.) return v; if (v == 0.f) v = -0.f; uint32_t ui = FloatToBits(v); if (v > 0) --ui; else ++ui; return BitsToFloat(ui); }

- Running Error Analysis

- 将 Float 转化为 UInt32

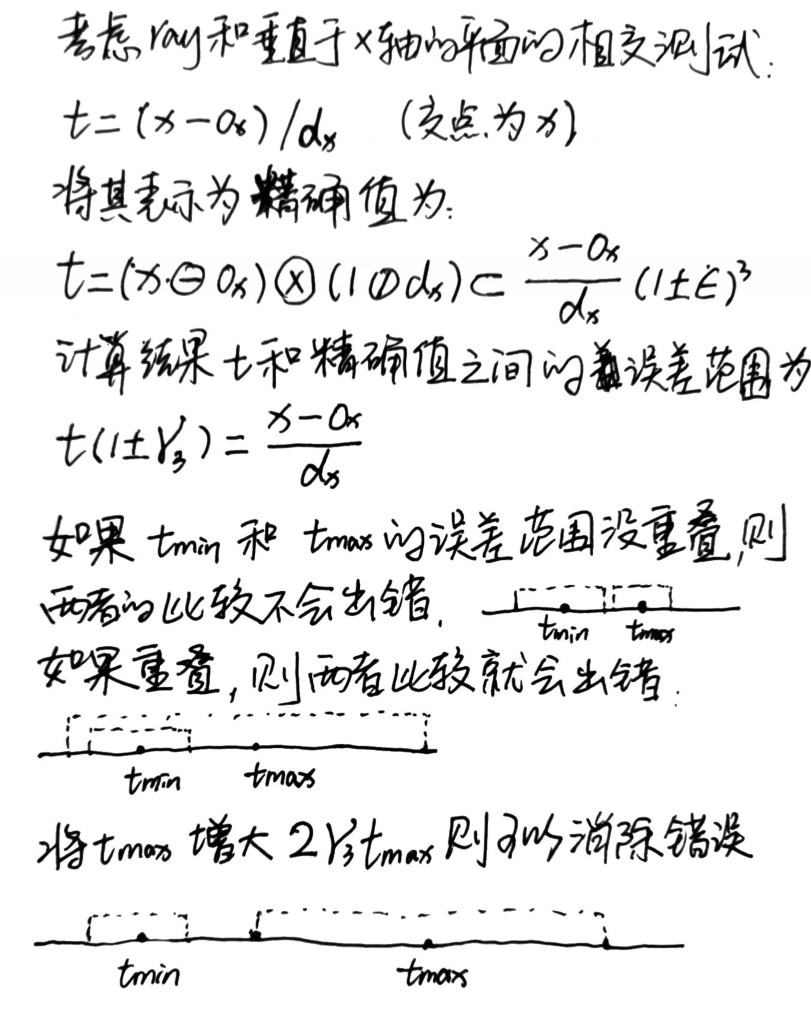

保守的 Ray-Bounds 相交计算

在 Ray-BoundingBox 相交计算中,我们沿着 Ray 方向找到进入 BoundingBox 的交点处的 tmin,然后找到离开 BoundingBox 的交点处的 tmax,如果 tmin<tmax说明有交点,否则说明无交点。

使用浮点数计算,可能会导致错误,使得相交测试失败。

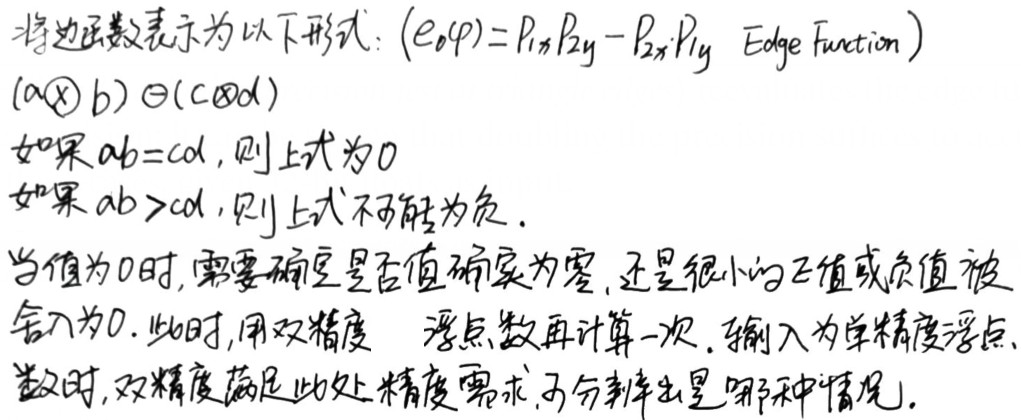

Robust Triangle Intesections

三角形和射线相交计算中,将三角形转化到求交坐标系下,使用重心坐标判断射线和三角形是否相交,避免了上面计算方式导致的误差。尽管错误可以从三角形转化到求交坐标系时产生,但是该错误不会影响相交测试,因为相同的变换被应用于所有的三角形(这个误差非常小,不会明显影响交点计算的精确性)。

该算法的关键在于使用浮点算术运算,edge 函数可以保证有正确的符号。

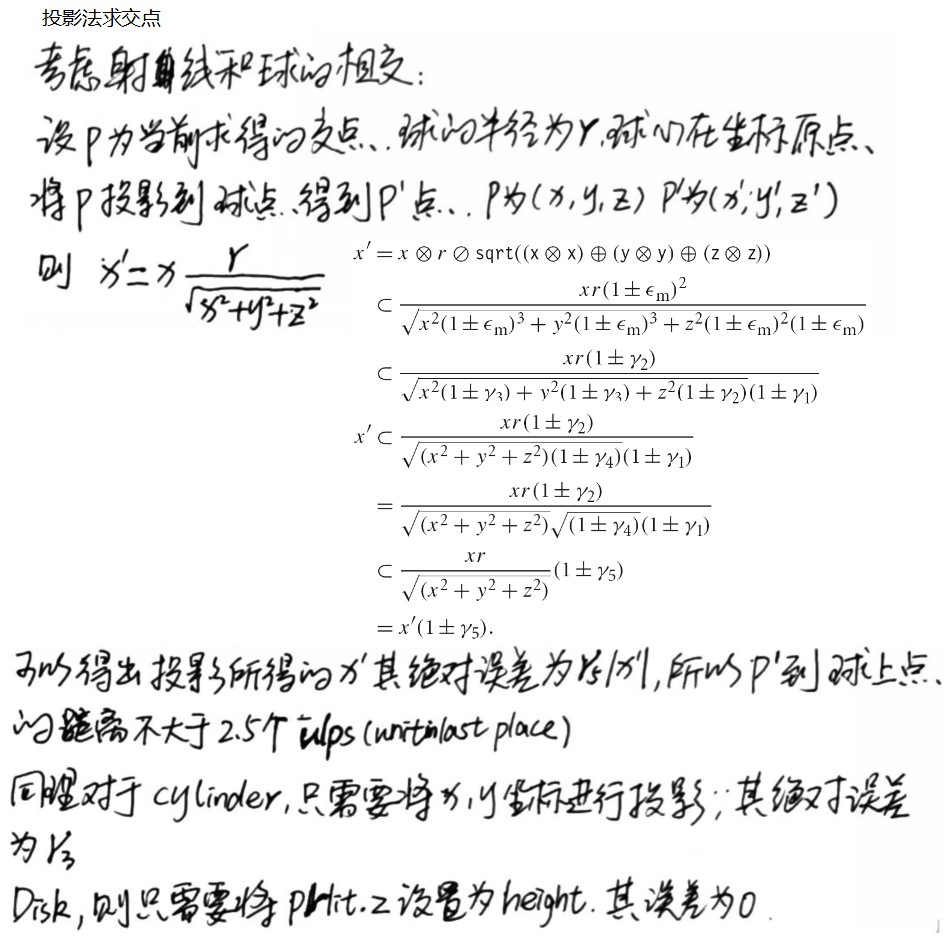

Bounding Intersection Point Error

下图分析了按照普通方法求 Ray 和 Shape 交点的误差:

下图展示了使用投影法求交点:

下图展示了三角形和射线交点的求解:

下图展示了其他 Shape 交点求解:

下图展示了矩阵变换引入的误差:

Robust Spawned Ray Origins

下图展示了 SpawnRay 时,Ray Origin 的计算

inline Ray Transform::operator()(const Ray &r, Vector3f *oError, Vector3f *dError) const { Point3f o = (*this)(r.o, oError); Vector3f d = (*this)(r.d, dError); Float tMax = r.tMax; Float lengthSquared = d.LengthSquared(); if (lengthSquared > 0) { Float dt = Dot(Abs(d), *oError) / lengthSquared; o += d * dt; // tMax -= dt; } return Ray(o, d, tMax, r.time, r.medium); }

Avoiding Intersections Behind Ray Origins

下图展示了 RayBoundingBox 交点计算中,舍入操作没有影响到交点计算精确性:

下图展示了 Ray Triangle 计算中,如何避免在 Ray 原点后产生交点:

4 Primitives and intersection acceleration

Primitive Interface And Geometric Primitives

抽象类 Primitive 是几何处理和渲染子系统的桥梁。

Instanceing 的支持是在 TransformedPrimitive 中实现的,其包含 AnimatedTransforms 属性,将 Shape 变换到不同的世界坐标从而实现 Instancing。刚体动画也是这样实现的。

Aggregates

概括来说,主要有两种加速射线追踪的方案:空间分割和物体分割。

空间分割将三维空间划分为多个区域(在场景上对轴对齐的 Box 进行迭代),并且记录在每个区域中有哪些物体与该区域重叠。有些算法中,可以根据区域中几何单元的数量自适应地调整区域大小。当执行射线相交计算时,射线经过的区域会被依次计算,并且只有和这些区域重叠的几何单元会被测试。

物体分割则是渐进地将场景中的物体分割为更小的组成物件。例如:一个房子可以被分为四面墙、一个房顶、一个椅子。当射线和房屋没有交点时,所有的房屋子物体都可以被 culling。当有交点时,才需要进一步测试和子物体的相交。

这两种方案对于解决 Ray 交点计算都很成功,没有理论表明那种方案更好。

KdTreeAccel 基于空间分割方式

BVHAccel 基于物体分割方式

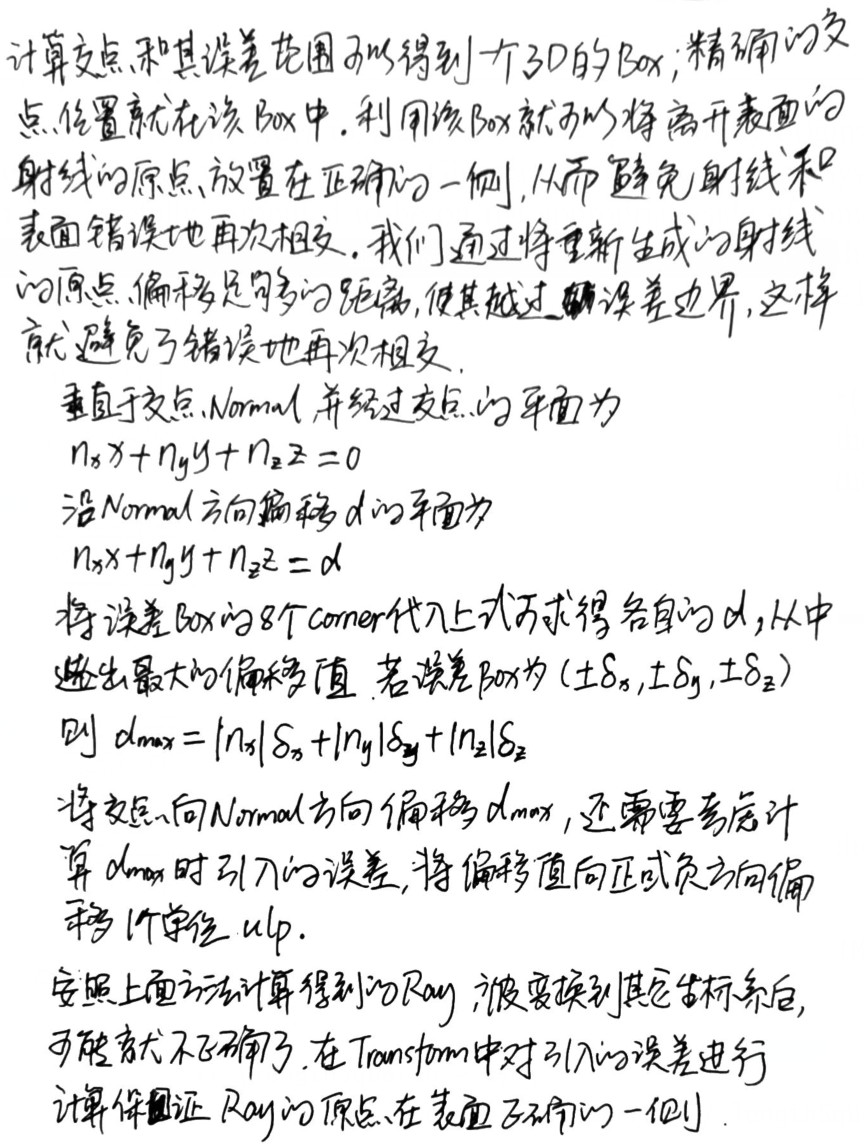

Bounding Volume Hierachies

基于物体分割方式有一个属性是,每个物体在树形结构中只出现一次,而基于空间分割的方式,物体可能跨越多个空间区域,所以在树形结构中会出现多次。这个属性决定了,使用 BVH 方式所消耗的内存是有限的。假设一共有 n 个几何单元,则 BVH 树就一共有 n 个叶子节点用来存储所有几何单元,还有 n-1 个内部节点,一共就有 2n-1 个节点。

BVH 树的构建要比 kd-tress 更高效一些。而 kd-trees 则提供了更快一些的交点计算。

BVH 通常要比 kd-trees 更精确一些。

构建 BVH

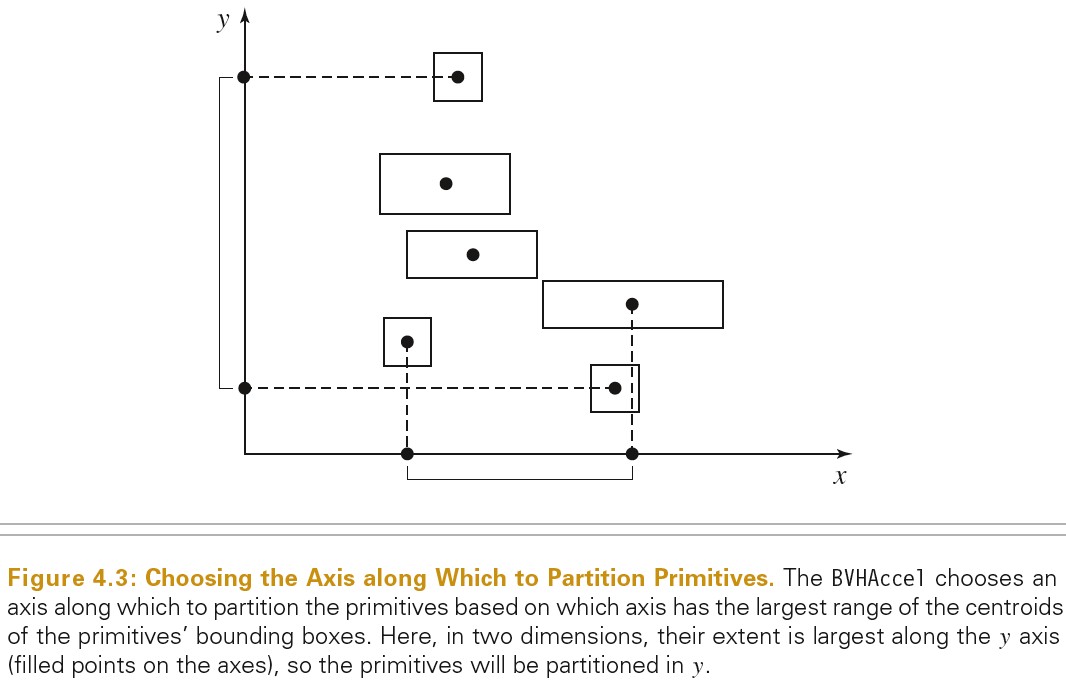

下图展示了划分 primitive 时,如何选择划分的方向:

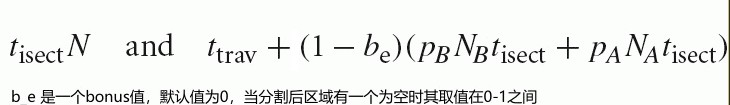

Surface Area Heuristic 消耗模型

Surface Area Heuristic 提供了有充分依据的消耗模型,可以回答以下这类问题:

- 将几何单元划分为多少可以得到一个更好的 BVH 用于射线交点测试?

- 将空间划分为多少子空间可以得到一个更好的加速结构?

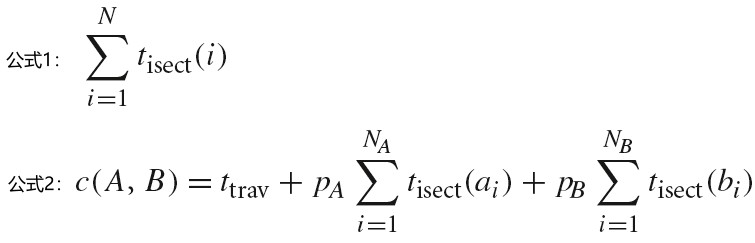

射线通过一个区域,执行相交测试需要的消耗为下面公式 1;

另一种情况是一个区域被划分为了两个区域,则相交测试需要的消耗为下面公式 2;

ttrav 表示遍历 interior 节点,确定射线经过了哪个子区域所消耗的时间。

pA 和 pB 分别为射线通过 A 区域和 B 区域的概率

Na 和 Nb 分别为 A 区域和 B 区域中的几何单元数量

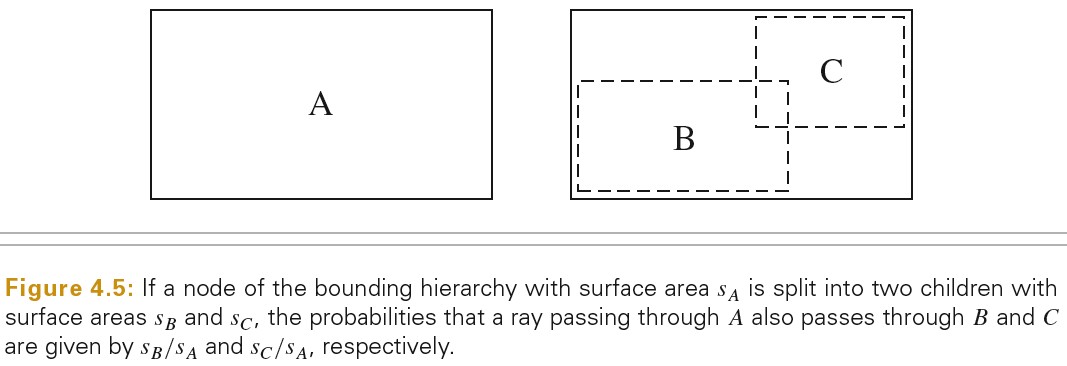

下图为计算射线通过区域的概率的原理:

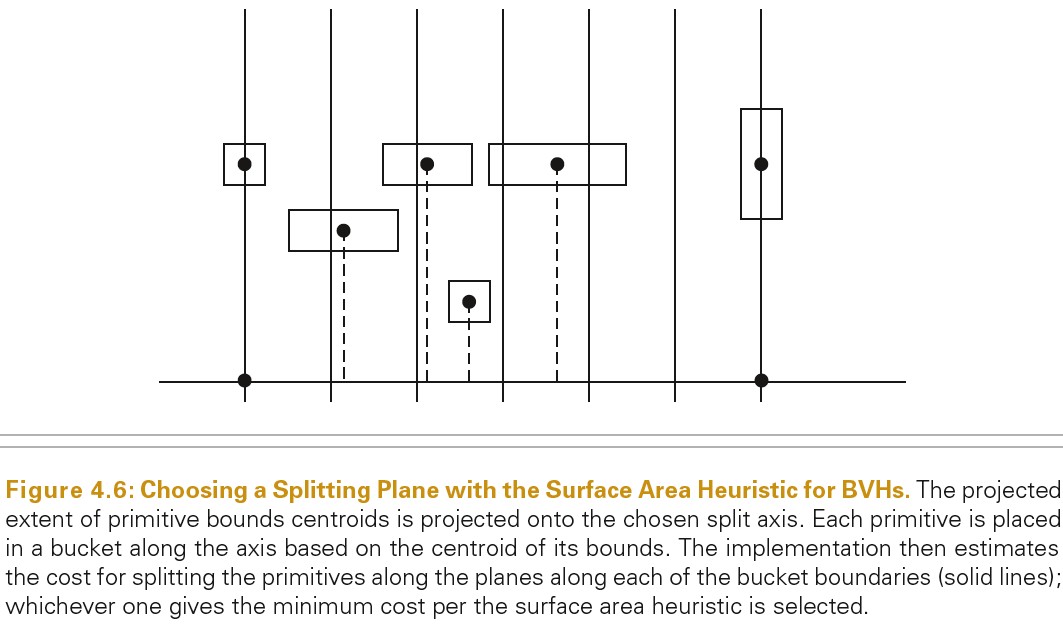

SAH 划分

不是考虑所有可能的划分方法,然后计算每种划分的消耗,最后选择消耗最少的划分。这样的方式消耗太大了。

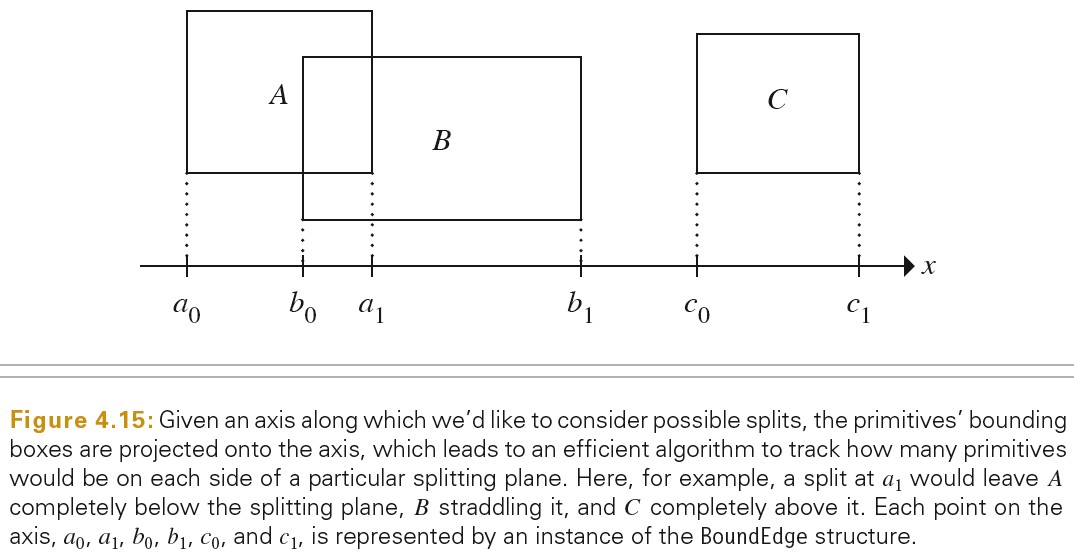

沿划分的轴,将整个区域划分为多个等距的桶,只需要考虑在桶边界上的划分。这种方式更加高效,而且依然可以获得有效的划分。下图展示了这种方式:

Linear Bounding Volume Hierachies

在构建 Bounding Volume Hierachies 时使用 Surface Area Heuristic 方法可以给出很好的结果,但是,这种方式有两个缺点:

- 在树的每一层都需要对 SAH 消耗进行计算。

- 从上至下的构建 BVH 对于并行非常不友好。最明显的并行方案(并行构建子树)受制于只有上一级树构建完成后才能构建下一级。

LBVH 就是用来解决以上问题的。

LBVH 背后关键的理念是将 BVH 构建转化为排序问题。

- Morton Codes

Morton Codes 基于一个简单的变换:给定一个 n 维的整数坐标值,它的 Morton-coded 表示坐标的二进制位交叉.

例如:

一个 2D 的坐标(x,y) x、y 的各个位用 xi 和 yi 来表示,则其 Morton-coded 值为 …y3x3 y2x2 y1x1 y0x0

对于一个 3D 的坐标(x,y,z),其 Morton-Coded 值为 …z3y3x3 z2y2x2 z1y1x1 z0y0x0

将一个 3D 坐标转化为 Morton Codes:

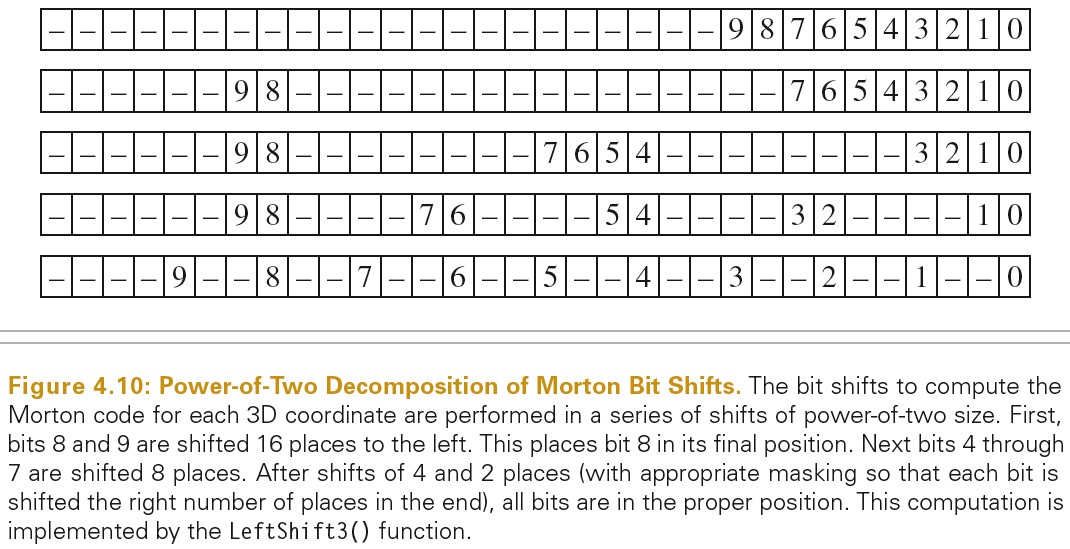

inline uint32_t EncodeMorton3(const Vector3f &v) { Assert(v.x >= 0 && v.x <= (1 << 10)); Assert(v.y >= 0 && v.y <= (1 << 10)); Assert(v.z >= 0 && v.z <= (1 << 10)); return (LeftShift3(v.z) << 2) | (LeftShift3(v.y) << 1) | LeftShift3(v.x); } // 下面方法将每个位的移位偏移量分解为2的幂次和,将移位操作从9减少到了4 inline uint32_t LeftShift3(uint32_t x) { Assert(x <= (1 << 10)); if (x == (1 << 10)) --x; x = (x | (x << 16)) & 0b00000011000000000000000011111111; // x = ---- --98 ---- ---- ---- ---- 7654 3210 x = (x | (x << 8)) & 0b00000011000000001111000000001111; // x = ---- --98 ---- ---- 7654 ---- ---- 3210 x = (x | (x << 4)) & 0b00000011000011000011000011000011; // x = ---- --98 ---- 76-- --54 ---- 32-- --10 x = (x | (x << 2)) & 0b00001001001001001001001001001001; // x = ---- 9--8 --7- -6-- 5--4 --3- -2-- 1--0 return x; }

下图展示了 LeftShift3 的原理:

RadixSort 可以参考 ../algorithm/AlgorithmIntroduce.org 文档中描述。

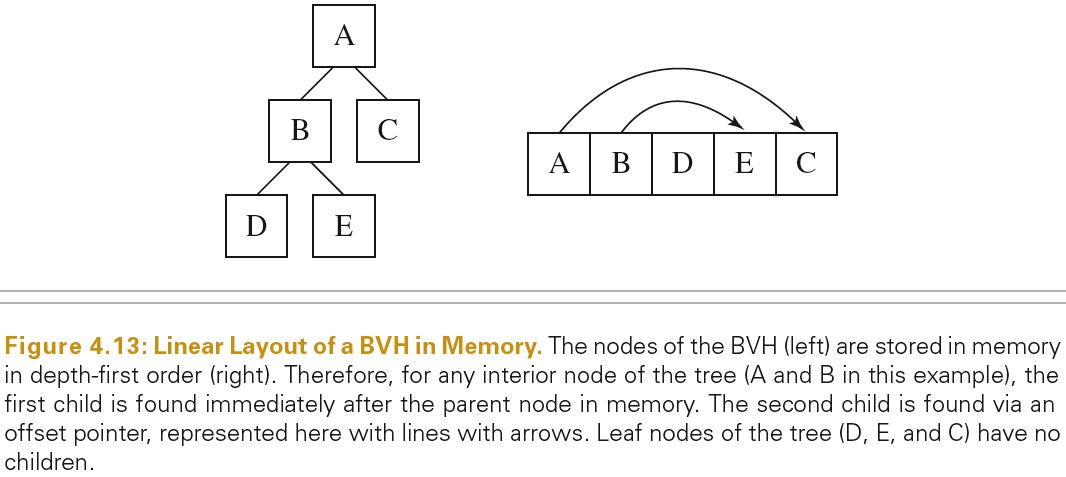

- Compact BVH For Traversal

将 tree 转化为紧密的表示形式(如数组)可以优化 cache、memory 可以整体提高性能。

最终的 BVH 会由树形结构转化为数组,数组中元素按照深度优先排列。

参考资料

- Introduction to Acceleration Structure https://www.scratchapixel.com/lessons/advanced-rendering/introduction-acceleration-structure/introduction

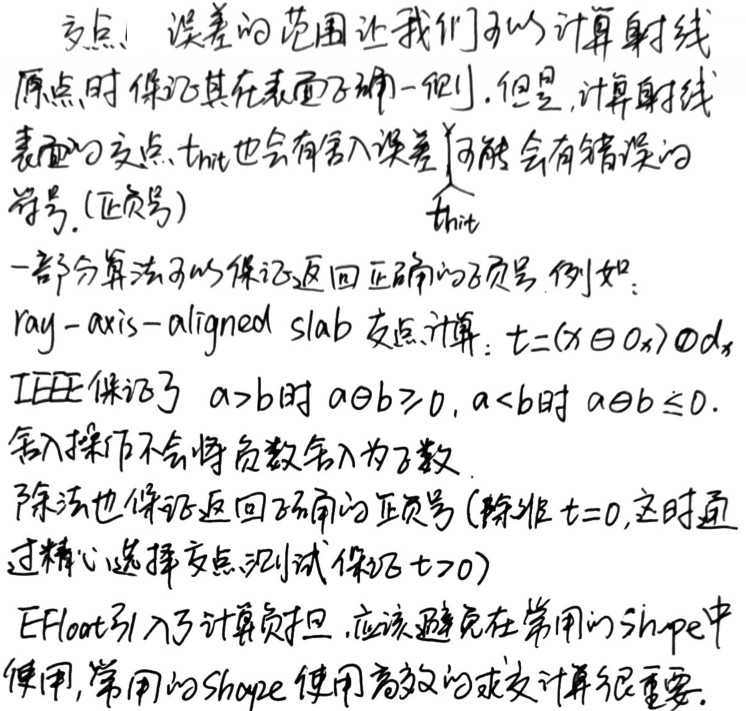

KD-TREE Accelerator

Binary space partitioning(BSP) trees 可以自适应地使用平面将空间分割开。BSP tree 首先使用一个包围盒包含整个场景,如果包围盒中的几何体数量大于某个阙值,使用一个平面将这个包围盒分成两半形成两个新的包围盒。处于分界线上的几何体同时属于两个包围盒。这个分割操作会递归进行直到最终的树的每个叶子区域都包含足够小数量的的几何体,或者是达到了分割的最大深度。

因为分割平面可以放在包围盒内部的任何地方,而且三维空间的不同部位可以被细化到不同的程度,所以 BSP 可以很容易处理场景中不均匀分布的几何体。

kd-tree 简单地限制分割平面必须垂直于其中一个坐标轴,这使得遍历和构建 tree 很高效。

octree 使用垂直与坐标轴的三个平面同时分割包围盒,每一步将包围盒分成 8 个区域。

Tree Representation

将树的节点所占用内存大小压缩到 8 字节,可以保证 8 个节点刚好可以放到 64 字节的 cache(8 字节的 Node 比 16 字节的 Node 速度提高了 20%)。

struct KdAccelNode { union { // 表示分割位置 Float split; // Interior // 如果只有一个图元,表示几何体的偏移 int onePrimitive; // Leaf // 如果由多个图元,表示第一个几何体的偏移 int primitiveIndicesOffset; // Leaf }; private: union { // Leaf 第两位为11表示为Leaf 其他位表示几何体数量 // Interior 第两位表示分割面所沿的轴 其他位表示分割后上面子节点的偏移 int flags; // Both int nPrims; // Leaf int aboveChild; // Interior }; };

Tree Construction

kd-trees 构建使用的 SAH 和 BVH trees 不同之处在于,前者在选择分割面时,如果该分割面生成的两个区域中,有一个区域是空区域则这种分割更优,因为空区域和射线求交消耗最小。

kd-trees 使用的 SAH 消耗模型如下:

kd-trees 将所有几何单元的 BoundingBox 的各个面做为分割面,选出消耗最小的分割面。通过将 BoundingBox 投影到各个轴上,可以方便地进行处理。

对 BoudingBox 在轴上的投影进行大小排序,小于分割面的图元为 below,大于分割面的图元为 above

Tree Traversal

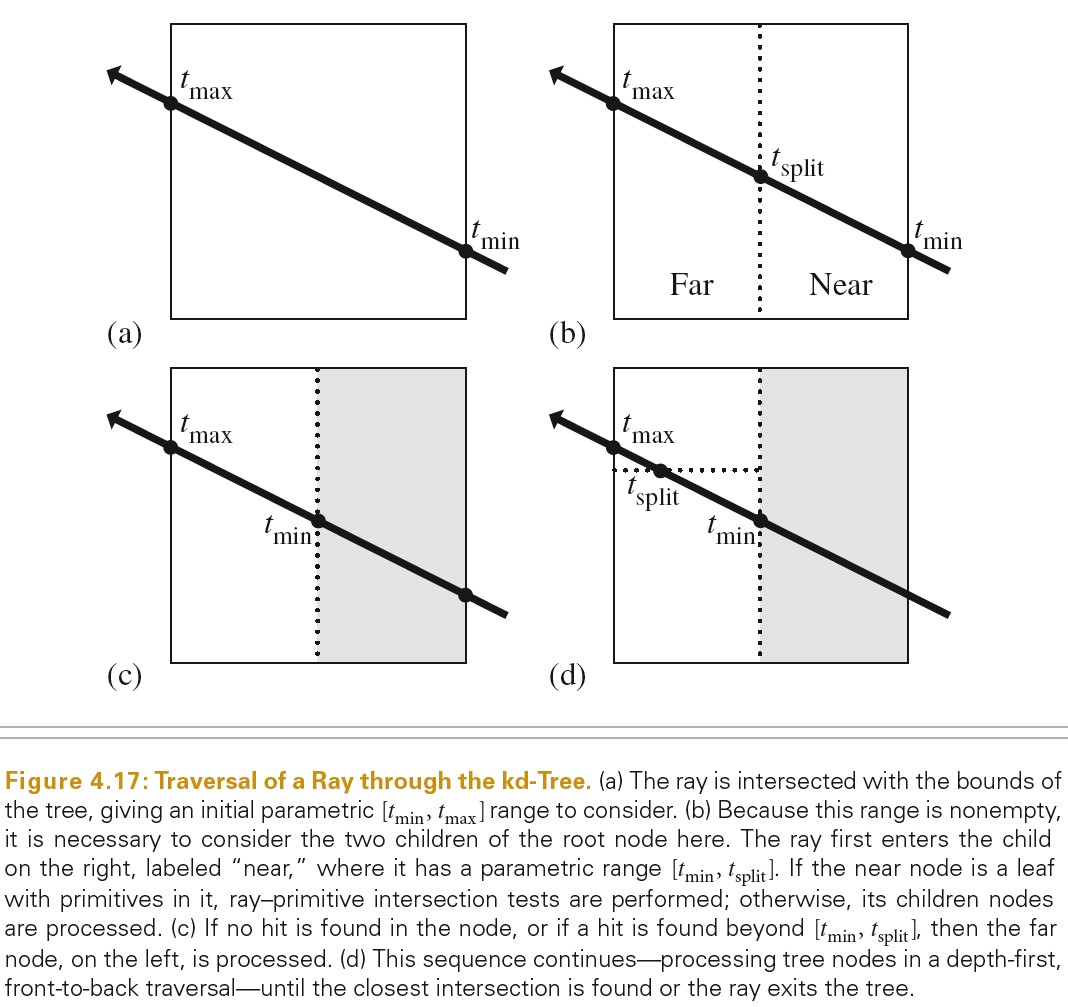

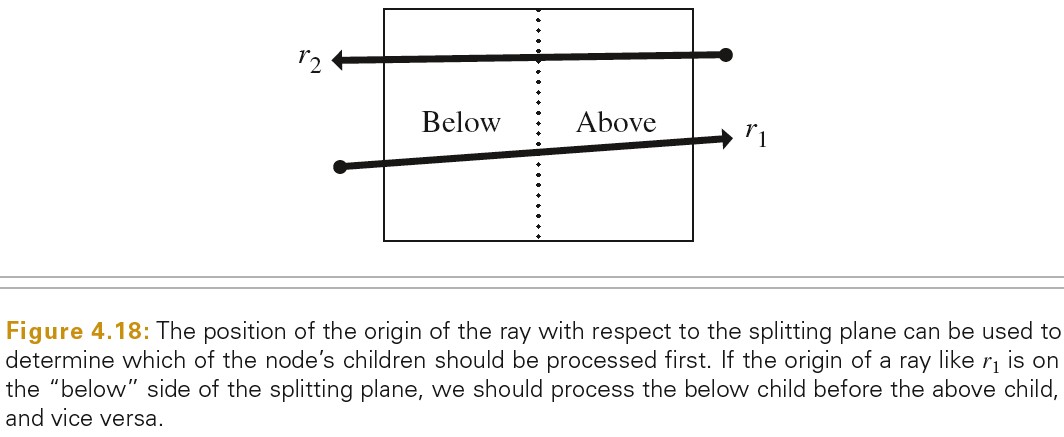

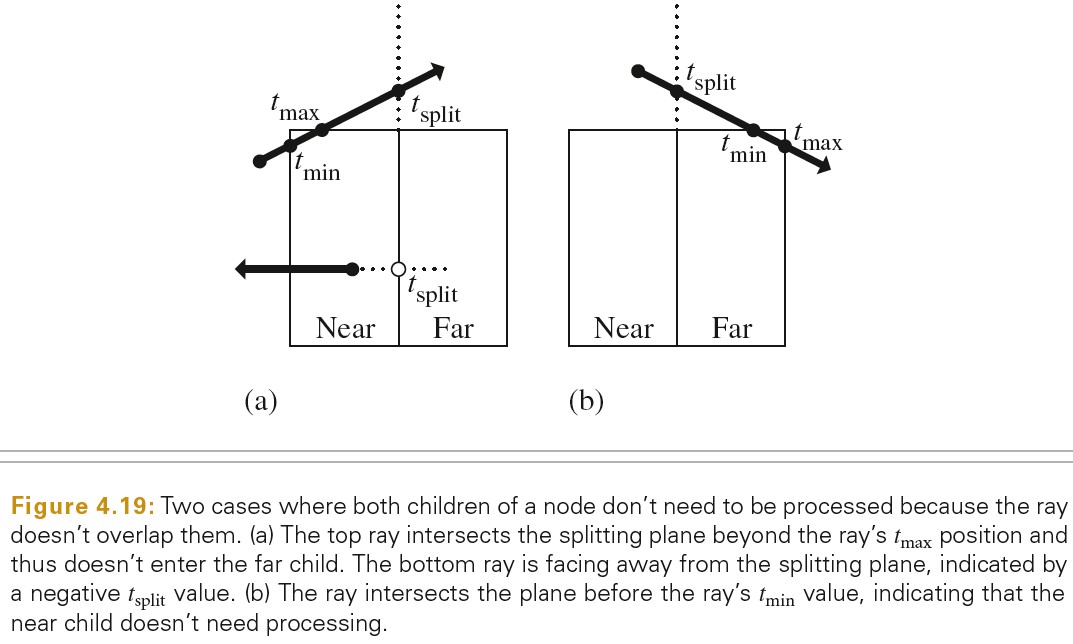

下图展示了遍历树的操作:

Part 2 Image Formation Process

5 Color and radiometry

基础知识

物理的光和颜色

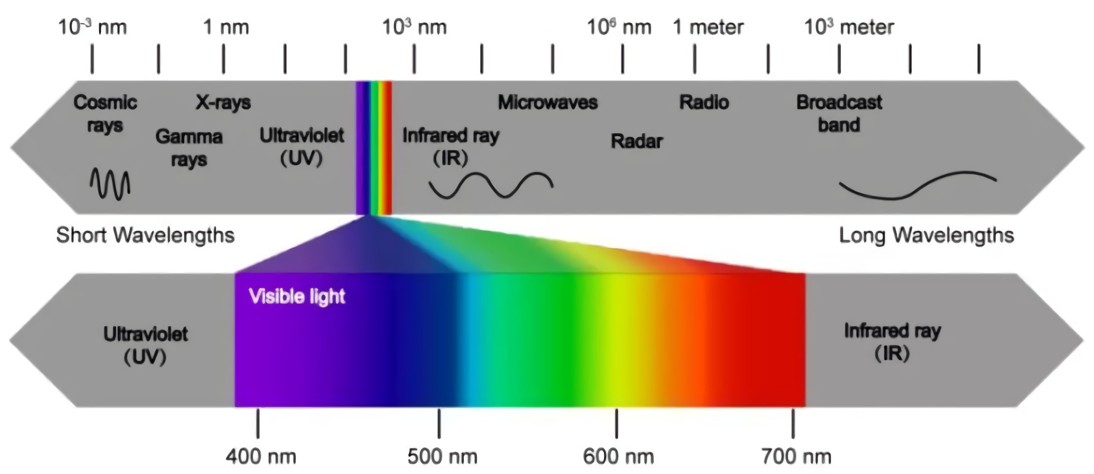

光是电磁辐射

- 不同颜色的光对应不同的波长

- 经典电磁学里,光波的能量由振幅确定,与频率或波长无关。在量子力学的情形,单光子的能量由频率或波长确定,而光波是大量光子的集合,所以光波的能量或振幅对应的是光子的数量。

光子能量: E=hc/λ=hf=hv

h 为普朗克常量,f和 v 为光的频率,c为光速,λ为光的波长

可见光的波长范围为 380nm - 780nm

下图展示了电磁波的波长分布

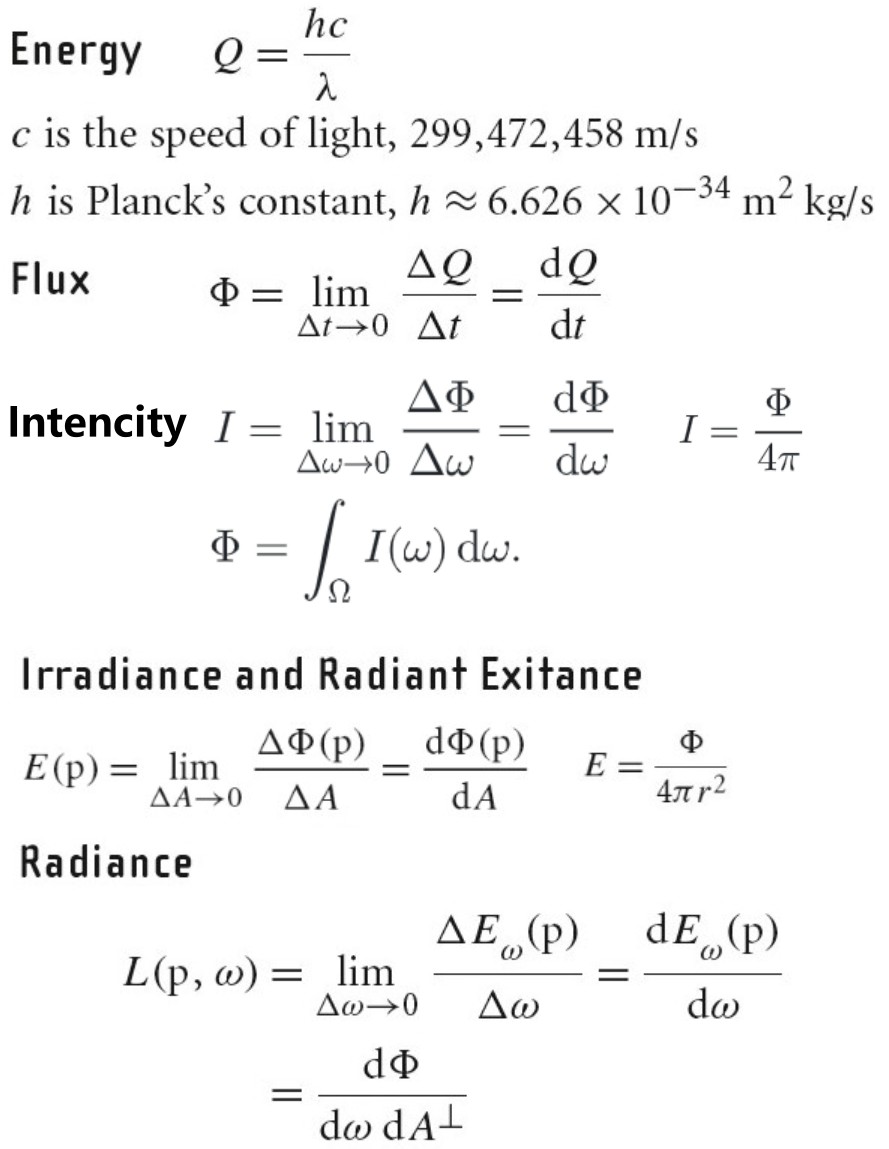

energy, flux(power), intensity, irradiance, radiance 这些物理量可以用于描述电磁辐射。

SPD(spectral power distribution) 是一个波长函数,用于描述每种波长的光的总量。

Relative SPD 是每种波长的光的总量的相对值。

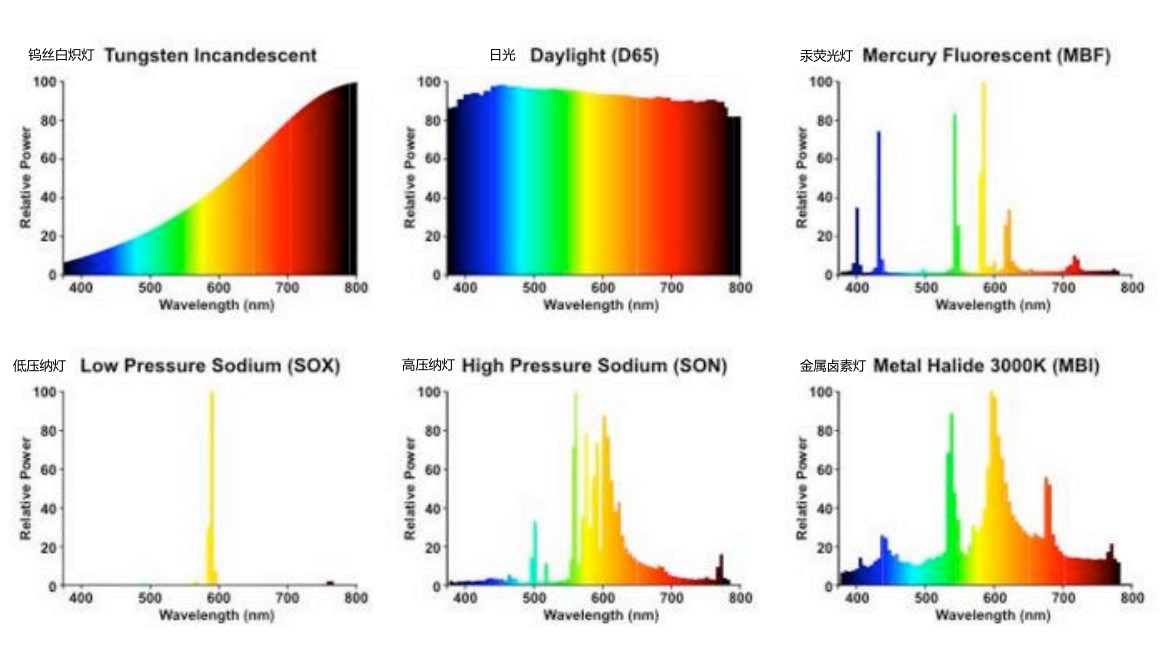

下图展示了常见光源的 SPD:

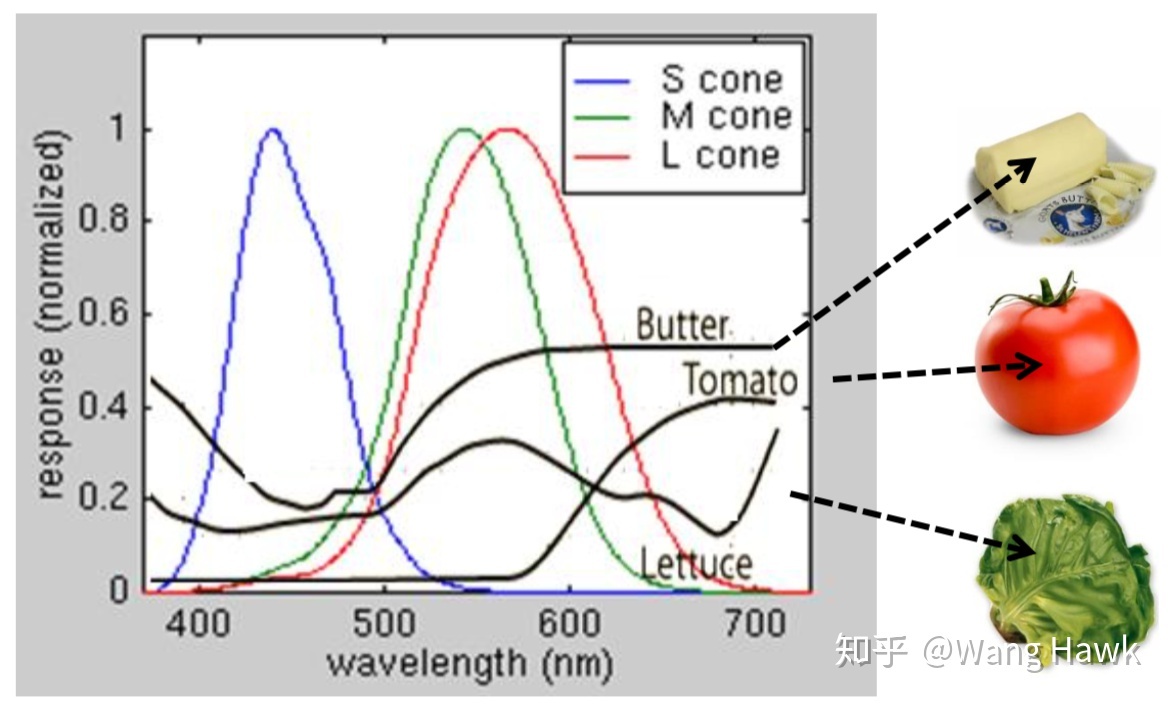

不同物体反射光的 SPD 不同,如下图展示了黄油、番茄、生菜反射光的 SPD:

- https://baike.baidu.com/item/%E5%85%89%E8%B0%B1%E5%88%86%E5%B8%83

- 光谱功率分布(spectral power distribution) http://mycolordoc.com/archives/741

- spectral power distribution https://en.wikipedia.org/wiki/Spectral_power_distribution

- 光的波长和振幅对应光子的什么属性? https://www.zhihu.com/question/309647712

- 光子能量 https://baike.baidu.com/item/%E5%85%89%E5%AD%90%E8%83%BD%E9%87%8F

颜色

- 人眼对波长的响应

物体没有颜色,颜色是我们所看到的感觉。

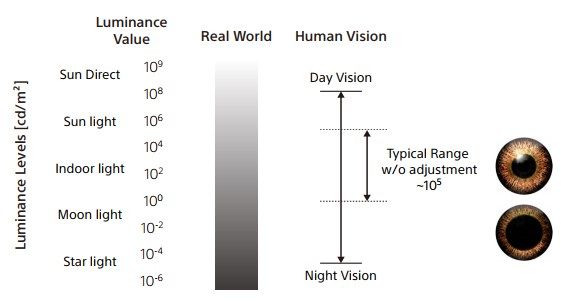

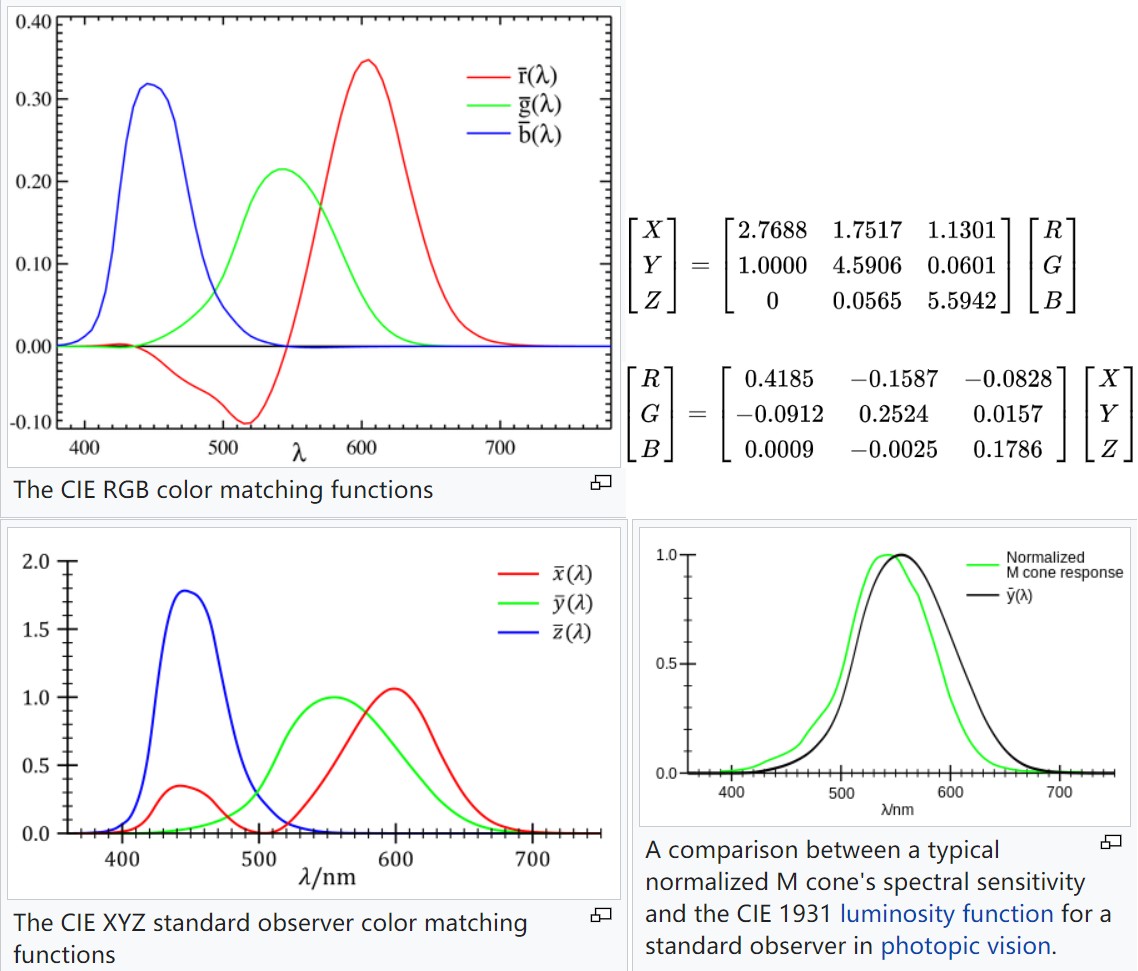

人眼有两类光感细胞: 视杆细胞和视锥细胞。在低亮度水平时,只有视杆细胞发挥作用,而在高亮度水平时则是视锥细胞发挥作用,在中间亮度水平时,两者都会同时工作。 视杆细胞只有 1 种,对感知颜色没有贡献。

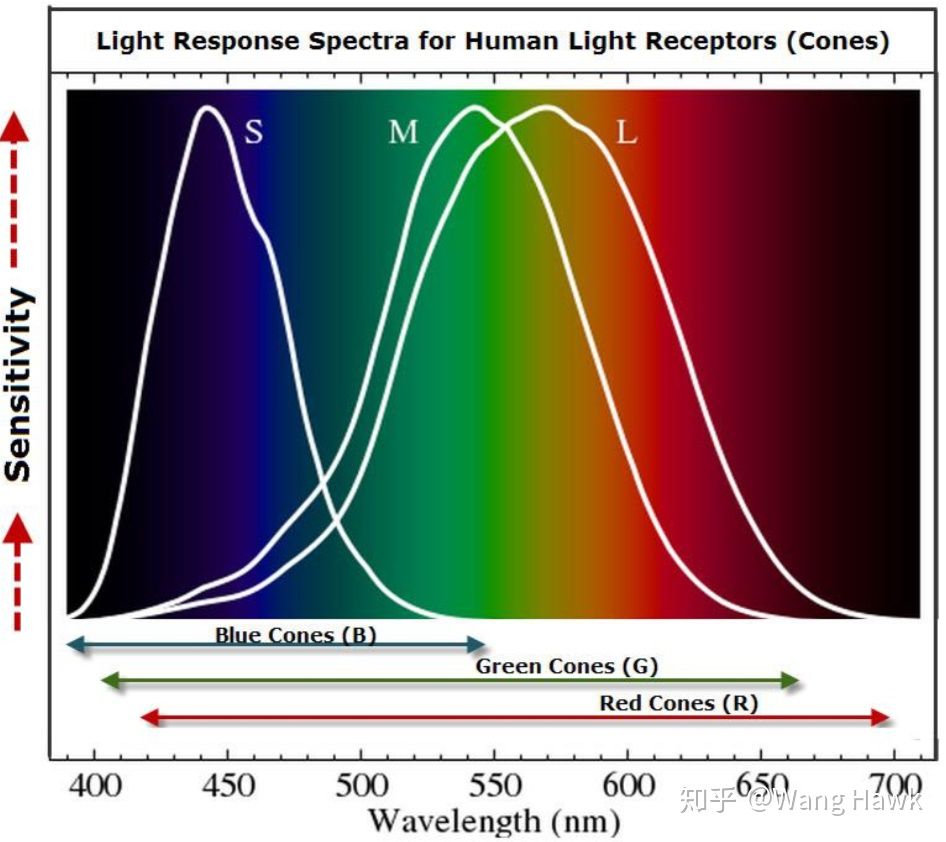

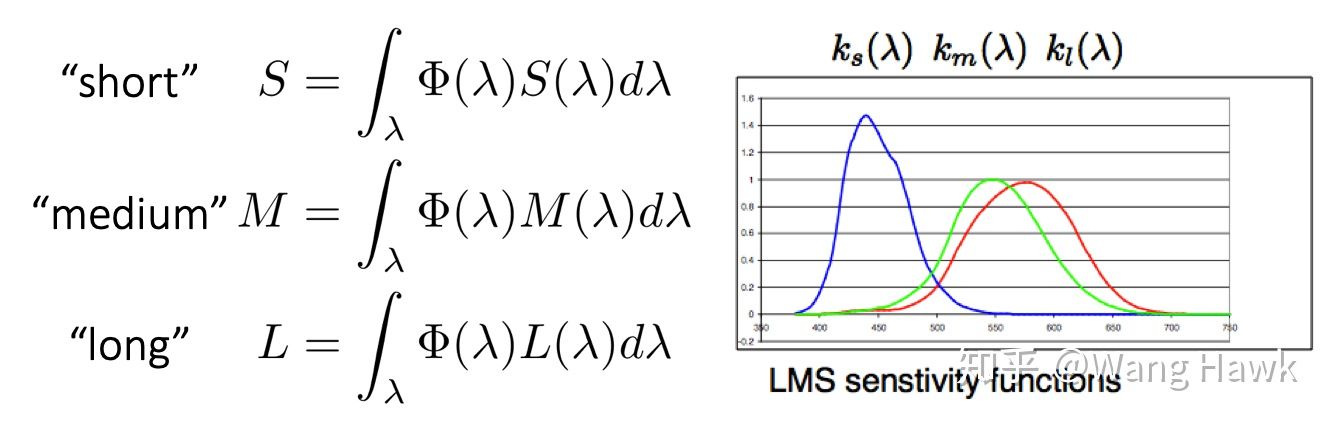

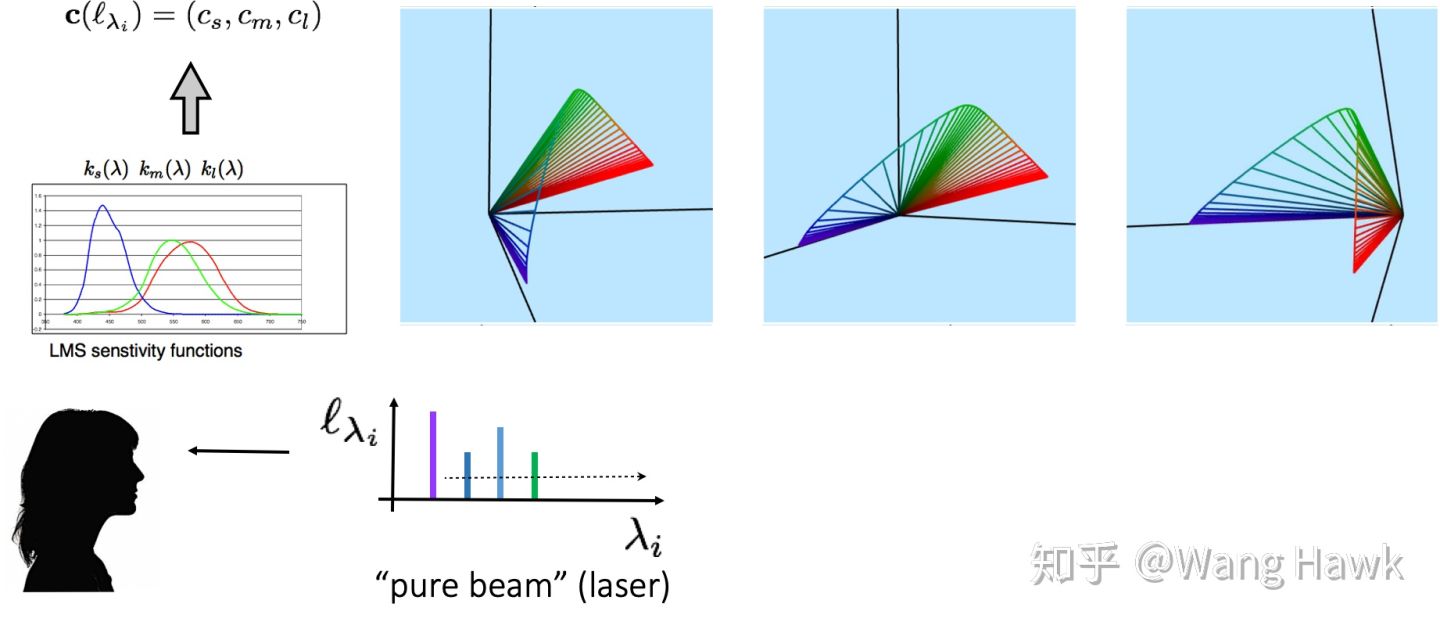

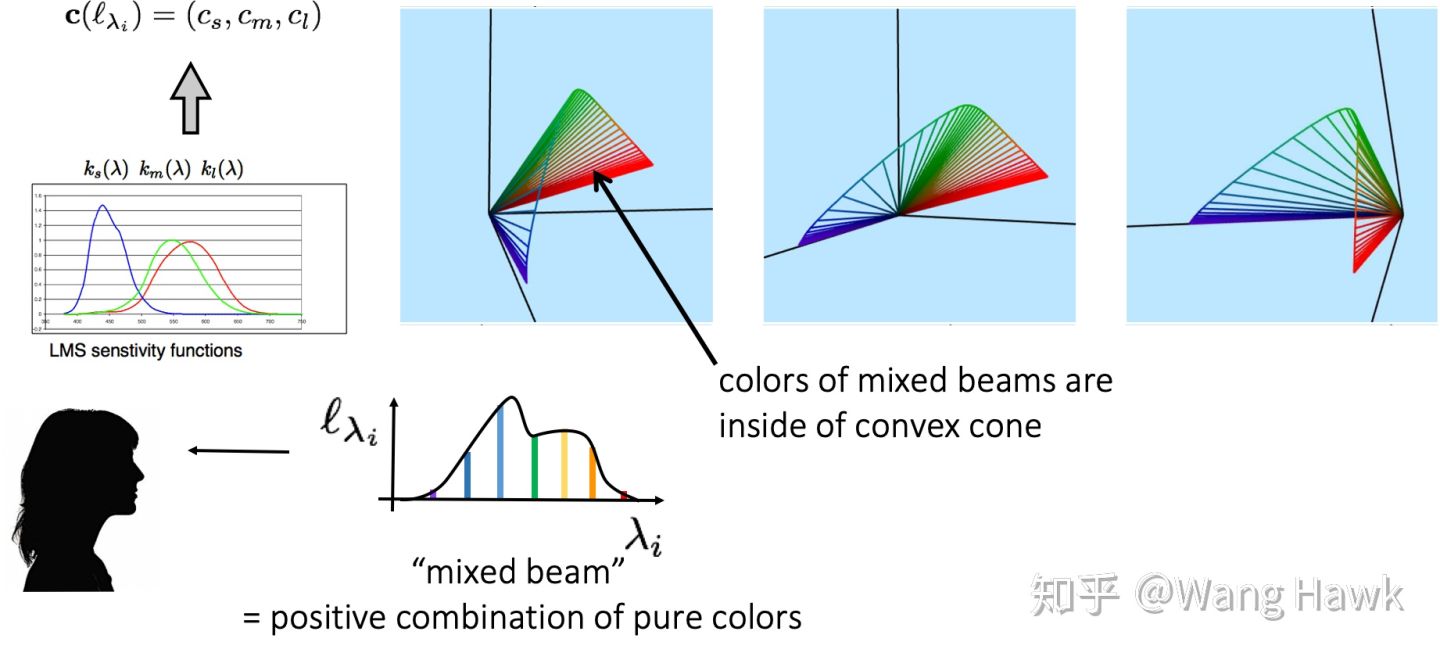

人眼的视锥细胞可分为三种:L/M/S,这三种细胞对不同波长的光响应不同,才使人类产生各种颜色的感觉。下图展示了三种细胞对不同波长光的相对响应值:

人的视觉系统在感知颜色时是有层次的,下图展示了这种层次结构。

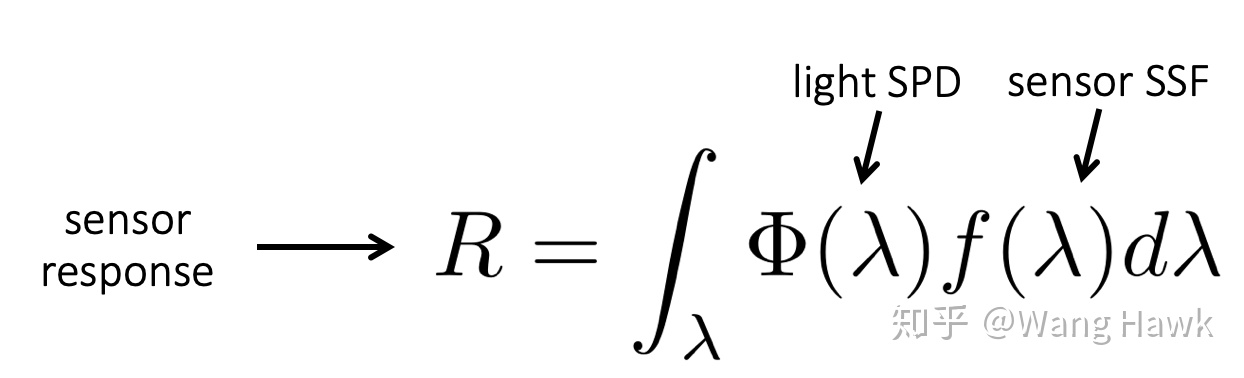

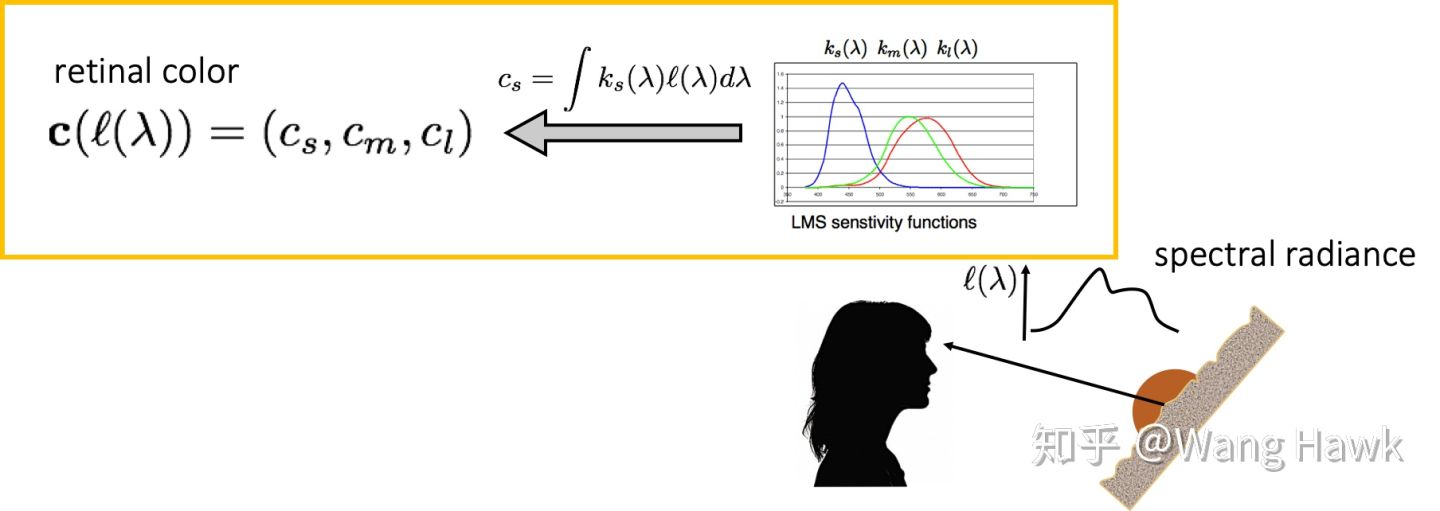

人们对视觉系统的深层次机理还有很多未知的地方,但是对视网膜颜色已经有了深入的理解,视网膜本质上是一个传感器,而光传感器对不同波长的光的敏感度用光谱敏感度函数 f()来描述,这样一个光源造成的响应 R 可以描述为下图,它实际上是光源中各个单色光的响应的加权和。光谱功率分布 SPD 是无限维度的(波长是连续的,400nm 到 401nm 之间就有无限多个),人类有三种视锥细胞可以对光谱有响应,对应了 SML 三条响应曲线。将 SPD 分别和 SML 响应曲线卷积(将 SPD 投影到 SML 空间)得到 3 个值,这三个值组成一个向量,就是视网膜颜色。

人眼的三种视锥细胞对光的响应为:

而这些响应可以用一个具有 3 个元素的向量 c 来描述,它就是我们所说的 视网膜颜色:

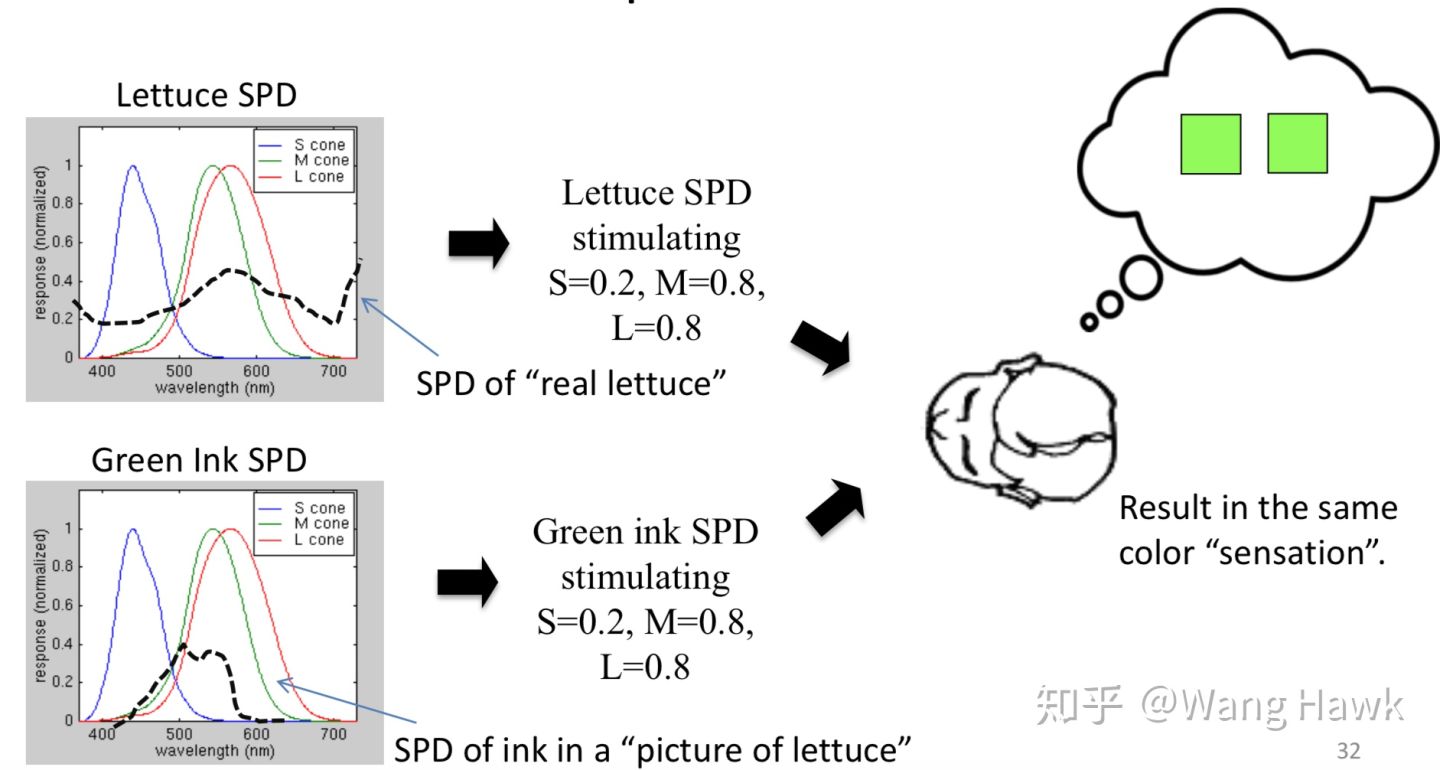

不同 SPD 的光,可以得到同样的视网膜颜色。这使得我们测量颜色时有了更多的挑战和困难。比如下面展示了两个不同的光谱功率分布,一个来自生菜,一个来自绿茶,但是在观察者看来都是同样的绿色。

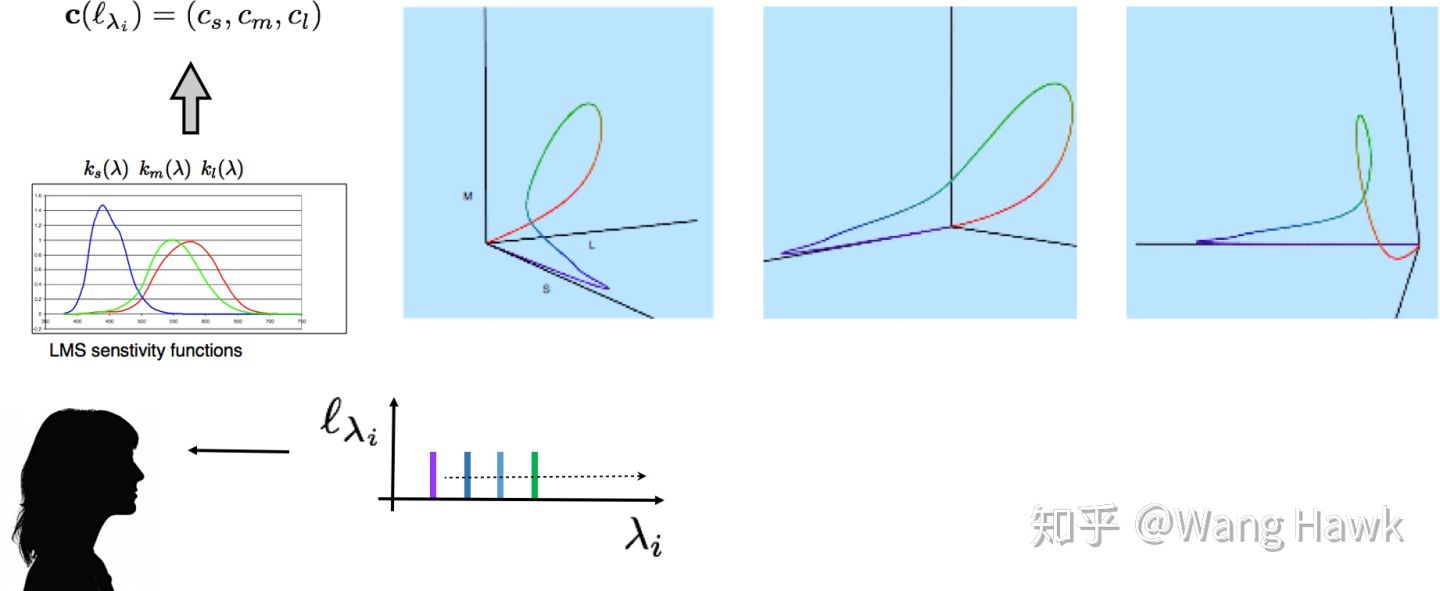

我们可以认为视网膜颜色空间是一个 3 维的颜色空间,我们称之为 LMS 颜色空间。任何一种纯色光在这个 3 维空间中都有对应的坐标,我们可以画出这些坐标,并从不同的角度去观察画出的曲线:

可以观察到这条曲线呈套索状,并位于 3 维空间的第一象限,它的起始点和终点都是原点,并且除了原点之外都与 M 轴无交点。

上面的曲线假设输入的纯色光是单位强度的,那么如果强度有变化呢?此时的曲线的样子是下面这样的,可以看到我们得到的颜色坐标位于一个凸面上。

如果是由多种不同强度不同波长纯色光混合而成的光呢?此时它的颜色坐标则会位于这个凸面包裹的范围之中:

- 颜色的科学 https://zhuanlan.zhihu.com/p/80321112

- 既然紫光的波长最短,为什么用红色和蓝色混合会产生紫色(紫光)? https://www.zhihu.com/question/385007670

- 颜色知识 1-人类的视觉系统与颜色 https://zhuanlan.zhihu.com/p/84891237 Tips: 该节内容大部分来自于该引用

- 颜色的科学 https://zhuanlan.zhihu.com/p/80321112

- 人眼特性

- 人眼分辨率 人眼像素

人眼一般具有一亿左右的视杆细胞,但是视锥细胞说满了也只有 700 万不到。

人眼成像过程非常复杂,大脑的参与同样至关重要。由于视锥细胞集中在黄斑,也就是视线焦点处。因此,人眼对于视线焦点处的色彩信息掌握最为充分,而对于非焦点区域,就只能靠大脑来“处理”了。而人眼对焦极快,可以快速对焦到你想要看到的地方,因此仿佛可以将看见的景色尽收眼底。

- 人眼动态范围

场景的最大亮度与最小亮度的跨度称作动态范围. 通常使用尼特(nits)来度量,1尼特=1 坎特拉/平方米(1nits=1cd/m^2)。

场景里的最大亮度和最小亮度的比就叫做(静态)对比度

在白天环境亮度 10,000 特时,人眼大约能分辨的亮度范围为 200~20,000 尼特,低于 200 尼特的亮度同感觉为黑色。而夜间环境为 30 尼特时,可分辨的亮度范围为 1~200 尼特,这时 100 尼特的亮度就引起相当亮的感觉。只有低于 1 尼特的亮度才引起黑色感觉。

人眼感知的亮度与光强成指数关系,而物理学定义的亮度与光强成正比。

- 参考资料

- 人的眼睛相当于什么参数的镜头? https://www.zhihu.com/question/26507130

- Human eye https://en.wikipedia.org/wiki/Human_eye

- 人眼的像素有多高? https://www.zhihu.com/question/25111095

- 人的眼相当于多少像素的数码相机呢? https://www.zhihu.com/question/19968393

- 为什么人眼的动态范围 (Dynamic Range) 比相机大得多? https://www.zhihu.com/question/21492596/answer/117666373

- What is the maximum light intensity that a human eye can withstand without being damaged? https://www.quora.com/What-is-the-maximum-light-intensity-that-a-human-eye-can-withstand-without-being-damaged

- 人的眼睛相当于什么参数的镜头? https://www.zhihu.com/question/26507130

- 人眼分辨率 人眼像素

- 颜色的标准化

- 三原色理论 颜色匹配实验

三原色,所谓三原色,就是指这三种色中的任意一色都不能由另外两种原色混合产生,而其它色可由这三色按照一定的比例混合出来,色彩学上将这三个独立的色称为三原色。

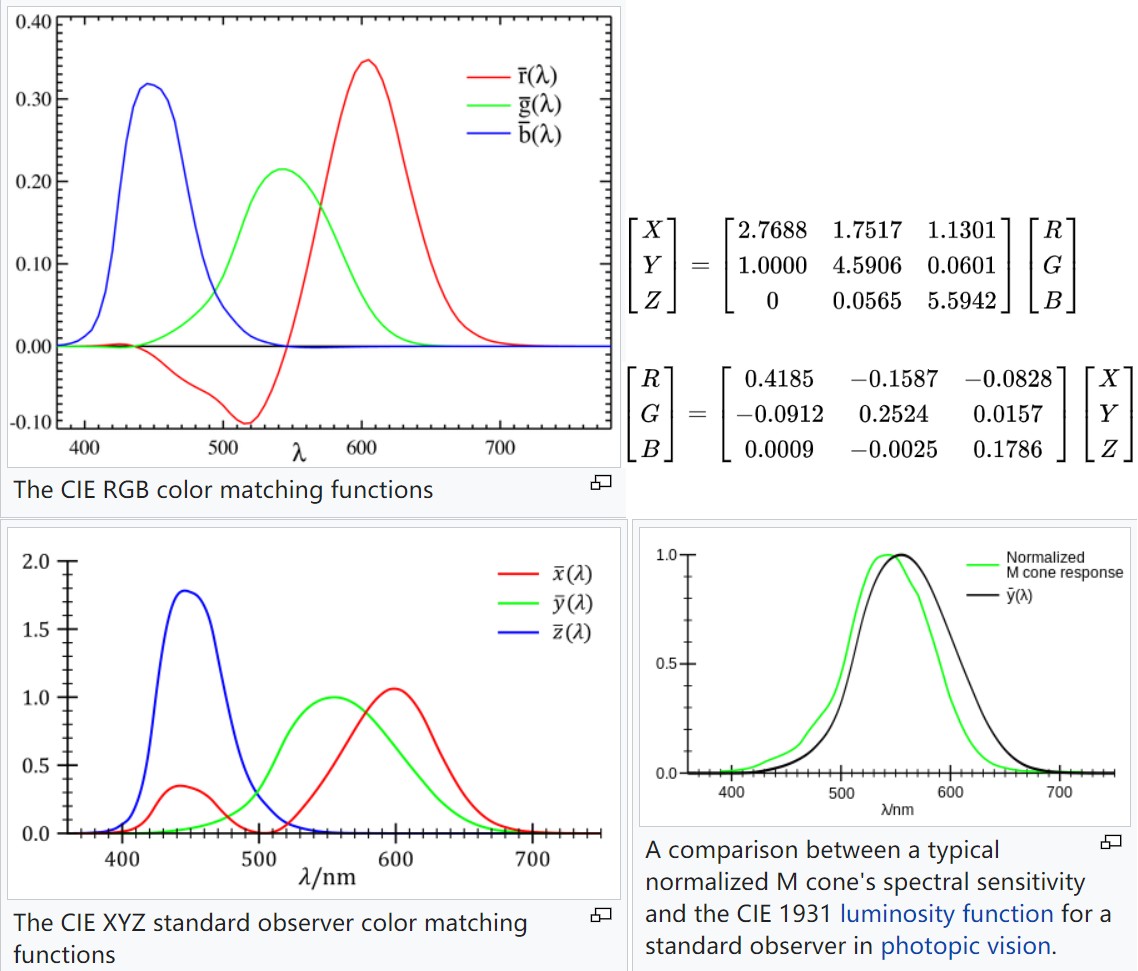

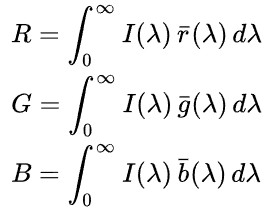

在颜色匹配实验中,当这三原色光的相对亮度(luminance)比例为 1.0000 : 4.5907 : 0.0601 (radiance 比例为 72.0962 : 1.3791 : 1)时就能匹配等能白光,所以 CIE 选取这一比例作为红、绿、蓝三原色的单位量。CIE 通过颜色匹配实验,确定了 CIE-RGB 颜色匹配函数(类比人眼三种视锥细胞对光的响应函数)。

红绿蓝被选作为三原色光有以下原因:

- 在 435.8 nm 时 r(λ) 和 g(λ)为 0,在 546.1nm 时 r(λ) b(λ)为 0,在 700nm 时 g(λ) b(λ)为 0.

- 选择波长为 546.1 nm 和 435.8 nm 的原色是因为它们是汞蒸气放电的易于再现的单色线。 在 1931 年,很难生成 700 nm 波长的单色光束,之所以将其作为三原色之一,是因为在该波长下眼睛对颜色的感知基本不发生变化,所以该基色波长的小误差对结果影响很小。

以下回答来自 ChatGPT

- 红绿蓝三原色光位于可见光谱的三个主要区域,代表了长、中、短波长度,可以合成可见光谱中的大多数颜色。

- 人眼对红绿蓝三原色的感光最为敏感,这三种颜色互相配合可以产生最大的色域范围。

- 红绿蓝三色之间的波长间隔大,颜色区分度高,混合时不易产生冲突。

- 在技术上,红绿蓝三色滤光材料和发光体相对容易实现。

- 红绿蓝三原色系统与人类颜色视觉感受的三通道理论相符。

原则上,可以选择其他三种单色光作为三原色系统。但要使混合色域最大化,这三种颜色必须在可见光谱的不同区域,波长间隔大,对人眼的刺激效果强,技术上也要容易实现。除非有更优的三原色系统,否则红绿蓝三原色很难被取代。

- 三原色原理 https://baike.baidu.com/item/%E4%B8%89%E5%8E%9F%E8%89%B2%E5%8E%9F%E7%90%86/6969780

- 颜色知识 2-三原色理论与颜色匹配实验 https://zhuanlan.zhihu.com/p/84897327

- 1931 CIE 颜色系统 https://zhuanlan.zhihu.com/p/31374619

- CIE 光谱三刺激值 https://baike.baidu.com/item/CIE%E5%85%89%E8%B0%B1%E4%B8%89%E5%88%BA%E6%BF%80%E5%80%BC/22127070?fr=aladdin

- https://en.wikipedia.org/wiki/CIE_1931_color_space

- 在 435.8 nm 时 r(λ) 和 g(λ)为 0,在 546.1nm 时 r(λ) b(λ)为 0,在 700nm 时 g(λ) b(λ)为 0.

- 颜色模型 颜色空间

- 颜色模型

颜色模型: 颜色模型是一种抽象的数学模型,描述了颜色被表示为数字元组的方式,通常颜色可以表示为三个或四个分量。 当此模型与如何解释各个分量的精确意义相关联时,生成的颜色集称为“颜色空间”。

RGB color model:

RGB 颜色模型是一种基于人类对颜色感知的加色模型。通过对 R、G、B 三种颜色的光束进行叠加可以得到其他颜色,格拉斯曼定律揭示了颜色混合的线性规律。

RGB 颜色模型本身并没有定义红、绿和蓝的含义,因此混合它们的结果不是绝对的,而是相对于原色的。 当定义了红、绿、蓝三原色的准确色度后,颜色模型就变成了一个绝对的颜色空间,例如 sRGB 或 Adobe RGB。

格拉斯曼定律揭示了光谱分布转化为 RGB 颜色值的本质,给定任意一个 SPD I(λ), 其对应的 RGB 坐标为:

I(λ) 是线性的,r(λ) g(λ) b(λ)是所选三原色对应的颜色匹配函数。

CIE 颜色匹配实验就是利用格拉斯曼定律构造 CIE-RGB 颜色空间。

CMYK color model:

CMYK 颜色模型是一种减色颜色模型。

Cylindrical-coordinate color model:

存在许多颜色模型,其中颜色适合圆锥形、圆柱形或球形,中性色沿中心轴从黑色到白色,色调对应于周边的角度。如 HSL,HSV 等等

- 颜色空间

颜色空间: 为一个颜色模型定义三原色、白点、传递函数后,就可以确定其所能表示的颜色集合,该集合就是颜色空间。

颜色空间通常还会包含 Image State、Viewing Environment、Data Type 等信息:

- Image State:它把颜色空间分类成了几种不同的图像状态,最常见的就是 Scene Referred Image 和 Display/Output Referred Image

- Viewing Environment:由于人眼的视觉是自适应的,大脑对颜色的理解是依赖当前所处的观察环境的。例如,同样一张白纸在明亮的天光环境和钨丝灯光照下我们都认为它是白色的,但实际上在两种光照环境下它真正反射的光线是不同的。因此,我们需要给颜色空间定义一个它的观察环境,这个观察环境会影响颜色空间的白点值、传递函数等数值。例如 DCI-P3 的白点和伽马一定程度上就是为了适应影院这样较为昏暗的放映条件

- Data Type:它指定了这个空间下颜色数据的范围和精度,例如数据是 8-bit、10-bit 还是 16-bit,格式是 integer 还是 floating point

- https://chrisbrejon.com/cg-cinematography/chapter-1-color-management/

RGB color space:

RGB color space 是基于 RGB color model 的很多种颜色空间的总称。如:sRGB,Adobe RGB, CIE RGB

- Image State:它把颜色空间分类成了几种不同的图像状态,最常见的就是 Scene Referred Image 和 Display/Output Referred Image

- CIE-RGB

CIE1931 色匹配实验使用 700 nm 红光,546.1 nm 绿光,435.8 nm 的蓝光,对 380nm 到 780nm 的单色光进行匹配,得到 r(λ) g(λ) b(λ) 三个颜色匹配函数。匹配实验并没有指定三原色光的亮度,三原始光亮度比例是由下面的等式推导出来的:

最终,r:g:b 三原色的 luminance 比例为 1.0000:4.5907:0.0601,radiance 比例为 72.0962:1.3791:1

CIE-RGB 线性空间的正交基: 1 单位亮度的 700nm 红光为(1,0,0), 4.5907 单位亮度的 546.1nm 绿光为(0,1,0), 0.0601 单位亮度的 435.8nm 蓝光为(0,0,1)。需要注意的是,CIE-RGB 空间中,部分颜色的坐标为负数。

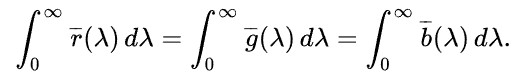

- CIE-XYZ

为了消除 CIE-RGB 颜色空间中,r分量的负值,开发了 CIE-XYZ 颜色空间。另外还满足如下一些约束:

- 所有坐标都是正的保持等能点(equal energy point)作为白色

- 使得新的 Y 坐标能够代表明度,也就是使得新的 Y 坐标等于视觉的明度响应

- 使得新的 Z 坐标在红光端保持为 0

- 使得所有色彩尽可能充满新的空间

下图展示了 CIE-RGB 和 CIE-XYZ color matching functions 的对比,CIE-RGB 到 CIE-XYZ 转化矩阵的构造(从 CIE-RGB 空间构造 CIE-XYZ 空间), 具体内容可以参考 wiki 中内容。

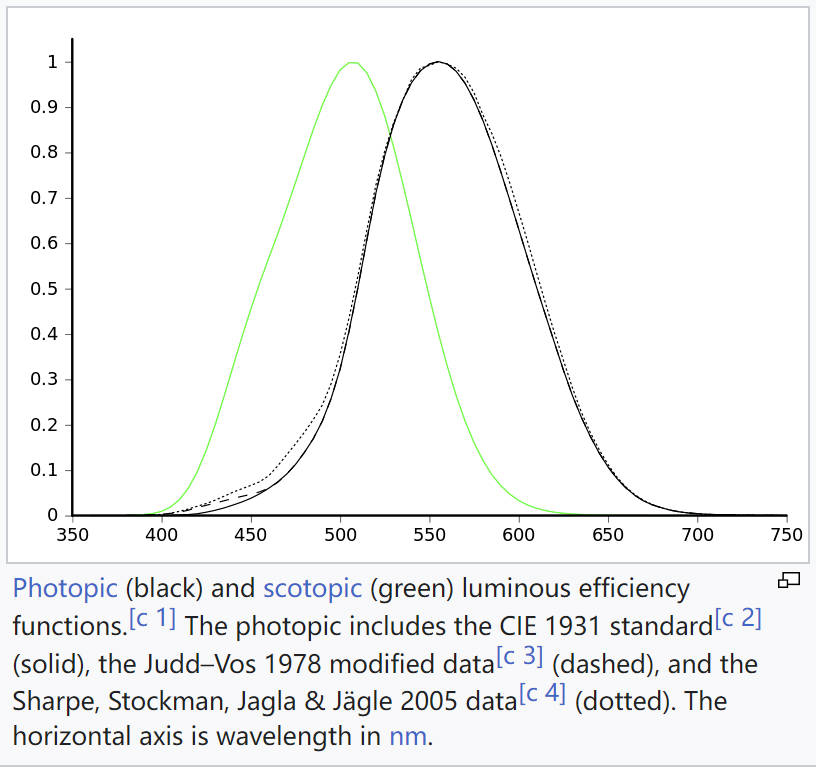

明度响应曲线是人眼对不同波长光引起明亮感觉的描述。使用等能光谱不同波长的光与标准白光相匹配的实测,可以获得对各个波长的光的相对视亮度函数。根据观察范围和观察者亮度适应水平分为两种:明视觉光亮度函数和暗视觉光亮度函数。

明视觉(Photopic vision)是在光照条件良好的情况下(luminance 等级在 10 到 10^8 cd/m^2),人眼对亮度感觉的描述。

暗视觉(Scotopic vision)是在低光照条件的情况下(luminance 等级在 10^-3 到 10^-6 cd/m^2),人眼对亮度感觉的描述。

下图是明视觉光亮度函数(photopic luminous efficiency function 黑色图像)和暗视觉光亮度函数(scotopic luminous efficency function 绿色图像)的对比:

- 所有坐标都是正的保持等能点(equal energy point)作为白色

- CIE-xyY

- linear RGB 颜色空间

linear RGB 这种说法是不准确的,因为 linear RGB 并没有给出三原色和白点,传递函数等信息。

一种观点认为,rgb 颜色可以理解为 SPD 的简化,其只包含了三个单色光的量。

另一种观点认为,rgb 颜色是 SPD 投影到 rgb 空间的表示形式。

- sRGB

sRGB 颜色空间是惠普和微软制定的被用于网络、Windows、印刷等领域的 RGB 颜色空间标准。其各个属性如下:

三原色和白点:

CIE xy chromaticity red green blue whitepoint x 0.6400 0.3000 0.1500 0.3127 y 0.3300 0.6000 0.0600 0.3290 z 0.0300 0.1000 0.7900 0.3583 从 CIE 色度图选择某个颜色空间的三原色和白点,求出该颜色空间和 CIE-XYZ 颜色空间的变换矩阵的方法如下图所示:

Tips: CIE 色度图选择的三原色、白点的值也是 CIE-XYZ 空间的颜色值,这些值在 X+Y+Z=1 平面上。

下面推导了 sRGB 到 CIE-XYZ 的变换矩阵:

0.3290 * sw = 1, 0.6400 * sr + 0.3*sg + 0.15*sb = 0.3127*sw, 0.3300 * sr + 0.6*sg + 0.06*sb = 0.3290*sw, 0.0300 * sr + 0.1*sg + 0.79*sb = 0.3583*sw, // WolframAlpha 中不支持上面写法,支持下面这种写法 0.3290 * w = 1, 0.6400 * r + 0.3*g + 0.15*b = 0.3127*w, 0.3300 * r + 0.6*g + 0.06*b = 0.3290*w, 0.0300 * r + 0.1*g + 0.79*b = 0.3583*w, // 解的 sr≈0.644361, sg≈1.19195, sb≈1.20321, sw≈3.03951 // 从而得到Rxyz Gxyz Bxyz Rxyz = rxyz*sr = (0.6400,0.3300,0.0300) * 0.644361 = {0.412391, 0.212639, 0.0193308} Gxyz = gxyz*sg = (0.3000,0.6000,0.1000) * 1.19195 = {0.357585, 0.71517, 0.119195} Bxyz = bxyz*sb = (0.1500,0.0600,0.7900) * 1.20321 = {0.180482, 0.0721926, 0.950536} Wxyz = wxyz*sw = (0.3127,0.3290,0.3583) * 3.03951 = {0.950455, 0.999999, 1.08906} // 因此 sRGB 到 CIE-XYZ 的变换矩阵为 0.412391, 0.212639, 0.0193308 0.357585, 0.71517, 0.119195 0.180482, 0.0721926, 0.950536 0.412391, 0.212639, 0.0193308 (1,0,1) 0.357585, 0.71517, 0.119195 = (0.412391, 0.212639, 0.0193308) 0.180482, 0.0721926, 0.950536传递函数:

Image State:

Viewing Environment: 常规家庭、办公照明环境

Data Type:

- Rec. 2020

三原色和白点:

CIE xy chromaticity red green blue whitepoint x 0.708 0.170 0.131 0.3127 y 0.292 0.797 0.046 0.3290 z 0. 0.033 0.823 0.3583 - 渲染 颜色值 颜色空间

- Radiometry or Photometry

渲染中选择的单位是 Radiometry 还是 Photometry,这个问题的答案并不统一。

- Photometry

Moving Frostbite to PBR 文章描述:Frostbite 引擎中,整个渲染管线使用了 photometry。使用 radiometry,就需要同时提供 luminous efficacy(发光效率),这增加了艺术家工作的复杂性,因此,最好假设光的波长都为 555nm,此时 1(watt)=683(lumen)。这样可以简单转化 Radiometry 和 Photometry 的单位。现实世界中光源都是按照 Photometry 度量的,所以最终引擎采用了 Photometry 作为单位。

- Radiometry

Radiometry Versus Photometry 文章描述:如果是渲染单色图片,使用 Radiometry 和 Photometry 都一样,只需要对渲染结果进行简单转化。如果是渲染 RGB 彩色图片, 渲染中应该使用 Radiometry 单位。使用 Radiometry 单位,颜色值(1,1,1)是白色,且对应的 SPD 大致是平坦的。使用 Photometry 单位,颜色值(1,1,1)不是白色,而是一种紫色,绿色范围内的能量较少,而红色和蓝色范围内的能量较多。

- Photometry

- linear and non-linear color space

几何光学中,光能量是线性的,光物体交互可以用相加和相乘来模拟。如,两个光源叠加相当于两个光源的 SPD 相加;光源 L(光源的光谱分布为 L)照射物体 O(物体的反射光谱分布为 O),则物体反射的光为 L*O。

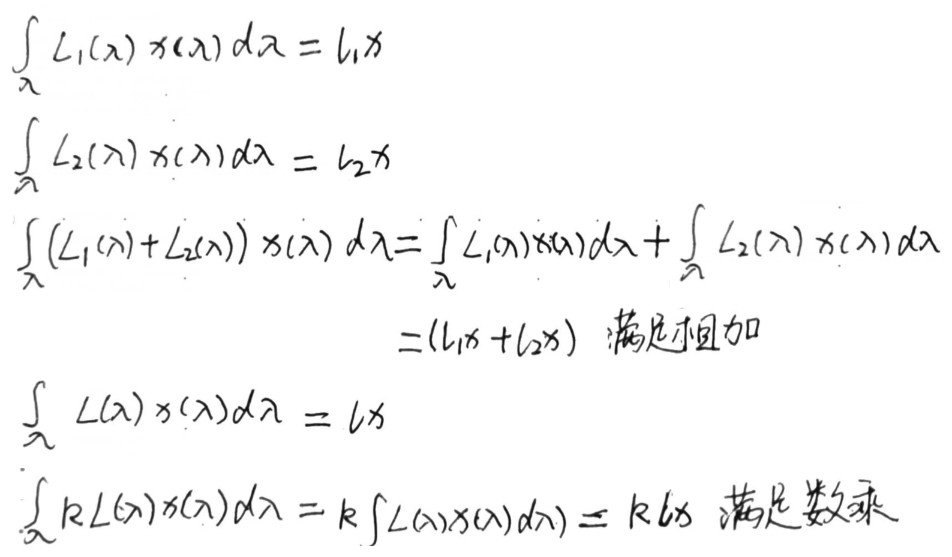

使用 RGB 模型表示光谱分布时也是线性的,证明如下图:

在渲染计算中,若所选的颜色空间不是线性的,则无法正确模拟光和物体的交互。例如:若我们选用的颜色空间是二次的(LightEnergy = LightPos^2 光对应的坐标值和能量是二次关系),考虑指定波长的光其坐标值为 1,对应的能量是 1,坐标值为 2,对应的能量是 4。

二次空间颜色值 1 + 2 = 3 对应的能量计算 1 + 4 = 5 二次颜色值3 转化为能量后为 9, 这和使用能量计算的结果5不相同。

因此,渲染计算中需要使用线性的颜色空间。

- sRGB BT.2020 ACES2065-1

本质上来说,sRGB CIE-RGB 或 CIE-XYZ 颜色值都是光谱功率分布和响应函数积分得到的。

sRGB 的三个基向量为 R(1,0,0) G(0,1,0) B(0,0,1)

CIE-RGB 的三个基向量为 R(1,0,0) G(0,1,0) B(0,0,1)

CIE-XYZ 的三个基向量为 X(1,0,0) Y(0,1,0) Z(0,0,1)

虽然, 以上三个颜色空间都是线性空间。但是,由于三原色、白点不同,使用不同的颜色空间渲染得到的结果会有差异。颜色相加不会导致结果不同,但是颜色相乘的结果受到三原色选取影响。

前人的研究表明,那些三原色越接近光谱轨迹的色域空间渲染出来的结果往往更接近光谱渲染的正确结果,ACEScg 就是这样一个颜色空间,它的三原色 AP1 在光谱轨迹附近,且包含了 Rec. 2020 等常见的广色域空间,因此它非常适合作为 CG 和 VFX 等计算机渲染的工作空间。

- Radiometry or Photometry

- 参考资料

- Color Model https://en.wikipedia.org/wiki/Color_model

- RGB color space https://en.wikipedia.org/wiki/RGB_color_space

- 线性和非线性的区别是什么? https://www.zhihu.com/question/293327883

- 格拉斯曼定律 (色彩) https://zh.wikipedia.org/wiki/%E6%A0%BC%E6%8B%89%E6%96%AF%E6%9B%BC%E5%AE%9A%E5%BE%8B_(%E8%89%B2%E5%BD%A9)

- 色彩空间基础 https://zhuanlan.zhihu.com/p/24214731

- 色彩空间表示与转换 https://zhuanlan.zhihu.com/p/24281841

- HDR 和色彩管理 1 光、颜色和色度图 https://zhuanlan.zhihu.com/p/129095380

- HDR 和色彩管理 2 颜色空间 https://zhuanlan.zhihu.com/p/133434457

- displaycal https://displaycal.net/

- Color Model https://en.wikipedia.org/wiki/Color_model

- 颜色模型

- 色域、色温和白平衡

- 实时渲染中如何模拟色调适应?

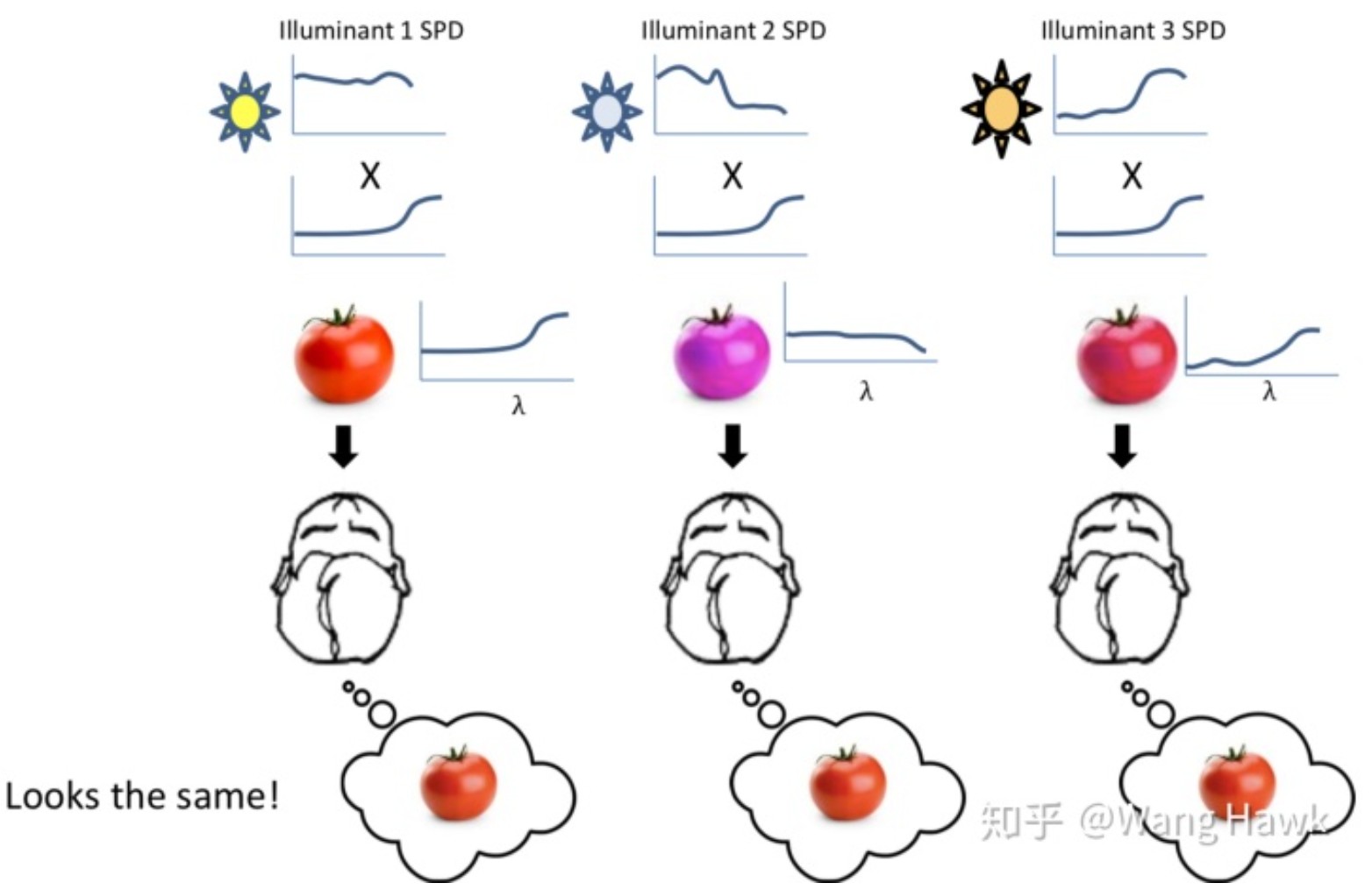

色调适应是指光照变化后,物体实际反射到人眼的 SPD(光谱能量分布) 也会发生变化,但是,人类的视角系统有一种神奇能力,可以让视网膜得到的颜色和大脑中感知的颜色不同,从而使得不同光照下,同一个物体的感知颜色是相同的。

实时渲染中在后处理中通过白平衡来实现颜色的恒常。白平衡实现中通过调节两个参数:色温和色调,来设置白点的位置,从而得到正确的色彩转换;色温调节蓝-黄偏色,色调调节绿-品红偏色。

- 白平衡原理

简单来说,白平衡原理为求解变换矩阵,其可以将设置的白点 w 转化为 D65 白点 wD65,将该变换矩阵应用于画面的每个像素颜色 c,就可以得到白平衡后的颜色 cWB。

// 将设置的白点w转化为 D65白点 wD65 w * wD65/w = wD65; // 执行白平衡变换 c * wD65/w = cWB;

具体操作如下:

- 将 temperature 和 tint 表示的白点 转化为 CIE xy chromaticity 中的白点 wXYZ(x,y)

- 将 wXYZ(x,y)转化为 LMS 空间的白点 wLSM

- 计算 LSM 空间的 D65 白点 wD65LSM

- 计算 LMS 空间中白平衡变换矩阵如下面注释所示

/// Converts white balancing parameter to LMS coefficients. /// <param name="temperature">A temperature offset, in range [-100;100].</param> /// <param name="tint">A tint offset, in range [-100;100].</param> /// <returns>LMS coefficients.</returns> public static Vector3 ColorBalanceToLMSCoeffs(float temperature, float tint) { // Range ~[-1.5;1.5] works best float t1 = temperature / 65f; float t2 = tint / 65f; // Get the CIE xy chromaticity of the reference white point. // Note: 0.31271 = x value on the D65 white point float x = 0.31271f - t1 * (t1 < 0f ? 0.1f : 0.05f); float y = StandardIlluminantY(x) + t2 * 0.05f; // Calculate the coefficients in the LMS space. var w1 = new Vector3(0.949237f, 1.03542f, 1.08728f); // LMS space D65 white point var w2 = CIExyToLMS(x, y); return new Vector3(w1.x / w2.x, w1.y / w2.y, w1.z / w2.z); } // Tips: Unity使用的XYZ2LSM变换矩阵来自 CIECAM02, 参考下面 LMS_color_space 链接内容

Color appearance model(CAM) 是一种数学模型,旨在描述人类颜色视觉的感知方面,例如,在何种观察调节下,颜色外观与刺激源的相应物理测量不相符。(相比之下,颜色模型定义了一个坐标空间来描述颜色,例如 RGB 和 CMYK 颜色模型。)

因此,Unity 中在进行白平衡时,将颜色转化到 CAM02 颜色模型下。

// sRGB -> XYZ 0.4124 0.3576 0.1805 0.2126 0.7152 0.0722 0.0193 0.1192 0.9505 // XYZ -> sRGB = inverse(sRGB2XYZ) +3.2406 -1.5372 -0.4986 -0.9689 +1.8758 +0.0415 +0.0557 -0.2040 +1.0570 // XYZ -> LSM(CAM02) 0.7328 0.4296 -0.1624 -0.7036 1.6975 0.0061 0.0030 0.0136 0.9834 // LSM -> XYZ = inverse(XYZ2LSM) 1.096124 -0.278869 0.182745 0.454369 0.473533 0.072098 -0.009628 -0.005698 1.015326 // sRGB -> XYZ -> LSM = XYZ2LSM * sRGB2XYZ * srgbColor // 注意:矩阵要左乘 3.90405e-1, 5.49941e-1, 8.92632e-3, 7.08416e-2, 9.63172e-1, 1.35775e-3, 2.31082e-2, 1.28021e-1, 9.36245e-1 // LSM -> XYZ -> sRGB = XYZ2sRGB * LSM2XYZ * lsmColor // 注意:矩阵要左乘 +2.85847e+0, -1.62879e+0, -2.48910e-2, -2.10182e-1, +1.15820e+0, +3.24281e-4, -4.18120e-2, -1.18169e-1, +1.06867e+0

- Color balance https://en.wikipedia.org/wiki/Color_balance

- LMS_color_space https://en.wikipedia.org/wiki/LMS_color_space#CAT02

- Color appearance model https://en.wikipedia.org/wiki/Color_appearance_model

- CAM02 https://en.wikipedia.org/wiki/CIECAM02

- The CIECAM02 Color Appearance Model https://scholarworks.rit.edu/cgi/viewcontent.cgi?article=1146&context=other

- 白平衡算法 http://www.brucelindbloom.com/index.html?Eqn_ChromAdapt.html 有道云笔记有备份

- 将 temperature 和 tint 表示的白点 转化为 CIE xy chromaticity 中的白点 wXYZ(x,y)

- 参考资料

- 颜色知识 3-色域、色温和白平衡 https://zhuanlan.zhihu.com/p/84954611

- 色温、白平衡与色彩恒常性 https://zhuanlan.zhihu.com/p/27165715

- 色彩恒常性 https://baike.baidu.com/item/%E9%A2%9C%E8%89%B2%E6%81%92%E5%B8%B8%E6%80%A7

- 颜色知识 3-色域、色温和白平衡 https://zhuanlan.zhihu.com/p/84954611

- 实时渲染中如何模拟色调适应?

- HDR 和色彩管理

- human eye https://en.wikipedia.org/wiki/Human_eye

- HDR 和色彩管理 3 SDR 和 HDR https://zhuanlan.zhihu.com/p/138295496

- HDR 和色彩管理 4 HDR 标准和 ACES https://zhuanlan.zhihu.com/p/144775352

- HDR 和色彩管理 5 游戏中的 HDR https://zhuanlan.zhihu.com/p/150894189

- ACES https://en.wikipedia.org/wiki/Academy_Color_Encoding_System

- human eye https://en.wikipedia.org/wiki/Human_eye

- Q&A

- 如何理解 颜色知识 2-三原色理论与颜色匹配实验 文章中的颜色匹配函数?

横轴为光的波长,纵轴为匹配该波长的光的颜色所使用的红、绿、蓝三种波长光的量。

红色曲线有一部分落在了 x 轴之下,这是因为混合红、绿、蓝三种波长光无法得到这个区域对应的光的颜色,需要将红色光叠在被匹配的光上,才能使得两边颜色一直(默认情况下,左边为被匹配的光,右边为红绿蓝三种波长的光叠加在一起的混合光)。

请参考下面文中描述

- 色觉地图的建立(一):光感受器、色匹配实验与 CIE RGB 坐标系 https://zhuanlan.zhihu.com/p/72803768

- 色觉地图的建立(一):光感受器、色匹配实验与 CIE RGB 坐标系 https://zhuanlan.zhihu.com/p/72803768

- 如何理解 颜色知识 2-三原色理论与颜色匹配实验 文章中的颜色匹配函数?

- 参考链接

具体内容参考下面链接。

- CIE 1931 XYZ 色彩空间 https://zh.wikipedia.org/wiki/CIE1931%E8%89%B2%E5%BD%A9%E7%A9%BA%E9%97%B4

- color-spaces https://ciechanow.ski/color-spaces/ 该链接中有颜色空间的 3D 图,可交互旋转这些图形

- 3D CIE-RGB CIE-XYZ 空间演示 https://graphics.stanford.edu/courses/cs178/applets/threedgamut.html

- Color: From Hexcodes to Eyeballs http://jamie-wong.com/post/color/

- CIE 1931 XYZ 色彩空间 https://zh.wikipedia.org/wiki/CIE1931%E8%89%B2%E5%BD%A9%E7%A9%BA%E9%97%B4

- 三原色理论 颜色匹配实验

参考资料

- Color and Light http://www.cse.psu.edu/~rtc12/CSE486/lecture26.pdf

- 色觉地图的建立(一):光感受器、色匹配实验与 CIE RGB 坐标系 https://zhuanlan.zhihu.com/p/72803768

- HumanSensitivity to color http://graphics.stanford.edu/courses/cs178/applets/locus.html

- ColorMatching http://graphics.stanford.edu/courses/cs178/applets/colormatching.html

Spectral Representation

pbr 中不支持动态修改 Spectrum 类型,修改 Spectrum 类型需要重新编译,这样做有两个好处:

- 很多 Spectrum 的方法都可以实现为 inlined,而不需要通过虚函数机制来支持不同 Spectrum 类型

- 不需要动态创建 Spectrum 的实例。

CoefficientSpectrum 下面的样本访问函数的实现中隐含了光谱表示是一系列的系数线性地缩放一组固定的基函数。尽管这种抽象不够理想,但是其简化了当前系统其他部分的实现,并且当这个假设不正确时,也不难清除。

Float & CoefficientSpectrum::operator[](int i) { return c[i]; } Float CoefficientSpectrum::operator[](int i) const { return c[i]; }

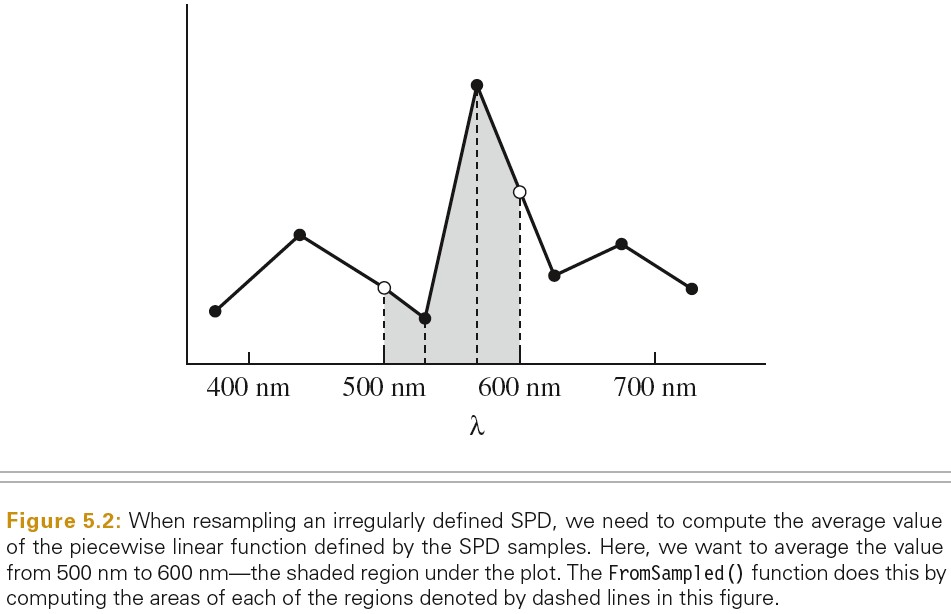

SampledSpectrum

下图展示了利用线性插值来求平均的光谱采样:

XYZ Color

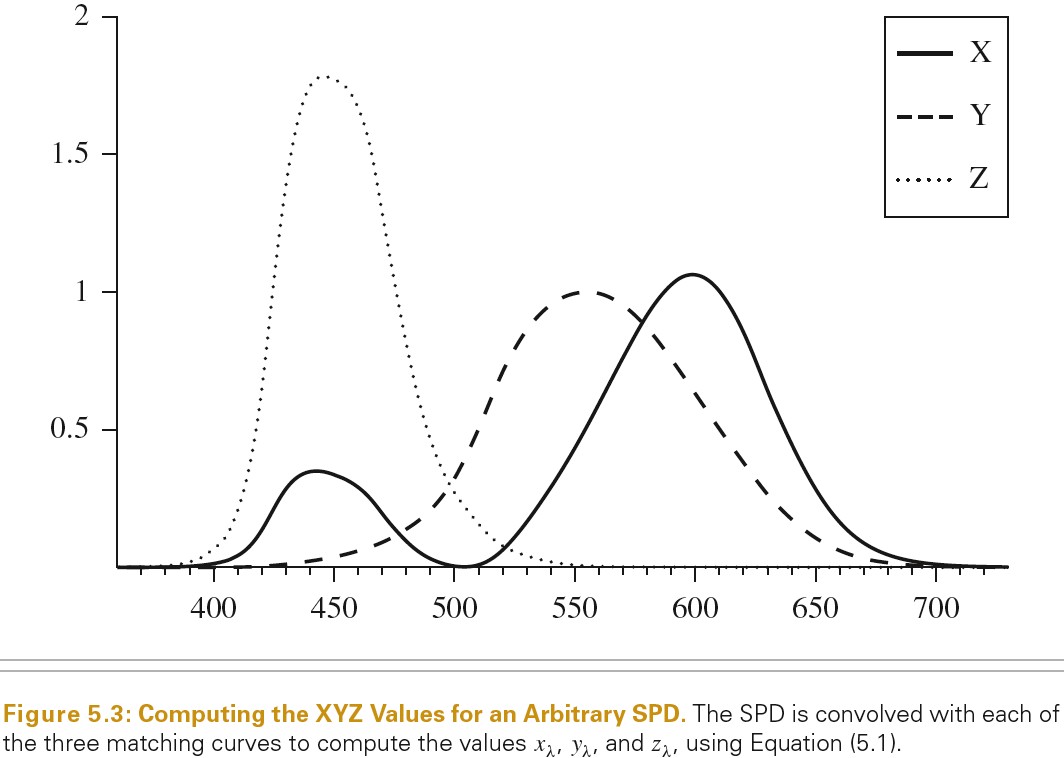

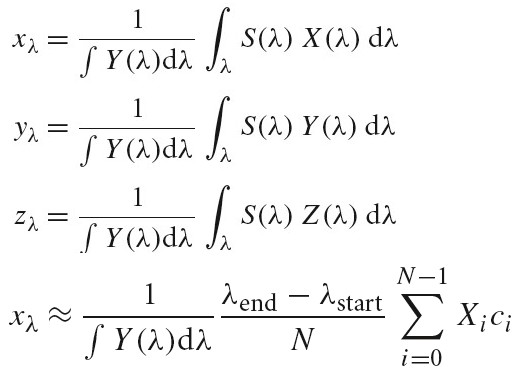

人类视觉系统的特性决定了可以只使用 3 个浮点值就可以表示人类看到的颜色。色彩感知的三原色理论表示,可以使用三个值 xλ,yλ,zλ为人类观察者精确表示所有可见光谱。

给定一个 SPD S(λ),这三个值可通过下面公式计算得到,X(λ) Y(λ) Z(λ) 分别为光谱匹配曲线,这些曲线由 CIE 标准通过一系列主观试验测试绘制出来。这些匹配曲线和人眼视网膜上的三种颜色感知视锥细胞的响应曲线相似。

下图为光谱匹配曲线:

下图为由 SPD 和 X(λ) Y(λ) Z(λ)计算 xλ,yλ,zλ的方法:

需要注意的是,不同的光谱分布可能会得到相似的 xλ,yλ,zλ值。对于人类视觉来说,这些不同的 SPDs 确有相同的可视效果。这些光谱被称为条件等色。

尽管 XYZ 可以很好的将一个给定的 SPD 表示为人类观察者看到的颜色。但是其也有不足的地方,例如,计算两个颜色各自 XYZ 值的乘积所得的 XYZ 值和将两个 SPD 相乘然后计算结果的 XYZ 值有明显的差别。

XYZ 空间的 y 系数和 luminance 有紧密联系,其用于度量颜色的亮度感觉。

RGB Color

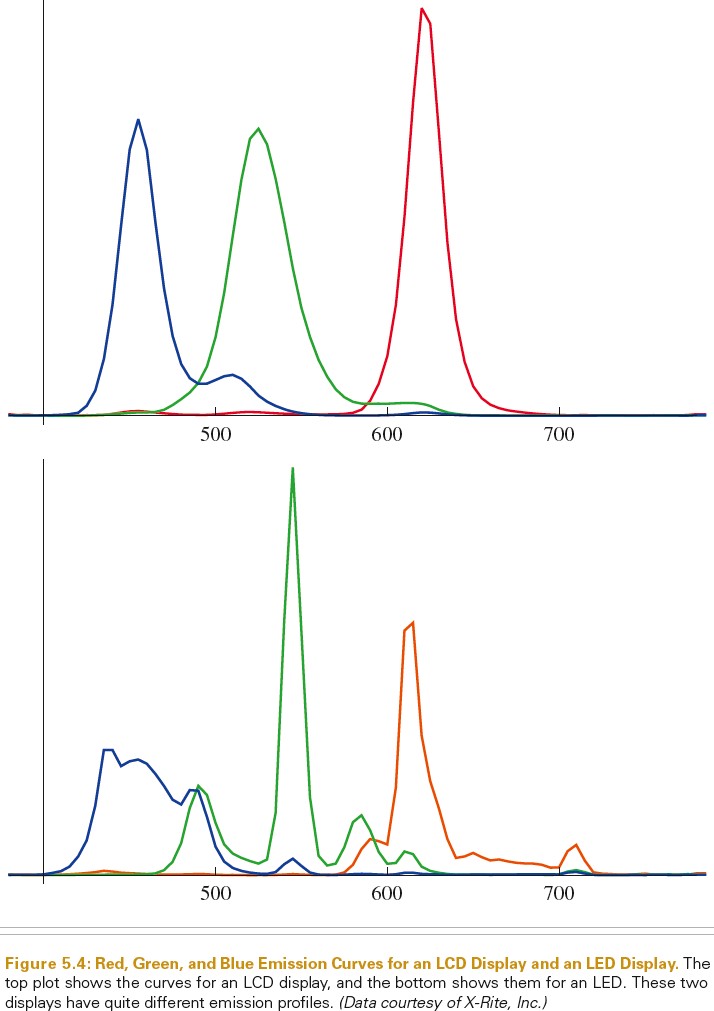

当我们将 RGB 颜色显示到显示器上时,实际上显示的光谱基本由 r、g、b 三个光谱响应曲线的权重和决定。下图显示了 LED 显示器和 LCD 显示器发出的 r、g、b 的分布:

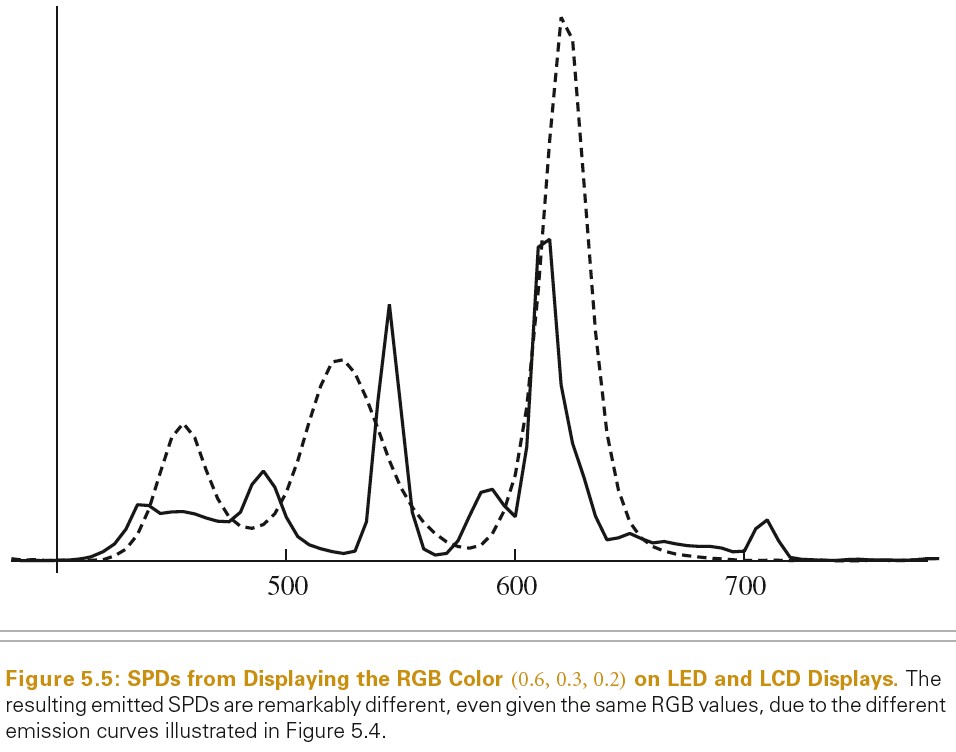

下图显示了 RGB 颜色(0.6,0.3,0.2)在 LED、LCD 上的显示时的 SPD,可以看出,不同显示器显示相同颜色,所得的 SPD 却非常不同,因此用户提供的用于表示特定颜色的 RGB 值,只有知道显示器特性才有意义。

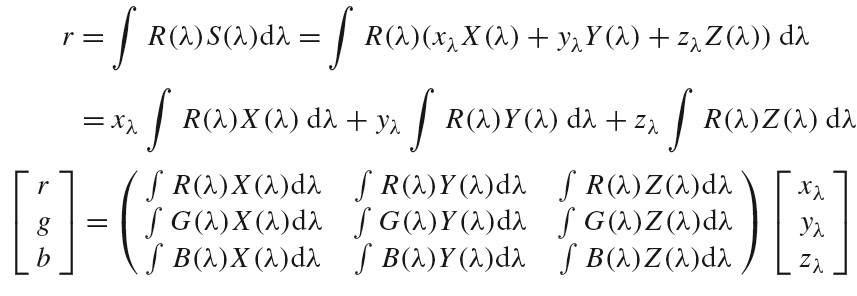

给定 SPD 的(xλ,yλ,zλ)表示形式,并选择一组特定的 SPD 来定义显示器的红色,绿色和蓝色,我们可以将(xλ,yλ,zλ)转换为对应显示器的 RGB 系数。给定显示器的光谱响应曲线 R(λ), G(λ), B(λ),对于特定的显示器 RGB 系数可以通过下面方法来计算:

inline void XYZToRGB(const Float xyz[3], Float rgb[3]) { rgb[0] = 3.240479f * xyz[0] - 1.537150f * xyz[1] - 0.498535f * xyz[2]; rgb[1] = -0.969256f * xyz[0] + 1.875991f * xyz[1] + 0.041556f * xyz[2]; rgb[2] = 0.055648f * xyz[0] - 0.204043f * xyz[1] + 1.057311f * xyz[2]; }

将 RGB 或 XYZ 值转化为 SPD 比较难,无数多个 SPD 有相同的 xλ,yλ,zλ系数。我们希望转化函数可以满足如下条件:

- 当 RGB 系数相同时,得到的 SPD 应该是一个常数

- 通常,希望计算得到的 SPD 是平滑的。大多数真实世界的物体都具有平滑的 SPD。不平滑的光谱主要来源于光源,特别是荧光灯。

通过将显示器的 R(λ), G(λ), and B(λ) SPDs 加权求和来构造 SPD 不是一个很好的解决方案,因为显示器的 R(λ), G(λ), and B(λ) SPDs 通常是不规律、不平滑的,加权求和得到的 SPD 也不会平滑。

Smits(1999)发现了一种将 RGBs 转化为 SPDs 的方法。分别为 red、green、blue 计算各自的 SPDs,并保证这些 SPDs 光滑,然后用给定的 RGB 系数对这些 SPDs 进行加权求和,从而得到平滑的 SPD,再将 SPD 转化为 RGB 可以得到一个和原始 RGB 系数接近的系数.可以对这种基本方式做下面两个额外的改进:

- 不要使用 red\green\blue 的 SPDs 的和来表示常量光谱,直接通过常量光谱表示常量 SPDs。

- 混合颜色是由两种元颜色混合而来,混合颜色最好通过预计算的光滑的 SPD 来表示,而不是通过元颜色的和表示

SampledSpectrum SampledSpectrum::FromRGB(const Float rgb[3], SpectrumType type) { SampledSpectrum r; if (type == SpectrumType::Reflectance) { // Convert reflectance spectrum to RGB if (rgb[0] <= rgb[1] && rgb[0] <= rgb[2]) { // Compute reflectance _SampledSpectrum_ with _rgb[0]_ as minimum r += rgb[0] * rgbRefl2SpectWhite; if (rgb[1] <= rgb[2]) { r += (rgb[1] - rgb[0]) * rgbRefl2SpectCyan; r += (rgb[2] - rgb[1]) * rgbRefl2SpectBlue; } else { r += (rgb[2] - rgb[0]) * rgbRefl2SpectCyan; r += (rgb[1] - rgb[2]) * rgbRefl2SpectGreen; } } } // ... }

- LCD 显示器工作原理到底是怎样的? https://www.zhihu.com/question/39452323

- 显示器如何显示准确的颜色? https://zhuanlan.zhihu.com/p/43467096

- An RGB to Spectrum Conversion for Reflectances http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.40.9608&rep=rep1&type=pdf

参考资料

RGBSpectrum

Radiometry

辐射度学并不是使用物理的第一原理推导而来,而是基于光的粒子抽象建立的。因此,该框架无法描述光的偏振,但是已经将辐射度学和麦克斯韦方程建立了联系,这为辐射度学提供了坚实的物理基础。

辐射传播是辐射能量的传播。其基于辐射度原理,属于几何光学层面,光的宏观属性足够描述光和物体(物体的尺寸远大于光的波长)的交互。其很少包含光的波动光学模型,但是波动光学的结果需要使用辐射度学的语言来描述。这样就可以描述光和尺寸较小的物体(物体尺寸和波长近似)的交互,可以模拟色散和干涉现象。更精细的细节就需要利用量子机制来描述光和原子的交互。渲染问题不需要直接模拟量子机制。

pbrt 中,我们假设几何光学足够描述光和光的散射。这样可以得到如下一些光的行为规则:

- 线性关系:组合两个输入等价于两个输入分别作用的结果的和

- 能量守恒:散射后能量不会比原来更多

- 没有偏振:忽略电磁场的偏振

- 没有荧光和磷光:这些是光在一个波长尺度上的行为,和光在多个波长尺度上的行为完全独立。

- 稳定的状态:光在环境中达到均衡,其辐射分布不会随时间变化。注意:磷光现象违反了稳定状态的假设。

几何光学模型的最大缺点是无法简单地模拟色散和干涉现象。因为两个区域总的通量不必和各自接收的能量的和相等。

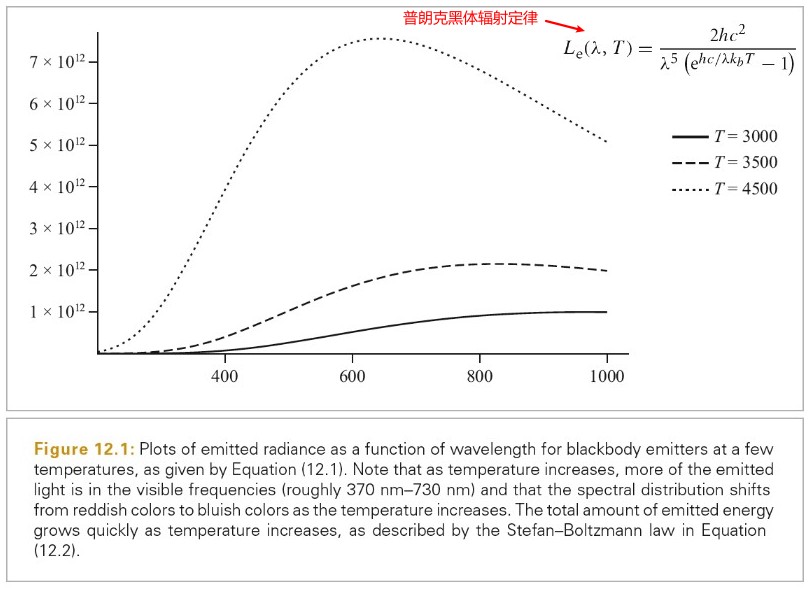

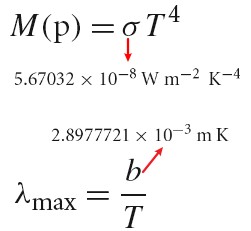

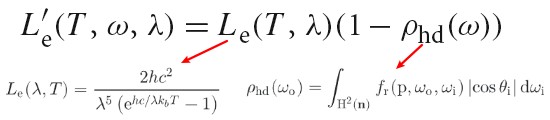

下图展示了辐射度学中的物理量:

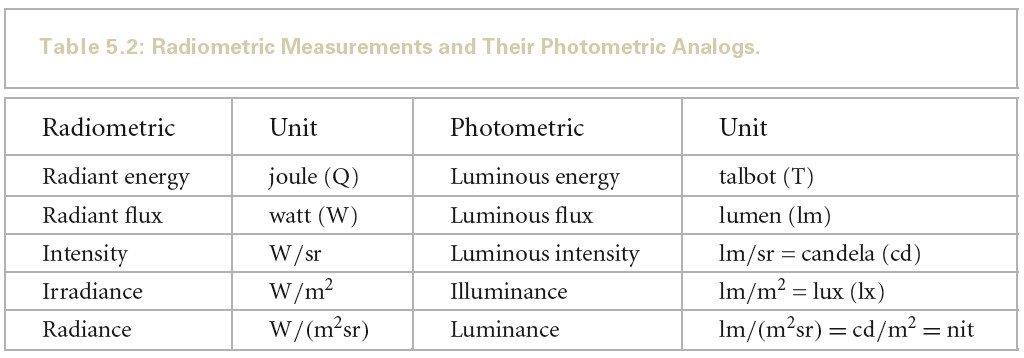

所有的辐射度测量物理量都有对应的光度测量物理量。光度学是研究人类视觉系统对可见的电子辐射的感觉。

人眼能相当精确地判断两种颜色的光亮暗感觉是否相同。所以为了确定眼睛的光谱响应,可将各种波长的光引起亮暗感觉所需的辐射通量进行比较。在较明亮环境中人的视觉对波长为 555.016nm 的绿色光最为敏感。设任意波长为 λ 的光和波长为 555.016nm 的光产生同样亮暗感觉所需的辐射通量分别为 Ψλ 和 Ψ555.016,把后者和前者之比 V(λ) = Ψ555.016 / Ψλ 叫做光度函数(luminosity function)或视见函数(visual sensitivity function)

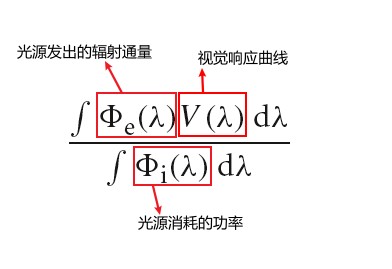

每个光谱辐射度物理量都可以被转化为对应的光度物理量,只需要对辐射度物理量和对应光度响应曲线的积做积分就可以了。下图展示了辐射度测量物理量和光度学测量物理量之间的对应关系:

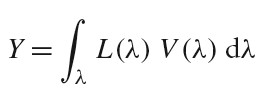

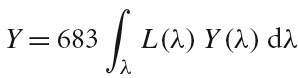

Luminance 测量了人眼观察到的光谱功率分布的亮度。和 Luminance 对应的辐射度测量物理量为 Radiance(记作 L),下图表示了计算 Luminance(记作 Y)的公式:

Lunimance 和光谱响应曲线 V (λ)与 XYZ 颜色表示有紧密关系。CIE 的 Y (λ) 三刺激曲线是和人类亮度响应曲线 V(λ)成比例的。

Tips:

Intensity 为辐射强度,Luminous Intensity 为光强度

Radiance 为辐射率或辐射亮度

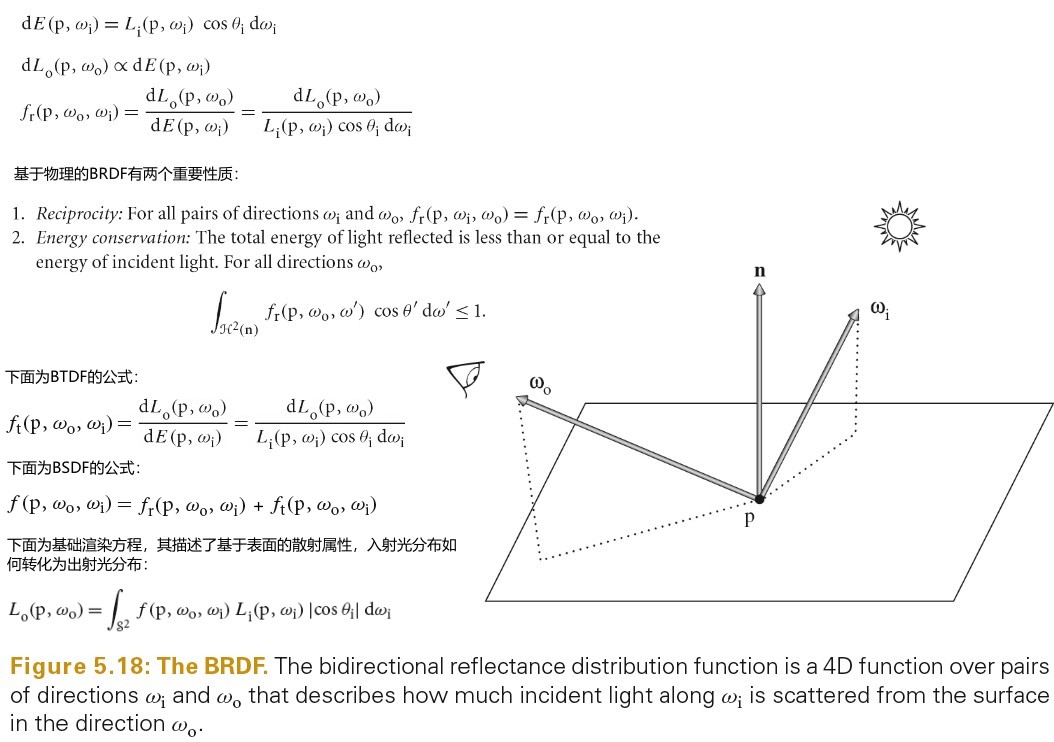

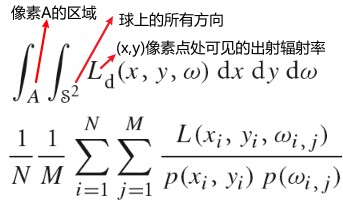

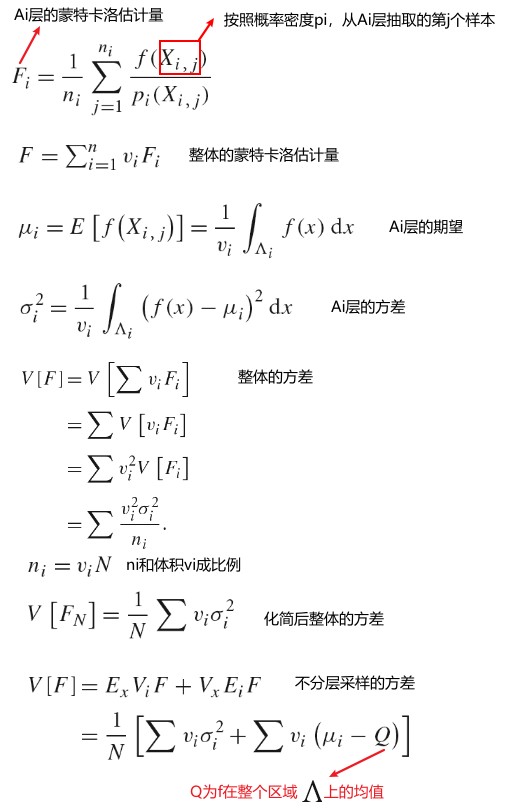

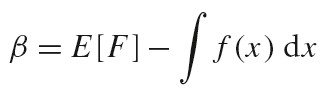

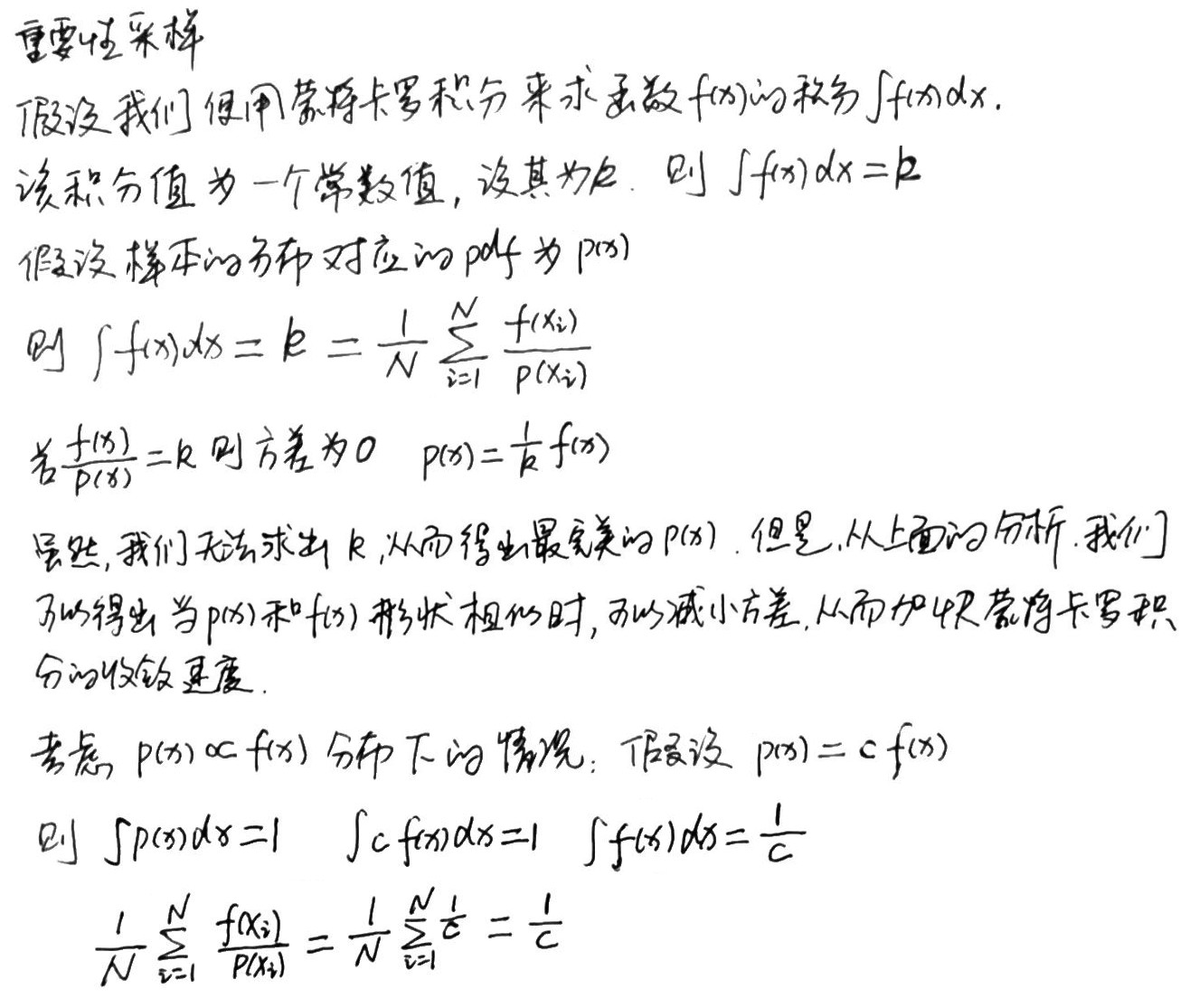

Working With Radiometric intergals

渲染中最寻常的任务是求辐射量的积分。本节介绍一些技巧可以简化求辐射量积分的任务。

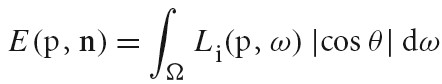

Integrals over projected solid angle

下图为计算点 p 处的 irradiance(辐照度) n 为点 p 处表面的 normal,Li(p,w)为 radiance(入射辐射度)函数,cos(θ)为 dA⊥项。θ 为 w 和 n 的夹角。辐照度通常只计算 normal 指向的半球范围。

辐射量积分中的各种 cosine 项经常会分散其要表示的内容。使用投影立体角而不是立体角来度量积分对象覆盖的区域可以避免此问题。

物体的投影立体角是通过先将物体投影到单位球上,然后再将物体投影到垂直与 normal 的 disc 上得到的。如下图所示:

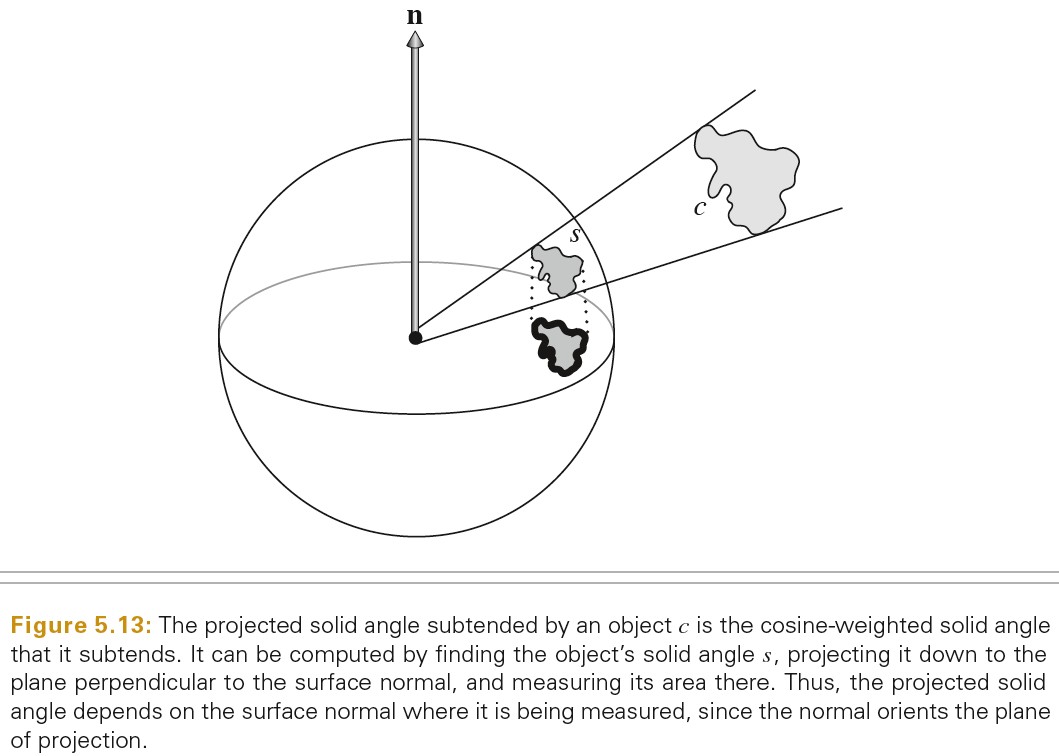

在半球范围内,从某个物体发出的总的通量可以通过下面公式计算,其中 A 为该物体的表面积:

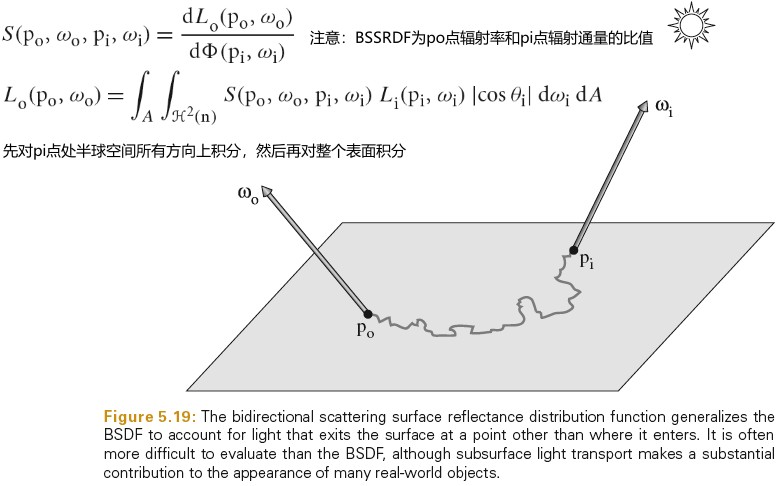

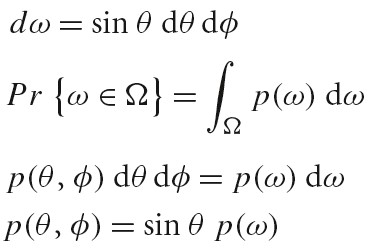

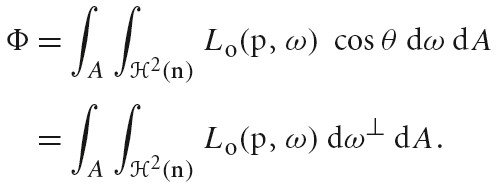

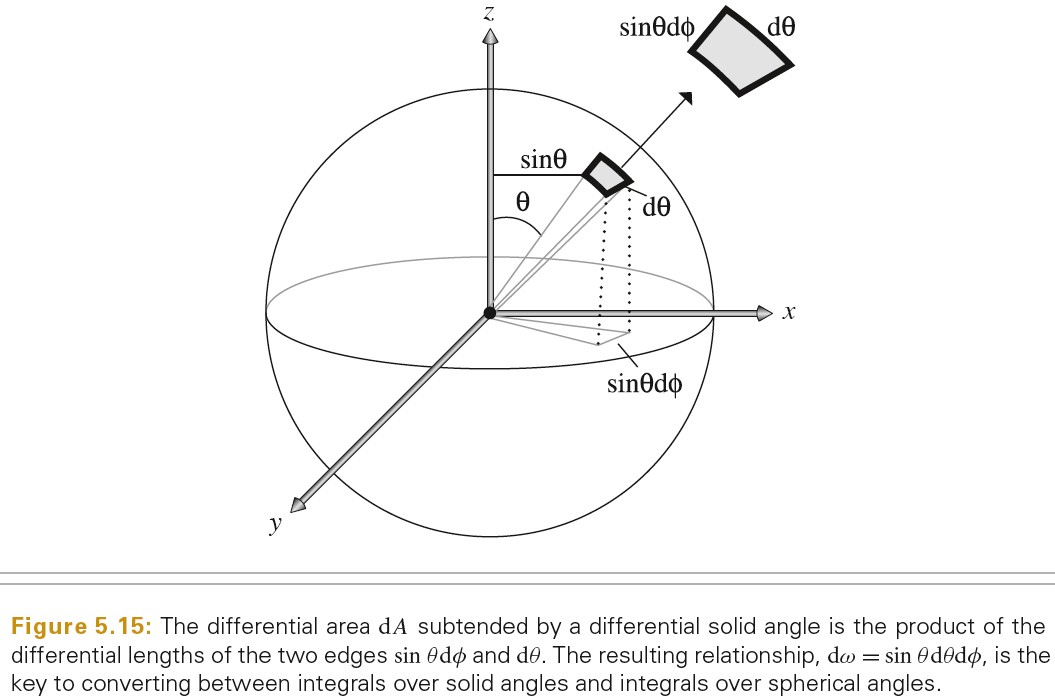

Integrals over spherical coordinates

将立体角积分转化为球面坐标系积分经常很方便。

下图将一个向量转化为球坐标系形式:

下图将立体角转化为球面坐标系形式:

则点 p 处的 irradiance(辐照度)可以通过如下方式计算:

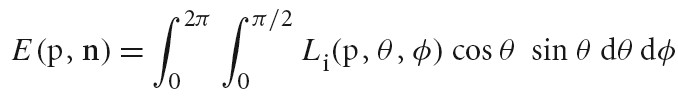

Integrals over area

将在方向上的积分转化为在区域(面积)上的积分可以简化计算。有一个正方形发出恒定的 radiance(辐射率),计算点 p 处的 irradiance(辐照度)。在各个方向上积分来求该值是不太直接的,因为给定一个方向需要判断该方向上正方形是否可见。在四边形的区域上积分来计算辐照度则更容易。

微分区域和微分立体角有如下关系,其中 θ 为正方形微分表面 dA 的法线和指向 p 点的向量的夹角,r为 p 和正方形微分表面 dA 之间的距离。

Surface Reflection

当光入射到表面,表面会散射光,并反射一部分光回到环境中。模拟反射主要有两个效果需要表示出来:反射光的光谱分布和反射光的方向分布。

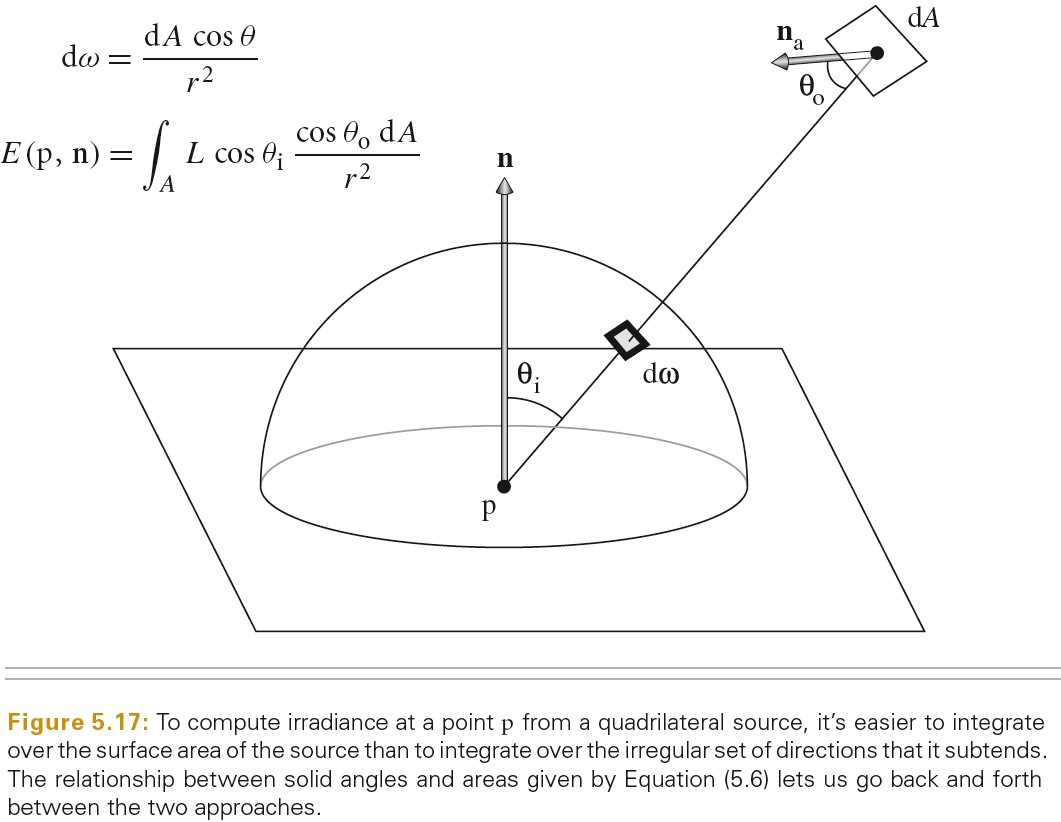

BRDF BTDF

BRDF(bidirectional reflectance distribution function) 形式化描述了表面的反射。其忽略了光在次表面传播的效果。

BTDF(bidirectional transmittance distribution function) 描述了穿过表面的光的分布。BTDF 不满足互换性(reciprocity).

BSDF(bidirectional scattering distribution function) 描述了表面反射和透射,其同时考虑了 BRDF 和 BTDF.

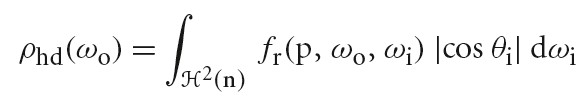

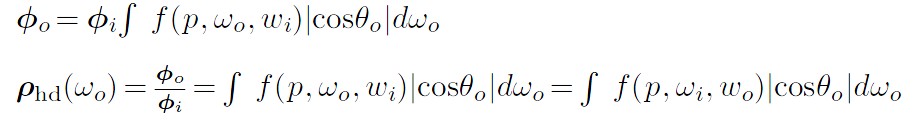

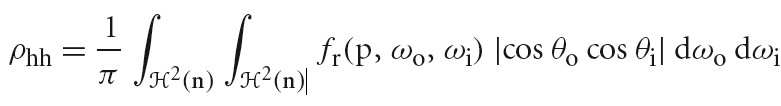

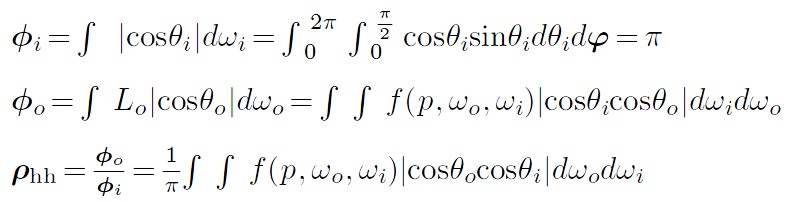

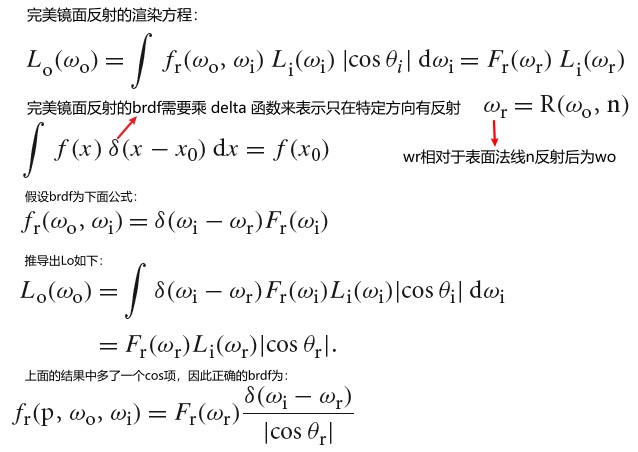

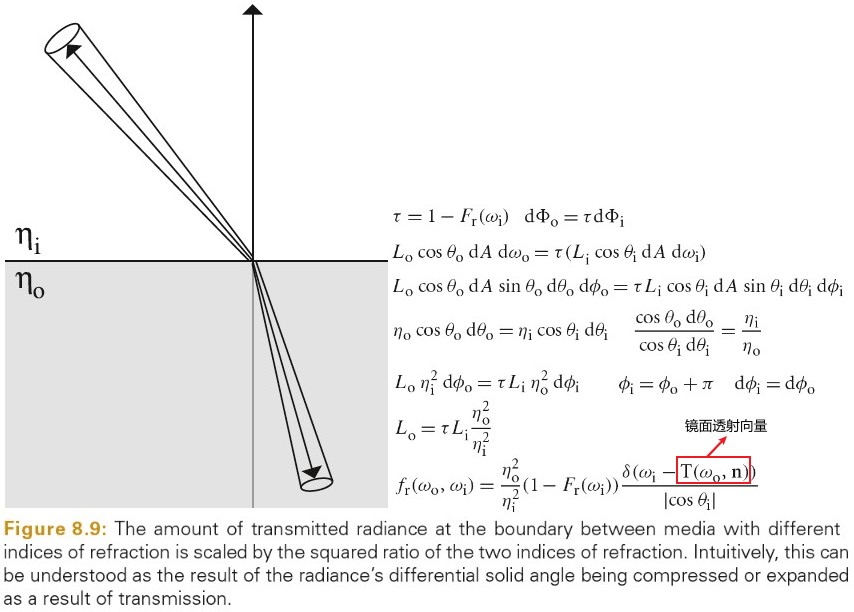

下图为 BRDF BTDF BSDF 的定义:

Tips: brdf 的范围为 0 到无穷大。例如:完美镜面反射的 brdf 就是一个 δ 函数,其在完美反射方向的值为无穷大。

6 Camera models

Camera Model

真实世界的摄像机都有一个快门,其开启一个短暂的时间将胶片暴露在光下。曝光时间大于 0 时,会造成运动模糊:曝光时间内,物体相对于摄像机运动时,物体会变模糊。摄像机都会存储快门打开的时间和快门关闭的时间,并且摄像机采样场景时生成的射线也会携带对应的时间。在快门开启关闭时间间隔内,给定恰当的射线时间分布,就可以在最终计算的图片中展现运动模糊效果。

摄像机中还包含一个 Film 实例的指针,以及一个 Medium 实例的指针(用于表示摄像机所处的介质)。

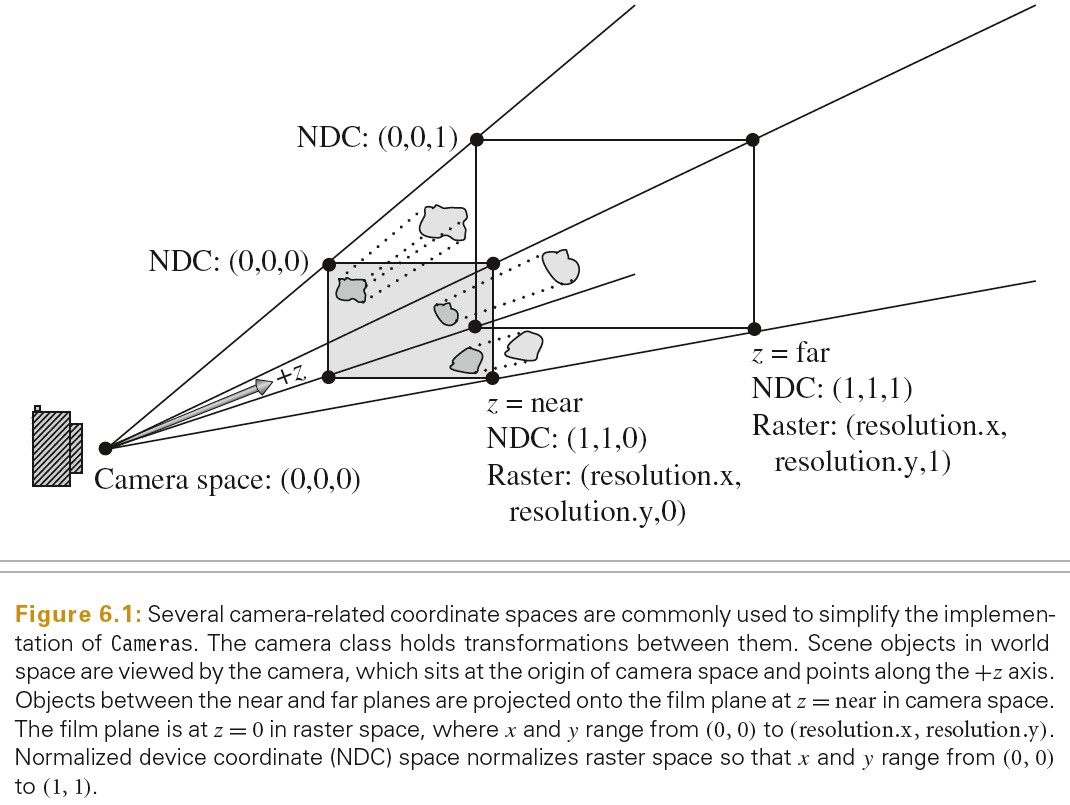

摄像机空间可以方便地监测物体对于摄像机是否可见。例如,如果物体在摄像机空间中的 BoundingBox 在 Z=0 平面后面,则物体对于摄像机不可见。

Projective Camera Models

屏幕空间:屏幕空间定义在胶片平面上。摄像机将物体从摄像机空间投影到胶片平面上。生成的图片只有在屏幕窗口内的部分是可见的。屏幕空间中深度值 Z 的范围为[0,1],分别对应近裁剪面和远裁剪面。注意:尽管被称为屏幕空间,其仍然是三维坐标系,因为 z 值是有意义的

标准设备坐标空间(NDC):该坐标系是实际被渲染图片的坐标系。x,y 方向的范围为[0,1].深度值和屏幕空间的相同。

光栅化空间:几乎和 NDC 空间相同,除了 x,y 坐标范围为[0, resolution.x] [0, resolution.y]

// ScreenToRaster ScreenToRaster = Scale(film->fullResolution.x, film->fullResolution.y, 1) * Scale(1 / (screenWindow.pMax.x - screenWindow.pMin.x), 1 / (screenWindow.pMin.y - screenWindow.pMax.y), 1) * Translate(Vector3f(-screenWindow.pMin.x, -screenWindow.pMax.y, 0)); // RasterToScreen RasterToScreen = Inverse(ScreenToRaster); // RasterToCamera RasterToCamera = Inverse(CameraToScreen) * RasterToScreen;

Orthographic Camera

// 计算正交投影矩阵 Transform Orthographic(Float zNear, Float zFar) { return Scale(1, 1, 1 / (zFar - zNear)) * Translate(Vector3f(0, 0, -zNear)); } // 正交摄像机的CameraToScreen 变换矩阵为 Orthographic(0, 1);

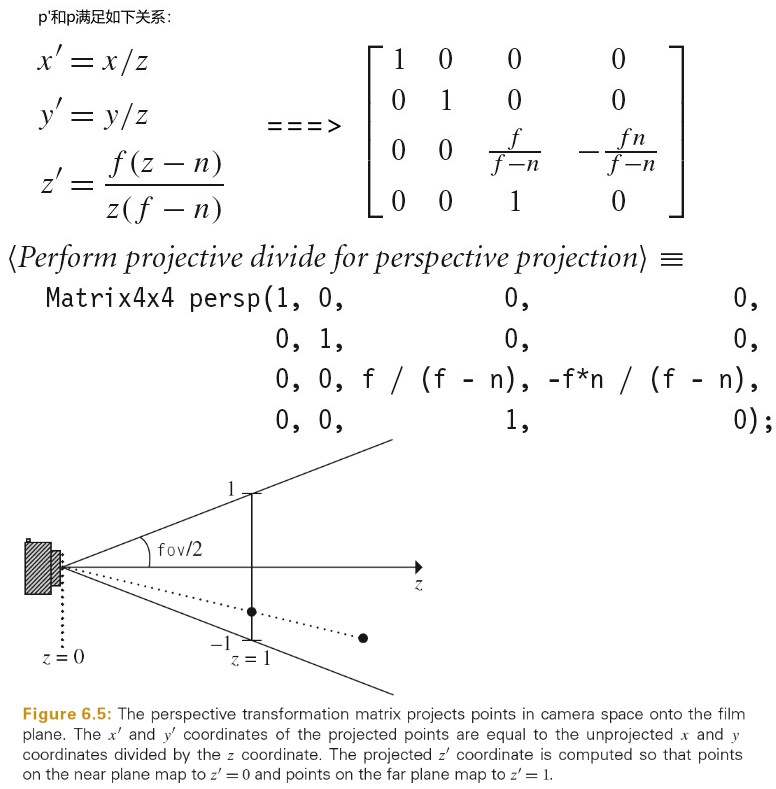

Perspective Camera

// 计算透视投影矩阵 Transform Perspective(Float fov, Float n, Float f) { // Perform projective divide for perspective projection Matrix4x4 persp(1, 0, 0, 0, 0, 1, 0, 0, 0, 0, f / (f - n), -f * n / (f - n), 0, 0, 1, 0); // Scale canonical perspective view to specified field of view Float invTanAng = 1 / std::tan(Radians(fov) / 2); return Scale(invTanAng, invTanAng, 1) * Transform(persp); } // 透视摄像机的 CameraToScreen变换矩阵为 Perspective(fov, 1e-2f, 1000.f)

上面透视投影变换的求解分为两步:

- 将点 p 投影到近平面得到点 p'。如下图所示:

- 利用用户指定的 FOV,将投影后的视景体内的坐标转化到[-1,1]范围内的坐标。

对于正方形图片来说,x和 y 都在[-1,1]范围内。

对于矩形图片来说,比较窄的方向会被映射到[-1, 1]范围,比较宽的方向会同比例映射到更大的范围。

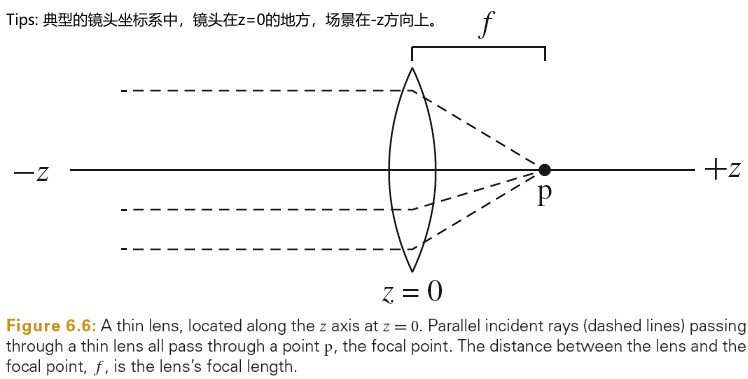

Lens Model and Depth Of Field

真实的相机有镜头系统,其将通过有限尺寸光圈的光聚焦到胶片平面上。相机设计者面临一个取舍:光圈越大,就会有越多的光进入胶片,需要曝光的时间也就越短。然而,镜头只会聚焦在单个平面上(焦点平面),离焦点平面越远的物体会越模糊。光圈越大,产生的模糊越明显。

下面是成像系统相关的几个概念:

焦点(像方交点):在物理学上指平行光线经透镜折射或曲面镜反射后的会聚点。

物方交点:

焦距:平行光从透镜的光心到光聚集之焦点的距离,即透镜中心到焦点的距离。

焦平面:与成像系统的光轴垂直、且包含成像系统焦点的平面。

镜屏距:透镜中心到屏幕(底片)的距离。

物距:物体到透镜中心的距离。

像距:给定物距和焦距情况下,像到透镜中心的距离。

合焦距离:屏幕上的像最清晰时,屏幕据透镜中心的距离。物距给定,合焦距离即是像距。

- https://www.zhihu.com/question/20086562/answer/15877139

- https://zhuanlan.zhihu.com/p/21672067

- https://baike.baidu.com/item/%E5%87%B8%E9%80%8F%E9%95%9C

- 工程光学(六)——几何光学(进阶)https://zhuanlan.zhihu.com/p/48980327

下图为凸透镜原理:

对于目前我们使用的简单摄像机模型,我们可以应用光学上经典的近似(薄镜头近似),使用计算机图形学投影模型来模拟有限光圈。薄镜头近似模拟拥有单个球面镜头的光学系统,镜头的厚薄和曲面镜头的直径有很小关系。

在薄镜头近似中,平行的入射光线经过镜头后会聚焦在一点,这点被称为焦点。焦点到镜头的距离被称为焦距 f。如果胶片被放置在镜头后焦点的位置上,则无线远的物体会被聚焦到胶片上的一个点。如下图所示:

下面链接中可以进行动态演示:

https://ophysics.com/l12.html

./PhysicallyBasedRendering/2020_06_12_ConcaveAndConvexLenses.ggb

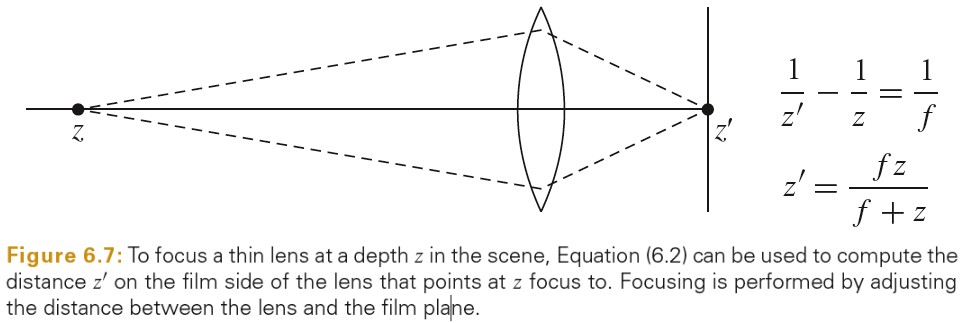

对于场景中距离镜头为 z 的一点 p,镜头的焦距为 f,p 点被镜头聚焦的点为 p',其到镜头的距离为 z'(像距),由成像公式可的如下关系:

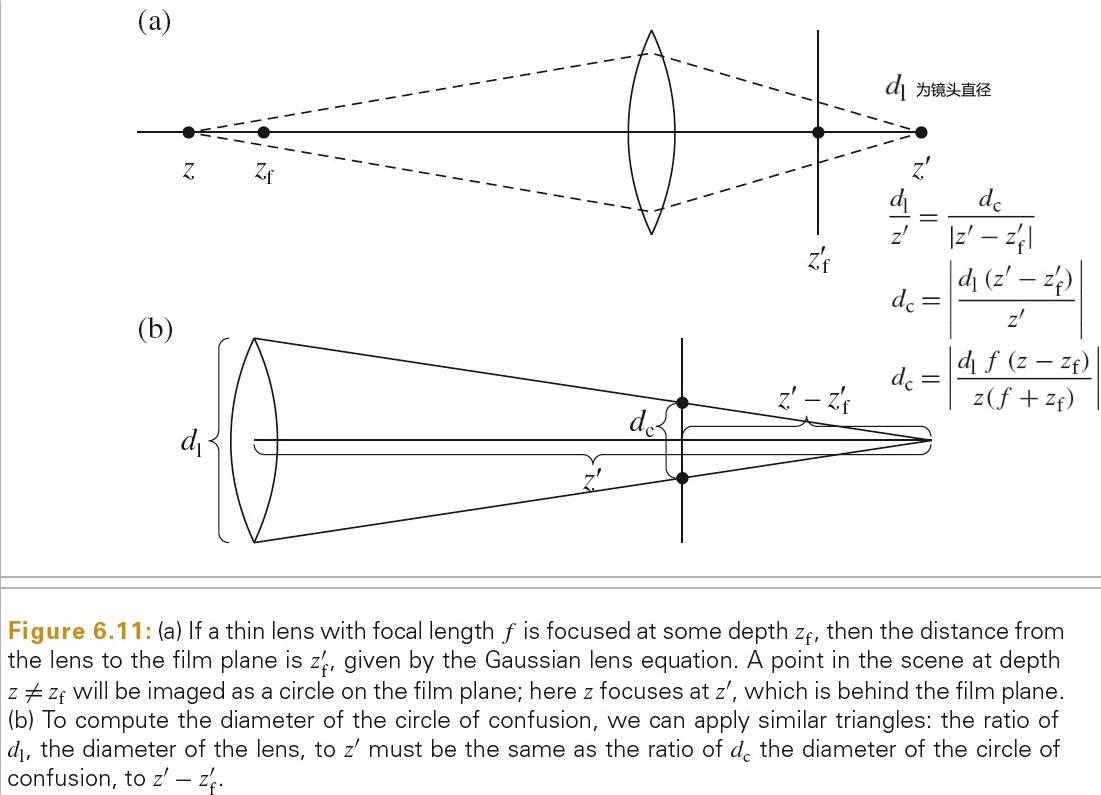

上图中的 z'就是 z 对应的像距,z和 z'是一一对应的,如果点没有放置在 z 聚焦位置上,点在胶片上的投影为一个圆盘(disk)而不是一个点。这个圆盘的边界被称为 circle of confusion。圆盘的尺寸由光圈的直径,焦距以及物体到镜头的距离决定。

在实践中,物体不需要正好在焦点平面上才投影出清晰的像,只要 circle of confusion 大致小于胶片上每个像素的大小,物像就是清晰的。物体聚焦的距离范围被称为镜头的 depth of field(景深).

成像公式可用于计算 circle of confusion 的直径。如下图所示:

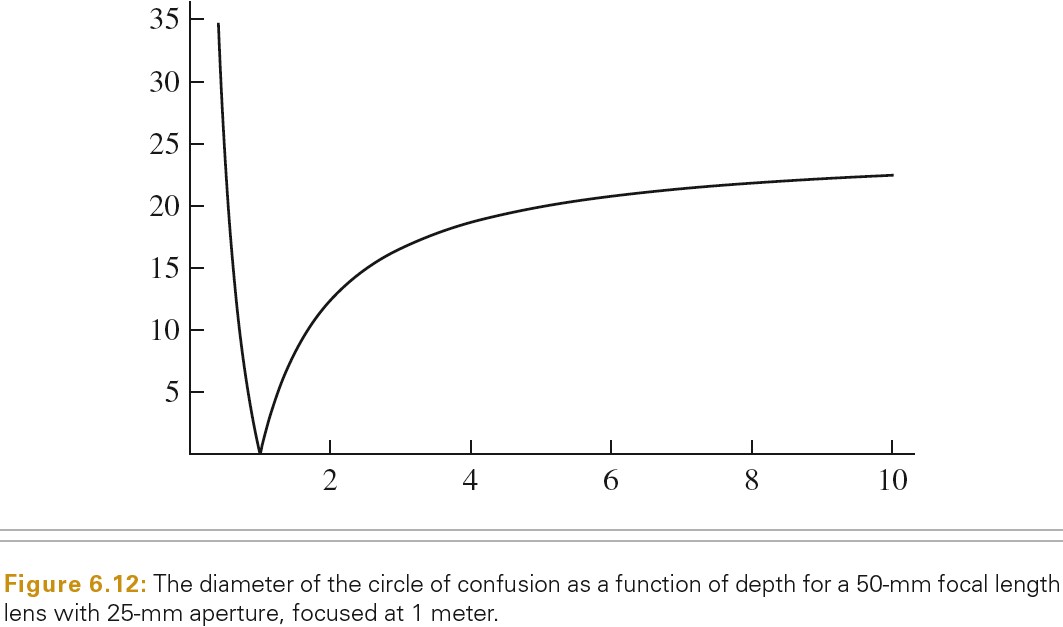

焦距 f 为 50mm 的镜头,25mm 光圈,清晰像的物距 Zf 为 1m,随着物距 z 的变化,circle of confusion 直径的变化如下图:

从上图可以看出,Z小于 Zf 时,Dc 变化比较快,而 Z 大于 Zf 时,Dc 变化比较慢。

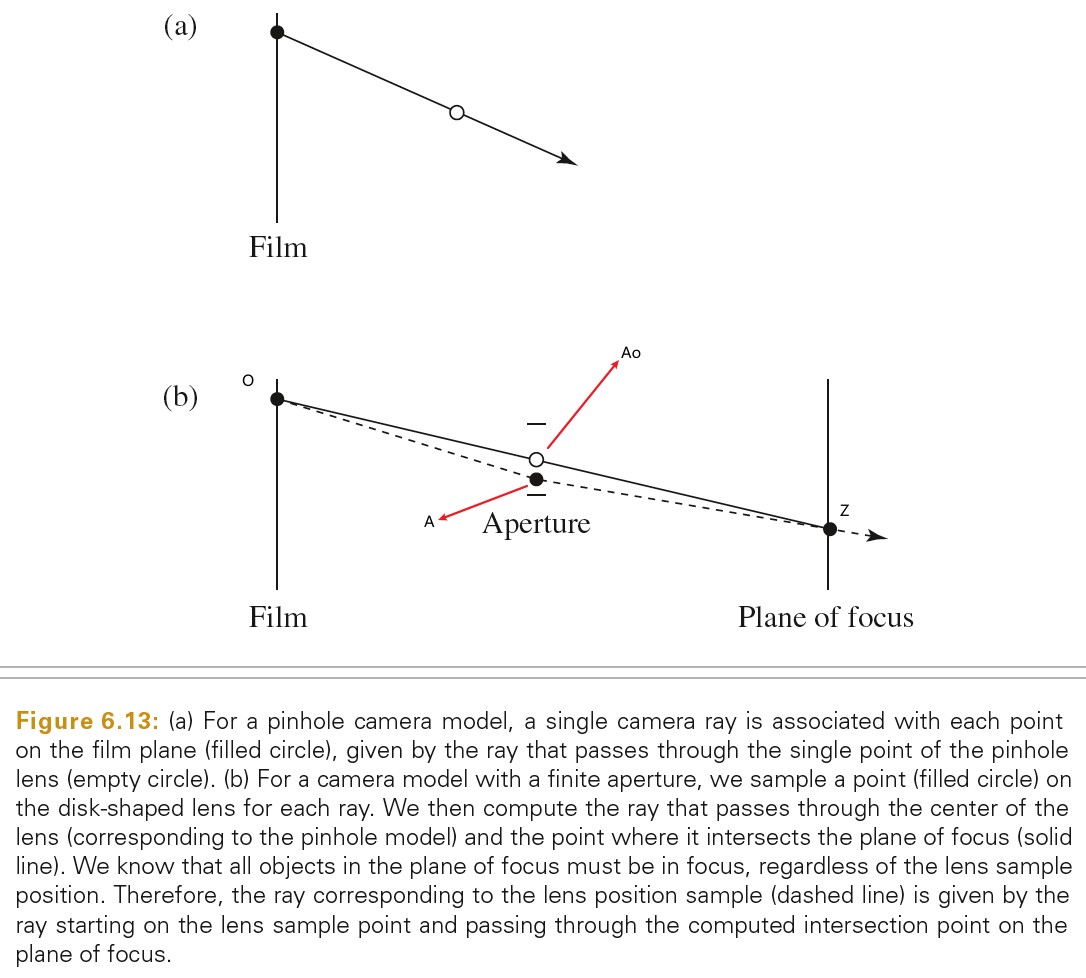

在射线追踪中模拟一个薄镜头非常简单直接。设点 O 为胶片上一点,在镜头上选一个点 A,然后计算经过镜头中心点 Ao 的射线和焦距平面的交点 Z,则 AZ 就是胶片上 O 对应的射线。如下图所示:

通常为了模拟平滑的景深需要为每个像素点追踪很多个射线。

下面代码为镜头半径大于 0 时,镜头发出射线的重新计算代码。

*ray = Ray(Point3f(0, 0, 0), Normalize(Vector3f(pCamera))); if (lensRadius > 0) { // Sample point on lens Point2f pLens = lensRadius * ConcentricSampleDisk(sample.pLens); // Compute point on plane of focus // focalDistance 为胶片到聚焦平面的距离 Float ft = focalDistance / ray->d.z; Point3f pFocus = (*ray)(ft); // (*ray)(ft) = ray.o + ft * ray.d // Update ray for effect of lens ray->o = Point3f(pLens.x, pLens.y, 0); ray->d = Normalize(pFocus - ray->o); }

Environment Camera

射线追踪比基于光栅化的渲染方法的一大优势是,其可以简单利用非寻常的图片投影。关于图片采样位置如何对应到射线的方向,我们有极大的自由度,因为射线追踪渲染算法并不依赖于场景中的直线必须要投影为图片中的直线这类属性。

环境摄像机模型就是在场景中一点(环境摄像机的位置),向所有方向追踪射线,得到一个 2D 的视图。

EnvironmentCamera 直接从 Camera 类派生,而不是从 ProjectiveCamera 类派生。因为环境投影不是线性的,其无法通过一个 4x4 的矩阵来表示。

EnvironmentCamera 使用了球坐标系来实现,如下面代码:

Float EnvironmentCamera::GenerateRay(const CameraSample &sample, Ray *ray) const { ProfilePhase prof(Prof::GenerateCameraRay); // Compute environment camera ray direction Float theta = Pi * sample.pFilm.y / film->fullResolution.y; Float phi = 2 * Pi * sample.pFilm.x / film->fullResolution.x; // 用球坐标系求射线方向 Vector3f dir(std::sin(theta) * std::cos(phi), std::cos(theta), std::sin(theta) * std::sin(phi)); *ray = Ray(Point3f(0, 0, 0), dir, Infinity, Lerp(sample.time, shutterOpen, shutterClose)); ray->medium = medium; *ray = CameraToWorld(*ray); return 1; }

下面为光栅化渲染方法中用到的环境映射:

- 详解球面环境映射 - Spherical Environment Mapping https://zhuanlan.zhihu.com/p/84494845

- 详解双抛物面环境映射 https://zhuanlan.zhihu.com/p/40784734

下面文件展示了其中原理:

./PhysicallyBasedRendering/paraboloid_env_mapping.ggb

TODO Realistic Cameras

7 Sampling and reconstruction

Sampling Theory

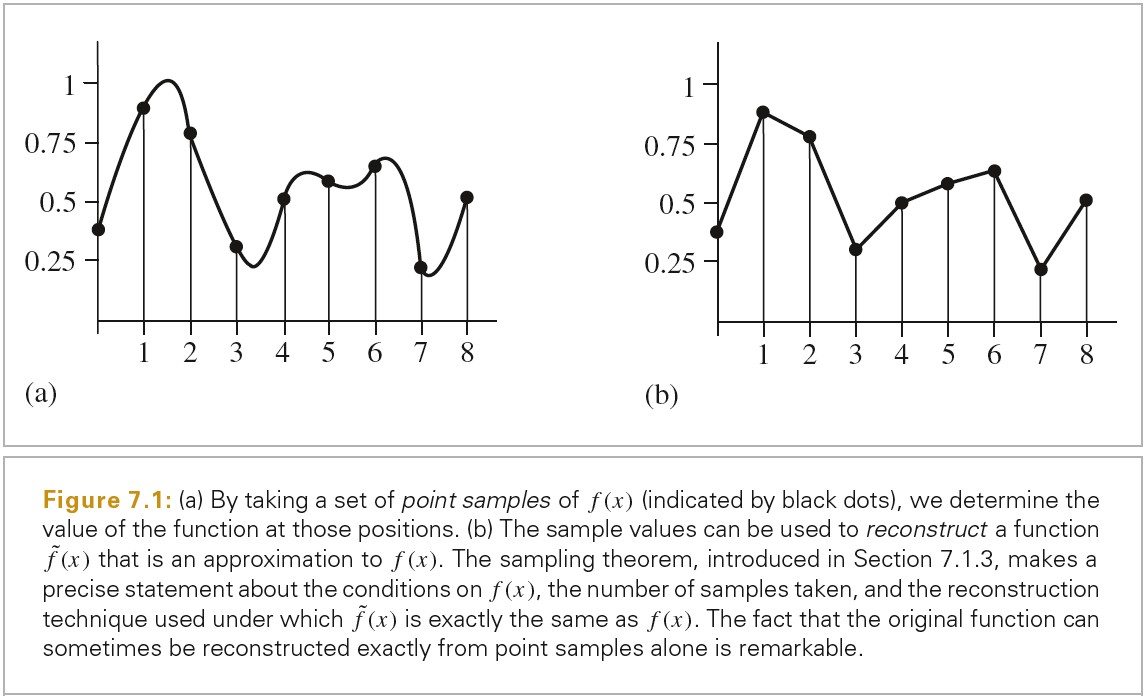

一个数字图片被表示为一组像素值,这些像素值通常排列成一个矩形格子。当数字图片被显示到物理设备上时,这些值通常用于确定显示器上像素所发出的光谱功率。区分图片像素和显示像素非常重要。图片像素表示函数在特定采样点的值。而显示像素是物理对象发出的带有某种分布的光,(在 LCD 显示器上,斜着看和正着看颜色和亮度会有很大不同)。显示器使用图片像素值来构建一个新的图片函数。这个函数定义在显示器的所有点上,而不只是数字图片的很小的像素点。取一组采样值,然后将其转化为连续函数的过程被称为重建(reconstruction)。

为了计算数字图片上离散的像素值,必须对原始的连续的图片函数做采样。在 pbrt 中,获取图片函数信息的唯一方式是通过射线追踪来对图片函数进行采样,这和其他射线追踪渲染器是一样的。

因为采样和重建过程涉及到了近似,所以会引入被称为走样(aliasing)的错误。走样有多种表现形式,其中包括锯齿边缘或者动画中的闪烁。这是因为采样过程中无法从连续定义的图片函数捕捉到所有信息。

下图展示了采样和重建的过程:

The Frequency Domain And The Fourier Transform

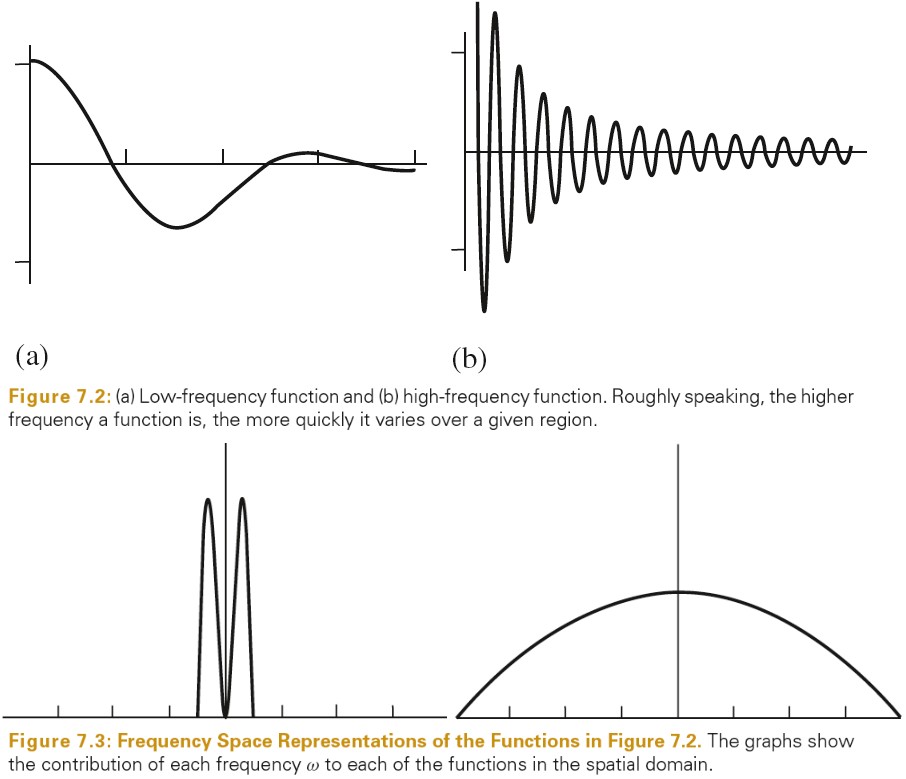

傅里叶变换是傅里叶分析的基础之一,傅里叶变换是函数在频率域上的表示(通常函数是在空间域上表示)。下图表示了两个函数在空间域和频率域上的图像。

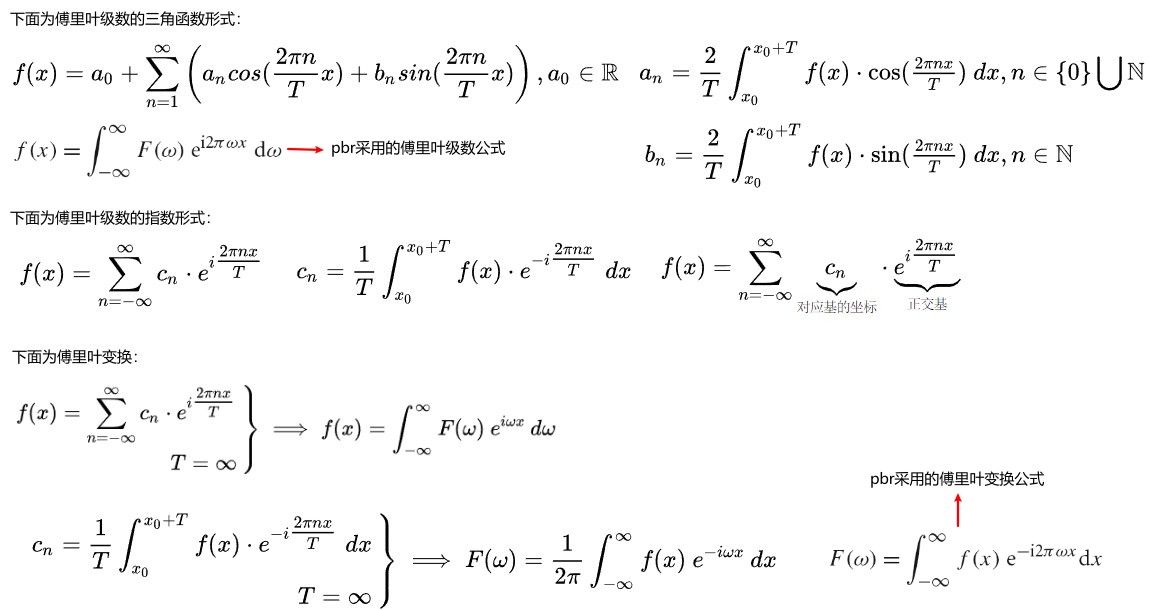

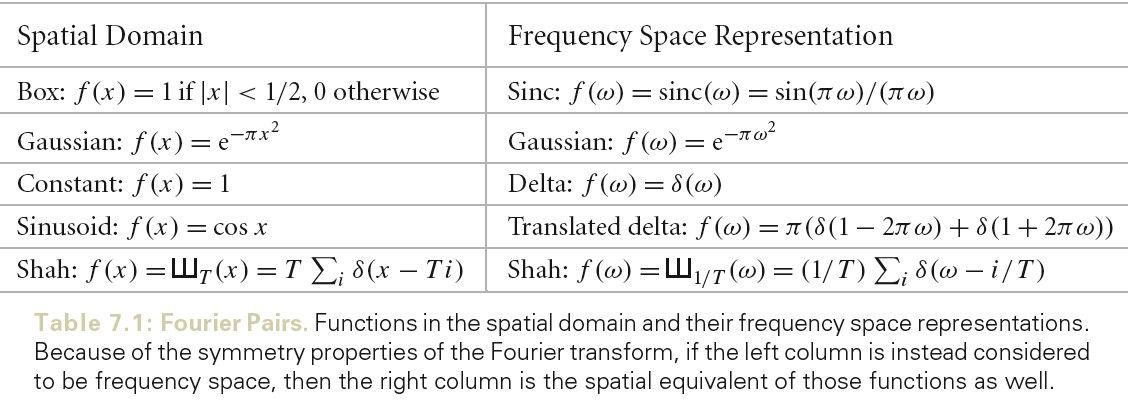

下图为傅里叶级数和傅里叶变换的公式:

大多数函数可以被分解为多个带相位的正弦函数的权重和。在频率空间表示一个函数,便于深入了解该函数的特性(正弦函数的频率分布对应了原始函数的频率分布)。使用这种形式,可以使用傅里叶分析透彻理解,采样引入的错误,以及重建(reconstruction)的过程,以及如何减少感知到的错误效果。

频率域表示和空间域表示互逆,下图为一些重要的函数,以及其在频率域的表示。

- 正弦型函数 https://baike.baidu.com/item/%E6%AD%A3%E5%BC%A6%E5%9E%8B%E5%87%BD%E6%95%B0

- 傅里叶分析之掐死教程 https://zhuanlan.zhihu.com/p/19763358

- 如何通俗地理解傅立叶变换? https://www.matongxue.com/madocs/473.html

- 如何理解傅立叶级数公式? https://www.matongxue.com/madocs/619.html

- 从傅立叶级数到傅立叶变换 https://www.matongxue.com/madocs/712.html

- 如何理解傅里叶变换公式?https://www.zhihu.com/question/19714540/answer/1119070975

- 傅里叶系列(一)傅里叶级数的推导 https://zhuanlan.zhihu.com/p/41455378

- 傅里叶系列(二)傅里叶变换的推导 https://zhuanlan.zhihu.com/p/41875010

- Explanation Fourier http://www.jezzamon.com/fourier/

- Fourier 变换的性质 https://zhuanlan.zhihu.com/p/148484210

- 如何理解离散傅里叶变换及 Z 变换 https://zhuanlan.zhihu.com/p/45114376

Ideal Sampling and Reconstruction

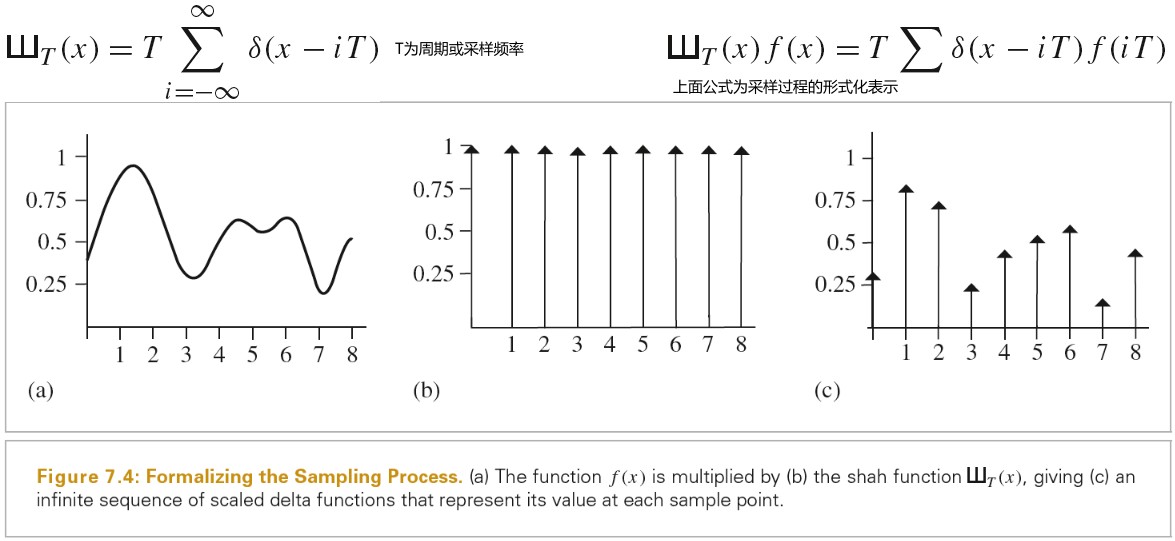

使用频率空间分析,我们可以形式化地研究采样的性质。采样过程需要我们选择一组等间距的采样位置,并且计算在这些位置上函数的值。将采样过程形式化表示就是和 shah(狄拉克梳状函数)相乘,下图为该函数定义以及对应的采样过程图示:

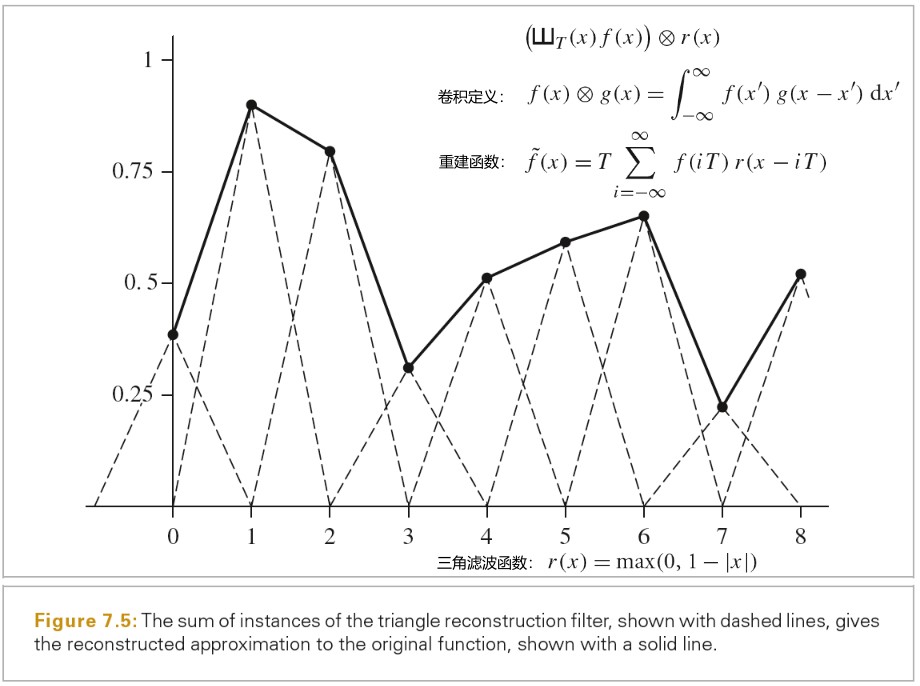

这些采样值可以用于定义一个重建函数~f(x),只需要选择一个重建过滤函数 r(x),然后和采样值进行卷积运算就可以了。为了重建,卷积对重建滤波在采样点中心的实例进行了加权求和缩放。

下图展示了重建函数的数学描述,以及三角滤波重建的一个例子:

上面讲述的获得重建函数的过程显得不必要的复杂,直观地讲,可以通过在样本之间以某种方式插值来得到重建函数。上面形式化的表述,可以方便地在重建过程中应用 Fourier analysis。

通过在频域中分析样本函数,我们可以更深入地认识采样过程。特别是,我们可以确定在怎样的条件下,可以使用样本数据精确重建原始函数。对于此处的讨论,我们假定原始函数 f(x)的带宽为有限的,也就是说存在一个频率 w0,f(x)的频率都小于 w0。带宽有限的函数,其频域表示函数为紧支撑的,也就是说,|w| > w0 时,F(w) = 0。

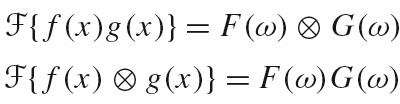

Fourier Transform 的一个重要性质是两个函数乘积的傅里叶变换为,这两个函数各自傅里叶变换后再卷积;而两个函数卷积的傅里叶变换为,这两个函数各自傅里叶变换后再相乘。通过该性质可得出,对原函数的采样,在时域空间是原函数(时域表示)和 Shah 函数的乘积,在频域空间是原函数(频域表示)和另一个 Shah 函数的卷积。周期为 T 的 Shah 函数,其频域表示(傅里叶变换)为周期为 1/T 的 Shah 函数。这说明时域空间上样本间隔越远,频域空间上样本间隔越近。

频域空间的样本表示是通过 F(w)和一个新的 shah 函数的卷积得到的,将一个函数和 delta 函数卷积得到的是该函数的一个复制,所以,将函数和 shah 函数卷积的结果为无数个原函数的复制,这些复制之间的间隔为新的 shah 函数的周期(1/T)。

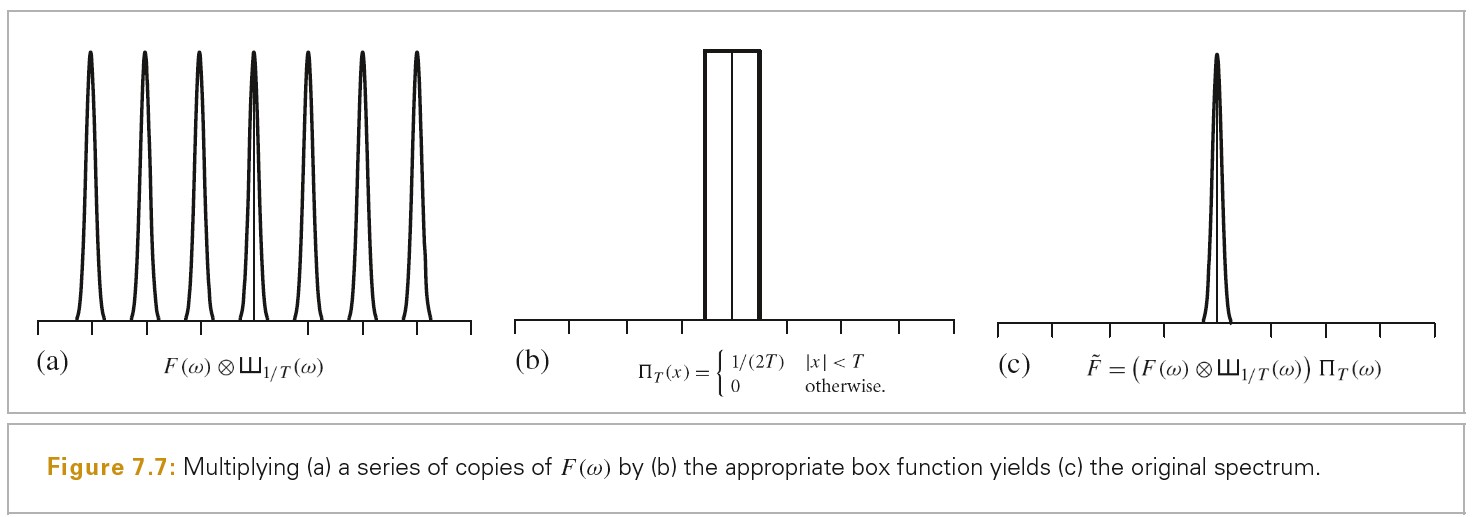

得到无穷多个原始函数分布的复制后,我们只要保留中心在原点的副本,忽略掉其他副本就可以得到原始函数了。为了达到这个目标,我们需要使用一个 box 函数。下图为该过程(重建过程)的图示:

由此可得,我们只需要对原函数进行一系列固定间隔的采样,就可以精确得到原函数在频域空间的表示,除了需要假定原函数为带宽有限的外,不需要知道其他任何信息。

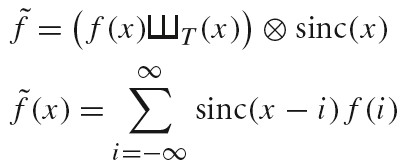

在时域空间应用相同的过程将会精确重建原函数。因为 Box 函数的傅里叶逆变换为 sinc 函数,所以时域空间中理想的重建函数为:

不幸的是,sinc 函数定义域是[-Infinity, Infinity],必须使用所有的样本值 f(i)才能计算出时域空间特定的~f(x)值。实践中,通常选择有限边界的滤波函数,尽管这会导致无法精确重建原始函数。

在图形学中,通常使用 Box 函数作为滤波函数,其可以有效地在 x 附近的区域对所有样本值进行平均。从 Box 滤波函数在频率域的行为就可以看出,这是一个非常差的选择,这种技术试图通过乘一个 sinc 函数来隔离函数分布的中心副本,这不仅对于选择中心副本来说效果很差,而且还包含了其他无限多个副本的高频部分。

- 如何通俗易懂地解释卷积? https://www.zhihu.com/question/22298352

- 图示卷积 https://www.desmos.com/calculator/ea96vohtuq

- 图示卷积 ./PhysicallyBasedRendering/2020_06_21_convolution.ggb

- 图示卷积 https://www.geogebra.org/m/KMrAFBxN

- 卷积神经网络的卷积核 和 数学中的卷积 https://www.zhihu.com/question/52237725

- 《傅里叶光学(九)》 信号采样与重建 https://zhuanlan.zhihu.com/p/72079283

- 麻省理工学院公开课:信号与系统:模拟与数字信号处理 https://open.163.com/newview/movie/courseintro?newurl=%2Fspecial%2Fopencourse%2Fsignals.html

- 实变函数中的支撑(support)是什么意思? https://www.zhihu.com/question/329984717

Aliasing

除了 sinc 函数无限边界的问题外,理想采样和重建方式的另一个严重的问题是假定信号的带宽是有限的。对于那些带宽无限的信号,或者相对信号自身的频率来说采样率不足够高的信号,前面描述的重建过程会得到一个和原函数不同的函数。

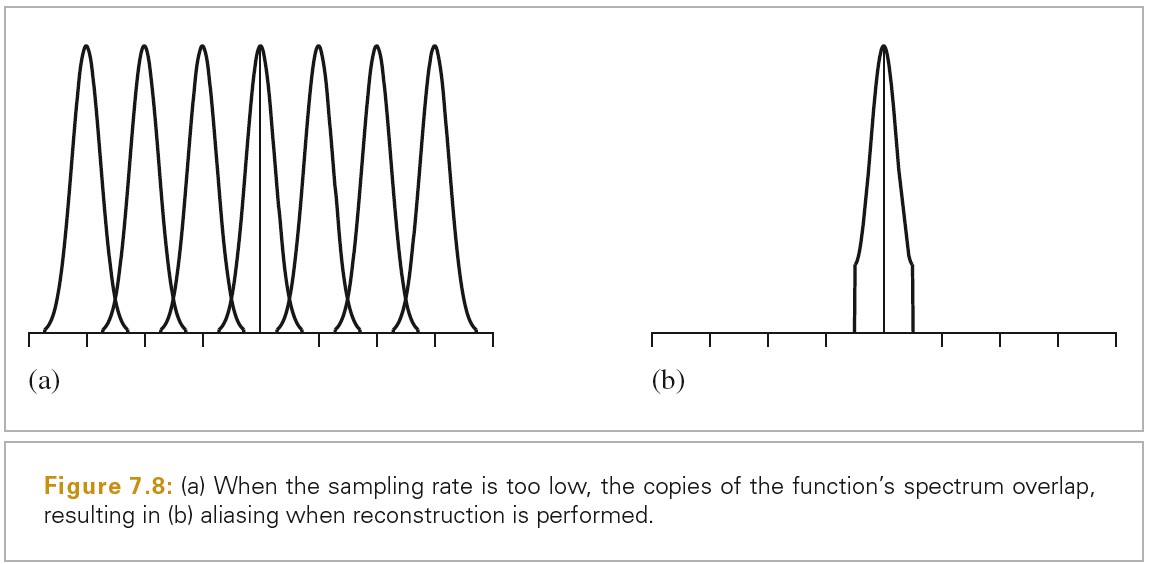

成功重建的关键是,将采样分布乘一个适当宽度的 Box 函数。信号的副本分布是由空格分割的,所以完美的重建是有可能的。如果对原函数的采样使用比较低的频率。这意味着时域空间中样本之间的间隔增大,频域空间中样本之间的间隔缩小,也就是 F(w)的副本之间靠的更近。如果这些副本靠的太近,他们就会重叠。下图展示了采样率太低的情况:

因为这些副本会叠加在一起,最终的分布将看起来就不像是原始函数的多个副本了。当新的分布被乘一个 box 函数,得到的分布看起来像,但不再等于原始 F(w):原始信号的高频细节漏到了重建信号分布的低频区域了。这些新的低频 artifacts 被称为 aliases(走样)(因为高频伪装成了低频),并且结果信号被称为 aliased(走样了)。下图展示了这种走样现象:

解决频谱重叠问题的一个可行方案是简单增加采样率,直到频谱的副本分开足够远而没有重叠,这样就消除了走样。采样理论可以精确告诉我们需要多大的采样率。理论表示,当采样率大于两倍的信号最大频率,就可以完美重建原始信号。这个最小的采样率被称为 Nyquist freqqency.

对于带宽无限的信号,无法通过足够高的采样率来重建。没有带宽限制的信号其频谱是无限的,所以无论如何分离这些副本,他们都始终叠在一起。不幸的是,图形学中只有少数几个有趣的函数带宽是有限的。特别是,任何不连续的函数都不是带宽有限的,因此,我们无法完美地采样和重建它们。这是有道理的,因为不连续的函数不连续的地方总是落在两个样本之间,而样本无法提供不连续的信息。因此,需要应用不同的方法来抵消这种错误。

Antialiasing Techniques

如果不小心地采样和重建,大量的 artifacts 将在最终的图片上出现。有时候区分采样和重建导致的 artifacts 很有用,当我们希望精确区分的时候,我们称采样导致的 artifacts 为 prealiasing,而重建导致的 artifacts 为 postaliasing。任何尝试纠正这些错误的方法被统称为 antialiasing.

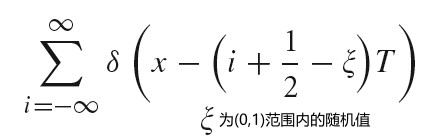

- Nonuniform Sampling

尽管我们采样的图片函数有无限多频率分量,无法从样本完美地重建,但是可以通过以非统一的方式改变样本间距来减少可视的 aliasing 影响。其形式化表示如下:

对于固定的采样率来说,无论是统一还是非统一采样都会得到错误的重建信号。但是,非统一采样会将规律的 aliasing artifacts 变为噪声,其会减低人类视觉系统的分散。在频域空间,样本信号的副本会随机地平移,因此重建的结果表现为随机错误而不是增强的 aliasing。

- Adaptive Sampling

另一种被推荐的减少 aliasing 的方式是 adaptive supersampling(自适应超采样):如果我们可以识别频率高于 Nyquist 限制的区域,我们可以在这些区域增加采样而不需要在所有地方都增加采样频率。在实践中,很难采用这种方式,因为找到所有需要超采样的区域很难。大多数这样做的技术都是基于检验邻接的采样值,然后找到有明显变化的地方,假设信号在这个区域有很高的频率。

一般来说,邻接样本值无法告诉我们样本之间确切是什么:即使邻接的样本值相同,函数可能在它们之间有巨大变化。另外,邻接样本值可能有明显的不同,却没有任何 aliasing 存在。

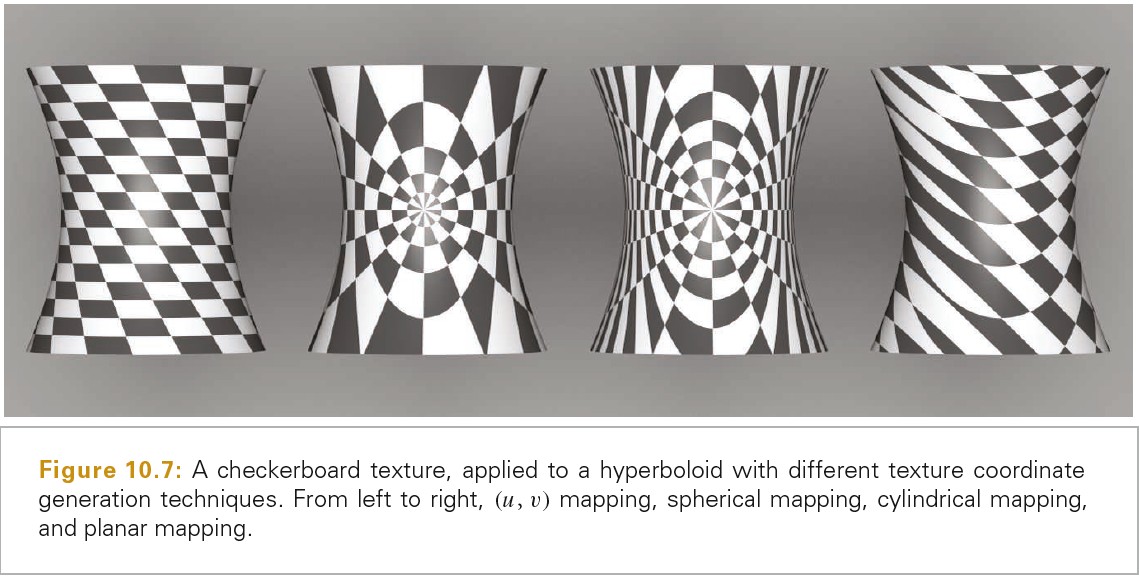

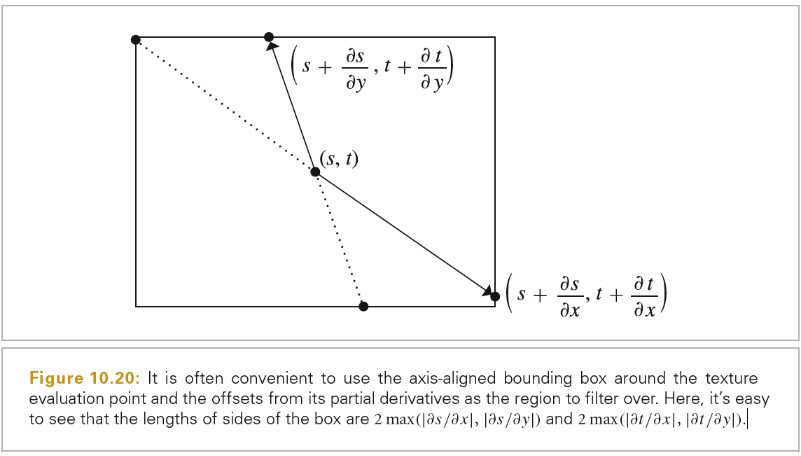

- Prefiltering

另一种采样理论提供的消除 aliasing 的方法为 Filter 原始函数,这样就没有高频存在了,这些高频是以当前采样率采样时无法被精确捕捉的。在第 10 章的贴图函数使用了这种方式。尽管这种技术改变了被采样函数的特点,其从原函数中移除了一部分信息,但是 blurring 通常要比 aliasing 好一些。

我们可以将原始函数的频谱乘一个 Box 滤波函数,该 Box 滤波函数的宽度大于 Nyquist 限制。在时域中,对应着将原始函数和 sinc 滤波函数求卷积,f(x)。

在实践中,我们可以使用一个有限范围的滤波函数。该滤波函数的频率域表示有助于阐明其是如何近似理想的 sinc 滤波函数的。

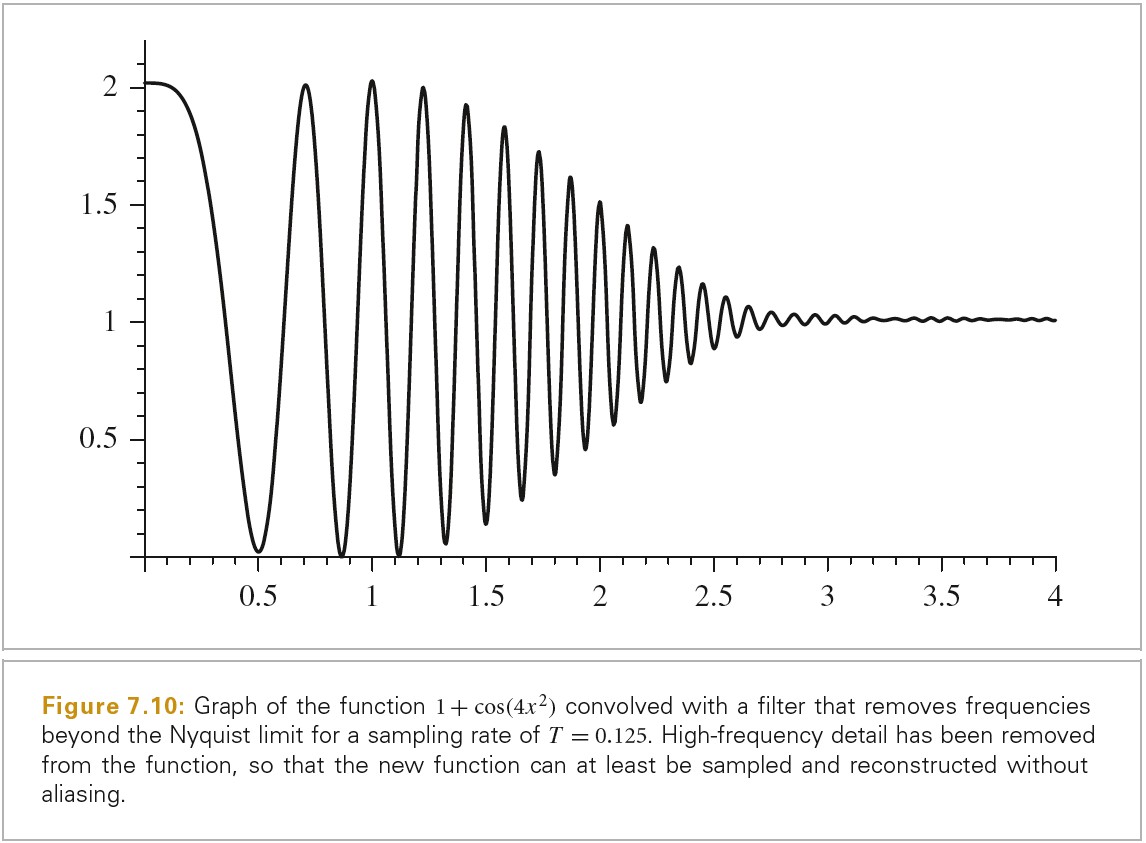

下图就是一个实例:

Application To Image Synthesis

运用这些理论于 2D 情况下采样和重建渲染场景的图片是非常直接的。我们可以把图片当作 2D 图片位置到辐射率值 L 的函数。

好消息是,使用我们的射线追踪,我们可以计算该函数在任意一点的值。坏消息是,无法在采样之前预过滤 f 函数来移除高频部分。因此,本章的采样器会使用 Nonuniform Sampling 和 Adaptive Sampling 策略。

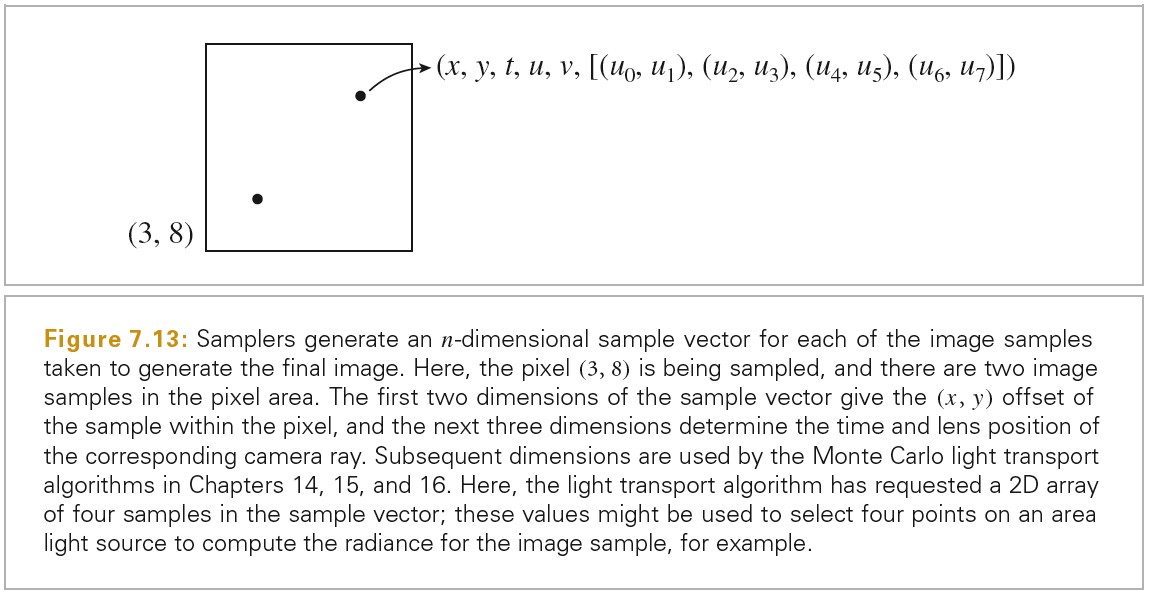

将场景函数的定义一般化为更高维度的函数是非常有用的,让其也依赖时间 t 以及其采样的镜头的位置(u,v)。因为所有的从摄像机发射的射线都基于 5 个量,改变其中任意一个都会得到不同的射线,也就可能得到不同的值。对于特定的图片位置,该点的辐射率值通常会随时间而变换(场景中有运动的物体),也会随镜头位置而变化(如果摄像机包含一个带有限光圈的镜头)。

更一般地,因为 14 到 16 章的很多积分器使用了统计技术来估算沿着给定射线的辐射量,当重复给定同一个射线时,他们可能返回一个不同的辐射率值。如果我们将来扩展了场景辐射率函数来包含积分器使用的样本值(例如,在区域光源上选择点来计算照明)我们将需要一个更高维的函数。

高效采样所有这些维度是生成高质量图片重要的一部分。

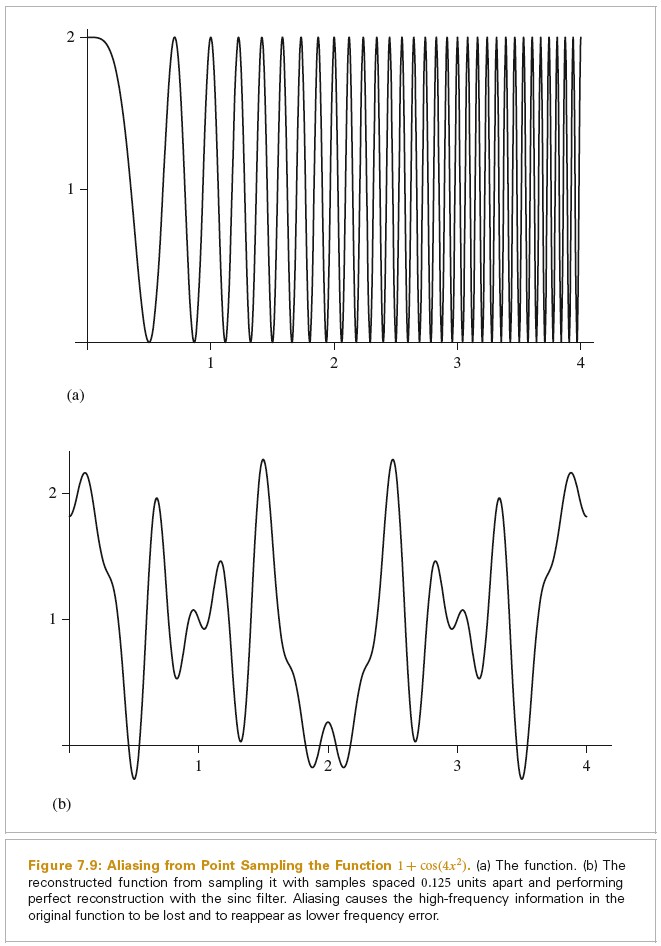

Sources of Aliasing in Rendering

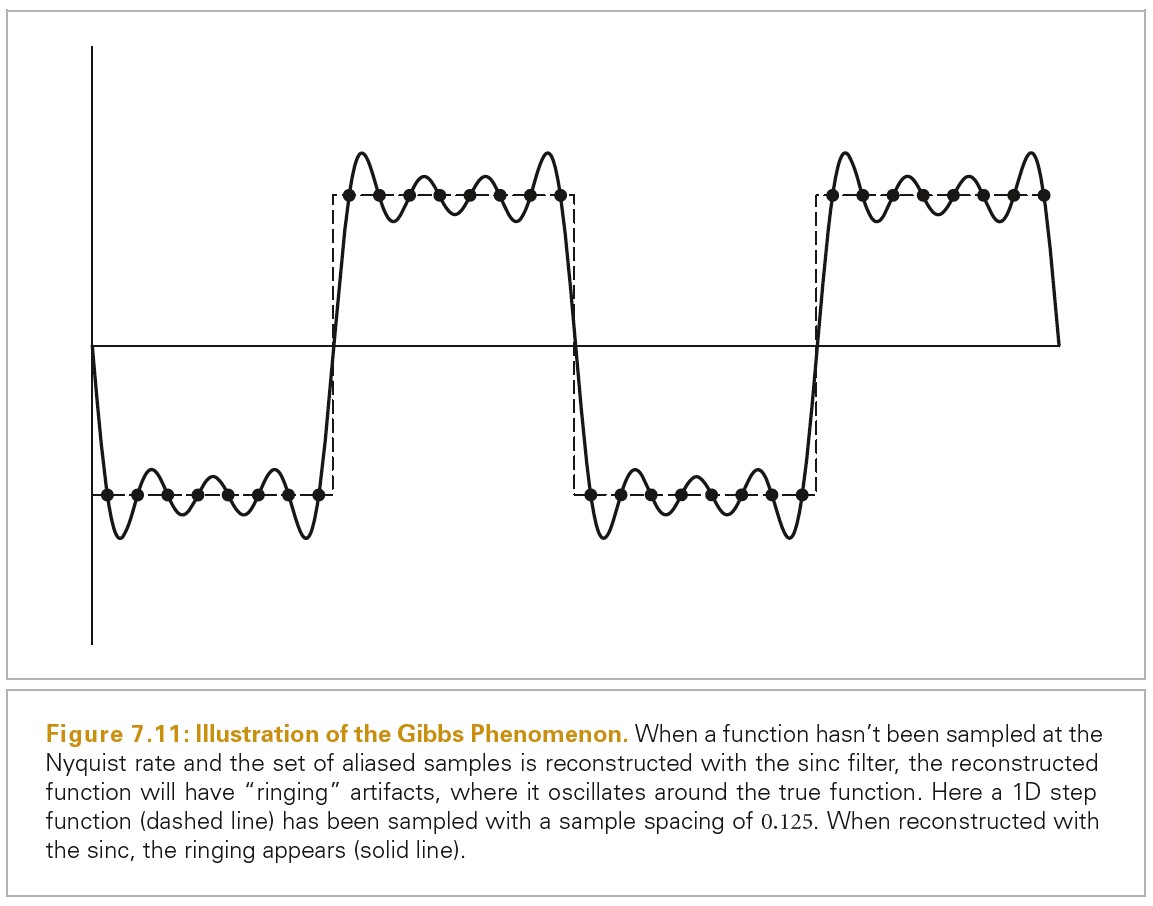

几何体是渲染图片中最常见的导致 aliasing 的原因。当投影到图片平面时,对象的边缘引入了一个阶跃函数(图片函数突然从一个值跳跃为另一个值)。阶跃函数不仅有无限频率内容,而且完美重建滤波函数应用于走样的样本时会导致 artifacts:ringing artifacts 在重建函数中出现,这种效果被称为 Gibbs phenomenon(吉布斯现象)。面对 aliasing 时,选择一个有效的重建滤波函数需要结合科学、艺术以及个人品味。下图展示了吉布斯现象:

场景中非常小的物体也会导致几何 aliasing。如果几何体足够小其落在了样本之间,其会出乎意料的消失,在过一个动画过几帧后又会出来。

另一个 aliasing 的来源为物体的贴图和材质。没有被正确过滤的贴图映射或者闪耀表面上小的亮点都可能导致渲染的 aliasing。如果采样率没有足够高,无法足够采样这些特性,结果就会 aliasing。物体投射的尖锐的阴影会引入另一种阶跃函数。尽管可以通过几何边缘在图片平面上确定阶跃函数的位置,从阴影边界来检测阶跃函数是非常难的。

我们无法去掉所有导致 aliasing 的源由,所以我们必须发展技术缓和其在最终图片上的影响。

Understanding Pixels

在本章剩余部分,需要铭记两个关于像素的观念。

第一个:组成图片的像素是图片函数的很多点的样本,这些点样本在图片平面上为离散的点。注意一个像素关联的不是区域,将像素当作小的正方形区域是错误的模型,会导致一系列错误。

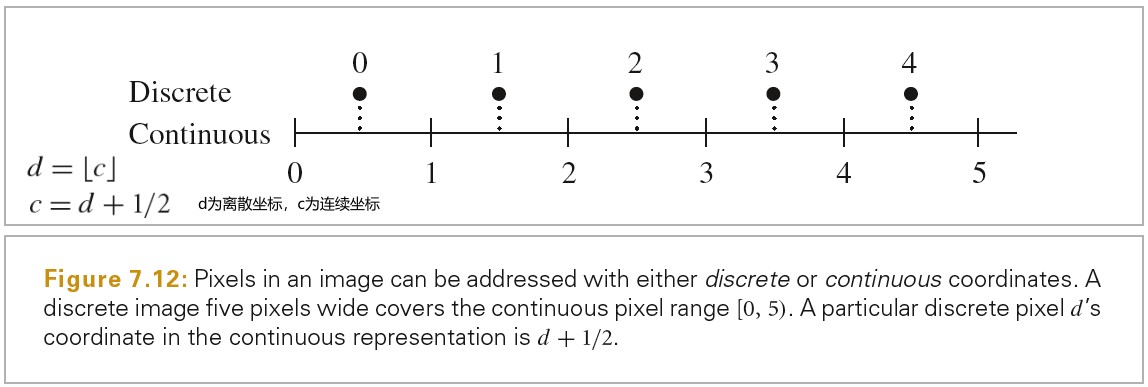

第二个:最终图片上的像素被定义在像素网格上的离散整数坐标(x,y)上,但是本章的 Sampler 生成的图片样本在连续的浮点坐标(x,y)上。一种自然的在这两种不同的域上映射的方式是将连续的浮点坐标舍入为最近的离散坐标。这种方式很有吸引力,因为其会将刚好等于离散坐标值的连续的坐标映射为离散坐标。然而,结果是给定一组间隔为[x0,x1]的离散坐标,一组覆盖这个范围的连续的坐标的范围为[x0-1/2,x1+1/2).这样,为一个给定离散像素范围生成的连续样本坐标有 1/2 的偏移。

按照下面方式转化离散坐标和连续坐标,离散的范围[x0,x1]会被转化为连续的范围[x0,x1+1),这样更自然,并且使得代码更简单:

Sampling Interface

Sampler 类的任务是生成一个 n 维样本的序列,每个样本向量属于一个图片样本,每个样本向量的维度随光照传播算法不同而会有变化。下图展示了 Sampler 为图片样本生成的采样向量:

Evaluating Sample Patterns:Discrepancy

里叶分析给我们提供了评价采样模式质量的方法,但是其只能让我们可以量化在带宽有限的情况下均匀增加更多采样所带来的改进。给定带宽无限(图片中物体边缘的地方)以及大于 2 维采样向量(Monte Carlo 光照传播算法)的情况,只使用傅里叶分析是不够的。

给定一个渲染器和一个候选的放置样本的算法,一种验证该算法有效性的方法是使用其采样模式渲染一张图片,然后比较该图片和另一张使用了更多数量样本渲染得到的图片。我们将使用这种方式来比较采样算法。

傅里叶分析之外,数学家发明了一种被称为 Discrepancy(差异)的概念,其可用于评估一个 n 维采样模式的质量。分布比较好的模式其具备低差异值。

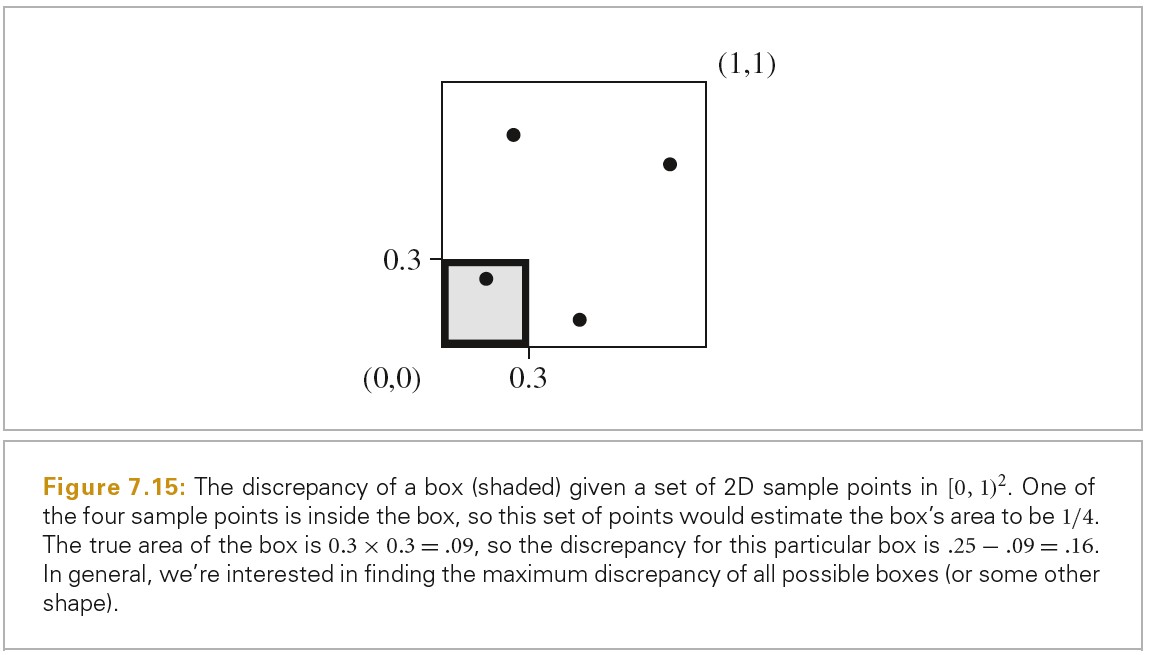

差异的基础理念为,可以通过下面方法来评估一组在 n 维空间[0,1)^n 上的样本点的质量,计算每个区域中样本点的数量,比较每个区域的体积和其中的样本点数量。下图在二维空间展示了这种理念:

Discrepancy 的数学定义如下。关于 Discrepancy,Star Discrepancy,以及均匀分布的一维样本模式的 Star Discrepancy 请参考 知乎-PBRT-E7.2-采样接口 https://zhuanlan.zhihu.com/p/73943687 文章的描述。

只使用差异来衡量采样模式,并不是一个很好的标准。一些低差异的采样模式展现出样本的聚集。7.7 节中的 Sobol 采样就有该问题。直观地看,靠的太近的样本就是没有充分利用样本资源:一个样本越靠近另一个,那么该样本就越可能没有提供新的信息。因此计算任意两个样本的最小距离也是一个有用的衡量标准,距离越大采样模式的质量越好。

有很多算法可以生成 Poisson Disk 采样模式,按照样本点距离的标准,这种模式评分很高。人眼的视杆细胞和视锥细胞就是按这种模式分布的,这进一步说明这种方法对于成像来说是一个好的模式。实践中发现 Poisson disk 模式对于 2D 图片来说非常好,但是对于高维采样来说,low discrepancy 模式要更有效。

- 低差异序列(一)- 常见序列的定义及性质 https://zhuanlan.zhihu.com/p/20197323

- Star Discrepancy https://mathworld.wolfram.com/StarDiscrepancy.html

- PBRT-E7.2-采样接口 https://zhuanlan.zhihu.com/p/73943687

Basic Sampler Interface and Implement

Sampler 的实现存储了一系列当前样本的状态,例如:哪个像素被采样,样本向量的维度,等等。因此单个 Sampler 对象被多个线程并行使用时,自然会不安全。Sampler 类实现了 Clone 函数,每个线程都会克隆初始化的 Sampler 对象,每个 Sampler 对象都携带一个随机种子,这样不同的线程就会得到不同的随机数序列。在多个 image tiles 之间重用相同的随机数序列会导致 image artifacts。

Sampler 实现同时处理了获取样本向量各个分量的请求,其为这些值的存储申请空间。

std::vector<int> samples1DArraySizes; 存储请求的样本数组的大小。

std::vector<int> samples2DArraySizes;

std::vector<vector<Float>> sampleArray1D; 存储整个像素的样本数组。

std::vector<vector<Point2f>> sampleArray2D;

size_t array1DOffset; 记录下一个样本对应的样本向量数组的偏移。

size_t array2DOffset;

Request1DArray(int n); n 为请求访问的样本数量

Request2DArray(int n);

Get1DArray(int n); 获取当前样本对应的各个维度数据(样本向量)。

Get2DArray(int n);

- Pixel Sampler

尽管一些采样算法可以很容易地递增生成每个样本向量的各个维度的值,大多数都是一次性生成一个像素的所有样本的所有维度值。PixelSampler 实现了一些基础的方法用于实现这类采样器。

// PixelSampler中样本数据的存储为 sampler1D[dimension][pixelSampleIndex],这样存储可以让所有样本的指定分量在内存中排列在一起,这对于生成样本数据的代码更方便。 PixelSampler::PixelSampler(int64_t samplesPerPixel, int nSampledDimensions) : Sampler(samplesPerPixel) { for (int i = 0; i < nSampledDimensions; ++i) { samples1D.push_back(std::vector<Float>(samplesPerPixel)); samples2D.push_back(std::vector<Point2f>(samplesPerPixel)); } } // 注意:sampler1D和sampler2D公用curPixelSampleIndex Get1D(); // 返回 sampler1D[cur1DDimension++][curPixelSampleIndex++] Get2D(); // 返回 sampler2D[cur2DDimension++][curPixelSampleIndex++]

- Global Sampler

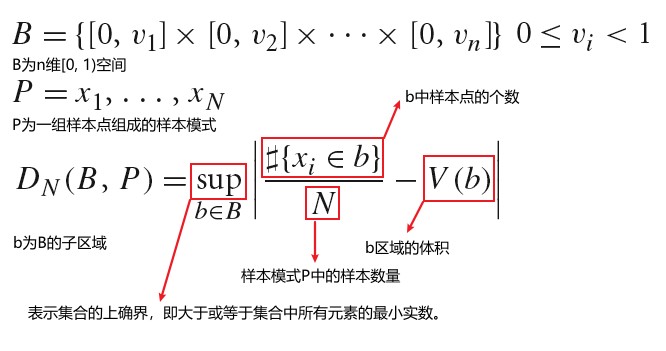

一些生成样本的算法完全不是基于像素的,而是很自然地生成分布在整个图片上的连续的样本,其会连续访问完全不同的像素(这类采样器可以高效地放置每个额外的样本,以填充 n 维样本空间中的漏洞,这自然会导致连续生成的样本分布在不同的像素中)。这些采样算法对于当前的 Sampler 接口来说是种麻烦。例如,一个采样器生成了一系列如下表所示的样本值,这些值为样本向量的前两个维度。这些样本值的每个维度都被乘以图片分辨率从而得到图片平面的样本位置(为了简化此处假设图片的分辨率为 2x3)。注意此处的采样器(HaltonSampler),一个像素的所有样本之间间隔 6 个样本。如果我们渲染图片时,每个像素使用三个样本,为了生成像素(0,0)的所有的样本,我们需要生成索引为 0,6 以及 12 的样本。

我们之前定义的 Sampler 接口,其指定了渲染像素所对应的样本,而不是反过来由样本得到被渲染的像素。但是适配当前的设计是有理由的:这种方式易于将胶片分解为多个小的 image tile,从而用于多线程渲染,这样每个线程在局部区域计算的像素可以被有效地合并到最终的图片中。因此,我们需要这些采样器生成的样本是无序的,这样对于单个像素的所有样本又是连续的。

GetIndexForSample(sampleNum) 执行从当前像素和给定样本索引到全局索引的映射。例如,上图中如果 currentPixel 为(0,2),则 GetIndexForSample(0)将返回 2,因为索引为 2 的样本为(0,2)像素区域内的第一个样本。

SampleDimmension(index, dimension) 返回指定索引指定维度的样本值。注意前两个维度为偏移量,他们会被特殊处理。例如,上图中 SampleDimension(4,1) 将返回 0.333333,因为索引为 4 的样本对应的像素区域为(0,1),所以第二维的采样值为 1.333333-1 = 0.333333

非常有必要确定采样向量的哪些维度用于数组采样。前面的维度要比后面的维度有更好的质量,因此将开始的一些维度为 CameraSample 留出来很重要,因为这些样本值对最终的图片质量有重要影响。因此,从开始的维度到 arrayStartDim 用于常规的 1D 和 2D 样本值,后续的维度先被用于 1D 数组样本值,紧接着的维度用于 2D 数组样本值。最后,更高维度从 arrayEndDim 开始。

Stratified Sampling

StratifiedSampler 的关键理念是将采样区域划分为不重叠的区域,并且为每个区域取一个样本,这样我们就尽可能避免了遗漏图片的整个特征,因为保证了样本之间距离不会太近。分层越小,层数越多,采样率越高。

StratifiedSampler 在每个 stratum 内选随机的位置来放置样本,该位置围绕 stratum 中心点,以 stratum 的宽高的一半为最大值进行随机。这种非一致性可以将 aliasing 转化为噪声。采样器也提供了非随机模式,其提供了一致的采样。

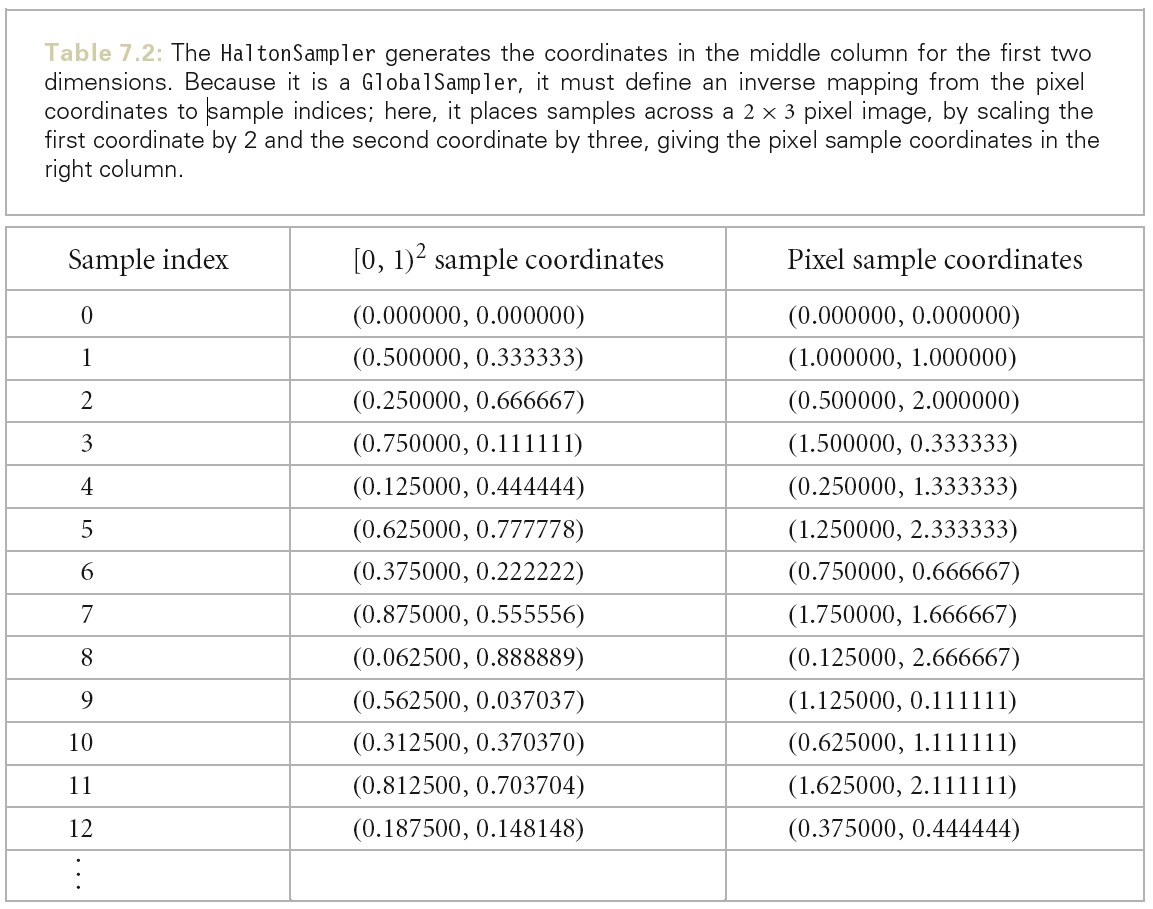

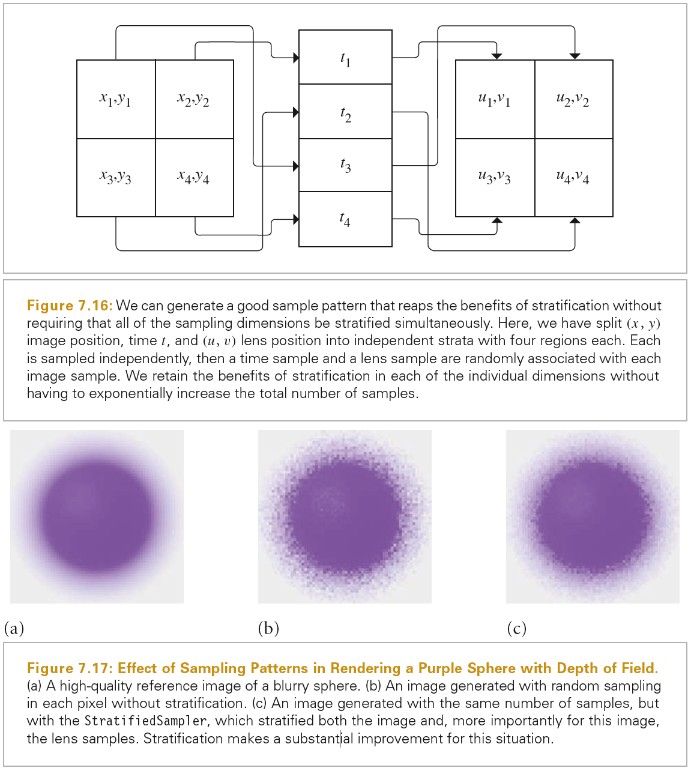

直接将分层应用于高维采样会很快导致巨量的样本数量。例如,如果将 5D 图片(x,y,t,u,v),lens,以及样本时间间隔在每个维度划分为 4 层,最终每个像素需要的样本数量为 4^5=1024。我们可以减少某些维度样本数量来减低这种影响,但是这会让我们丢掉分层带来的好处。我们可以获取到分层的大部分好处,而不需要大量的样本。我们只需要为域维度的子集计算低维的分层模式,然后随机地将子集的样本关联在一起。下图展示了这种方法的基础理念:我们可能只想为每个像素取 4 个样本,但是依然使得这些样本在整个维度上都是被分层的。我们独立地生成 4 个 2 维的分层图片样本,4个 1 维的分层时间样本,以及 4 个 2 维的镜头样本。然后,我们随机地选一个图片样本一个时间样本一个镜头样本,将他们关联起来得到像素的一个样本向量,这样得到的样本向量整体上对样本空间有好的覆盖。

调用者可能会请求请求任意数量的图片样本,此时分层可能无法很容易被使用(例如,我们如何生成拥有 7 个样本的 2D 分层模式)。我们可以只是生成 nx1 或 1xn 的分层模式,但是这样只会在一个维度上得到分层的好处,其他维度无法保证也是好的模式。StratifiedSampler::RandSize()可以将请求的样本值数量舍入为一个整数的平方。

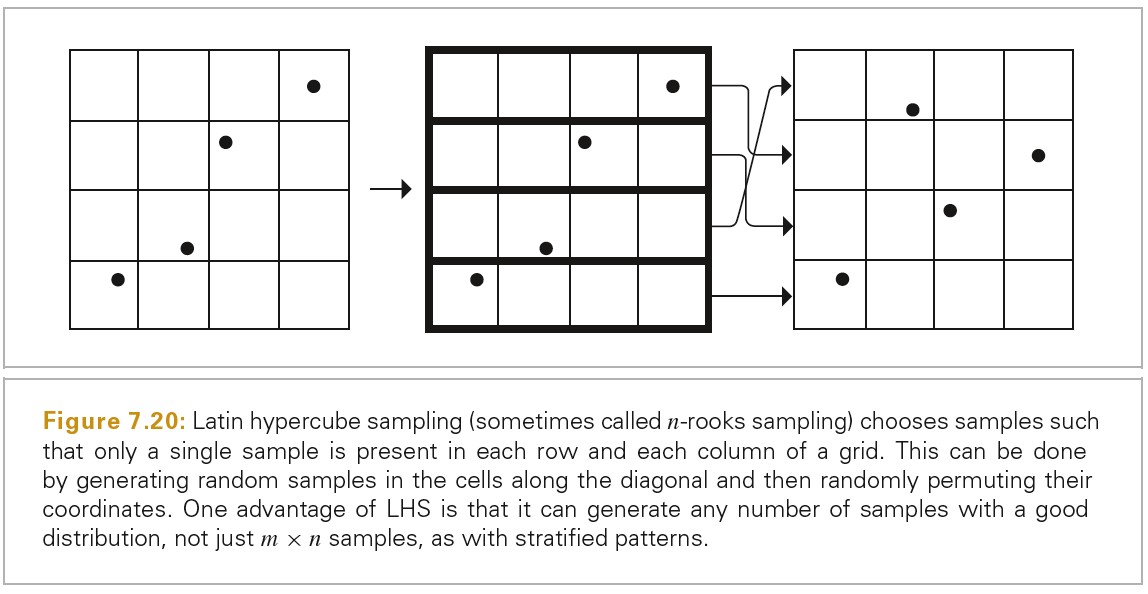

另外一种可以生成任意数量样本,任意数量维度的方法为 Latinhypercube sampling(LHS).LHS 统一地将每个维度的轴分为 n 个区域,并且在每个区域沿着对角线生成一个 jitterred sample,然后,这些样本值在每个维度进行随机洗牌,这样就可以创建一个好的分布。LHS 的一个优点是将样本投影到任意维度的轴上时,减少了样本的聚集。下图展示了 LHS 的原理。除了解决样本聚集的问题,LHS 并不是对 StratifiedSampling 的优化。在实践中,随着 n 的增加,LHS 的采样模式要比 StratifiedSampling 的采样模式更差。

The Halton Sampler

HaltonSampler 生成的点不仅可以保证不会聚集的太近,而且在采样向量的整个维度上都分布很好。

Hammersley and Halton Sequences

Halton 和 Hammersley 序列是两种紧密相关的低差异点集。它们都基于一种被称为 radical inverse 的构造方法。这种方法的基础是任何一个正整数都可以被表示为 b 进制的数字序列。

Halton 和 Hammersley 的定义可以参考原书。

inline uint32_t ReverseBits32(uint32_t n) { n = (n << 16) | (n >> 16); n = ((n & 0x00ff00ff) << 8) | ((n & 0xff00ff00) >> 8); n = ((n & 0x0f0f0f0f) << 4) | ((n & 0xf0f0f0f0) >> 4); n = ((n & 0x33333333) << 2) | ((n & 0xcccccccc) >> 2); n = ((n & 0x55555555) << 1) | ((n & 0xaaaaaaaa) >> 1); return n; } inline uint64_t ReverseBits64(uint64_t n) { uint64_t n0 = ReverseBits32((uint32_t)n); uint64_t n1 = ReverseBits32((uint32_t)(n >> 32)); return (n0 << 32) | n1; }

Hammersley 和 Halton 序列有一个缺点,就是随着基数 b 的增加,样本值会展现出极其规律的模式。这个问题可以通过扰乱(scrambled)Halton 和 Hammersley 序列来解决,在计算基数取反时对数字进行一次排列。

- 低差异序列(一)- 常见序列的定义及性质 https://zhuanlan.zhihu.com/p/20197323

TODO HaltonSampler Implement

TODO (0,2)-Sequence Sampler

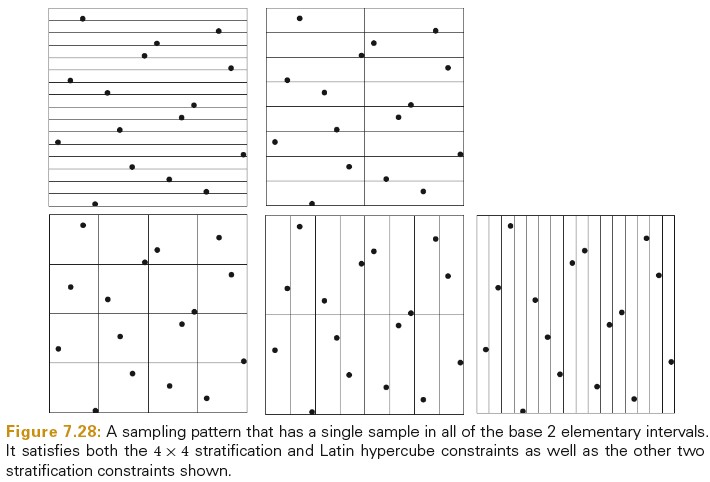

(0, 2)-sequences 以一种非常一般的方式进行分层。例如,开始的 16 个样本满足 StratifiedSampling 约束,这意味着在每一个(1/4, 1/4)方格内只有一个样本。而且,也符合 Latin hypercube 约束,因为只有(1/16,1)和(1,1/16)在边界上。下图展示了将空间分割为区域的所有可能情况,每种情况的(0,2)-sequence 都满足分层的属性。16 个样本的每个连续的序列也满足这些分布属性。

(0,2)-Sequence 的定义

TODO Maximized Minimal Distance Sampler

TODO Sobol Sampler

Image Reconstruction

给定仔细选取的图片样本,我们需要将样本和基于样本计算的辐射率值转化为像素值用于显示或者存储。依据信号处理理论,我们需要做三件事情来计算输出图片上每个像素对应的最终的值:

- 依据一组图片样本重建一个连续的图片函数 ~L

- 预过滤 ~L 函数,将超过 Nyquist 限制的频率移除

- 在像素位置对 ~L 函数进行采样,计算该位置像素最终的像素值。

由于我们只会在像素位置对 ~L 函数进行重新采样,因此无需构造函数的显式表示。我们可以使用单个滤波器函数将前两个步骤组合起来。

如果原始函数以高于 Nyquist 频率的频率进行均匀采样并使用 sinc 滤波器重建,则第一步的重建函数将完美匹配原始图像函数。但是由于图像函数几乎总是会包含比采样率所能表示的更高频率(由于边缘等的存在),我们选择非均匀采样,用噪音换取 aliasing。

采样理论的最近研究显示完美重建在实践上基本上是无法达到的。重建理论的研究目标已经从完美重建转为开发可以最小化错误的重建技术。

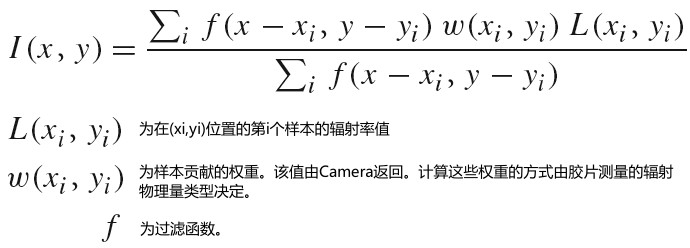

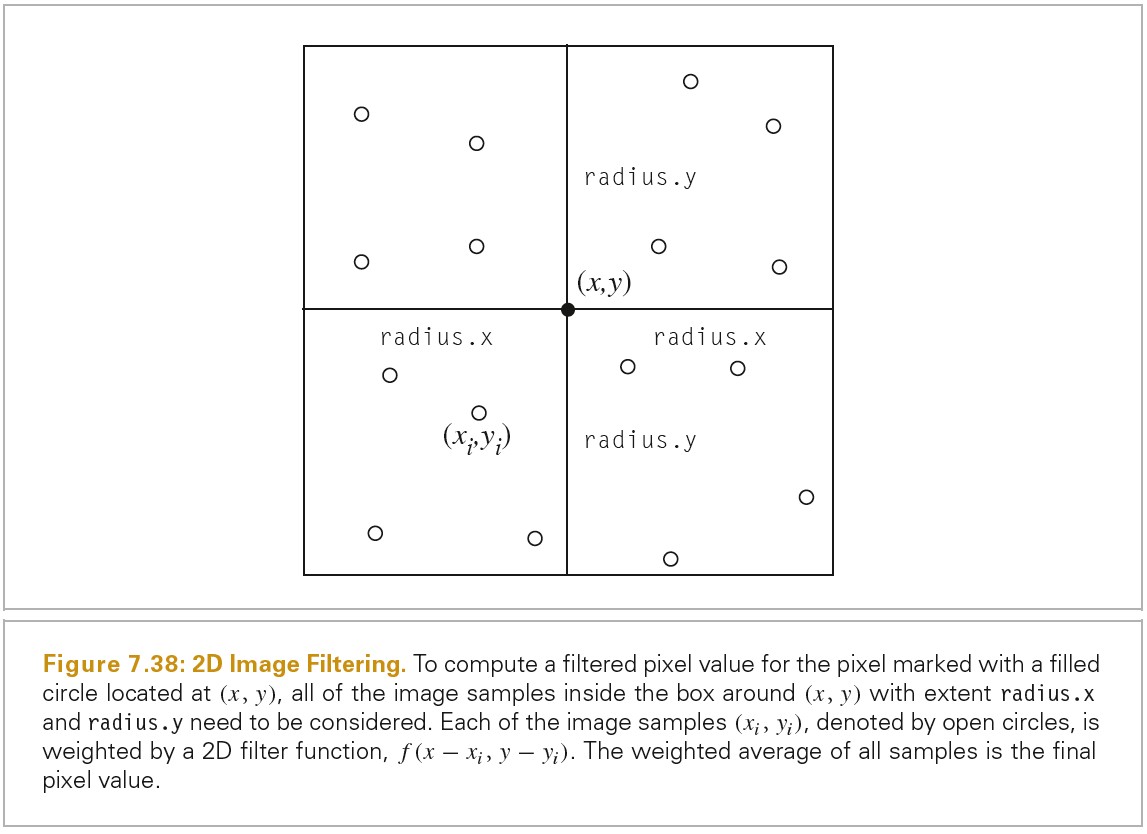

pbrt 中使用的重建技术没有直接使用最新的方式。为了重建像素值,我们需要考虑插值特定像素附近样本的问题。可以通过如下公式计算像素 I(x,y)最终的值:

下图展示了一个位于(x,y)处的像素,其对应的像素过滤器在 x 方向上的范围为 radius.x,在 y 方向上的范围为 radius.y.在这个过滤器 Box 内的所有样本都可能对像素值有贡献,这依赖于过滤器函数 f(x-xi,y-yi)的值。

sinc 过滤函数不是合适的选择,因为当有频率超过 Nyquist limit,其会导致 Gibbs phenomenon。而且 sinc 函数最终不会在有限的距离内下降为 0。实践上,并没有一个最好的过滤函数。对于特定的场景,选择最好的滤波函数需要综合定性评估和定性判断。

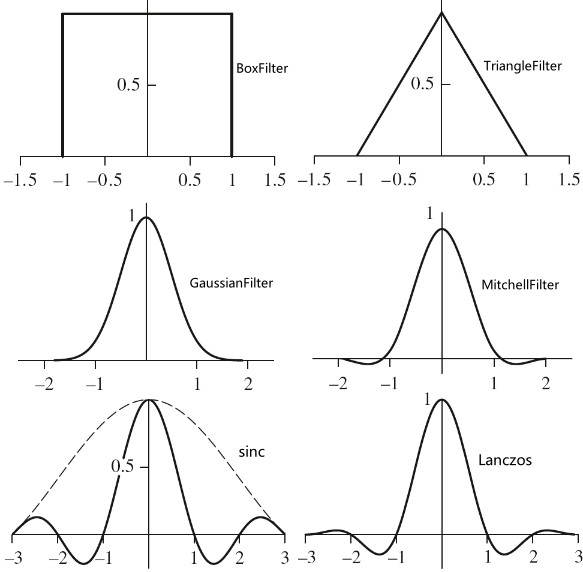

下图展示了本节讨论的 Filter 函数的图形:

BoxFilter 为图形学中最常见的过滤函数之一。BoxFilter 对图片的方形区域内的所有样品取相等的权重。尽管计算高效,但是其可能为最糟糕的过滤器。BoxFilter 会让高频样本数据泄露到重建的值中。这导致了 postaliasing(即使原始样本值有足够高的频率来避免 aliasing,错误依然由糟糕的过滤器引入了)

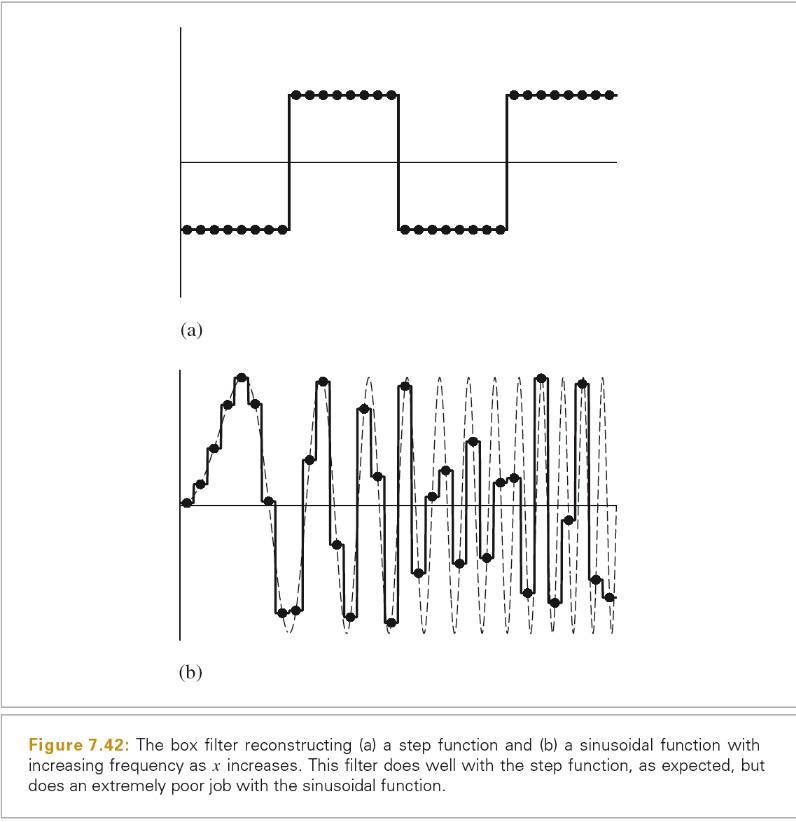

下图展示了 BoxFilter 用于重建两个 1D 函数的结果:

TriangleFilter 比 BoxFilter 要稍微好一些。在过滤器中心的样本点的权重为 1,权重从过滤器从中心到边界线性变小。

Float TriangleFilter::Evaluate(const Point2f &p) const { return std::max((Float)0, radius.x - std::abs(p.x)) * std::max((Float)0, radius.y - std::abs(p.y)); }

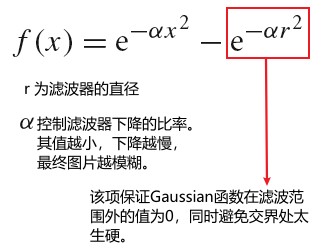

GaussianFilter 比 BoxFilter 和 TriangleFilter 都要好。下图为 1D 高斯过滤器函数:

./PhysicallyBasedRendering/gaussian_filter.ggb

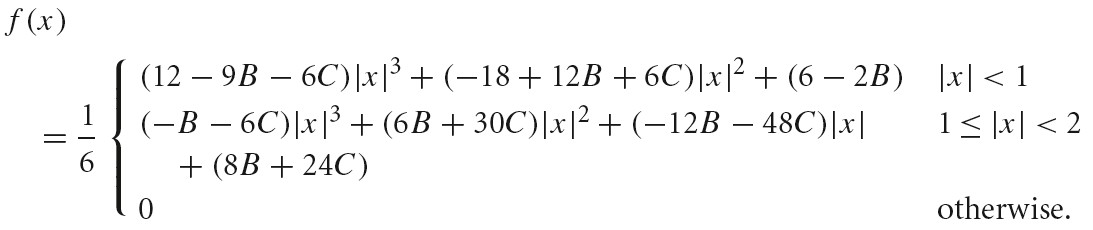

MitchellFilter

Mitchell 和 Netravali 开发了一系列参数化的滤波函数用于系统的研究 Filter 的设计。通过分析测试对象对图形过滤后的主观反应,他们开发了一个滤波器,其试图在 ringing 和 blurring 之间找到平衡。

该函数定义如下,其有两个系数 B 和 C,这两个系数可以任意选取,Mitchell 建议这两个系数在直线 B+2C=1 上。

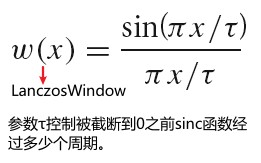

Windowed Sinc Filter

非归一化 sinc 函数: sinc(x) = sin(x)/x

归一化 sinc 函数 : sinc(x) = sin(xπ)/(xπ)

Lanczos window 只是 sinc 函数中心的波瓣,Lanczos window 和 sinc 函数相乘得到 LanczosSincFilter 函数。下图为 Lanczos window 函数:

./PhysicallyBasedRendering/2020_06_21_lanczos_sinc_01.ggb

Float LanczosSincFilter::Sinc(Float x) const { x = std::abs(x); if (x < 1e-5) return 1; return std::sin(Pi * x) / (Pi * x); } // radius 控制Filter的半径 // tau 控制Filter的周期 Float LanczosSincFilter::WindowedSinc(Float x, Float radius) const { x = std::abs(x); if (x > radius) return 0; Float lanczos = Sinc(x / tau); return Sinc(x) * lanczos; }

Film and The imaging pipeline

摄像机的传感器或胶片有一个神奇的效果,其可以将入射光转化为带颜色的图片。pbrt 中,Film 类就是对传感器的建模。每个摄像机射线对应的辐射率被计算出来后,Film 的实现确定了胶片上每个像素周围的样本对该像素的贡献,然后更新其所表示的图片。当渲染主循环结束后,Film 类会将最终的图片写入到一个文件中。

Film Class

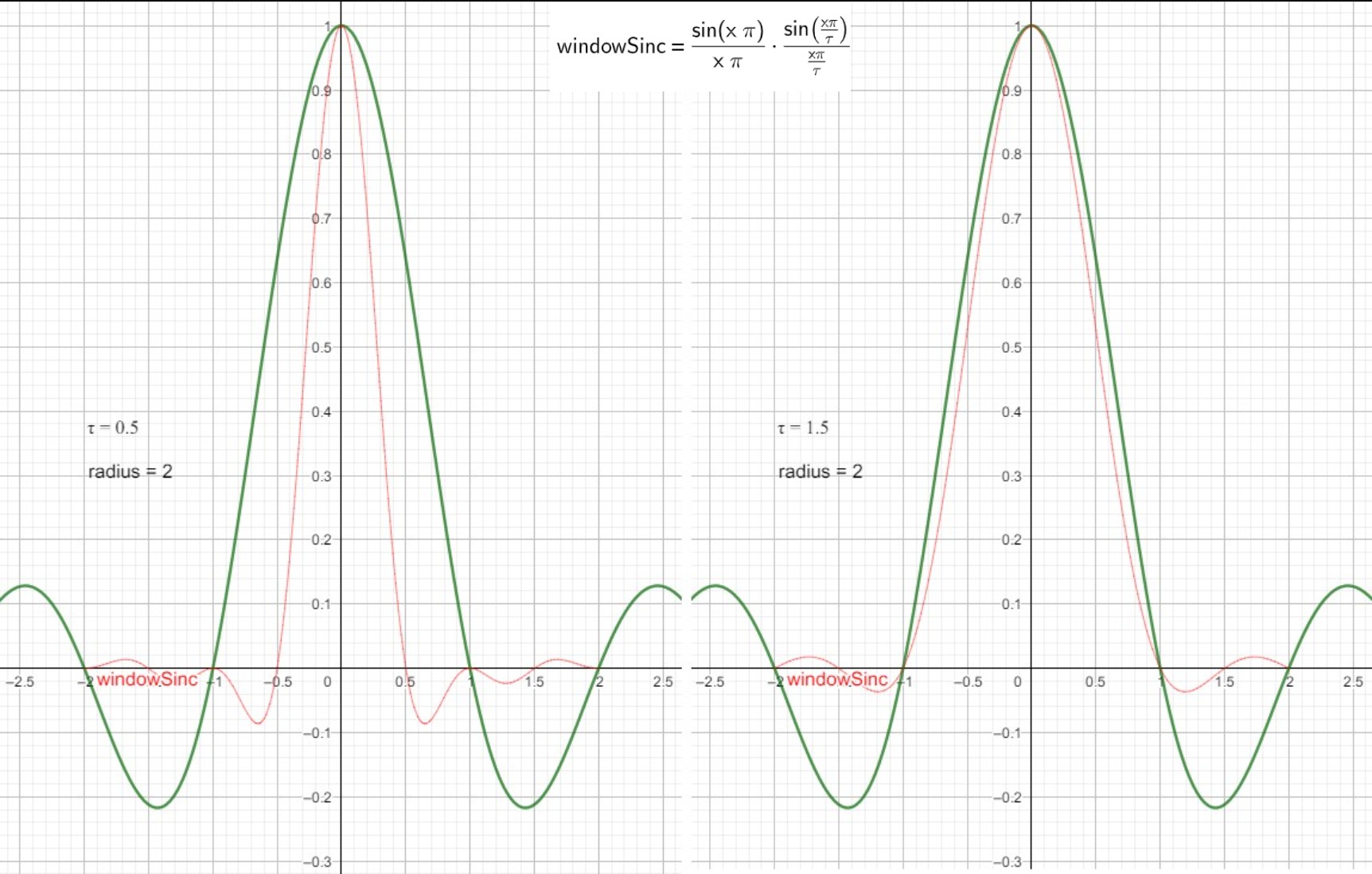

crop window 指定了实际被存储和写出的像素的边界。Crop window 有利于调试,并且将大图片划分为多个小图使其可以在多个电脑上被渲染。Crop window 为 NDC 空间的坐标值。

struct Pixel { Pixel() { xyz[0] = xyz[1] = xyz[2] = filterWeightSum = 0; } // 运行时对像素有贡献的光谱权重和被表示为XYZ颜色并且被存储在Pixel对象的xyz成员变量中 Float xyz[3]; // filterWeightSum存储了样本对像素贡献的过滤器权重和 Float filterWeightSum; // splatXYZ存储了无权重的样本和 AtomicFloat splatXYZ[3]; // 该成员没有实际用途,只是确保Pixel对象为32字节而不是28字节。 // 这可以让Pixel对象在cache中对齐,避免缓存失败 Float pad; }; // 存储Film对应的像素数据 std::unique_ptr<Pixel[]> Film::pixels; // filter 预计算值表 static int filterTableWidth = 16; Float filterTable[filterTableWidth*filterTableWidth];

选择 XYZ 颜色而不是 RGB 是为了强调 XYZ 是独立于显示器的颜色表示方式,而 RGB 需要假定一组特定的显示器响应曲线。

Film 预计算了一个过滤器值表,从而可以避免耗时的虚函数 Filter::Evaluate()调用。没有用每个样本的精确位置来计算过滤器值会引入一些错误,但是实践上这种错误并不明显。

Film 的责任是确定整数像素值的范围,Sampler 的责任是为这些像素值生成样本。Film::GetSampleBounds 返回被采样的区域,因为像素重建过滤器通常跨越多个像素,因此 Sampler 生成的图片样本必须稍为超出被输出的像素的范围。这样即使是边界处的像素也会有相同的样本密度。这对于通过 crop windows 一片一片渲染图片来说也很重要,其避免了子图片边界处的 artifacts。

Bounds2i Film::GetSampleBounds() const { Bounds2f floatBounds(Floor(Point2f(croppedPixelBounds.pMin) + Vector2f(0.5f, 0.5f) - filter->radius), Ceil(Point2f(croppedPixelBounds.pMax) - Vector2f(0.5f, 0.5f) + filter->radius)); return (Bounds2i)floatBounds; }

Supplying Pixel Values To The Film

有三种方式将样本的贡献提供给胶片。第一种方式是由 Sampler 在图片的 tiles 上生成的样本驱动的。尽管这种最简单直接的方法允许渲染器提供一个胶片像素位置以及一个直接指向胶片像素的射线携带的光谱,但是在多线程下无法为这种方式提供一个高效的实现,因为这种情况下多个线程可能会同时更新图片的同一部分。

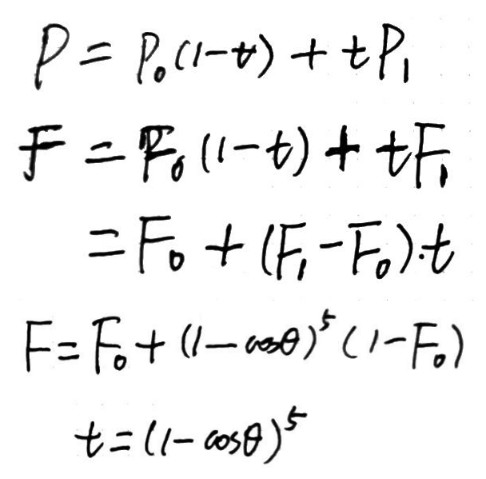

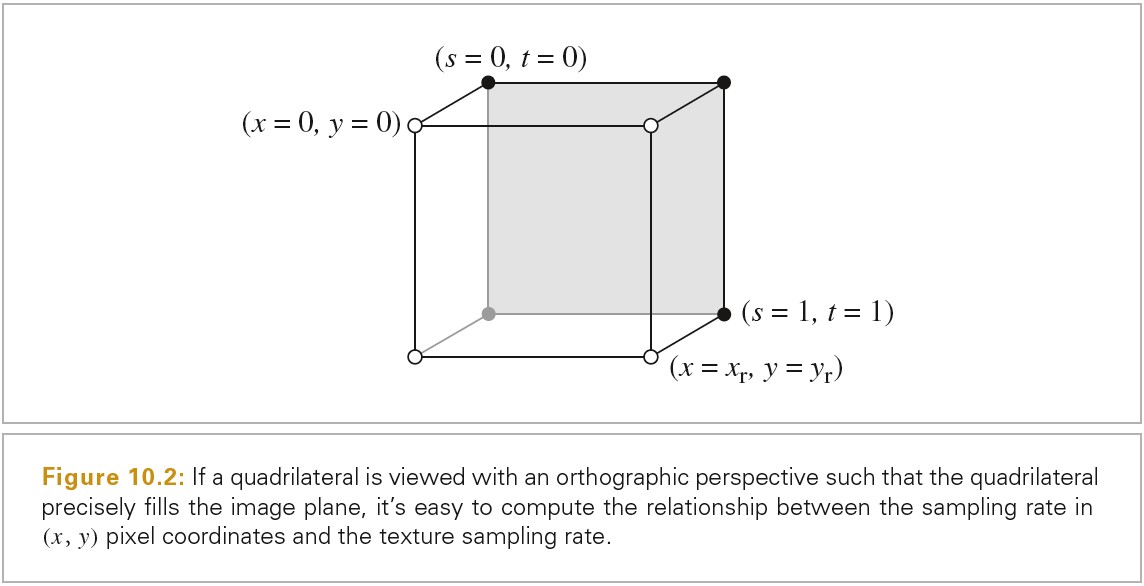

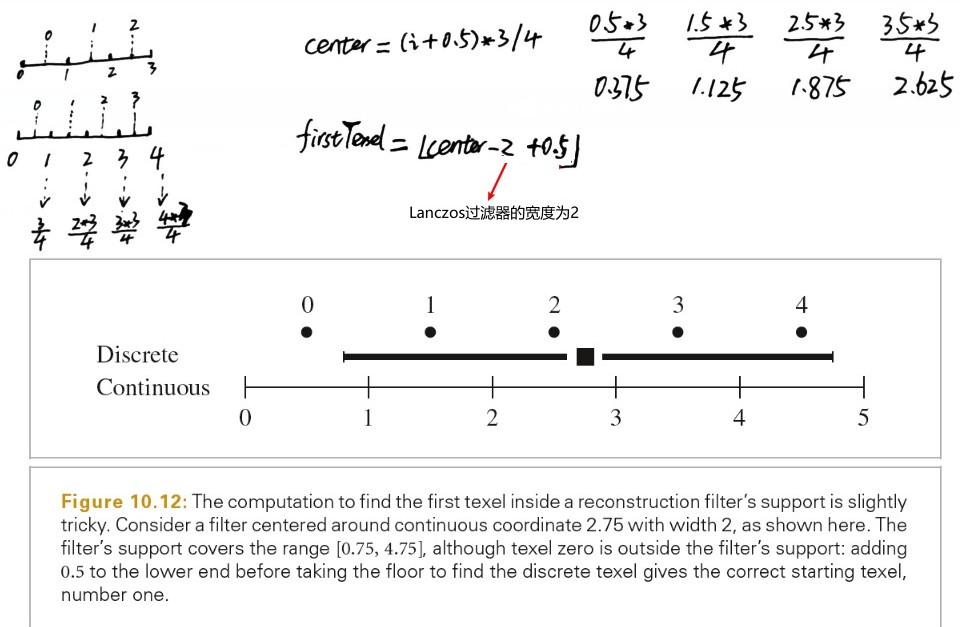

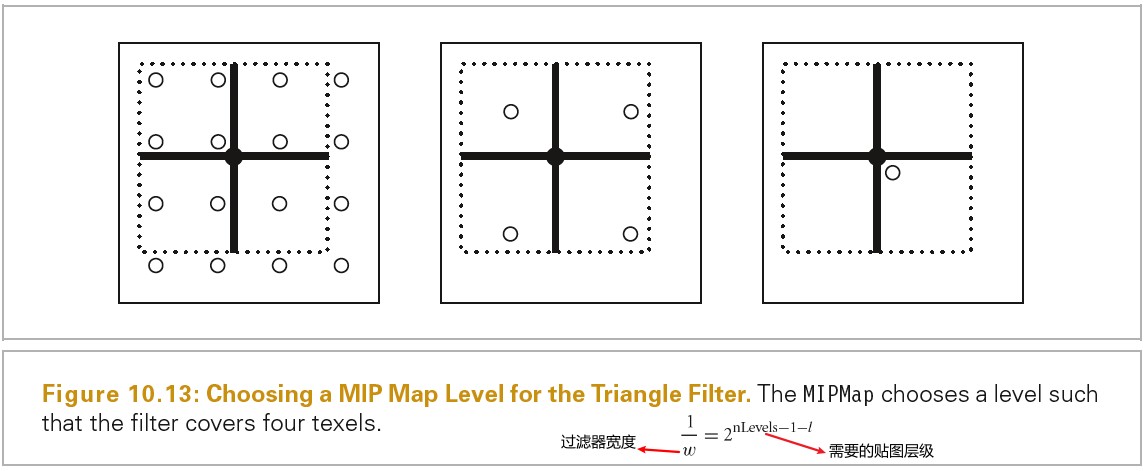

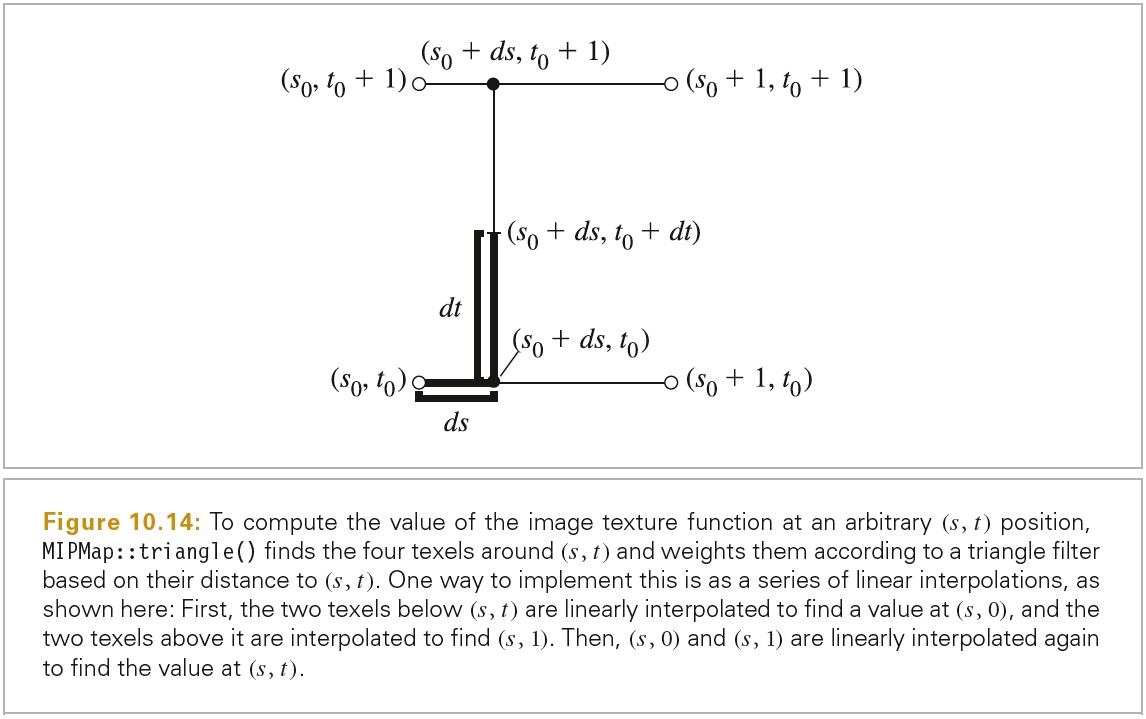

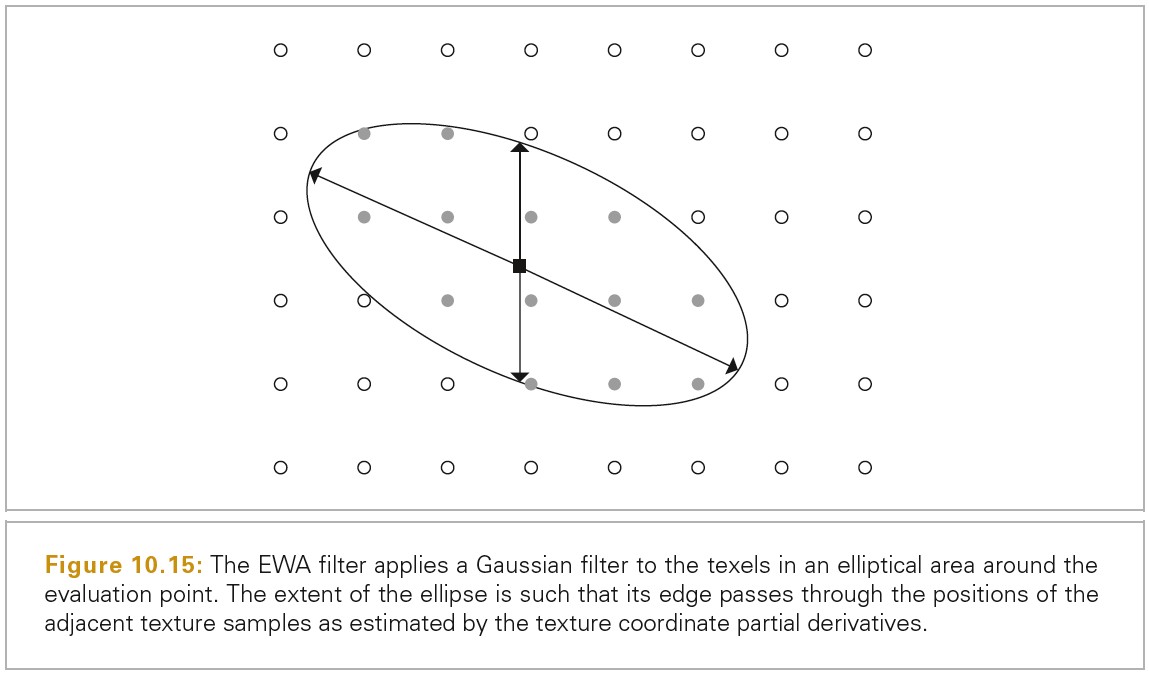

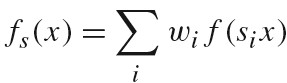

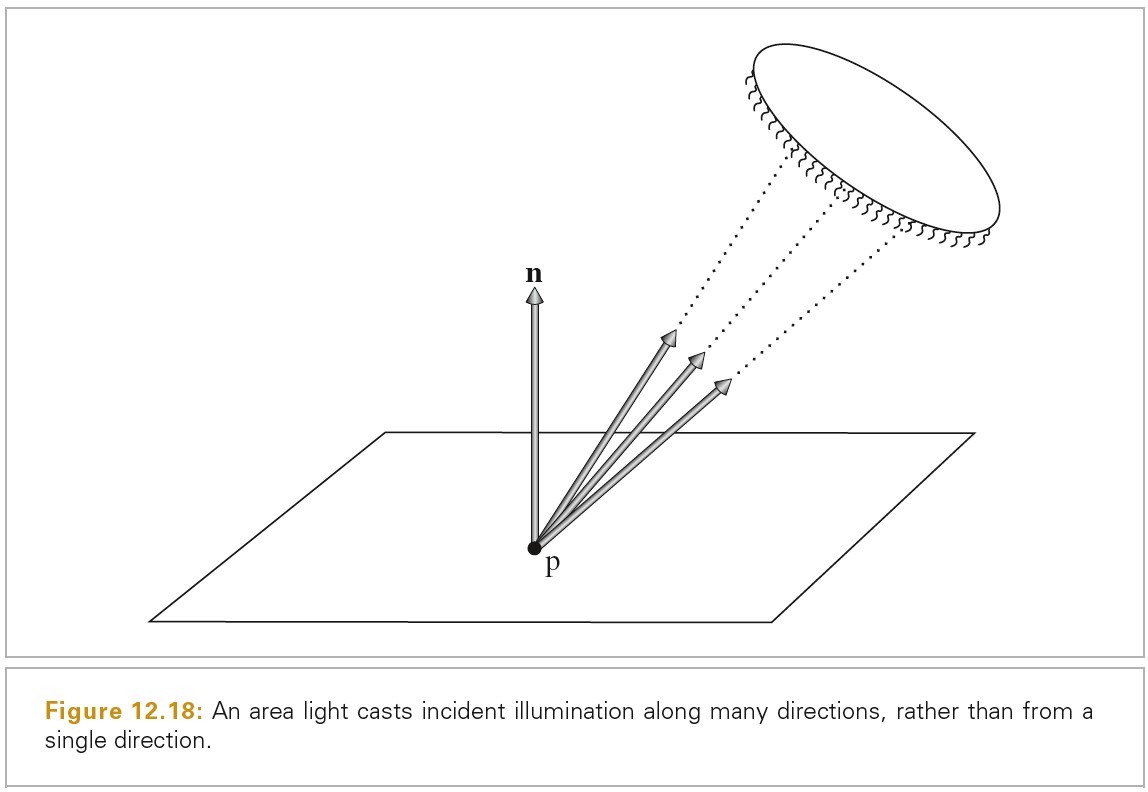

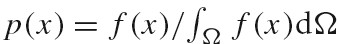

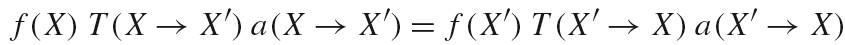

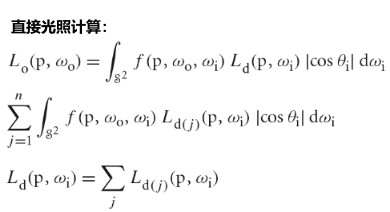

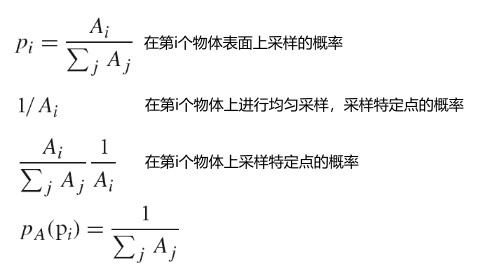

Film 定义了一个接口,多个线程可以指定其生成的样本在某个像素范围。给定样本范围,GetFileTile()返回指向 FileTile 对象的指针,FileTile 中存储了在对应区域中,样本对该区域像素的贡献。FileTile 和其存储的数据对于调用者来说是独自占有的,因此线程可以提供样本值给 FilmTile 而不需要担心其他线程争夺。当线程在 tile 上的工作完成后,其会将完成的 tile 传回给 Film,Film 会将 tile 合并到最终的图片中。